Ce guide du débutant présente les technologies principales de l'IA générative et explique comment elles s'intègrent pour alimenter les chatbots et les applications. L'IA générative (également appelée genAI ou gen AI) est un domaine du machine learning (ML) qui développe et utilise des modèles de ML pour générer du contenu.

Les modèles d'IA générative sont souvent appelés "grands modèles de langage" (LLM, large language model) en raison de leur grande taille et de leur capacité à comprendre et à générer un langage naturel. Toutefois, en fonction des données sur lesquelles les modèles sont entraînés, ils peuvent comprendre et générer du contenu à partir de plusieurs modalités, y compris du texte, des images, des vidéos et des contenus audio. Les modèles qui fonctionnent avec plusieurs modalités de données sont appelés modèles multimodaux.

Génération de contenu

Pour que les modèles d'IA générative puissent générer du contenu utile dans des applications réelles, ils doivent disposer des fonctionnalités suivantes :

Découvrez comment effectuer de nouvelles tâches :

Les modèles d'IA générative sont conçus pour effectuer des tâches générales. Si vous souhaitez qu'un modèle effectue des tâches propres à votre cas d'utilisation, vous devez pouvoir le personnaliser. Sur Vertex AI, vous pouvez personnaliser votre modèle grâce au réglage du modèle.

Accès à des informations externes :

Les modèles d'IA générative sont entraînés sur de vastes quantités de données. Toutefois, pour être utiles, ces modèles doivent pouvoir accéder à des informations en dehors de leurs données d'entraînement. Par exemple, si vous souhaitez créer un chatbot de service client alimenté par un modèle d'IA générative, celui-ci doit avoir accès aux informations sur les produits et services que vous proposez. Dans Vertex AI, vous utilisez les fonctionnalités d'ancrage et d'appel de fonction pour aider le modèle à accéder à des informations externes.

Bloquer le contenu dangereux :

Les modèles d'IA générative peuvent générer des résultats inattendus, y compris du texte offensant ou insensible. Pour assurer la sécurité et éviter tout usage abusif, les modèles ont besoin de filtres de sécurité pour bloquer les invites et les réponses qui sont considérées comme potentiellement dangereuses. Vertex AI dispose de fonctionnalités de sécurité intégrées qui favorisent l'utilisation responsable de nos services d'IA générative.

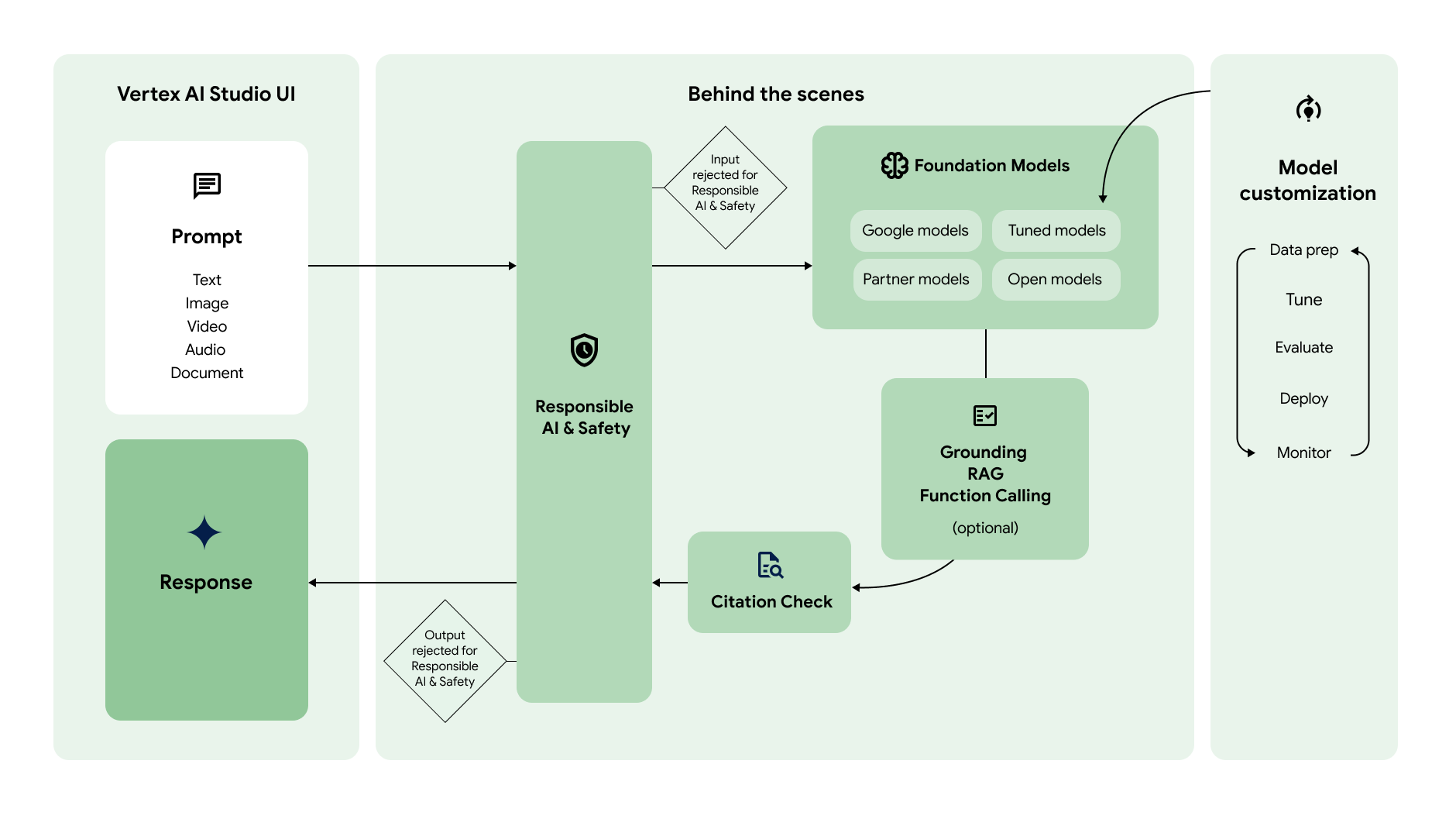

Le schéma suivant montre comment ces différentes fonctionnalités interagissent pour générer le contenu souhaité :

Requête

|

|

Le workflow de l'IA générative commence généralement par une requête. Une requête est une instruction en langage naturel envoyée à un modèle d'IA générative pour obtenir une réponse. Selon le modèle, une requête peut contenir du texte, des images, des vidéos, de l'audio, des documents et d'autres modalités, voire même des modalités multiples (requête multimodale). Le fait d'écrire une requête pour obtenir la réponse souhaitée du modèle est une pratique appelée conception de requête. Bien que la conception d'une requête soit un processus expérimental, vous pouvez utiliser des principes et des stratégies de conception de requêtes pour inciter le modèle à se comporter de la manière souhaitée. Vertex AI Studio propose un outil de gestion des requêtes pour vous aider à gérer vos requêtes. |

Modèles de fondation

|

|

Les requêtes sont envoyées à un modèle d'IA générative afin de générer des réponses. Vertex AI dispose de divers modèles de fondation d'IA générative accessibles via une API, dont les suivants :

La taille, la modalité et les coûts des modèles sont différents. Vous pouvez explorer les modèles Google, ainsi que des modèles Open Source et des modèles de partenaires Google, dans Model Garden. |

Personnaliser le modèle

|

|

Vous pouvez personnaliser le comportement par défaut des modèles de fondation de Google afin qu'ils génèrent les résultats souhaités de manière cohérente, sans utiliser de requêtes complexes. Ce processus de personnalisation est appelé réglage du modèle. Les réglages de modèles vous aident à réduire le coût et la latence de vos requêtes en vous permettant de simplifier vos requêtes. Vertex AI propose également des outils d'évaluation de modèle pour vous aider à évaluer les performances de votre modèle réglé. Une fois que votre modèle réglé est prêt pour la production, vous pouvez le déployer sur un point de terminaison et surveiller les performances, comme dans les workflows MLOps standards. |

Accéder à des informations externes

|

|

Vertex AI propose plusieurs façons de donner au modèle accès à des API externes et à des informations en temps réel.

|

Vérification des citations

|

|

Une fois la réponse générée, Vertex AI vérifie si les citations doivent être incluses dans la réponse. Si une grande partie du texte de la réponse provient d'une source particulière, cette source est ajoutée aux métadonnées de citation de la réponse. |

IA responsable et sécurité

|

|

La dernière couche de vérification que la requête et la réponse passent avant d'être renvoyée concernent les filtres de sécurité. Vertex AI vérifie à la fois la requête et la réponse indiquant dans quelle mesure la requête ou la réponse appartient à une catégorie de sécurité. Si le seuil est dépassé pour une ou plusieurs catégories, la réponse est bloquée et Vertex AI renvoie une réponse de remplacement. |

Réponse

|

|

Si la requête et la réponse réussissent les contrôles de filtre de sécurité, la réponse est renvoyée. En règle générale, la réponse est renvoyée simultanément. Cependant, avec Vertex AI, vous pouvez également recevoir des réponses progressivement au fur et à mesure de leur génération en activant le streaming. |

Expériences de la console Vertex AI Studio

Lorsque vous utilisez Vertex AI Studio avec l'essai gratuit ou sans vous connecter à Google Cloud, certaines fonctionnalités ne sont pas disponibles. Pour tester Vertex AI Studio, acceptez les conditions d'utilisation de Vertex AI Studio dans la console Google Cloud.

| Utiliser sans compte Google Cloud | Utiliser avec un compte d'essai gratuit Google Cloud | Utiliser avec un compte Google Cloud existant | |

|---|---|---|---|

| Connexion obligatoire | Non | Oui | Oui |

| Requêtes par minute (RPM) | 2 RPM pour tous les modèles multimodaux | Consulter les limites de quota | Consulter les limites de quota |

| Crédits offerts | 0 $ | Jusqu'à 300 $ pendant 90 jours | 0 $ |

| Galerie de requêtes | Non | Oui | Oui |

| Outil de conception de requêtes | Oui | Oui | Oui |

| Enregistrer les invites | Non | Oui | Oui |

| Historique des invites | Non | Oui | Oui |

| Paramètres avancés | Non | Non | Oui |

| Réglage | Non | Non | Oui |

| Utilisation de l'API | Non | Oui | Oui |

| Facturation obligatoire | Non | Non | Oui |

| Premiers pas | Accéder à Vertex AI Studio | S'inscrire à un essai gratuit | Essayer Vertex AI Studio dans votre console |

Faites vos premiers pas avec l'IA générative sur Vertex AI.

- Suivez un tutoriel de démarrage rapide sur Vertex AI Studio ou sur l'API Vertex AI.

- Découvrez les modèles pré-entraînés dans Model Garden.

- Explorez la documentation de référence du SDK de l'API Vertex AI Gemini pour Python, Node.js, Java, Go ouC#.

- Découvrez les bonnes pratiques d'IA responsable et les filtres de sécurité de Vertex AI.

- En savoir plus sur les tarifs.

- Découvrez comment appeler Gemini à l'aide de la bibliothèque OpenAI.