Cette page explique comment l'architecture de Memorystore pour Valkey prend en charge et fournit la haute disponibilité. Cette page explique également les configurations recommandées qui contribuent à améliorer les performances et la stabilité des instances.

Haute disponibilité

Memorystore pour Valkey repose sur une architecture à disponibilité élevée dans laquelle vos clients accèdent directement aux nœuds Memorystore pour Valkey gérés. Pour ce faire, vos clients se connectent à des points de terminaison individuels, comme décrit dans Se connecter à une instance Memorystore pour Valkey.

La connexion directe à un ou plusieurs shards présente les avantages suivants :

Une connexion directe évite les sauts intermédiaires, ce qui minimise le temps aller-retour (latence du client) entre votre client et le nœud Valkey.

Lorsque le mode cluster est activé, la connexion directe évite tout point de défaillance unique, car chaque segment est conçu pour échouer indépendamment. Par exemple, si le trafic de plusieurs clients surcharge un emplacement (segment d'espace de clés), l'échec du shard limite l'impact au shard responsable de la diffusion de l'emplacement.

Configurations recommandées

Nous vous recommandons de créer des instances multizones à disponibilité élevée plutôt que des instances monozones, car elles offrent une meilleure fiabilité. Toutefois, si vous choisissez de provisionner une instance sans réplicas, nous vous recommandons de choisir une instance à zone unique. Pour en savoir plus, consultez Choisir une instance à zone unique si votre instance n'utilise pas de réplicas.

Pour activer la haute disponibilité de votre instance, vous devez provisionner au moins un nœud répliqué pour chaque partition. Vous pouvez le faire lorsque vous créez l'instance ou mettre à l'échelle le nombre de réplicas à au moins un réplica par shard. Les réplicas permettent un basculement automatique lors d'une maintenance planifiée et en cas de défaillance inattendue d'un shard.

Vous devez configurer votre client en suivant les conseils de la section Bonnes pratiques concernant les clients. En suivant les bonnes pratiques recommandées, votre client peut gérer automatiquement les éléments suivants pour votre instance, sans aucun temps d'arrêt :

Le rôle (basculements automatiques)

Point de terminaison (remplacement de nœud)

Modifications de l'attribution des emplacements liées au mode cluster activé (augmentation et diminution de la capacité côté consommateur)

Instances dupliquées

Une instance Memorystore pour Valkey à disponibilité élevée est une ressource régionale. Cela signifie que Memorystore pour Valkey distribue les nœuds principaux et de réplique des partitions sur plusieurs zones pour se prémunir contre une panne zonale. Memorystore pour Valkey est compatible avec les instances comportant 0, 1 ou 2 répliques par nœud.

Vous pouvez utiliser des répliques pour augmenter le débit en lecture au détriment de l'obsolescence potentielle des données.

- Mode cluster activé : utilisez la commande

READONLYpour établir une connexion qui permet à votre client de lire les répliques. - Mode cluster désactivé : connectez-vous au point de terminaison de lecteur pour vous connecter à l'une des instances répliquées disponibles.

Formes d'instance avec le mode Cluster activé

Les schémas suivants illustrent les formes pour les instances en mode cluster activé :

Avec trois segments et zéro réplica par nœud

Avec trois shards et une réplique par nœud

Avec trois shards et deux répliques par nœud

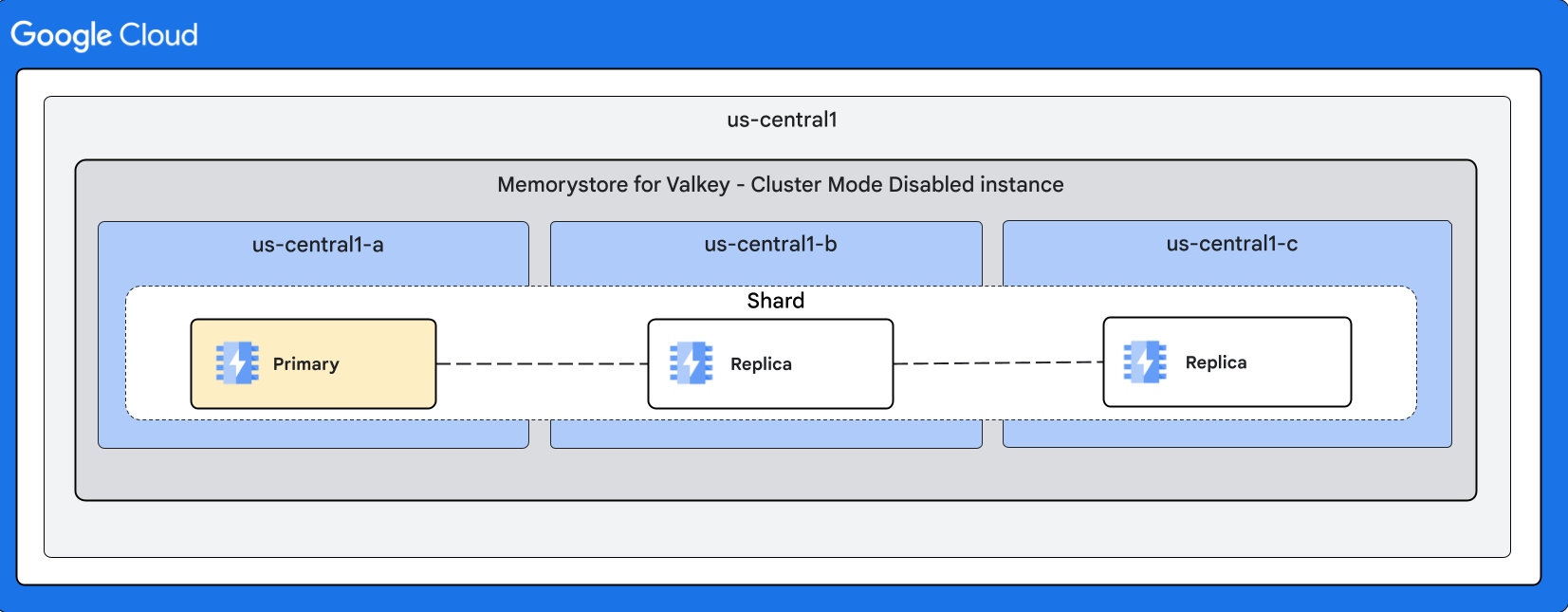

Formes d'instance avec le mode cluster désactivé

Les schémas suivants illustrent les formes pour les instances en mode cluster désactivé :

Avec deux instances répliquées

Basculement automatique

Les basculements automatiques au sein d'un shard peuvent se produire en raison d'une maintenance ou d'une défaillance inattendue du nœud principal. Lors d'un basculement, une instance répliquée est promue au rang d'instance principale. Vous pouvez configurer explicitement les répliques. Le service peut également provisionner temporairement des réplicas supplémentaires lors de la maintenance interne pour éviter tout temps d'arrêt.

Les basculements automatiques empêchent la perte de données lors des mises à jour de maintenance. Pour en savoir plus sur le comportement du basculement automatique pendant la maintenance, consultez Comportement du basculement automatique pendant la maintenance.

Durée du basculement et de la réparation des nœuds

Les basculements automatiques peuvent prendre plusieurs dizaines de secondes pour les événements imprévus tels qu'un plantage du processus du nœud principal ou une défaillance matérielle. Pendant ce temps, le système détecte la défaillance et choisit une instance répliquée comme nouvelle instance principale.

La réparation d'un nœud peut prendre plusieurs minutes avant que le service ne remplace le nœud défaillant. Cela s'applique à tous les nœuds principaux et de réplique. Pour les instances à disponibilité élevée (aucune instance répliquée provisionnée), la réparation d'un nœud principal défaillant prend également quelques minutes.

Comportement du client lors d'un basculement non planifié

Les connexions client sont susceptibles d'être réinitialisées en fonction de la nature de l'échec. Après la récupération automatique, les connexions doivent être réessayées avec backoff exponentiel pour éviter de surcharger les nœuds principaux et de réplique.

Les clients qui utilisent des réplicas pour le débit de lecture doivent se préparer à une dégradation temporaire de la capacité jusqu'à ce que le nœud défaillant soit automatiquement remplacé.

Écritures perdues

Lors d'un basculement résultant d'une défaillance inattendue, les écritures confirmées peuvent être perdues en raison de la nature asynchrone du protocole de réplication de Valkey.

Les applications clientes peuvent utiliser la commande WAIT de Valkey pour améliorer la sécurité des données dans le monde réel.

Impact d'une panne de zone unique sur l'espace de clés

Cette section décrit l'impact d'une panne dans une seule zone sur une instance Memorystore pour Valkey.

Instances multizones

Instances à haute disponibilité : en cas de défaillance d'une zone, l'intégralité de l'espace de clés est disponible pour les opérations de lecture et d'écriture. Toutefois, comme certaines instances dupliquées avec accès en lecture sont indisponibles, la capacité de lecture est réduite. Nous vous recommandons vivement de surprovisionner la capacité du cluster afin que l'instance dispose d'une capacité de lecture suffisante en cas de panne d'une seule zone (ce qui est rare). Une fois la panne terminée, les réplicas de la zone concernée sont restaurés et la capacité de lecture du cluster revient à sa valeur configurée. Pour en savoir plus, consultez Modèles d'applications évolutives et fiables.

Instances non HA (sans réplicas) : si une zone est en panne, la partie de l'espace de clés provisionnée dans la zone concernée fait l'objet d'un vidage des données et n'est pas disponible pour les opérations d'écriture ou de lecture pendant la durée de la panne. Une fois l'indisponibilité terminée, les instances principales de la zone concernée sont restaurées et la capacité du cluster revient à sa valeur configurée.

Instances à zone unique

- Instances HD et non HD : si la zone dans laquelle l'instance est provisionnée est en panne, le cluster est indisponible et les données sont supprimées. Si une autre zone est indisponible, le cluster continue de diffuser les requêtes de lecture et d'écriture.

Bonnes pratiques

Cette section décrit les bonnes pratiques concernant la haute disponibilité et les répliques.

Ajouter une instance répliquée

L'ajout d'un réplica nécessite un instantané RDB. Les instantanés RDB utilisent un fork de processus et un mécanisme de copie sur écriture pour prendre un instantané des données de nœud. En fonction du modèle d'écriture dans les nœuds, la mémoire utilisée des nœuds augmente à mesure que les pages concernées par les écritures sont copiées. L'empreinte mémoire peut atteindre le double de la taille des données du nœud.

Pour vous assurer que les nœuds disposent de suffisamment de mémoire pour effectuer l'instantané, conservez ou définissez maxmemory à 80 % de la capacité du nœud afin que 20 % soient réservés aux frais généraux. Cette surcharge de mémoire, en plus des instantanés de surveillance, vous aide à gérer votre charge de travail pour obtenir des instantanés réussis. De plus, lorsque vous ajoutez des réplicas, réduisez le trafic en écriture autant que possible. Pour en savoir plus, consultez Surveiller l'utilisation de la mémoire pour une instance.