Kurzanleitung: Überprüfung abschließen

Jeder Prozessor erstellt eine „HITL-Aufgabe“, die einem Pool von menschlichen Labelern (Labeler Pool) zugewiesen wird, die die vom Prozessor verarbeiteten Dokumente überprüfen. Nach der Verarbeitung werden diese Dokumente vom zugewiesenen Labeler-Pool in der Aufgabe für die HITL-Überprüfung in die Warteschlange gestellt.

Hinweise

Führen Sie die vorherige Kurzanleitung: Manuelle Überprüfung konfigurieren aus, bevor Sie fortfahren.Labeler hinzufügen

- Nach der Konfiguration der manuellen Überprüfung sollten Sie eine E-Mail erhalten, die in etwa so aussieht:

From: AI Platform <noreply-aiplatform@google.com>\

Subject: Added to AI Platform SpecialistPool Test Labeler Group

Hello AI Platform Customer,

You are added as a manager to specialist pool

cloudml_data_specialists_us_central1_785484070008756xxxx.

To view details, visit Manager console

https://datacompute.google.com/cm/

Sincerely,

The Google Cloud AI Team

Klicken Sie auf den Link in der E-Mail oder kopieren Sie ihn und fügen Sie ihn in Ihren Browser ein, um die Seite „Verwaltung“ aufzurufen:

Die vom neu erstellten Prozessor erstellte Aufgabe hat denselben Namen wie der Prozessor (z. B. „Rechnungen für Abteilung A“) und wird auf dem Tab „Aufgaben“ aufgeführt.

Klicken Sie auf den Tab „Labeler“.

Klicken Sie auf „Labeler hinzufügen“ und fügen Sie mindestens einen Labeler (E-Mail-Adresse) hinzu. Ein Administrator kann ein Labeler sein. Sie können sich also selbst hinzufügen.

Bei einem neu erstellten Labeler-Pool muss die Aufgabe dem einzelnen Labeler auf dem Tab „Aufgaben“ explizit zugewiesen werden. Das Hinzufügen des Labeler-Pools weist diesen neuen Labelern die Aufgabe also nicht automatisch zu. Wenn im Labeler-Pool bereits Labeler bereitgestellt wurden, wird der Pool automatisch der Aufgabe zugewiesen.

Erstes Dokument zur Überprüfung posten

Senden Sie ein Dokument zur Extraktion über den erstellten Prozessor. Weitere Informationen findest du in den Anleitungen. Sowohl Online- (synchron) als auch Batch-Aufrufe (asynchron) unterstützen derzeit das Routing zur manuellen Überprüfung für unterstützte Prozessoren.

Zu Testzwecken können Sie entweder eine bekanntermaßen schlechte Extraktion verwenden, um die manuelle Überprüfung zu aktivieren, wenn der Konfidenzwert unter dem Grenzwert liegt, oder Sie können den Grenzwert auf 100 % festlegen. Die Dokumentlimits betragen in der Regel 5 Seiten, maximal 20 MB. Prüfen Sie jedoch die spezifischen Limits des jeweiligen Prozessors.

Es gibt eine API, mit der jedes Dokument, das zur manuellen Überprüfung weitergeleitet wird, nachverfolgt werden kann. Die Antwort der Auftragsverarbeiter enthält einen

humanReviewOperation-String, der die Vorgangs-ID (Jobname) des Dokuments im Rahmen der manuellen Überprüfung ist. Der Status dieses Vorgangs mit langer Ausführungszeit (Long Running Operation, LRO) kann abgefragt werden.Mit der Methode

projects.locations.operations.getkönnen Sie den Status eines Dokuments abfragen, das zur manuellen Überprüfung weitergeleitet wurde.Mit der Methode

reviewDocumentkönnen Sie erzwingen, dass ein Dokument manuell überprüft wird. Beachten Sie, dass diese Methode prozessorabhängig ist:Wenn Sie die

reviewDocument-Methode verwenden möchten, muss das Kästchen MANUELLE ÜBERPRÜFUNG AKTIVIERT angeklickt sein. Die Konfigurationseinstellungen werden durch die Verwendung dieser API nicht überschrieben.Eine Anleitung dazu, wie Sie diese Methode verwenden, finden Sie im Hilfeartikel Manuelle Überprüfung beantragen.

Dokument prüfen

Wenn das Dokument die manuelle Überprüfung auslöst, aber keine Labeler im Pool vorhanden sind, erhält der Manager eine E-Mail.

> Hello AI Platform Customer, > > There is a running task for Project with Job ID 404298342016955xxxx,\ > Labeling Task ID cloudml_data_us_central1_prod_11b273b4dabdxxxx,\ > Display name \ > datalabeling-job-8005676103232389120-for-hitl-340697311810578xxxx,\ > replication count 1\ > Please see attachment for instruction.\ > Please add labelers and have them finish the task at Labeler console \ > [https://datacompute.google.com/w/cloudml_data_specialists_us_central1_7854840700087566336](https://datacompute.google.com/w/cloudml_data_specialists_us_central1_7854840700087566336){: target="external" class="external" track-type="quickstart" track-name="externalLink" track-metadata-position="body" }.\ > To view details, visit Manager console \ > [https://datacompute.google.com/cm/cloudml_data_specialists_us_central1_7854840700087566336/tasks](https://datacompute.google.com/cm/cloudml_data_specialists_us_central1_7854840700087566336/tasks){: target="external" class="external" track-type="quickstart" track-name="externalLink" track-metadata-position="body" }. > > Sincerely,\ The Google Cloud AI Team

Über diese Links kann der Labeling Manager Aufgaben zur Datenbeschriftung zuweisen.

Wenn die Labeler nicht in der Labeling Group registriert sind und neu hinzugefügt werden, muss der Labeling Manager eine ähnliche E-Mail mit einer Anleitung an die hinzugefügten Labeler senden.

Schritte für Labeler

Verfahren für Labeler

E-Mail-Adresse des Labelers

Wenn ein Bearbeiter in Schritt 2e bereits in einer Labelsgruppe registriert ist, erfolgt die Zuordnung automatisch und er erhält eine E-Mail wie diese:

Über den Link in dieser E-Mail kann der ausgewählte Labeler das Dokument beschriften.

Labelaktionen:

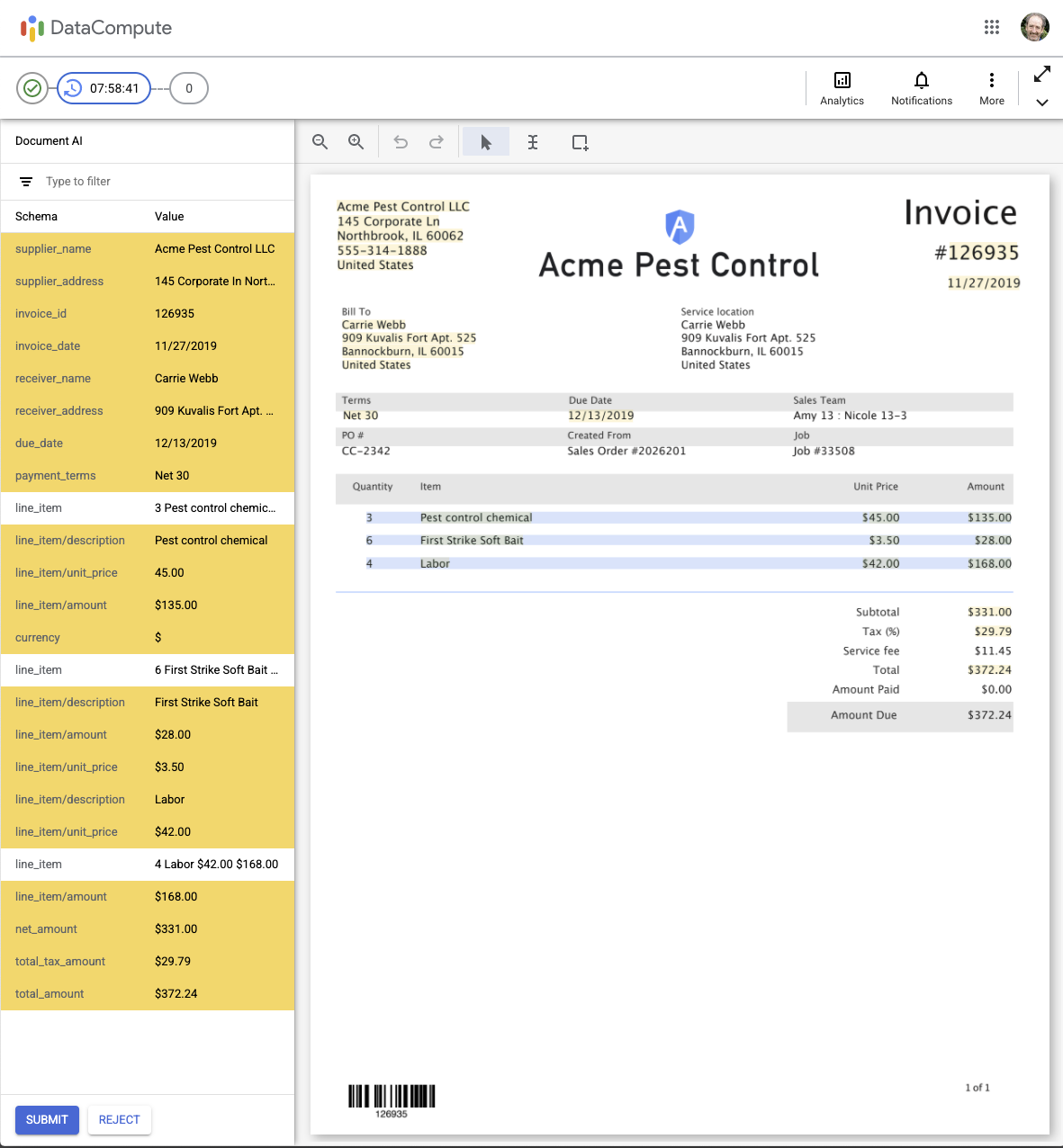

Wenn ein Labeler auf den Link zum Labeln klickt, wird die unten abgebildete Benutzeroberfläche für die interaktive KI-gestützte manuelle Überprüfung angezeigt. Die gelb hervorgehobenen Zeilen sind die Zeilen, die die Validierung nicht bestehen (d. h. sie liegen unter dem konfigurierten Schwellenwert für den Konfidenzwert) und müssen überprüft werden.

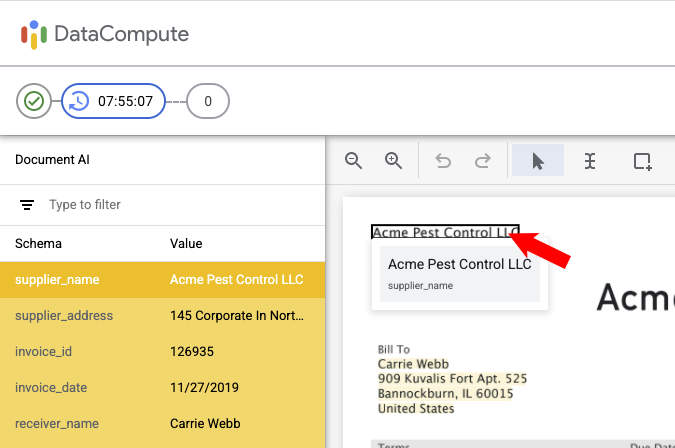

Überprüfung Wenn Sie den Mauszeiger auf ein erkanntes Textfeld bewegen, wird der erkannte Text und (in kleinerer Schrift darunter) der Name des Felds (Schema) angezeigt. Die Zeile wird auch im linken Bereich hervorgehoben.

Der Nutzer kann mit den Lupensymbolen links oben in der Symbolleiste heran- und herauszoomen.

Feld ändern

Sie können das Feld bearbeiten, indem Sie links darauf klicken:

Sie können den Wert oder das Label im linken Bereich ändern. Klicken Sie dann auf Anwenden.

ODER: Sie können auf eines der Symbole in den Ecken des Dokumentenbilds klicken, um die Größe des Begrenzungsrahmens um den Dokumententext zu ändern:

Wie gezeigt, ändert sich der Text im Feld „Wert“ im linken Bereich, wenn ein anderer Text ausgewählt wird. Sie können diesen Text bei Bedarf weiter bearbeiten. Klicken Sie dann auf Anwenden.

Überprüfen Sie alle Seiten mithilfe der Seitensteuerung oben rechts.

Nachdem Sie alle erforderlichen Labeländerungen vorgenommen haben, klicken Sie unten links auf SENDEN. Die JSON-Ergebnisse werden im Ordner „Ergebnisspeicherort“ gespeichert.

Wenn das Dokument nicht zufriedenstellend gekennzeichnet werden kann, können Sie unten links auf ABLEHNEN klicken und dann einen Grund für die Ablehnung des Dokuments auswählen: – Wählen Sie einen Grund aus und klicken Sie dann auf Dokument ablehnen.

Bearbeiter können auch auf die folgenden Symbole oben rechts klicken:

- Analysen: Hier sehen Sie, wie viele Dokumente die Person geprüft hat (Antworten) und wie lange sie dafür insgesamt gebraucht hat.

- Benachrichtigungen: Hier werden alle Benachrichtigungen angezeigt, die der Nutzer erhalten hat.

- Dreipunkt-Menü: Sie können das Dokument überspringen, Antworten finden oder Feedback geben (falls aktiviert).

- Titelleiste ein-/ausblenden (diagonale Pfeile): Dadurch wird die DataCompute-Titelleiste ausgeblendet (oder eingeblendet), um mehr Platz zu schaffen.

Labeling Manager

Dokument aus Cloud Storage prüfen

Wenn Sie das Dokument prüfen möchten, haben Sie zwei Möglichkeiten:

Methode 1:

- Cloud Storage an zuvor konfiguriertem Speicherort suchen

- Dokumente abrufen und herunterladen

Methode 2:

- URI zum Abrufen des Dokuments aus der Antwort der Vorhersage merken

- URI aufrufen, um das überprüfte Dokument abzurufen

Nächste Schritte

- Labeling-Aufgaben mit der Labeling Manager Console verwalten

- Eine Liste und Beschreibungen der derzeit verfügbaren Prozessoren