Questo documento fornisce informazioni sulle metriche Spark. Per impostazione predefinita, Serverless per Apache Spark abilita la raccolta delle metriche Spark disponibili, a meno che tu non utilizzi le proprietà di raccolta delle metriche Spark per disattivare o sostituire la raccolta di una o più metriche Spark.

Per ulteriori proprietà che puoi impostare quando invii un workload batch Spark Serverless per Apache Spark, vedi Proprietà Spark.

Proprietà di raccolta delle metriche Spark

Puoi utilizzare le proprietà elencate in questa sezione per disattivare o ignorare la raccolta di una o più metriche Spark disponibili.

| Proprietà | Descrizione |

|---|---|

spark.dataproc.driver.metrics |

Utilizza questa opzione per disattivare o ignorare le metriche del driver Spark. |

spark.dataproc.executor.metrics |

Utilizza questa opzione per disattivare o ignorare le metriche dell'executor Spark. |

spark.dataproc.system.metrics |

Utilizza per disattivare le metriche di sistema Spark. |

Esempi dell'interfaccia a riga della gcloud CLI:

Disabilita la raccolta delle metriche del driver Spark:

gcloud dataproc batches submit spark \ --properties spark.dataproc.driver.metrics="" \ --region=region \ other args ...

Esegui l'override della raccolta delle metriche predefinita del driver Spark per raccogliere solo le metriche

BlockManager:disk.diskSpaceUsed_MBeDAGScheduler:stage.failedStages:gcloud dataproc batches submit spark \ --properties=^~^spark.dataproc.driver.metrics="BlockManager:disk.diskSpaceUsed_MB,DAGScheduler:stage.failedStages" \ --region=region \ other args ...

Metriche Spark disponibili

Serverless per Apache Spark raccoglie le metriche Spark elencate in questa sezione a meno che tu non utilizzi le proprietà di raccolta delle metriche Spark per disabilitare o ignorare la raccolta.

custom.googleapis.com/METRIC_EXPLORER_NAME.

Metriche del driver Spark

| Metrica | Nome di Metrics Explorer |

|---|---|

| BlockManager:disk.diskSpaceUsed_MB | spark/driver/BlockManager/disk/diskSpaceUsed_MB |

| BlockManager:memory.maxMem_MB | spark/driver/BlockManager/memory/maxMem_MB |

| BlockManager:memory.memUsed_MB | spark/driver/BlockManager/memory/memUsed_MB |

| DAGScheduler:job.activeJobs | spark/driver/DAGScheduler/job/activeJobs |

| DAGScheduler:job.allJobs | spark/driver/DAGScheduler/job/allJobs |

| DAGScheduler:messageProcessingTime | spark/driver/DAGScheduler/messageProcessingTime |

| DAGScheduler:stage.failedStages | spark/driver/DAGScheduler/stage/failedStages |

| DAGScheduler:stage.runningStages | spark/driver/DAGScheduler/stage/runningStages |

| DAGScheduler:stage.waitingStages | spark/driver/DAGScheduler/stage/waitingStages |

Metriche dell'esecutore Spark

| Metrica | Nome di Metrics Explorer |

|---|---|

| ExecutorAllocationManager:executors.numberExecutorsDecommissionUnfinished | spark/driver/ExecutorAllocationManager/executors/numberExecutorsDecommissionUnfinished |

| ExecutorAllocationManager:executors.numberExecutorsExitedUnexpectedly | spark/driver/ExecutorAllocationManager/executors/numberExecutorsExitedUnexpectedly |

| ExecutorAllocationManager:executors.numberExecutorsGracefullyDecommissioned | spark/driver/ExecutorAllocationManager/executors/numberExecutorsGracefullyDecommissioned |

| ExecutorAllocationManager:executors.numberExecutorsKilledByDriver | spark/driver/ExecutorAllocationManager/executors/numberExecutorsKilledByDriver |

| LiveListenerBus:queue.executorManagement.listenerProcessingTime | spark/driver/LiveListenerBus/queue/executorManagement/listenerProcessingTime |

| executor:bytesRead | spark/executor/bytesRead |

| executor:bytesWritten | spark/executor/bytesWritten |

| executor:cpuTime | spark/executor/cpuTime |

| executor:diskBytesSpilled | spark/executor/diskBytesSpilled |

| executor:jvmGCTime | spark/executor/jvmGCTime |

| executor:memoryBytesSpilled | spark/executor/memoryBytesSpilled |

| executor:recordsRead | spark/executor/recordsRead |

| executor:recordsWritten | spark/executor/recordsWritten |

| executor:runTime | spark/executor/runTime |

| executor:shuffleFetchWaitTime | spark/executor/shuffleFetchWaitTime |

| executor:shuffleRecordsRead | spark/executor/shuffleRecordsRead |

| executor:shuffleRecordsWritten | spark/executor/shuffleRecordsWritten |

| executor:shuffleRemoteBytesReadToDisk | spark/executor/shuffleRemoteBytesReadToDisk |

| executor:shuffleWriteTime | spark/executor/shuffleWriteTime |

| executor:succeededTasks | spark/executor/succeededTasks |

| ExecutorMetrics:MajorGCTime | spark/executor/ExecutorMetrics/MajorGCTime |

| ExecutorMetrics:MinorGCTime | spark/executor/ExecutorMetrics/MinorGCTime |

Metriche di sistema

| Metrica | Nome di Esplora metriche |

|---|---|

| agent:uptime | agent/uptime |

| cpu:utilization | cpu/utilization |

| disk:bytes_used | disk/bytes_used |

| disk:percent_used | disk/percent_used |

| memory:bytes_used | memory/bytes_used |

| memory:percent_used | memory/percent_used |

| network:tcp_connections | network/tcp_connections |

Visualizza le metriche Spark

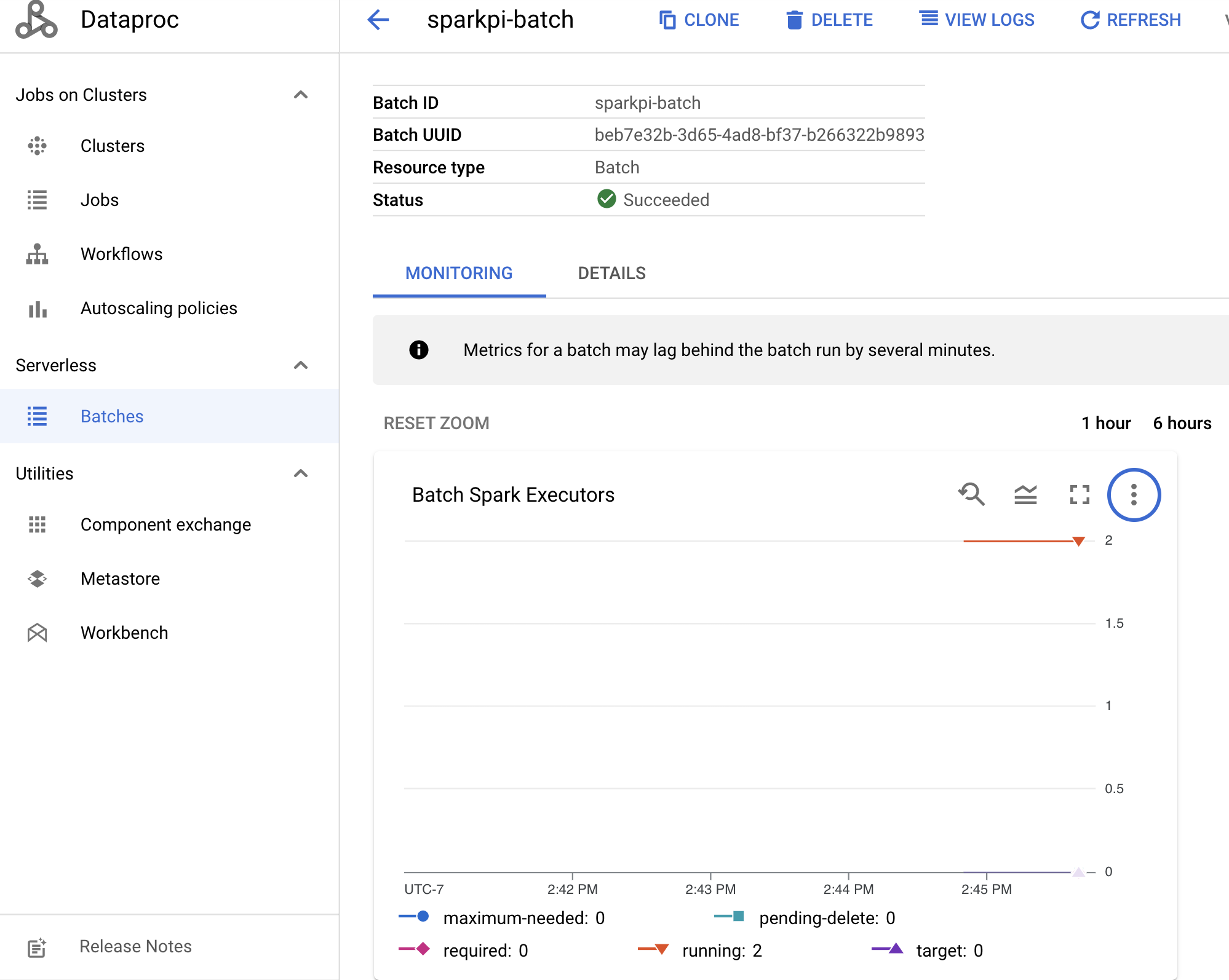

Per visualizzare le metriche batch, fai clic su un ID batch nella pagina Batch di Dataproc nella consoleGoogle Cloud per aprire la pagina Dettagli del batch, che mostra un grafico delle metriche per il workload batch nella scheda Monitoraggio.

Per ulteriori informazioni su come visualizzare le metriche raccolte, consulta Cloud Monitoring di Dataproc.