Questa pagina spiega come importare i metadati in un servizio Dataproc Metastore.

La funzionalità di importazione dei metadati ti consente di popolare un servizio Dataproc Metastore esistente con i metadati archiviati in un formato di archiviazione portatile.

Questi metadati portatili vengono in genere esportati da un altro servizio Dataproc Metastore o da un metastore Hive (HMS) autogestito.

Informazioni sull'importazione dei metadati

Puoi importare i seguenti formati di file in Dataproc Metastore:

- Un insieme di file Avro archiviati in una cartella.

- Un singolo file di dump MySQL archiviato in una cartella Cloud Storage.

I file MySQL o Avro che importi devono essere generati da un database relazionale.

Se i file sono in un formato diverso, ad esempio PostgreSQL, devi convertirli nel formato Avro o MySQL. Dopo la conversione, puoi importarli in Dataproc Metastore.

Avro

Le importazioni basate su Avro sono supportate solo per le versioni 2.3.6 e 3.1.2 di Hive. Quando

importa i file Avro, Dataproc Metastore prevede una serie di

file <table-name>.avro per ogni tabella del database.

Per importare file Avro, il servizio Dataproc Metastore può utilizzare il tipo di database MySQL o Spanner.

MySQL

Le importazioni basate su MySQL sono supportate per tutte le versioni di Hive. Quando importi file MySQL, Dataproc Metastore prevede un singolo file SQL contenente tutte le informazioni sulle tabelle. Sono supportati anche i dump MySQL ottenuti da un cluster Dataproc utilizzando SQL nativo.

Per importare file MySQL, il servizio Dataproc Metastore deve utilizzare il tipo di database MySQL. Il tipo di database Spanner non supporta le importazioni MySQL.

Considerazioni sull'importazione

L'importazione sovrascrive tutti i metadati esistenti archiviati in un servizio Dataproc Metastore.

La funzionalità di importazione dei metadati importa solo i metadati. I dati creati da Apache Hive nelle tabelle interne non vengono replicati nell'importazione.

L'importazione non trasforma i contenuti del database e non gestisce la migrazione dei file. Se sposti i dati in una posizione diversa, devi aggiornare manualmente le posizioni e lo schema dei dati delle tabelle nel servizio Dataproc Metastore.

L'importazione non ripristina o sostituisce i criteri IAM granulari.

Se utilizzi i controlli di servizio VPC, puoi importare i dati solo da un bucket Cloud Storage che si trova nello stesso perimetro di servizio del servizio Dataproc Metastore.

Prima di iniziare

- Abilita Dataproc Metastore nel tuo progetto.

- Comprendere i requisiti di networking specifici per il tuo progetto.

- Crea un servizio Dataproc Metastore.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per importare i metadati in Dataproc Metastore, chiedi all'amministratore di concederti i seguenti ruoli IAM:

-

Per importare i metadati:

-

Editor Dataproc Metastore (

roles/metastore.editor) sul servizio di metadati. -

Amministratore Dataproc Metastore (

roles/metastore.admin) sul progetto.

-

Editor Dataproc Metastore (

-

Per MySQL, per utilizzare l'oggetto Cloud Storage (file di dump SQL) per l'importazione:

concedi al tuo account utente e all'agente di servizio Dataproc Metastore il ruolo Visualizzatore oggetti Storage (

roles/storage.objectViewer) sul bucket Cloud Storage contenente il dump dei metadati da importare. -

Per Avro, per utilizzare il bucket Cloud Storage per l'importazione:

concedi al tuo account utente e all'agente di servizio Dataproc Metastore il ruolo Storage Object Viewer (

roles/storage.objectViewer) sul bucket Cloud Storage contenente il dump dei metadati da importare.

Per ulteriori informazioni sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Questi ruoli predefiniti contengono le autorizzazioni necessarie per importare i metadati in Dataproc Metastore. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

Per importare i metadati in Dataproc Metastore sono necessarie le seguenti autorizzazioni:

-

Per importare i metadati:

metastore.imports.createsul servizio metastore. -

Per MySQL, per utilizzare l'oggetto Cloud Storage (file di dump SQL) per l'importazione, concedi al tuo account utente e all'agente di servizio Dataproc Metastore:

storage.objects.getsul bucket Cloud Storage contenente il dump dei metadati da importare. -

Per Avro, per utilizzare il bucket Cloud Storage per l'importazione, concedi al tuo account utente e all'agente di servizio Dataproc Metastore:

storage.objects.getsul bucket Cloud Storage contenente il dump dei metadati da importare.

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Per ulteriori informazioni su ruoli e autorizzazioni specifici di Dataproc Metastore, consulta la panoramica di IAM di Dataproc Metastore.Importare i metadati

L'operazione di importazione è una procedura in due passaggi. Per prima cosa, prepara i file di importazione e poi importali in Dataproc Metastore.

Quando avvii un'importazione, Dataproc Metastore esegue una convalida dello schema dei metadati Hive. Questa convalida verifica le tabelle nel file di dump SQL e i nomi file per Avro. Se manca una tabella, l'importazione non riesce e viene visualizzato un messaggio di errore che descrive la tabella mancante.

Per verificare la compatibilità dei metadati Hive prima di un'importazione, puoi utilizzare il toolkit Dataproc Metastore.

Prepara i file di importazione prima dell'importazione

Prima di poter importare i file in Dataproc Metastore, devi copiare i file di dump dei metadati in Cloud Storage, ad esempio nel bucket Cloud Storage degli artefatti.

Sposta i file su Cloud Storage

Crea un dump del database esterno che vuoi importare in Dataproc Metastore.

Per istruzioni sulla creazione di un dump del database, consulta le seguenti pagine:

Carica i file in Cloud Storage.

Assicurati di annotare il percorso Cloud Storage in cui carichi i file, in quanto dovrai utilizzarlo in un secondo momento per eseguire l'importazione.

Se importi file MySQL, carica il file SQL in un bucket Cloud Storage.

Se importi file Avro, caricali in una cartella Cloud Storage.

- L'importazione Avro deve includere un file Avro per ogni tabella Hive, anche se la tabella è vuota.

- I nomi dei file Avro devono seguire il formato

<table-name>.avro.<table-name>deve essere tutto maiuscolo. Ad esempio:AUX_TABLE.avro.

Importa i file in Dataproc Metastore

Prima di importare i metadati, consulta le considerazioni sull'importazione.

Durante l'esecuzione di un'importazione, non puoi aggiornare un servizio Dataproc Metastore, ad esempio modificando le impostazioni di configurazione. Tuttavia, puoi comunque utilizzarlo per operazioni normali, ad esempio per accedere ai relativi metadati da cluster Dataproc o autogestiti collegati.

Console

Nella console Google Cloud , apri la pagina Dataproc Metastore:

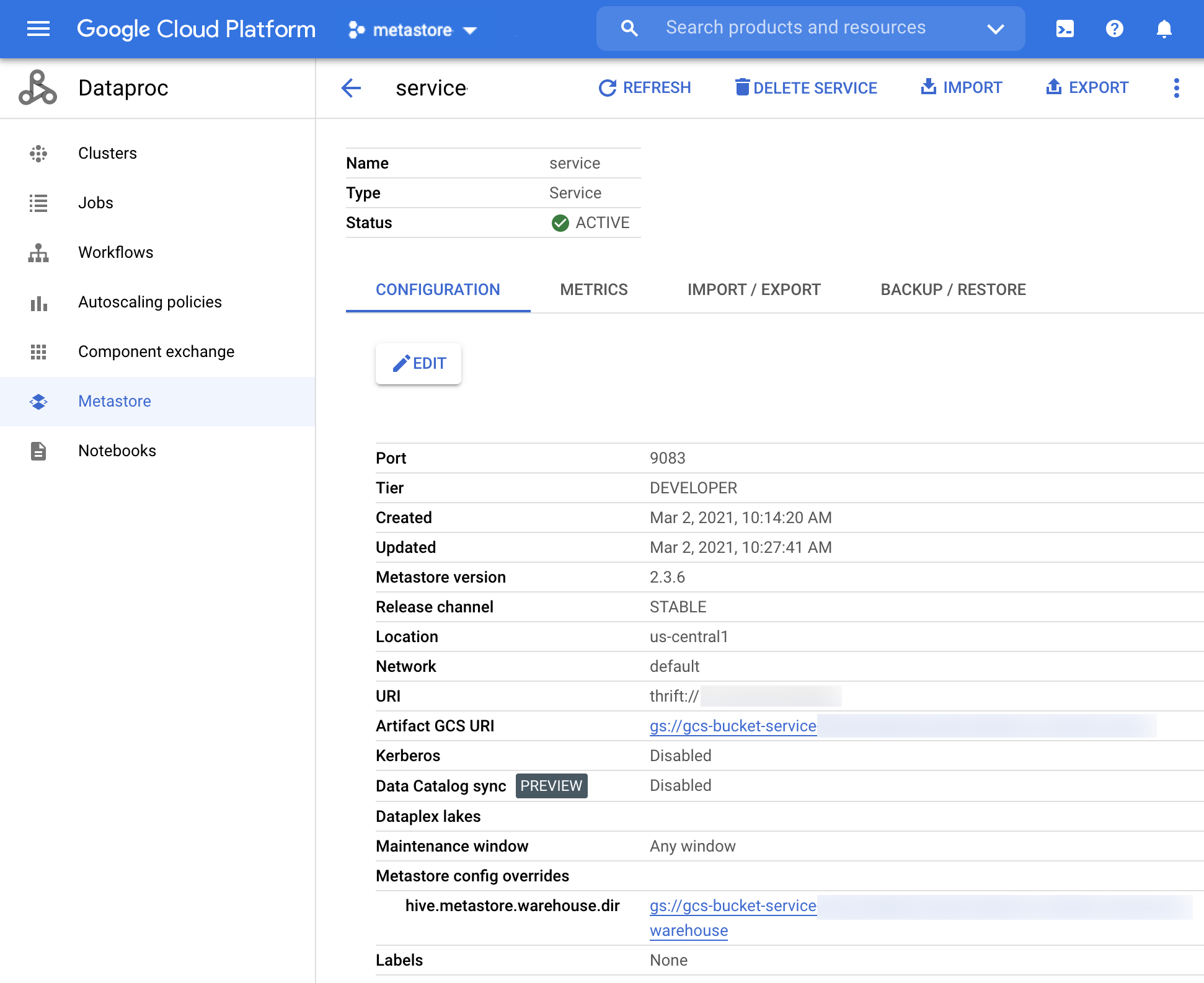

Nella pagina Dataproc Metastore, fai clic sul nome del servizio in cui vuoi importare i metadati.

Viene visualizzata la pagina Dettagli servizio.

Figura 1. La pagina dei dettagli del servizio Dataproc Metastore. Nella barra di navigazione, fai clic su Importa.

Si apre la finestra di dialogo Importa.

Inserisci il nome dell'importazione.

Nella sezione Destinazione, scegli MySQL o Avro.

Nel campo URI di destinazione, fai clic su Sfoglia e seleziona l'URI Cloud Storage in cui vuoi importare i file.

Puoi anche inserire manualmente la posizione del bucket nel campo di testo fornito. Utilizza il formato seguente:

bucket/objectobucket/folder/object.(Facoltativo) Inserisci una descrizione dell'importazione.

Puoi modificare la descrizione nella pagina Dettagli del servizio.

Per aggiornare il servizio, fai clic su Importa.

Al termine dell'importazione, viene visualizzato in una tabella nella pagina Dettagli del servizio della scheda Importa/Esporta.

Interfaccia a riga di comando gcloud

Per importare i metadati, esegui questo comando

gcloud metastore services import gcs:gcloud metastore services import gcs SERVICE_ID \ --location=LOCATION \ --import-id=IMPORT_ID \ --description=DESCRIPTION \ --dump-type=DUMP_TYPE \ --database-dump=DATABASE_DUMP

Sostituisci quanto segue:

SERVICE_ID: l'ID o il nome completo del servizio Dataproc Metastore.LOCATION: la regione Google Cloud in cui si trova il servizio Dataproc Metastore.IMPORT_ID: un ID o un nome completo per l'importazione dei metadati. Ad esempio,import1.DESCRIPTION: (facoltativo) una descrizione dell'importazione. Puoi modificarlo in un secondo momento utilizzandogcloud metastore services imports update IMPORT.DUMP_TYPE: il tipo di database esterno che stai importando. I valori accettati includonomysqleavro. Il valore predefinito èmysql.DATABASE_DUMP: il percorso di Cloud Storage contenente i file di database. Questo percorso deve iniziare congs://. Per Avro, fornisci il percorso della cartella in cui sono archiviati i file Avro (la cartella Cloud Storage). Per MySQL, fornisci il percorso del file MySQL (l'oggetto Cloud Storage).

Verifica che l'importazione sia riuscita.

REST

Segui le istruzioni dell'API per importare i metadati in un servizio utilizzando Explorer API.

Utilizzando l'API, puoi creare, elencare, descrivere e aggiornare le importazioni, ma non puoi eliminarle. Tuttavia, l'eliminazione di un servizio Dataproc Metastore comporta l'eliminazione di tutti gli importazioni nidificate memorizzate.

Quando l'importazione va a buon fine, Dataproc Metastore torna automaticamente allo stato attivo. Se l'importazione non va a buon fine, Dataproc Metastore esegue il rollback allo stato integro precedente.

Visualizzazione della cronologia di importazione

Per visualizzare la cronologia delle importazioni di un servizio Dataproc Metastore nella console Google Cloud , completa i seguenti passaggi:

- Nella console Google Cloud , apri la pagina Dataproc Metastore.

Nella barra di navigazione, fai clic su Importa/Esporta.

La cronologia delle importazioni viene visualizzata nella tabella Cronologia delle importazioni.

La cronologia mostra fino alle ultime 25 importazioni.

L'eliminazione di un servizio Dataproc Metastore comporta anche l'eliminazione di tutta la cronologia di importazione associata.

Risolvere i problemi comuni

Alcuni problemi comuni includono:

- L'importazione non riesce perché le versioni di Hive non corrispondono.

- L'agente di servizio o l'account utente non dispone delle autorizzazioni necessarie.

- Il job non riesce perché il file di database è troppo grande.

Per ulteriore assistenza nella risoluzione dei problemi comuni, vedi Scenari di errore di importazione ed esportazione.