借助 Dataplex Universal Catalog 数据质量任务,您可以在 BigQuery 和 Cloud Storage 中的表之间定义并运行数据质量检查。Dataplex Universal Catalog 数据质量任务还可让您在 BigQuery 环境中应用常规数据控制。

何时创建 Dataplex Universal Catalog 数据质量任务

Dataplex Universal Catalog 数据质量任务可帮助您执行以下操作:

- 在数据生产流水线中对数据进行验证。

- 定期监控数据集的质量是否符合您的预期。

- 构建数据质量报告以满足监管要求。

优势

- 可自定义的规范。您可以使用高度灵活的 YAML 语法来声明您的数据质量规则。

- 无服务器实现。Dataplex Universal Catalog 无需任何基础设施设置。

- 零复制和自动下推。YAML 检查将转换为 SQL 并下推至 BigQuery,因此无需复制数据。

- 可调度的数据质量检查。您可以通过 Dataplex Universal Catalog 中的无服务器调度器安排数据质量检查,也可以通过 Cloud Composer 等外部调度器使用 Dataplex API 进行流水线集成。

- 代管式体验。Dataplex Universal Catalog 使用开源数据质量引擎 CloudDQ 来运行数据质量检查。不过,Dataplex Universal Catalog 提供了无缝的托管式体验来执行数据质量检查。

数据质量任务的工作原理

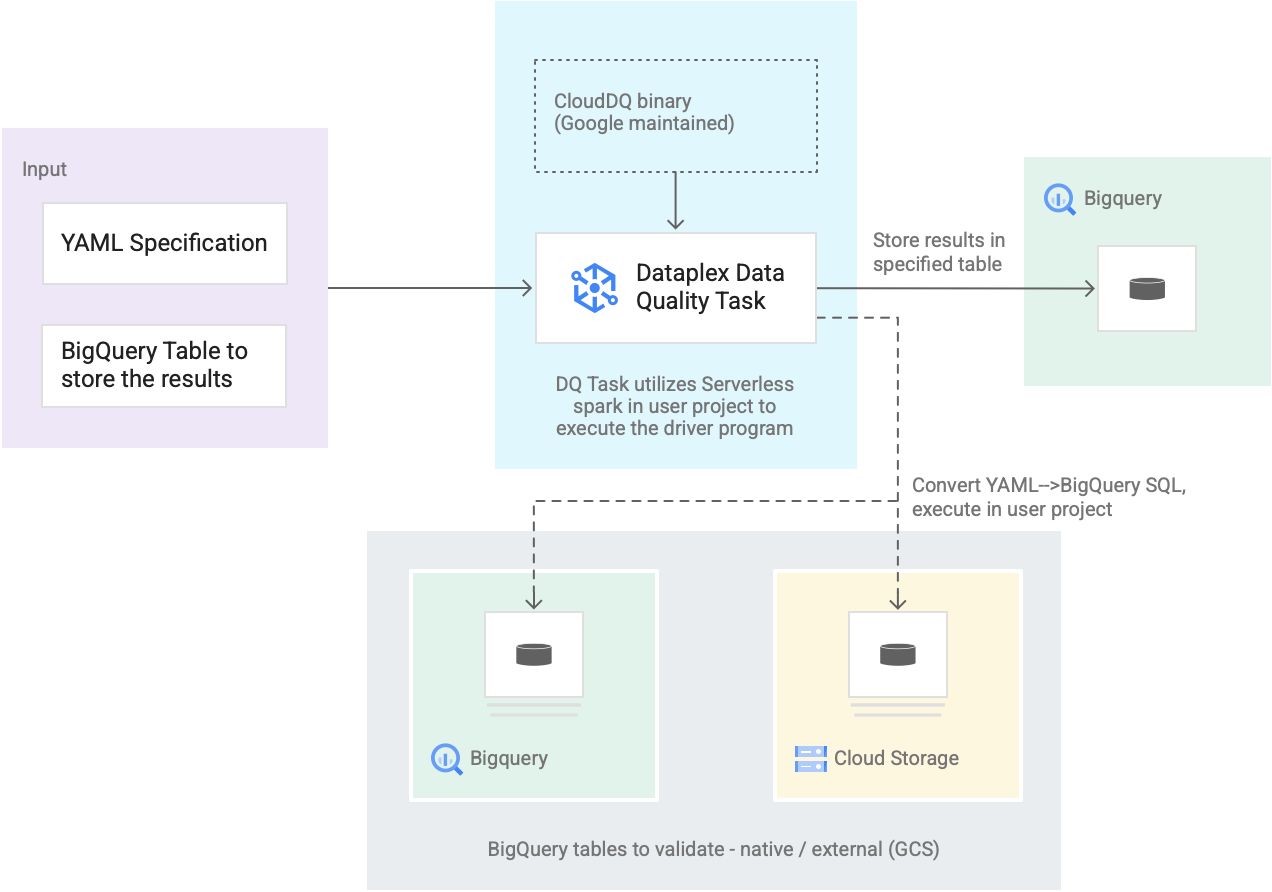

下图展示了 Dataplex Universal Catalog 数据质量任务的工作原理:

- 用户输入

- YAML 规范:一个或多个 YAML 文件,用于定义基于规范语法的数据质量规则。您需要将 YAML 文件存储在项目的 Cloud Storage 存储桶中。用户可以同时运行多个规则,并且这些规则可以应用于不同的 BigQuery 表,包括不同数据集或 Google Cloud项目中的表。该规范支持增量运行,以仅对新数据进行验证。如需创建 YAML 规范,请参阅创建规范文件。

- BigQuery 结果表:用户指定的表,用于存储数据质量验证结果。此表所在的 Google Cloud 项目可与使用 Dataplex Universal Catalog 数据质量任务的项目不同。

- 要验证的表

- 在 YAML 规范中,您需要指定要根据哪些规则对哪些表进行验证(也称为规则绑定)。这些表可以是 BigQuery 原生表,也可以是 Cloud Storage 中的 BigQuery 外部表。YAML 规范可让您指定位于 Dataplex Universal Catalog 区域内部或外部的表。

- 单次运行中验证的 BigQuery 和 Cloud Storage 表可以属于不同的项目。

- Dataplex Universal Catalog 数据质量任务:Dataplex Universal Catalog 数据质量任务配置了由 Google 维护的预构建 CloudDQ PySpark 二进制文件,并接受 YAML 规范和 BigQuery 结果表作为输入。与其他 Dataplex Universal Catalog 任务类似,Dataplex Universal Catalog 数据质量任务在无服务器 Spark 环境中运行,将 YAML 规范转换为 BigQuery 查询,然后对规范文件中定义的表运行这些查询。

价格

运行 Dataplex Universal Catalog 数据质量任务时,您需要为 BigQuery 和 Serverless for Apache Spark(批处理)用量付费。

Dataplex Universal Catalog 数据质量任务会将规范文件转换为 BigQuery 查询,并在用户项目中运行这些查询。请参阅 BigQuery 价格。

Dataplex Universal Catalog 使用 Spark 运行由 Google 维护的预构建开源 CloudDQ 驱动程序,将用户规范转换为 BigQuery 查询。请参阅 Serverless for Apache Spark 价格。

使用 Dataplex Universal Catalog 整理数据或使用 Dataplex Universal Catalog 中的无服务器调度器安排数据质量检查不会产生任何费用。请参阅 Dataplex Universal Catalog 价格。