Étape 3 : Déterminez le mécanisme d'intégration

Cette page décrit la troisième étape du déploiement de Cortex Framework Data Foundation, le cœur de Cortex Framework. Dans cette étape, vous allez configurer l'intégration à la source de données de votre choix. Si vous utilisez des exemples de données, ignorez cette étape.

Présentation de l'intégration

Cortex Framework vous aide à centraliser les données provenant de différentes sources et d'autres plates-formes. Cela crée une source unique de vérité pour vos données. Cortex Data Foundation s'intègre à chaque source de données de différentes manières, mais la plupart d'entre elles suivent une procédure similaire :

- Couche "Source vers Brut" : ingérez les données de la source de données dans l'ensemble de données brutes à l'aide d'API. Pour ce faire, vous devez utiliser des pipelines Dataflow déclenchés par des DAG Cloud Composer.

- Couche brute vers couche CDC : appliquez le traitement CDC à l'ensemble de données brutes et stockez le résultat dans l'ensemble de données CDC. Pour ce faire, des DAG Cloud Composer exécutent des requêtes SQL BigQuery.

- Couche CDC vers couche Reporting : crée des tables de reporting finales à partir des tables CDC dans l'ensemble de données "Reporting". Pour ce faire, vous pouvez créer des vues d'exécution au-dessus des tables CDC ou exécuter des DAG Cloud Composer pour les données matérialisées dans les tables BigQuery, selon la configuration. Pour en savoir plus sur la configuration, consultez Personnaliser le fichier de paramètres de création de rapports.

Le fichier config.json configure les paramètres requis pour se connecter aux sources de données afin de transférer les données de différentes charges de travail. Consultez les ressources suivantes pour découvrir les options d'intégration de chaque source de données.

- Opérationnel :

- Marketing :

- Durabilité :

Pour en savoir plus sur les diagrammes entité-relation compatibles avec chaque source de données, consultez le dossier docs dans le dépôt Cortex Framework Data Foundation.

Déploiement K9

Le déployeur K9 simplifie l'intégration de diverses sources de données. Le déployeur K9 est un ensemble de données prédéfini dans l'environnement BigQuery. Il est chargé d'ingérer, de traiter et de modéliser les composants réutilisables dans différentes sources de données.

Par exemple, la dimension time est réutilisable dans toutes les sources de données où les tables peuvent avoir besoin de prendre des résultats analytiques basés sur un calendrier grégorien. Le déploiement K9 combine des données externes telles que la météo ou Google Trends avec d'autres sources de données (par exemple, SAP, Salesforce, Marketing). Cet ensemble de données enrichi permet d'obtenir des insights plus approfondis et des analyses plus complètes.

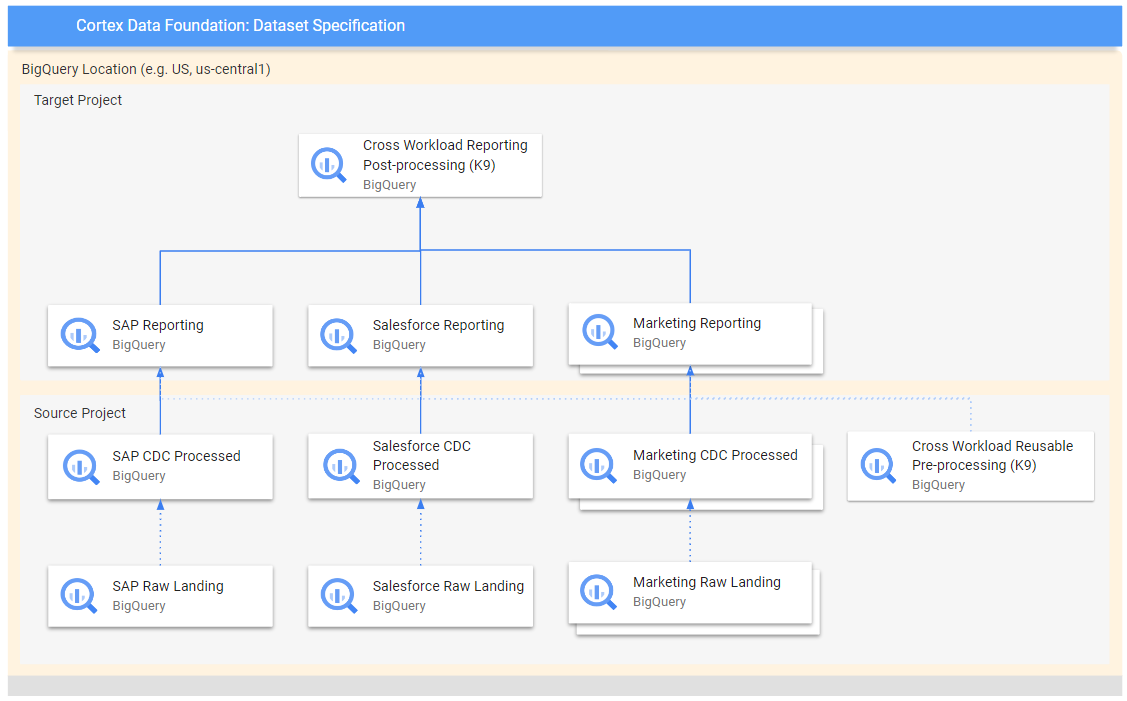

Le schéma suivant illustre le flux de données depuis différentes sources brutes vers plusieurs couches de reporting :

Dans le schéma, le projet source contient les données brutes des sources de données choisies (SAP, Salesforce et Marketing). Le projet cible contient des données traitées, issues du processus de capture des données modifiées (CDC).

L'étape K9 de prétraitement s'exécute avant le déploiement de toutes les charges de travail. Les modèles réutilisables sont donc disponibles lors de leur déploiement. Cette étape transforme les données provenant de différentes sources pour créer un ensemble de données cohérent et réutilisable.

Les étapes K9 de post-traitement ont lieu après que toutes les charges de travail ont déployé leurs modèles de reporting pour permettre le reporting inter-charges de travail ou l'augmentation des modèles afin de trouver leurs dépendances nécessaires dans chaque ensemble de données de reporting individuel.

Configurer le déploiement K9

Configurez les graphes orientés acycliques (DAG) et les modèles à générer dans le fichier manifeste K9.

L'étape de prétraitement K9 est importante, car elle garantit que toutes les charges de travail du pipeline de données ont accès à des données préparées de manière cohérente. Cela réduit la redondance et assure la cohérence des données.

Pour savoir comment configurer des ensembles de données externes pour K9, consultez Configurer des ensembles de données externes pour K9.

Étapes suivantes

Une fois cette étape terminée, passez aux étapes de déploiement suivantes :

- Établissez des charges de travail.

- Clonez le dépôt.

- Déterminez le mécanisme d'intégration (cette page).

- Configurer les composants

- Configurez le déploiement.

- Exécutez le déploiement.