Paso 3: Determina el mecanismo de integración

En esta página, se describe el tercer paso para implementar Cortex Framework Data Foundation, el núcleo de Cortex Framework. En este paso, configurarás la integración con la fuente de datos que elegiste. Si usas datos de muestra, omite este paso.

Descripción general de la integración

Cortex Framework te ayuda a centralizar los datos de varias fuentes, junto con otras plataformas. Esto crea una única fuente de verdad para tus datos. Cortex Data Foundation se integra con cada fuente de datos de diferentes maneras, pero la mayoría de ellas siguen un procedimiento similar:

- Capa de origen a sin procesar: Transfiere datos de la fuente de datos al conjunto de datos sin procesar con APIs. Esto se logra con canalizaciones de Dataflow que se activan a través de DAG de Cloud Composer.

- Capa sin procesar a capa de CDC: Aplica el procesamiento de CDC en el conjunto de datos sin procesar y almacena el resultado en el conjunto de datos de CDC. Esto se logra con los DAGs de Cloud Composer que ejecutan SQLs de BigQuery.

- Capa de CDC a capa de informes: Crea tablas de informes finales a partir de tablas de CDC en el conjunto de datos de informes. Esto se logra creando vistas de tiempo de ejecución sobre las tablas de CDC o ejecutando DAG de Cloud Composer para los datos materializados en las tablas de BigQuery, según cómo se configure. Para obtener más información sobre la configuración, consulta Cómo personalizar el archivo de configuración de los parámetros de informes.

El archivo config.json configura los parámetros necesarios para conectarse a las fuentes de datos y transferir datos de diversas cargas de trabajo. Consulta las opciones de integración para cada fuente de datos en los siguientes recursos.

- Operacionales:

- Marketing:

- Sustentabilidad:

Para obtener más información sobre los diagramas de entidad-relación que admite cada fuente de datos, consulta la carpeta docs en el repositorio de Data Foundation de Cortex Framework.

Implementación de K9

El implementador de K9 simplifica la integración de diversas fuentes de datos. El implementador de K9 es un conjunto de datos predefinido dentro del entorno de BigQuery que se encarga de la transferencia, el procesamiento y el modelado de componentes que se pueden reutilizar en diferentes fuentes de datos.

Por ejemplo, la dimensión time se puede reutilizar en todas las fuentes de datos en las que las tablas podrían necesitar tomar resultados analíticos basados en un calendario gregoriano. El sistema de implementación K9 combina datos externos, como el clima o Google Trends, con otras fuentes de datos (por ejemplo, SAP, Salesforce y Marketing). Este conjunto de datos enriquecido permite obtener estadísticas más detalladas y análisis más completos.

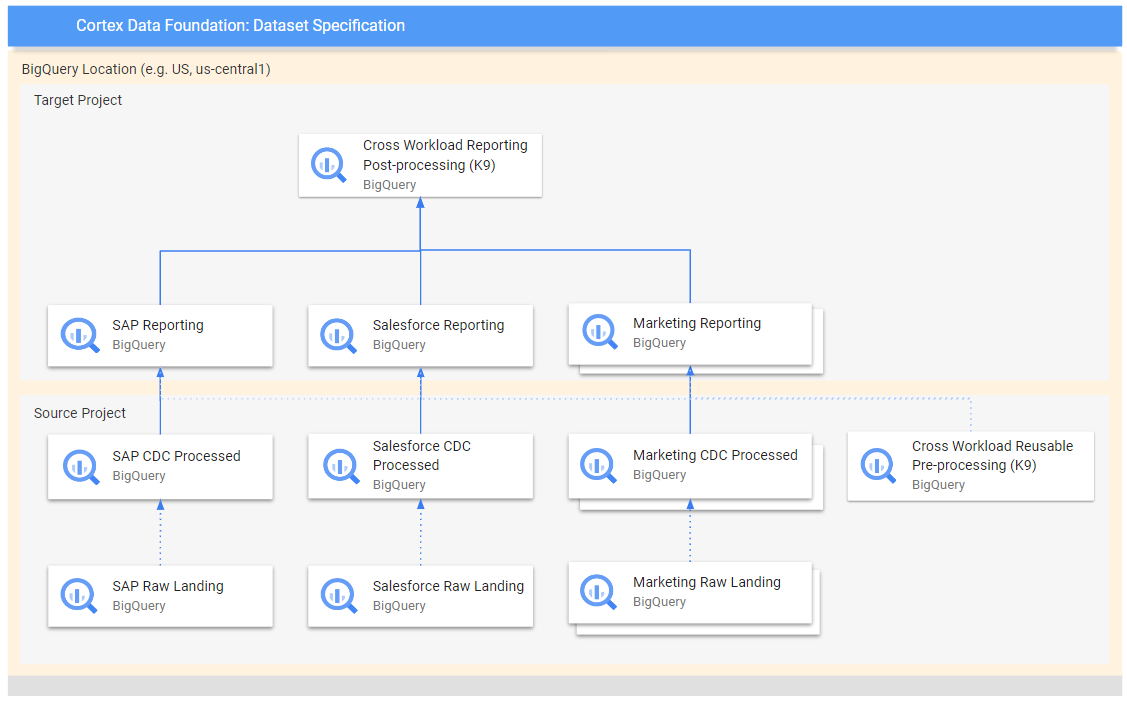

En el siguiente diagrama, se muestra el flujo de datos desde diferentes fuentes sin procesar hasta varias capas de informes:

En el diagrama, el proyecto de origen contiene los datos sin procesar de las fuentes de datos elegidas (SAP, Salesforce y Marketing). Mientras que el proyecto de destino contiene datos procesados, derivados del proceso de captura de datos modificados (CDC).

El paso de procesamiento previo K9 se ejecuta antes de que todas las cargas de trabajo comiencen su implementación, por lo que los modelos reutilizables están disponibles durante su implementación. En este paso, se transforman los datos de varias fuentes para crear un conjunto de datos coherente y reutilizable.

Los pasos posteriores al procesamiento de K9 se producen después de que todas las cargas de trabajo implementaron sus modelos de informes para habilitar la generación de informes en todas las cargas de trabajo o aumentar los modelos para encontrar sus dependencias necesarias dentro de cada conjunto de datos de informes individual.

Configura la implementación de K9

Configura los grafos acíclicos dirigidos (DAG) y los modelos que se generarán en el archivo de manifiesto de K9.

El paso de procesamiento previo de K9 es importante porque garantiza que todas las cargas de trabajo dentro de la canalización de datos tengan acceso a datos preparados de manera coherente. Esto reduce la redundancia y garantiza la coherencia de los datos.

Para obtener más información sobre cómo configurar conjuntos de datos externos para K9, consulta Configura conjuntos de datos externos para K9.

Próximos pasos

Después de completar este paso, continúa con los siguientes pasos de implementación:

- Establece cargas de trabajo.

- Clona el repositorio.

- Determina el mecanismo de integración (esta página).

- Configura los componentes.

- Configura la implementación.

- Ejecuta la implementación.