Paso 1: Establece las cargas de trabajo

En esta página, se explica el paso inicial para configurar tu base de datos, que es el núcleo de Cortex Framework. La base de datos, que se basa en el almacenamiento de BigQuery, organiza los datos entrantes de diversas fuentes. Estos datos organizados simplifican el análisis y su aplicación en el desarrollo de la IA.

Configura la integración de datos

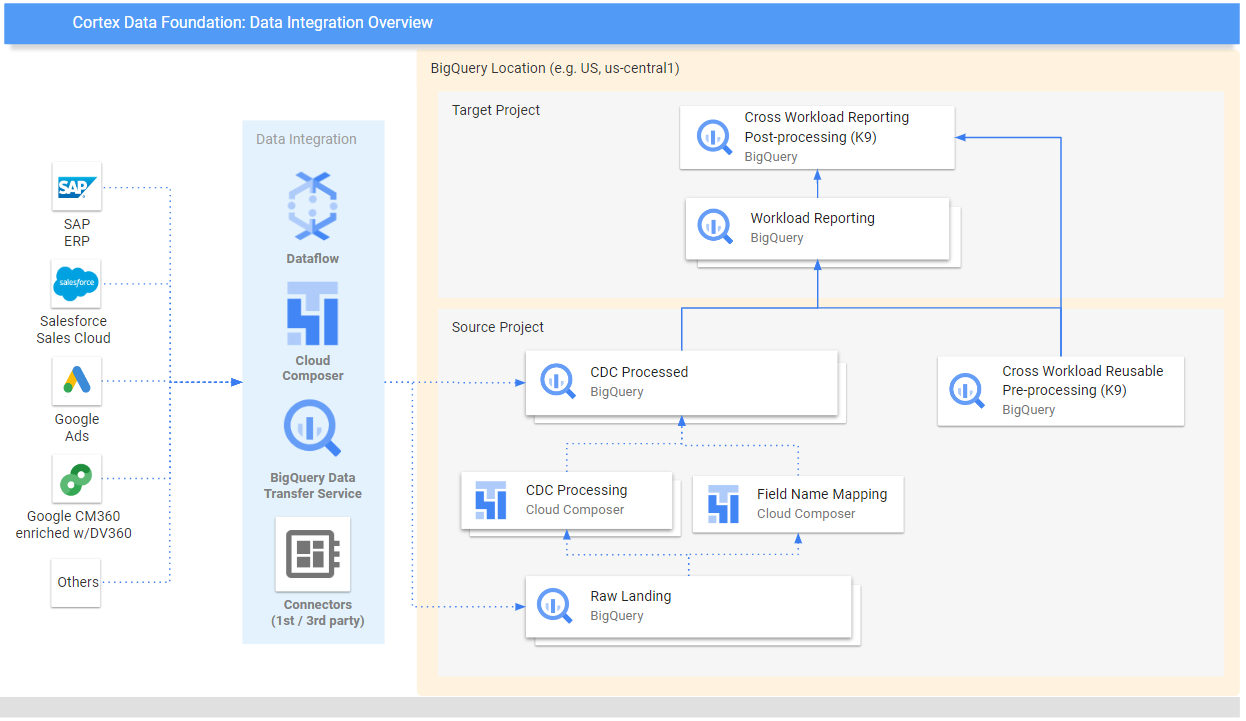

Comienza por definir algunos parámetros clave que actuarán como un plan para organizar y usar tus datos de manera eficiente en Cortex Framework. Recuerda que estos parámetros pueden variar según la carga de trabajo específica, el flujo de datos que elijas y el mecanismo de integración. En el siguiente diagrama, se proporciona una descripción general de la integración de datos en la base de datos de Cortex Framework:

Define los siguientes parámetros antes de la implementación para lograr un uso de datos eficiente y eficaz dentro de Cortex Framework.

Proyectos

- Proyecto de origen: Es el proyecto en el que residen tus datos sin procesar. Necesitas al menos un proyecto Google Cloud para almacenar datos y ejecutar el proceso de implementación.

- Proyecto de destino (opcional): Es el proyecto en el que Cortex Framework Data Foundation almacena sus modelos de datos procesados. Puede ser el mismo que el proyecto de origen o uno diferente, según tus necesidades.

Si deseas tener conjuntos separados de proyectos y conjuntos de datos para cada carga de trabajo (por ejemplo, un conjunto de proyectos de origen y destino para SAP y un conjunto diferente de proyectos de origen y destino para Salesforce), ejecuta implementaciones separadas para cada carga de trabajo. Para obtener más información, consulta Usa diferentes proyectos para segregar el acceso en la sección de pasos opcionales.

Modelo de datos

- Implementar modelos: Elige si necesitas implementar modelos para todas las cargas de trabajo o solo un conjunto de modelos (por ejemplo, SAP, Salesforce y Meta). Para obtener más información, consulta las Fuentes de datos y cargas de trabajo disponibles.

Conjuntos de datos de BigQuery

- Conjunto de datos de origen (sin procesar): Conjunto de datos de BigQuery en el que se replican los datos de origen o en el que se crean los datos de prueba. Se recomienda tener conjuntos de datos separados, uno para cada fuente de datos. Por ejemplo, un conjunto de datos sin procesar para SAP y otro para Google Ads. Este conjunto de datos pertenece al proyecto fuente.

- Conjunto de datos de CDC: Conjunto de datos de BigQuery en el que se almacenan los registros disponibles más recientes de los datos procesados de CDC. Algunas cargas de trabajo permiten la asignación de nombres de campos. Se recomienda tener un conjunto de datos de CDC independiente para cada fuente. Por ejemplo, un conjunto de datos de CDC para SAP y otro para Salesforce. Este conjunto de datos pertenece al proyecto fuente.

- Conjunto de datos de informes de destino: Conjunto de datos de BigQuery en el que se implementan los modelos de datos predefinidos de Data Foundation. Te recomendamos que tengas un conjunto de datos de informes independiente para cada fuente. Por ejemplo, un conjunto de datos de informes para SAP y otro para Salesforce. Este conjunto de datos se crea automáticamente durante la implementación si no existe. Este conjunto de datos pertenece al proyecto de destino.

- Pre-processing K9 Dataset: Es un conjunto de datos de BigQuery en el que se pueden implementar componentes de DAG reutilizables y entre cargas de trabajo, como las dimensiones de

time. Las cargas de trabajo tienen una dependencia de este conjunto de datos, a menos que se modifique. Este conjunto de datos se crea automáticamente durante la implementación si no existe. Este conjunto de datos pertenece al proyecto fuente. - Conjunto de datos K9 posterior al procesamiento: Es el conjunto de datos de BigQuery en el que se pueden implementar informes entre cargas de trabajo y DAG de fuentes externas adicionales (por ejemplo, la transferencia de datos de Google Trends). Este conjunto de datos se crea automáticamente durante la implementación si no existe. Este conjunto de datos pertenece al proyecto Target.

Opcional: Genera datos de muestra

Cortex Framework puede generar datos y tablas de muestra para ti si no tienes acceso a tus propios datos, herramientas de replicación para configurar datos o incluso si solo quieres ver cómo funciona Cortex Framework. Sin embargo, aún debes crear e identificar los conjuntos de datos de CDC y sin procesar con anticipación.

Crea conjuntos de datos de BigQuery para los datos sin procesar y los datos de CDC por fuente de datos, siguiendo las instrucciones que se indican a continuación.

Console

Abre la página de BigQuery en la Google Cloud consola.

En el panel Explorador, selecciona el proyecto en el que deseas crear el conjunto de datos.

Expande la opción Acciones y haz clic en Crear conjunto de datos:

En la página Crear conjunto de datos:

- En ID de conjunto de datos, ingresa un nombre único para el conjunto de datos.

En Tipo de ubicación, elige una ubicación geográfica para el conjunto de datos (opcional). Después de crear un conjunto de datos, la ubicación no se puede cambiar.

Opcional. Para obtener más detalles sobre la personalización de tu conjunto de datos, consulta Crea conjuntos de datos: Consola.

Haz clic en Crear conjunto de datos.

BigQuery

Crea un nuevo conjunto de datos para los datos sin procesar copiando el siguiente comando:

bq --location= LOCATION mk -d SOURCE_PROJECT: DATASET_RAWReemplaza lo siguiente:

LOCATIONcon la ubicación del conjunto de datos.SOURCE_PROJECTcon el ID de tu proyecto de origen.DATASET_RAWcon el nombre de tu conjunto de datos para los datos sin procesar. Por ejemplo,CORTEX_SFDC_RAW

Copia el siguiente comando para crear un nuevo conjunto de datos para los datos de los CDC:

bq --location=LOCATION mk -d SOURCE_PROJECT: DATASET_CDCReemplaza lo siguiente:

LOCATIONcon la ubicación del conjunto de datos.SOURCE_PROJECTcon el ID de tu proyecto de origen.DATASET_CDCcon el nombre de tu conjunto de datos para los datos del CDC. Por ejemplo,CORTEX_SFDC_CDC

Confirma que se crearon los conjuntos de datos con el siguiente comando:

bq lsOpcional. Para obtener más información sobre la creación de conjuntos de datos, consulta Crea conjuntos de datos.

Próximos pasos

Después de completar este paso, continúa con los siguientes pasos de implementación:

- Establece cargas de trabajo (esta página).

- Clona el repositorio.

- Determina el mecanismo de integración.

- Configura los componentes.

- Configura la implementación.

- Ejecuta la implementación.