Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Auf dieser Seite wird die Architektur von Cloud Composer-Umgebungen beschrieben.

Konfigurationen der Umgebungsarchitektur

Cloud Composer 3-Umgebungen haben eine einzige Konfiguration, die nicht vom Netzwerktyp abhängt:

Kunden- und Mandantenprojekte

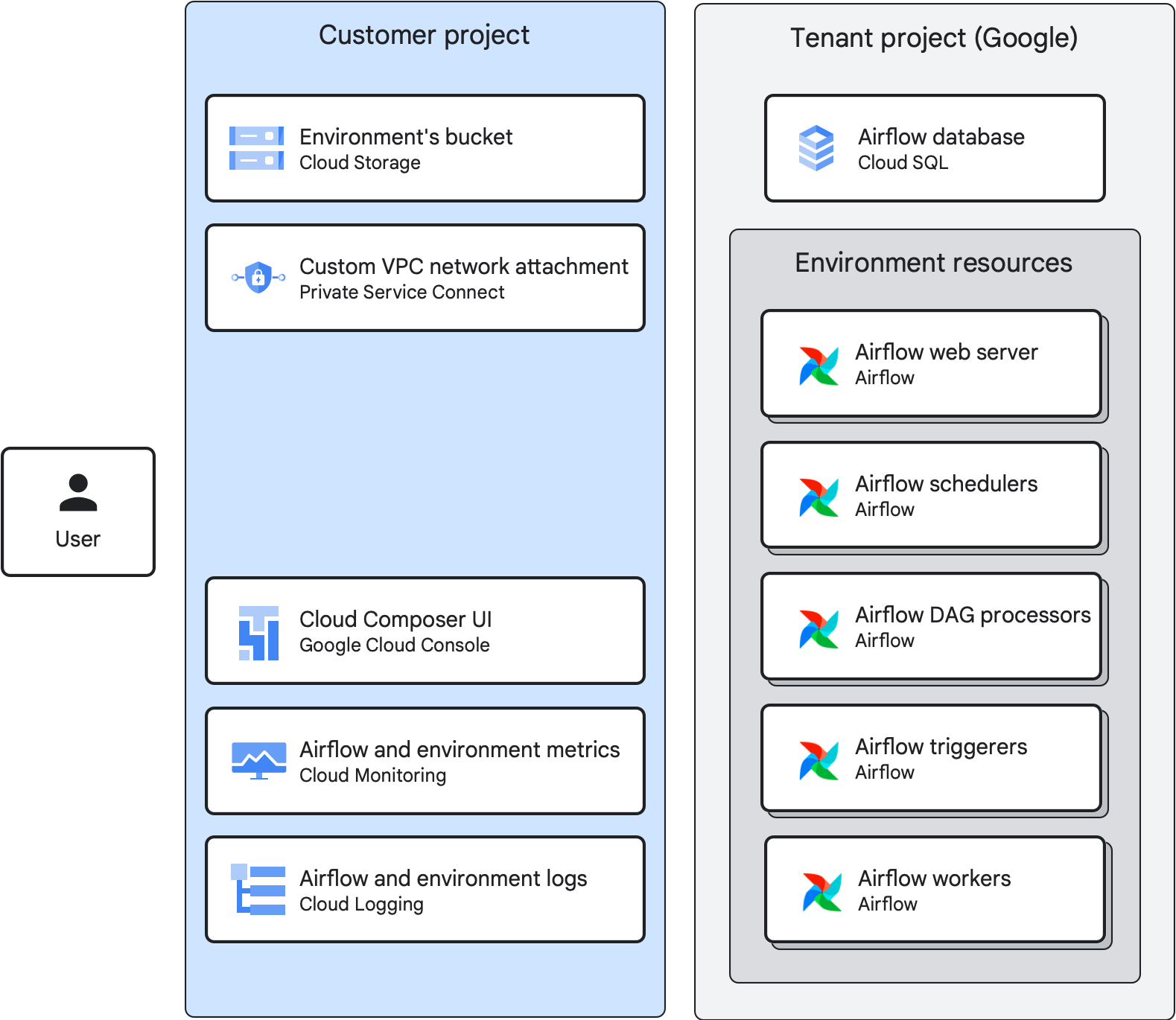

Beim Erstellen einer Umgebung werden die Umgebungsressourcen von Cloud Composer auf ein Mandanten- und ein Kundenprojekt verteilt:

Das Kundenprojekt ist ein Google Cloud -Projekt, in dem Sie Ihre Umgebungen erstellen. Sie können in einem Kundenprojekt mehrere Umgebungen erstellen.

Das Mandantenprojekt ist ein von Google verwaltetes Mandantenprojekt und gehört zur Organisation Google.com. Das Mandantenprojekt bietet eine einheitliche Zugriffssteuerung und eine zusätzliche Datensicherheitsebene für Ihre Umgebung. Jede Cloud Composer-Umgebung hat ein eigenes Mandantenprojekt.

Umgebungskomponenten

Eine Cloud Composer-Umgebung besteht aus Umgebungskomponenten.

Eine Umgebungskomponente ist ein Element einer verwalteten Airflow-Infrastruktur, die auf Google Cloudals Teil Ihrer Umgebung ausgeführt wird. Umgebungskomponenten werden entweder im Mandanten- oder im Kundenprojekt Ihrer Umgebung ausgeführt.

Bucket der Umgebung

Der Bucket der Umgebung ist ein Cloud Storage-Bucket, in dem DAGs, Plug-ins, Datenabhängigkeiten und Airflow-Logs gespeichert werden. Der Bucket der Umgebung befindet sich im Kundenprojekt.

Wenn Sie Ihre DAG-Dateien in den Ordner /dags Ihres Buckets hochladen, synchronisiert Cloud Composer die DAGs mit den Airflow-Komponenten Ihrer Umgebung.

Airflow-Webserver

Der Airflow-Webserver führt die Airflow-UI Ihrer Umgebung aus.

Cloud Composer bietet Zugriff auf die Benutzeroberfläche basierend auf Nutzeridentitäten und IAM-Richtlinienbindungen, die für Nutzer definiert sind.

Airflow-Datenbank

Eine Airflow-Datenbank ist eine Cloud SQL-Instanz, die im Mandantenprojekt Ihrer Umgebung ausgeführt wird. Sie hostet die Airflow-Metadatendatenbank.

Zum Schutz vertraulicher Verbindungs- und Workflowinformationen lässt Cloud Composer den Datenbankzugriff nur auf das Dienstkonto Ihrer Umgebung zu.

Andere Airflow-Komponenten

Weitere Airflow-Komponenten, die in Ihrer Umgebung ausgeführt werden:

Airflow-Planer parsen DAG-Dateien, planen DAG-Ausführungen anhand des Zeitplanintervalls und stellen Aufgaben zur Ausführung durch Airflow-Worker in die Warteschlange.

Airflow-Triggerer überwachen alle ausgesetzten Tasks in Ihrer Umgebung asynchron. Wenn Sie die Anzahl der Trigger in Ihrer Umgebung auf einen Wert über null festlegen, können Sie zurückstellbare Operatoren in Ihren DAGs verwenden.

Airflow-DAG-Prozessoren verarbeiten DAG-Dateien und wandeln sie in DAG-Objekte um. In Cloud Composer 3 werden DAG-Prozessoren als separate Umgebungskomponenten ausgeführt.

Airflow-Worker führen Aufgaben aus, die von Airflow-Planern geplant werden. Die Mindest- und Höchstanzahl an Workern in Ihrer Umgebung ändert sich dynamisch, je nach Anzahl der Aufgaben in der Warteschlange.

Architektur der Cloud Composer 3-Umgebung

In Cloud Composer 3-Umgebungen:

- Im Mandantenprojekt wird eine Cloud SQL-Instanz mit der Airflow-Datenbank gehostet.

- Alle Airflow-Ressourcen werden im Mandantenprojekt ausgeführt.

- Das Kundenprojekt hostet den Bucket der Umgebung.

- Mit einem benutzerdefinierten VPC-Netzwerk-Anhang im Kundenprojekt kann die Umgebung an ein benutzerdefiniertes VPC-Netzwerk angehängt werden. Sie können einen vorhandenen Anhang verwenden oder Cloud Composer kann ihn bei Bedarf automatisch erstellen. Es ist auch möglich, eine Umgebung von einem VPC-Netzwerk zu trennen.

- Über dieGoogle Cloud -Konsole, Monitoring und Logging im Kundenprojekt können Sie die Umgebung, DAGs und DAG-Ausführungen verwalten und auf die Messwerte und Logs der Umgebung zugreifen. Sie können auch die Airflow-Benutzeroberfläche, die Google Cloud CLI, die Cloud Composer API und Terraform für dieselben Zwecke verwenden.

In hochverfügbaren Cloud Composer 3-Umgebungen:

Die Cloud SQL-Instanz Ihrer Umgebung ist für Hochverfügbarkeit konfiguriert (ist eine regionale Instanz). Innerhalb einer regionalen Instanz besteht die Konfiguration aus einer primären Instanz und einer Standby-Instanz.

In Ihrer Umgebung werden die folgenden Airflow-Komponenten in separaten Zonen ausgeführt:

- Zwei Airflow-Planer

- Zwei Webserver

- Mindestens zwei DAG-Prozessoren (bis zu 10 insgesamt)

Wenn Triggerer verwendet werden, mindestens zwei (bis zu zehn insgesamt)

Die Mindestanzahl der Worker ist auf zwei festgelegt und der Cluster Ihrer Umgebung verteilt Worker-Instanzen auf Zonen. Bei einem Zonenausfall werden betroffene Worker-Instanzen in einer anderen Zone neu geplant.

Einbindung in Cloud Logging und Cloud Monitoring

Cloud Composer kann in Cloud Logging und Cloud Monitoring Ihres Google Cloud Projekts integriert werden, sodass Sie eine zentrale Stelle für die Anzeige von Airflow- und DAG-Logs haben.

Cloud Monitoring sammelt und erfasst Messwerte, Ereignisse und Metadaten aus Cloud Composer, mit denen sich mithilfe von Dashboards und Diagrammen aussagekräftige Informationen generieren lassen.

Aufgrund des Streaming-Charakters von Cloud Logging können Sie alle Logs, die von Airflow-Komponenten gesendet werden, sofort aufrufen. Sie müssen also nicht warten, bis Airflow-Logs im Cloud Storage-Bucket Ihrer Umgebung angezeigt werden.

Wenn Sie die Anzahl der Logs in Ihrem Google Cloud -Projekt begrenzen möchten, können Sie die gesamte Aufnahme von Logs beenden. Deaktivieren Sie das Logging aber nicht.