Questo tutorial descrive come accedere al control plane di un cluster Google Kubernetes Engine (GKE) privato utilizzando i pool privati di Cloud Build. Questo accesso ti consente di utilizzare Cloud Build per eseguire il deployment di applicazioni e gestire risorse su un cluster GKE privato. Questo tutorial è rivolto ad amministratori della piattaforma, amministratori del cluster e sviluppatori. Presuppone che tu abbia familiarità con GKE, Cloud Build, OpenID Connect e lo strumento a riga di comando gcloud.

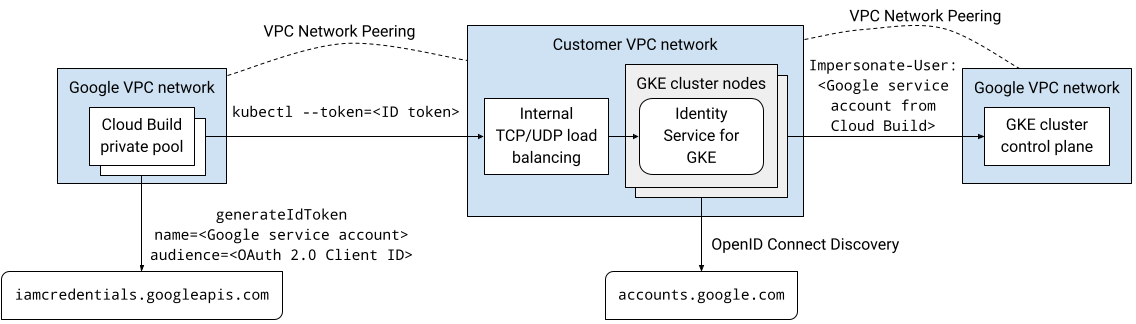

I pool privati di Cloud Build e i piani di controllo dei cluster GKE vengono eseguiti entrambi nelle reti Virtual Private Cloud (VPC) di proprietà di Google. Queste reti VPC sono connesse in peering alla tua rete VPC su Google Cloud. Tuttavia, il peering di rete VPC non supporta il peering transitivo, il che può rappresentare una limitazione quando utilizzi i pool privati di Cloud Build. Questo tutorial presenta una soluzione che utilizza Identity Service for GKE per consentire ai worker di un pool privato di Cloud Build di accedere al control plane di un cluster GKE privato.

Panoramica dell'architettura

Identity Service for GKE è un proxy di autenticazione per i control plane dei cluster GKE. Esegue il proxy delle richieste al server API e convalida i token ID emessi dai provider di identità OpenID Connect (OIDC). Dopo che il proxy ha convalidato correttamente un token ID, aggiunge le intestazioni HTTP di rappresentazione dell'utente alla richiesta originale e la inoltra al server API. Il proxy viene eseguito come account di servizio Kubernetes con autorizzazioni per impersonare utenti e gruppi.

Il proxy Identity Service per GKE viene eseguito come pod sui nodi del cluster. Un servizio Kubernetes di tipo LoadBalancer espone il proxy all'esterno del cluster. Se Identity Service per GKE è abilitato su un cluster privato, il programma di installazione aggiunge un'annotazione al servizio Kubernetes per eseguire il provisioning di un bilanciatore del carico di rete pass-through interno. È possibile accedere al proxy tramite il bilanciatore del carico tramite una connessione di peering di rete VPC, ad esempio da un pool privato Cloud Build, perché il proxy viene eseguito sui nodi del cluster nella rete VPC.

Puoi configurare Google come provider di identità OpenID Connect in Identity Service per GKE perché il sistema di autenticazione OAuth 2.0 di Google è conforme alla specifica OpenID Connect. Per ottenere token ID per un account di servizio Google, puoi utilizzare il metodo generateIdToken dell'API Service Account Credentials. I token ID vengono emessi e firmati da Google.

Mettendo insieme tutti questi elementi, questa soluzione consente l'accesso al piano di controllo del cluster GKE privato utilizzando il proxy di Identity Service per GKE. Le build eseguite in un pool privato di Cloud Build si connettono al proxy tramite una connessione di peering di rete VPC. La build in esecuzione sul pool privato Cloud Build viene eseguita come account di servizio Google. Questo account di servizio Google può ottenere un token ID per l'autenticazione al proxy dall'API Service Account Credentials.

Il seguente diagramma mostra l'architettura descritta nel testo precedente:

Tutta la comunicazione in questa soluzione avviene nello spazio degli indirizzi IP interni. I worker nel pool privato non hanno bisogno di connettività a internet pubblica.

Le autorizzazioni Identity and Access Management (IAM) concesse agli account utente e ai service account Google non vengono applicate quando l'autenticazione viene eseguita utilizzando Identity Service per GKE. Utilizzi invece il controllo dell'controllo dell'accesso basato su ruoli (RBAC) di Kubernetes per gestire le autorizzazioni del cluster per questi account.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, GKE, Identity-Aware Proxy (IAP), and Service Networking APIs APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

container.googleapis.com iap.googleapis.com servicenetworking.googleapis.com -

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, GKE, Identity-Aware Proxy (IAP), and Service Networking APIs APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

container.googleapis.com iap.googleapis.com servicenetworking.googleapis.com In Cloud Shell, crea un cluster GKE che non abbia accesso client all'endpoint pubblico del control plane e su cui sia installato Identity Service per GKE:

gcloud container clusters create CLUSTER \ --enable-identity-service \ --enable-ip-alias \ --enable-master-authorized-networks \ --enable-private-endpoint \ --enable-private-nodes \ --master-ipv4-cidr CONTROL_PLANE_CIDR \ --network NETWORK\ --release-channel regular \ --scopes cloud-platform \ --subnetwork SUBNET \ --tags NODE_TAGS \ --workload-pool PROJECT_ID.svc.id.goog \ --zone ZONESostituisci quanto segue:

- CLUSTER: il nome del cluster. Per questo tutorial, utilizza

private-cluster. - CONTROL_PLANE_CIDR: l'intervallo di indirizzi IP del control plane. Deve avere un prefisso

/28. Per questo tutorial, puoi utilizzare172.16.0.32/28. - NETWORK: la rete VPC a cui si connette il control plane. Per questo tutorial, utilizza

default. - SUBNET: la subnet a cui si connette il control plane del cluster GKE. La subnet deve appartenere alla rete VPC specificata da NETWORK. Per questo tutorial, utilizza

default. - NODE_TAGS: un elenco separato da virgole di tag di rete da applicare ai nodi. Per questo tutorial, utilizza

private-cluster-node. - PROJECT_ID: il tuo ID progetto Google Cloud .

- ZONE: la zona del cluster GKE. Per questo tutorial, utilizza

us-central1-f.

Tieni presente quanto segue in merito al comando:

Il flag

--enable-identity-serviceabilita Identity Service for GKE sul cluster. Nel tuo ambiente, puoi abilitare il servizio di identità per GKE su un cluster esistente.Il flag

--enable-private-endpointconfigura il control plane in modo che sia accessibile solo utilizzando indirizzi IP interni.Il flag

--enable-private-nodesconfigura i nodi del cluster in modo che abbiano solo indirizzi IP interni.I flag

--enable-master-authorized-networkse--enable-private-nodesconsentono l'accesso al server API solo dalle reti private specificate dal flag--network.Il flag facoltativo

--workload-poolabilita Workload Identity Federation for GKE. Non è necessario per questo tutorial.

- CLUSTER: il nome del cluster. Per questo tutorial, utilizza

Aggiungi una regola firewall che consenta al control plane del cluster GKE di connettersi al webhook di ammissione di convalida per le risorse ClientConfig:

gcloud compute firewall-rules create allow-control-plane-clientconfig-webhook \ --allow tcp:15000 \ --network NETWORK\ --source-ranges CONTROL_PLANE_CIDR\ --target-tags NODE_TAGSClientConfig è un tipo di risorsa personalizzata Kubernetes (CRD) che Identity Service per GKE utilizza per configurare la modalità di interazione con i provider di identità.

Apri la pagina Credenziali nella console Google Cloud .

Fai clic su Crea credenziali.

Seleziona ID client OAuth.

Se la schermata per il consenso non è ancora stata configurata per il progetto Google Cloud, fai clic su Configura schermata per il consenso. Segui la documentazione sulla configurazione della schermata di consenso. Per questo tutorial, imposta i seguenti valori:

- Il Tipo di utente può essere Interno o Esterno. Per questo tutorial, puoi selezionare Interno.

- I valori per Nome app, Email per l'assistenza utente e Dati di contatto dello sviluppatore sono obbligatori e possono essere di qualsiasi valore.

- Per questo tutorial non è necessario aggiungere ambiti.

Al termine della configurazione della schermata del consenso, fai clic su Torna alla dashboard e ricomincia dal passaggio 1 della procedura corrente.

Nell'elenco Tipo di applicazione, seleziona Applicazione web.

Nel campo Nome, inserisci un nome per l'ID client. Per questo tutorial, utilizza

Identity Service for GKE.Fai clic su Crea.

Viene visualizzata una finestra di dialogo. Copia il valore di Il tuo ID client, ti servirà più avanti in questa procedura.

Fai clic su Ok per chiudere la finestra di dialogo.

In Cloud Shell, crea una directory sotto la home directory denominata

cloud-build-private-pools-gke-tutorial, quindi vai a questa directory:mkdir -p ~/cloud-build-private-pools-gke-tutorial cd ~/cloud-build-private-pools-gke-tutorial

Nella nuova directory, crea un file YAML denominato

client-config-patch.yamlcon i valori che ti serviranno in seguito per applicare una patch alla risorsa ClientConfig di Identity Service per GKE:cat << EOF > client-config-patch.yaml spec: authentication: - name: google-oidc oidc: clientID: CLIENT_ID cloudConsoleRedirectURI: https://console.cloud.google.com/kubernetes/oidc extraParams: prompt=consent,access_type=offline issuerURI: https://accounts.google.com kubectlRedirectURI: http://localhost:10000/callback scopes: email userClaim: email userPrefix: '-' EOFSostituisci CLIENT_ID con l'ID client OAuth del passaggio precedente.

Tieni presente quanto segue in merito alla patch:

I token ID emessi dal sistema di autenticazione OAuth 2.0 di Google contengono un identificatore numerico univoco nella rivendicazione sub (soggetto). L'utilizzo di questo identificatore opaco nelle associazioni di ruoli rende difficile identificare il soggetto di un'associazione di ruoli. Questa patch configura quindi Identity Service for GKE in modo che utilizzi la rivendicazione email dei token ID per identificare gli utenti anziché la rivendicazione sub predefinita.

L'ambito email viene aggiunto in modo che i token ID emessi includano l'attestazione email.

I campi

cloudConsoleRedirectURI,extraParams,kubectlRedirectURIe ambiti vengono utilizzati quando gli sviluppatori si autenticano al cluster utilizzando Identity Service per GKE. Non vengono utilizzati quando i service account Google si autenticano nel cluster. Il campo kubectlRedirectURI è obbligatorio.Il campo

userPrefixè un prefisso per gli utenti che eseguono l'autenticazione utilizzando il provider di identità configurato. Il valore'-'indica che non è presente alcun prefisso.Il campo

spec.authenticationè un array. Puoi utilizzare più provider di identità OpenID Connect con Identity Service for GKE. Ad esempio, puoi utilizzare Google come identity provider per autenticare gli account di servizio Google e un altro identity provider per autenticare gli sviluppatori.

Per saperne di più sui campi di questa configurazione, vedi Utilizzare provider di identità esterni per l'autenticazione in GKE.

In Cloud Shell, crea un account di servizio Google:

gcloud iam service-accounts create ISG_GSA \ --display-name "Configure Identity Service for GKE"Sostituisci ISG_GSA con il nome che vuoi utilizzare per il account di servizio Google. Per questo tutorial, utilizza

identity-service-for-gke.Assegni questo account di servizio Google a un'istanza VM di Compute Engine per configurare Identity Service per GKE e controllo dell'accesso basato sui ruoli di Kubernetes sul cluster.

Concedi il ruolo Amministratore Kubernetes Engine sul progetto al account di servizio Google:

gcloud projects add-iam-policy-binding PROJECT_ID \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/container.adminQuesto ruolo fornisce le autorizzazioni necessarie per svolgere le seguenti attività in questo tutorial:

- Configura le impostazioni di Identity Service per GKE sui cluster nel progetto.

- Crea associazioni di ruoli e associazioni di ruoli cluster nel cluster.

In Cloud Shell, crea una regola firewall che consenta l'accesso SSH utilizzando l'inoltro TCP di IAP a qualsiasi istanza VM con il tag di rete

ssh-iap:gcloud compute firewall-rules create allow-ssh-ingress-from-iap \ --allow tcp:22 \ --description "Allow SSH tunneling using Identity-Aware Proxy" \ --network NETWORK \ --source-ranges 35.235.240.0/20 \ --target-tags ssh-iapL'intervallo di origine contiene gli indirizzi IP utilizzati da IAP per l'inoltro TCP.

Crea un'istanza VM di Compute Engine nella stessa rete VPC del cluster GKE:

gcloud compute instances create VM \ --metadata enable-oslogin=TRUE \ --network NETWORK \ --no-address \ --scopes cloud-platform,userinfo-email \ --service-account ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --subnet SUBNET \ --tags ssh-iap \ --zone ZONESostituisci VM con il nome che vuoi utilizzare per l'istanza VM. Per questo tutorial, utilizza

identity-service-for-gke-configuration.Tieni presente quanto segue in merito al comando riportato sopra:

Il flag

--service-accountcollega il account di servizio Google all'istanza VM.L'ambito

cloud-platformè necessario per accedere all'API Service Account Credentials.L'ambito

userinfo-emailè utile quando crei un'istanza VM per gestire il controllo dell'accesso basato sui ruoli di Kubernetes. È facoltativo per questo tutorial.Il flag

--no-addressindica che l'istanza VM viene creata senza un indirizzo IP esterno.Il valore facoltativo dei metadati dell'istanza

enable-osloginattiva OS Login nell'istanza VM. OS Login consente la gestione dell'accesso SSH alle istanze VM utilizzando IAM.

Copia il file patch ClientConfig nell'istanza VM:

gcloud compute scp client-config-patch.yaml VM:~ --tunnel-through-iap --zone ZONEIl flag

--tunnel-through-iapindica agclouddi eseguire il tunneling della connessione tramite IAP.Connettiti all'istanza VM utilizzando SSH:

gcloud compute ssh VM --tunnel-through-iap --zone ZONEEsegui il resto dei comandi in questa sezione dalla sessione SSH.

Installa lo strumento a riga di comando

kubectle il file binario gke-gcloud-auth-plugin nell'istanza VM:sudo apt-get install -y kubectl google-cloud-sdk-gke-gcloud-auth-pluginRecupera le credenziali per il cluster GKE:

export USE_GKE_GCLOUD_AUTH_PLUGIN=True gcloud container clusters get-credentials CLUSTER --zone ZONEApplica una patch alla risorsa ClientConfig predefinita:

kubectl patch clientconfig default \ --namespace kube-public \ --patch-file client-config-patch.yaml \ --type mergeEstrai il campo

certificateAuthorityDatadalla risorsa ClientConfig predefinita patchata e archivialo in un file denominatocertificateAuthorityData.pem:kubectl get clientconfig default \ --namespace kube-public \ --output jsonpath='{.spec.certificateAuthorityData}' \ | base64 --decode > certificateAuthorityData.pemEstrai il campo server dalla risorsa ClientConfig predefinita patchata e archivialo in un file denominato

server.txt:kubectl get clientconfig default \ --namespace kube-public \ --output jsonpath='{.spec.server}' > server.txtEsci dalla sessione SSH:

exitIn Cloud Shell, concedi il ruolo Service Account OpenID Connect Identity Token Creator al account di servizio Google al account di servizio stesso:

gcloud iam service-accounts add-iam-policy-binding \ ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorQuesto ruolo fornisce l'autorizzazione

iam.serviceAccounts.getOpenIdTokennecessaria per richiedere token ID per il account di servizio dall'API Service Account Credentials.Connettiti all'istanza VM utilizzando SSH:

gcloud compute ssh VM --tunnel-through-iap --zone ZONEEsegui il resto dei comandi in questa sezione dalla sessione SSH.

Richiedi un token di accesso OAuth 2.0 dal server di metadati per il account di servizio Google collegato all'istanza VM, utilizzando l'ID client OAuth come rivendicazione

aud(pubblico) richiesta:ACCESS_TOKEN=$(curl --silent --header "Metadata-Flavor: Google" \ http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/token \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("access_token"))')Il corpo della risposta del server dei metadati è un documento JSON. Il comando utilizza uno script Python incorporato per estrarre il campo

access_tokendal corpo della risposta.Richiedi un token ID dall'API Service Account Credentials per il account di servizio Google collegato all'istanza VM:

ID_TOKEN=$(curl --silent --request POST \ --data '{"audience": "CLIENT_ID", "includeEmail": true}' \ --header "Authorization: Bearer $ACCESS_TOKEN" \ --header "Content-Type: application/json; charset=utf-8" \ "https://iamcredentials.googleapis.com/v1/projects/-/serviceAccounts/ISG_GSA@PROJECT_ID.iam.gserviceaccount.com:generateIdToken" \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("token"))')Tieni presente quanto segue in merito al comando riportato sopra:

- Il campo

audiencenel JSON del corpo della richiesta specifica l'attestazioneaud(pubblico) richiesta del token ID. - Il token di accesso del passaggio precedente viene utilizzato per l'autenticazione all'API.

- Il campo

Visualizza le rivendicazioni nel token ID:

echo $ID_TOKEN \ | cut -d. -f2 \ | base64 --decode --ignore-garbage 2> /dev/null \ | python3 -m json.toolVerifica che l'attestazione

emailcontenga l'indirizzo email del account di servizio Google.Utilizza il token ID per l'autenticazione al control plane utilizzando Identity Service for GKE:

kubectl get namespaces \ --certificate-authority certificateAuthorityData.pem \ --server $(cat server.txt) \ --token $ID_TOKENL'output è simile al seguente:

Error from server (Forbidden): namespaces is forbidden: User "ISG_GSA@PROJECT_ID.iam.gserviceaccount.com" cannot list resource "namespaces" in API group "" at the cluster scopeQuesto errore è previsto. Sebbene al account di servizio Google siano state concesse autorizzazioni IAM sui cluster GKE nel progetto, le autorizzazioni IAM non vengono applicate quando esegui l'autenticazione utilizzando Identity Service per GKE. Configura invece l'accesso utilizzando controllo dell'accesso basato sui ruoli (RBAC) di Kubernetes.

Crea un binding del ruolo del cluster che conceda il ruolo del cluster

viewall'account di servizio Google quando questo si autentica al cluster utilizzando il provider OpenID Connect di Google:kubectl create clusterrolebinding ISG_GSA-cluster-view \ --clusterrole view \ --user ISG_GSA@PROJECT_ID.iam.gserviceaccount.comSe imposti un valore

userPrefixdiverso da-in ClientConfig nel tuo ambiente, aggiungi il prefisso al valore del flag--userin questo comando.Accedi al cluster GKE utilizzando Identity Service for GKE:

kubectl get namespaces \ --certificate-authority certificateAuthorityData.pem \ --server $(cat server.txt) \ --token $ID_TOKENL'output è simile al seguente:

NAME STATUS AGE anthos-identity-service Active 1h default Active 1h kube-node-lease Active 1h kube-public Active 1h kube-system Active 1hEsci dalla sessione SSH:

exitIn Cloud Shell, copia i file che contengono i dati dell'autorità di certificazione e l'URL del server dall'istanza VM alla directory corrente:

gcloud compute scp VM:~/certificateAuthorityData.pem VM:~/server.txt . \ --tunnel-through-iap --zone ZONECrea un contesto e una configurazione del cluster che utilizzerai in un secondo momento per connetterti al cluster GKE da Cloud Build:

kubectl config set-context private-cluster \ --cluster private-cluster \ --kubeconfig kubeconfigIl flag

--kubeconfigcrea la configurazione del contesto e del cluster in un nuovo file denominato kubeconfig nella directory corrente.Questo comando utilizza il nome del cluster GKE come nome della configurazione del cluster per il contesto. Nel tuo ambiente, puoi utilizzare un nome di configurazione del cluster diverso nel contesto.

Imposta il campo

certificateAuthorityDatanella configurazione del cluster:kubectl config set-cluster private-cluster \ --certificate-authority certificateAuthorityData.pem \ --embed-certs \ --kubeconfig kubeconfigImposta il campo

servernella configurazione del cluster:kubectl config set-cluster private-cluster \ --kubeconfig kubeconfig \ --server $(cat server.txt)In Cloud Shell, crea un account di servizio Google per eseguire le build nel pool Cloud Build privato:

gcloud iam service-accounts create CB_GSA \ --description "Runs builds on Cloud Build private pools" \ --display-name "Cloud Build private pool"Sostituisci CB_GSA con il nome che vuoi utilizzare per il account di servizio Google. Per questo tutorial, utilizza

cloud-build-private-pool.Concedi il ruolo Service Account Cloud Build al account di servizio Google nel progetto:

gcloud projects add-iam-policy-binding PROJECT_ID \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/cloudbuild.builds.builderQuesto ruolo fornisce le autorizzazioni predefinite del service account Cloud Build gestito da Google.

Concedi il ruolo Service Account OpenID Connect Identity Token Creator all'account di servizio Google:

gcloud iam service-accounts add-iam-policy-binding \ CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorQuesto ruolo fornisce l'autorizzazione

iam.serviceAccounts.getOpenIdTokennecessaria per richiedere token ID per il account di servizio dall'API Service Account Credentials.Connettiti all'istanza VM utilizzando SSH:

gcloud compute ssh VM --tunnel-through-iap --zone ZONEEsegui il resto dei comandi in questa sezione dalla sessione SSH.

Nella sessione SSH, crea un'associazione di ruoli del cluster Kubernetes che conceda il ruolo del cluster

cluster-adminal account di servizio Google quando il account di servizio si autentica al cluster utilizzando il provider OpenID Connect di Google:kubectl create clusterrolebinding CB_GSA-cluster-admin \ --clusterrole cluster-admin \ --user CB_GSA@PROJECT_ID.iam.gserviceaccount.comIl ruolo cluster

cluster-adminconcede autorizzazioni estese a livello di cluster. Nel tuo ambiente, puoi utilizzare un ruolo del cluster che fornisca solo le autorizzazioni necessarie per le attività eseguite da Cloud Build. Puoi anche utilizzare i binding dei ruoli per concedere autorizzazioni solo a spazi dei nomi specifici.Se imposti un

userPrefixin ClientConfig nel tuo ambiente, devi aggiungere questo prefisso al valore del flag--userin questo comando.Esci dalla sessione SSH:

exitIn Cloud Shell, alloca un intervallo di indirizzi IP nella tua rete VPC per la connessione al pool privato:

gcloud compute addresses create RESERVED_RANGE_NAME \ --addresses RESERVED_RANGE_START_IP\ --description "Cloud Build private pool reserved range" \ --global \ --network NETWORK \ --prefix-length RESERVED_RANGE_PREFIX_LENGTH \ --purpose VPC_PEERINGSostituisci quanto segue:

- RESERVED_RANGE_NAME: il nome dell'intervallo di indirizzi IP allocato che ospita il pool privato Cloud Build. Per questo tutorial, utilizza

cloud-build-private-pool. - RESERVED_RANGE_START_IP: il primo indirizzo IP dell'intervallo di indirizzi IP allocato. Per questo tutorial, utilizza

192.168.12.0. - RESERVED_RANGE_PREFIX_LENGTH: la lunghezza del prefisso (subnet mask) dell'intervallo di indirizzi IP allocato. La lunghezza del prefisso deve essere

/23o un numero inferiore, ad esempio/22o/21. Un numero più basso indica un intervallo di indirizzi più ampio. Per questo tutorial, utilizza23e non inserire la/(barra) iniziale.

- RESERVED_RANGE_NAME: il nome dell'intervallo di indirizzi IP allocato che ospita il pool privato Cloud Build. Per questo tutorial, utilizza

Crea una regola firewall per consentire il traffico in entrata dall'intervallo di indirizzi IP riservati ad altre risorse nella tua rete VPC:

gcloud compute firewall-rules create allow-private-pools-ingress \ --allow all \ --network NETWORK \ --source-ranges RESERVED_RANGE_START_IP/RESERVED_RANGE_PREFIX_LENGTHCrea una connessione di servizio privata per connettere la tua rete VPC al servizio Service Networking:

gcloud services vpc-peerings connect \ --network NETWORK \ --ranges RESERVED_RANGE_NAME \ --service servicenetworking.googleapis.comI pool privati di Cloud Build eseguono i worker utilizzando Service Networking. La connessione privata ai servizi consente alla tua rete VPC di comunicare con il pool privato nell'intervallo allocato di indirizzi IP interni utilizzando una connessione di peering di rete VPC.

La creazione della connessione privata ai servizi può richiedere alcuni minuti.

Se utilizzi un VPC condiviso nel tuo ambiente, per informazioni sui passaggi aggiuntivi per creare la connessione di servizio privata, consulta Configurare l'ambiente.

Crea un pool privato Cloud Build in una rete VPC di proprietà di Google in peering con la tua rete VPC:

gcloud builds worker-pools create PRIVATE_POOL_NAME \ --no-public-egress \ --peered-network projects/PROJECT_ID/global/networks/NETWORK \ --region REGIONSostituisci quanto segue:

- PRIVATE_POOL_NAME: il nome del pool privato. Per questo tutorial, utilizza

private-pool. - REGION: la regione da utilizzare per il pool privato. Per questo tutorial, utilizza

us-central1.

Il flag

--no-public-egressindica che i worker nel pool privato non hanno indirizzi IP pubblici. Nel tuo ambiente, puoi rimuovere questo flag se vuoi che i worker nel pool privato abbiano connettività a internet utilizzando indirizzi IP pubblici.Per informazioni su altre opzioni di configurazione, come il tipo di macchina e la dimensione del disco per i worker nel pool privato, consulta Creare e gestire pool privati.

- PRIVATE_POOL_NAME: il nome del pool privato. Per questo tutorial, utilizza

In Cloud Shell, crea un bucket Cloud Storage per archiviare i log di build di Cloud Build:

gcloud storage buckets create gs://PROJECT_ID-build-logs --location=REGIONCrea un file di configurazione di compilazione per Cloud Build:

cat << "EOF" > cloudbuild.yaml steps: - id: list-services name: gcr.io/google.com/cloudsdktool/google-cloud-cli entrypoint: bash args: - -eEuo - pipefail - -c - |- kubectl config use-context $_KUBECTL_CONTEXT ACCESS_TOKEN=$$(curl --silent \ --header "Metadata-Flavor: Google" \ http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/token \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("access_token"))') ID_TOKEN=$$(curl --silent --request POST \ --data '{"audience": "CLIENT_ID", "includeEmail": true}' \ --header "Authorization: Bearer $$ACCESS_TOKEN" \ --header "Content-Type: application/json; charset=utf-8" \ "https://iamcredentials.googleapis.com/v1/projects/-/serviceAccounts/$_SERVICE_ACCOUNT:generateIdToken" \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("token"))') kubectl get services --namespace $_NAMESPACE --token $$ID_TOKEN logsBucket: gs://PROJECT_ID-build-logs options: env: - KUBECONFIG=/workspace/$_KUBECONFIG substitutions: _KUBECONFIG: kubeconfig _KUBECTL_CONTEXT: private-cluster _NAMESPACE: default serviceAccount: projects/$PROJECT_ID/serviceAccounts/$_SERVICE_ACCOUNT EOFIl passaggio nel file di configurazione di compilazione esegue le seguenti operazioni:

Passa al contesto

kubectlspecificato dalla sostituzione_KUBECTL_CONTEXT. Il valore di sostituzione predefinito èprivate-cluster.Recupera un token di accesso dal server di metadati. Il token di accesso viene rilasciato all'account di servizio Google che esegue la build.

Genera un token ID utilizzando l'API Service Account Credentials. La richiesta di generazione del token ID viene autenticata utilizzando il token di accesso. L'attestazione

aud(pubblico) richiesta del token ID è l'ID client OAuth 2.0 specificato dalla sostituzione_CLIENT_ID.Elenca i servizi Kubernetes nello spazio dei nomi specificato dalla sostituzione

_NAMESPACE. Il valore di sostituzione predefinito èdefault. La richiesta viene autenticata utilizzando il token ID generato nel comando precedente.

Tieni presente quanto segue in merito al file di configurazione della build:

Il carattere

$è il prefisso per le sostituzioni.$$viene utilizzato per l'espansione dei parametri bash e la sostituzione dei comandi.Le sostituzioni

_KUBECONFIGe_KUBECTL_CONTEXTconsentono di specificare file kubeconfig e contesti diversi quando esegui una build. Queste sostituzioni ti consentono di gestire più configurazioni di cluster utilizzando un singolo file kubeconfig con più contesti o più file kubeconfig.La sostituzione

_SERVICE_ACCOUNTnon ha un valore predefinito. Devi fornire un valore per questa sostituzione quando esegui una build.Il blocco

optionsimposta la variabile di ambienteKUBECONFIGper tutti i passaggi della build.Il passaggio di build utilizza l'immagine del builder

gcr.io/google.com/cloudsdktool/google-cloud-cli. Si tratta di un'immagine container di grandi dimensioni e il pull dal registro al worker del pool privato richiede un po' di tempo. Per ridurre il tempo necessario per estrarre l'immagine del builder, puoi creare un'immagine del builder personalizzata che contenga solo gli strumenti necessari per il passaggio di compilazione, comecurl,kubectle Python.

Per saperne di più sugli script shell incorporati nei file di configurazione della build, consulta Esecuzione di script bash.

Esegui una build utilizzando il file di configurazione della build e i file nella directory corrente:

gcloud builds submit \ --config cloudbuild.yaml \ --region REGION \ --substitutions _SERVICE_ACCOUNT=CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --worker-pool projects/PROJECT_ID/locations/REGION/workerPools/PRIVATE_POOL_NAMEIl comando carica tutti i file presenti nella directory corrente in Cloud Storage per l'utilizzo da parte di Cloud Build. Il passaggio di build utilizza il file kubeconfig per connettersi al cluster GKE.

Verso la fine dell'output, vedrai righe simili alle seguenti:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 2hQuesto output mostra che il worker del pool privato si è connesso al control plane del cluster utilizzando il proxy di autenticazione di Identity Service for GKE.

In Cloud Shell, elimina il pool privato Cloud Build:

gcloud builds worker-pools delete PRIVATE_POOL_NAME --region REGION --quietElimina la connessione privata ai servizi a Service Networking:

gcloud services vpc-peerings delete --network NETWORK \ --service servicenetworking.googleapis.com --quiet --asyncElimina l'intervallo di indirizzi IP allocato ai pool privati di Cloud Build:

gcloud compute addresses delete RESERVED_RANGE_NAME --global --quietElimina il bucket Cloud Storage e tutti i relativi contenuti:

gcloud storage rm gs://PROJECT_ID-build-logs --recursiveElimina il cluster GKE:

gcloud container clusters delete CLUSTER --zone ZONE --quiet --asyncElimina l'istanza VM di Compute Engine:

gcloud compute instances delete VM --zone ZONE --quietElimina le regole firewall:

gcloud compute firewall-rules delete allow-private-pools-ingress --quiet gcloud compute firewall-rules delete allow-ssh-ingress-from-iap --quiet gcloud compute firewall-rules delete allow-control-plane-clientconfig-webhook --quietRimuovi le associazioni di ruoli IAM:

gcloud projects remove-iam-policy-binding PROJECT_ID \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/cloudbuild.builds.builder gcloud projects remove-iam-policy-binding PROJECT_ID \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/container.admin gcloud iam service-accounts remove-iam-policy-binding \ CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreator gcloud iam service-accounts remove-iam-policy-binding \ ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorElimina i service account Google:

gcloud iam service-accounts delete CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --quiet gcloud iam service-accounts delete ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --quietVai alla pagina Credenziali nella console Google Cloud :

Seleziona il progetto dall'elenco del selettore di progetti.

Nella tabella degli ID client OAuth 2.0, individua la riga relativa a Identity Service per GKE e poi fai clic sull'icona Elimina client OAuth.

Nella finestra di dialogo, fai clic su Elimina.

- Scopri come accedere ai cluster Anthos da Cloud Build con il gateway di connessione.

- Scopri come accedere ai cluster GKE privati con i pool privati di Cloud Build utilizzando Cloud VPN.

- Scopri come creare cluster GKE privati con proxy di rete per l'accesso al control plane.

- Scopri come accedere a risorse esterne in una rete privata utilizzando un IP esterno statico.

- Scopri GKE Identity Service. GKE Identity Service ti consente di gestire l'autenticazione del provider di identità esterno in un parco di cluster Anthos.

Crea un cluster GKE privato

Registra Identity Service for GKE come applicazione client OAuth 2.0

In questa sezione, registri Identity Service per GKE come applicazione client utilizzando il sistema di autenticazione OAuth 2.0 di Google.

Crea un account di servizio Google per configurare Identity Service for GKE

Configura Identity Service for GKE

Per configurare Identity Service per GKE, devi avere accesso al control plane del cluster. In questo tutorial, crei un'istanza VM di Compute Engine per accedere al control plane.

Devi disporre dell'accesso SSH all'istanza VM. Per abilitare l'accesso SSH autenticato e autorizzato dall'esterno della rete VPC all'istanza VM, utilizza l'inoltro TCP con Identity-Aware Proxy (IAP). Questa funzionalità consente l'accesso SSH senza richiedere che l'istanza VM abbia un indirizzo IP pubblico.

(Facoltativo) Verifica la configurazione del cluster

Prima di procedere, puoi verificare che Identity Service for GKE sia stato configurato correttamente sul cluster. Verifichi la configurazione utilizzando ilaccount di serviziot Google collegato all'istanza VM per l'autenticazione al cluster utilizzando Identity Service for GKE.

Crea un contesto per lo strumento kubectl

Il comando kubectl può utilizzare un file kubeconfig per configurare l'accesso ai cluster. Un file kubeconfig contiene uno o più contesti. Ogni contesto ha un nome e, facoltativamente, include informazioni sulla connettività del cluster, credenziali utilizzate per l'autenticazione al cluster e uno spazio dei nomi predefinito.

In questa sezione, creerai un file kubeconfig con un contesto. Il contesto include i dettagli di connettività del proxy del servizio di identità per GKE per il tuo cluster. Non aggiungi credenziali utente al file kubeconfig.

Crea un account di servizio Google per Cloud Build

Crea un pool privato Cloud Build

Verificare la soluzione

In questa sezione, verifichi la soluzione eseguendo una build nel pool privato Cloud Build. La build accede al cluster GKE privato.

Risoluzione dei problemi

Se non riesci a connetterti all'istanza VM utilizzando SSH, aggiungi il flag --troubleshoot per scoprire la causa dei problemi di connettività:

gcloud compute ssh VM --tunnel-through-iap --zone ZONE --troubleshoot

Se visualizzi il messaggio Error from server (NotFound): clientconfigs.authentication.gke.io "default" not found quando applichi la patch a ClientConfig predefinito sul cluster GKE, assicurati di aver creato la regola firewall come descritto nella sezione Creazione di un cluster GKE privato. Verifica che esista la regola firewall:

gcloud compute firewall-rules describe allow-control-plane-clientconfig-webhook

Se non riesci ad autenticarti nel proxy di Identity Service for GKE, cerca errori nei log dei pod nel deployment gke-oidc-service:

gcloud compute ssh VM --tunnel-through-iap --zone ZONE --command \

'kubectl logs deployment/gke-oidc-service \

--namespace anthos-identity-service --all-containers'

Se riscontri altri problemi con questo tutorial, ti consigliamo di consultare questi documenti:

Esegui la pulizia

Per evitare che al tuo Account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo tutorial, elimina il progetto che contiene le risorse oppure mantieni il progetto ed elimina le singole risorse.

Elimina il progetto

Delete a Google Cloud project:

gcloud projects delete PROJECT_ID

Elimina le risorse

Se vuoi conservare il progetto che hai utilizzato in questo tutorial, elimina le singole risorse: