Ce tutoriel explique comment accéder au plan de contrôle d'un cluster Google Kubernetes Engine (GKE) privé à l'aide de pools privés Cloud Build. Cet accès vous permet d'utiliser Cloud Build pour déployer des applications et gérer des ressources sur un cluster GKE privé. Ce tutoriel s'adresse aux administrateurs de plate-forme, aux administrateurs de cluster et aux développeurs. Nous partons du principe que vous connaissez bien GKE, Cloud Build, OpenID Connect et l'outil de ligne de commande gcloud.

Les pools privés Cloud Build et les plans de contrôle de cluster GKE s'exécutent tous deux dans des réseaux de cloud privé virtuel (VPC) appartenant à Google. Ces réseaux VPC sont appairés à votre propre réseau VPC sur Google Cloud. Toutefois, l'appairage de réseaux VPC n'est pas compatible avec l'appairage transitif, ce qui peut être une restriction lorsque vous utilisez des pools privés Cloud Build. Ce tutoriel présente une solution qui utilise Identity Service pour GKE afin de permettre aux nœuds de calcul d'un pool privé Cloud Build d'accéder au plan de contrôle d'un cluster GKE privé.

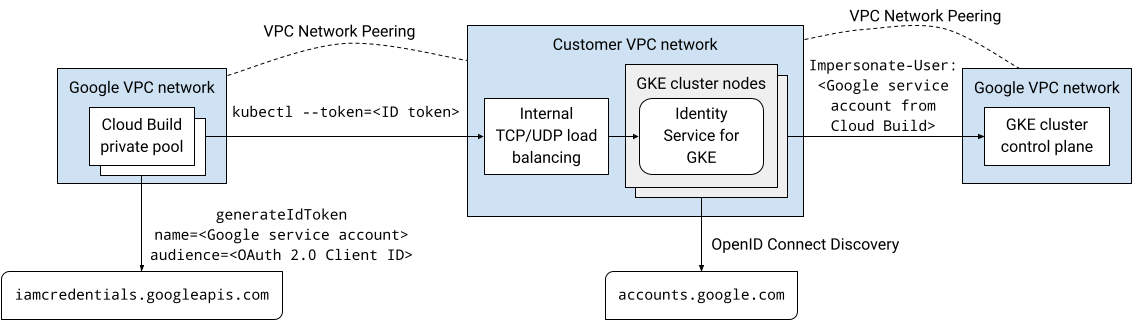

Présentation de l'architecture

Identity Service pour GKE est un proxy d'authentification pour les plans de contrôle des clusters GKE. Il sert de proxy pour les requêtes envoyées au serveur d'API et valide les jetons d'identification émis par les fournisseurs d'identité OpenID Connect (OIDC). Une fois qu'il a validé un jeton d'identité, le proxy ajoute des en-têtes HTTP d'usurpation d'identité de l'utilisateur à la requête d'origine et la transmet au serveur d'API. Le proxy s'exécute en tant que compte de service Kubernetes disposant des autorisations nécessaires pour emprunter l'identité des utilisateurs et des groupes.

Le proxy Identity Service pour GKE s'exécute en tant que pods sur les nœuds du cluster. Un service Kubernetes de type LoadBalancer expose le proxy en dehors du cluster. Si Identity Service pour GKE est activé sur un cluster privé, le programme d'installation ajoute une annotation au service Kubernetes pour provisionner un équilibreur de charge réseau passthrough interne. Le proxy est accessible via l'équilibreur de charge sur une connexion d'appairage de réseaux VPC, par exemple à partir d'un pool privé Cloud Build, car il s'exécute sur les nœuds du cluster dans votre réseau VPC.

Vous pouvez configurer Google comme fournisseur d'identité OpenID Connect dans Identity Service pour GKE, car le système d'authentification OAuth 2.0 de Google est conforme à la spécification OpenID Connect. Pour obtenir des jetons d'identification pour un compte de service Google, vous pouvez utiliser la méthode generateIdToken de l'API Service Account Credentials. Les jetons d'identité sont émis et signés par Google.

En combinant tous ces éléments, cette solution permet d'accéder au plan de contrôle du cluster GKE privé à l'aide du proxy Identity Service for GKE. Les compilations qui s'exécutent sur un pool privé Cloud Build se connectent au proxy via une connexion d'appairage de réseaux VPC. La compilation qui s'exécute sur le pool privé Cloud Build s'exécute en tant que compte de service Google. Ce compte de service Google peut obtenir un jeton d'identité pour s'authentifier auprès du proxy à partir de l'API Service Account Credentials.

Le schéma suivant illustre l'architecture décrite dans le texte précédent :

Toutes les communications de cette solution s'effectuent sur l'espace d'adresses IP internes. Les nœuds de calcul du pool privé n'ont pas besoin d'être connectés à l'Internet public.

Les autorisations Identity and Access Management (IAM) accordées aux comptes utilisateur et aux comptes de service Google ne s'appliquent pas lorsqu'ils s'authentifient à l'aide d'Identity Service pour GKE. Vous devez plutôt utiliser le contrôle des accès basé sur les rôles (RBAC) Kubernetes pour gérer les autorisations de cluster pour ces comptes.

Avant de commencer

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

Install the Google Cloud CLI.

-

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

-

Pour initialiser la gcloud CLI, exécutez la commande suivante :

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, GKE, Identity-Aware Proxy (IAP), and Service Networking APIs APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

container.googleapis.com iap.googleapis.com servicenetworking.googleapis.com -

Install the Google Cloud CLI.

-

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

-

Pour initialiser la gcloud CLI, exécutez la commande suivante :

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, GKE, Identity-Aware Proxy (IAP), and Service Networking APIs APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

container.googleapis.com iap.googleapis.com servicenetworking.googleapis.com Dans Cloud Shell, créez un cluster GKE sans accès client au point de terminaison public du plan de contrôle et sur lequel Identity Service pour GKE est installé :

gcloud container clusters create CLUSTER \ --enable-identity-service \ --enable-ip-alias \ --enable-master-authorized-networks \ --enable-private-endpoint \ --enable-private-nodes \ --master-ipv4-cidr CONTROL_PLANE_CIDR \ --network NETWORK\ --release-channel regular \ --scopes cloud-platform \ --subnetwork SUBNET \ --tags NODE_TAGS \ --workload-pool PROJECT_ID.svc.id.goog \ --zone ZONERemplacez les éléments suivants :

- CLUSTER : nom du cluster. Pour ce tutoriel, utilisez

private-cluster. - CONTROL_PLANE_CIDR : plage d'adresses IP du plan de contrôle. Il doit comporter un préfixe

/28. Pour ce tutoriel, vous pouvez utiliser172.16.0.32/28. - NETWORK : réseau VPC auquel le plan de contrôle se connecte. Pour ce tutoriel, utilisez

default. - SUBNET : sous-réseau auquel se connecte le plan de contrôle du cluster GKE. Le sous-réseau doit appartenir au réseau VPC spécifié par NETWORK. Pour ce tutoriel, utilisez

default. - NODE_TAGS : liste de tags réseau à appliquer aux nœuds, séparés par une virgule. Pour ce tutoriel, utilisez

private-cluster-node. - PROJECT_ID : ID de votre projet Google Cloud .

- ZONE : zone du cluster GKE. Pour ce tutoriel, utilisez

us-central1-f.

Tenez compte des remarques suivantes pour cette commande :

L'indicateur

--enable-identity-serviceactive Identity Service pour GKE sur le cluster. Dans votre propre environnement, vous pouvez activer Identity Service pour GKE sur un cluster existant.L'indicateur

--enable-private-endpointconfigure le plan de contrôle pour qu'il ne soit accessible qu'à l'aide d'adresses IP internes.L'indicateur

--enable-private-nodesconfigure les nœuds du cluster pour qu'ils ne disposent que d'adresses IP internes.Les indicateurs

--enable-master-authorized-networkset--enable-private-nodespermettent d'accéder au serveur d'API uniquement à partir des réseaux privés spécifiés par l'indicateur--network.L'indicateur facultatif

--workload-poolactive la fédération d'identité de charge de travail pour GKE. Elle n'est pas obligatoire pour ce tutoriel.

- CLUSTER : nom du cluster. Pour ce tutoriel, utilisez

Ajoutez une règle de pare-feu qui autorise le plan de contrôle du cluster GKE à se connecter au webhook d'admission de validation pour les ressources ClientConfig :

gcloud compute firewall-rules create allow-control-plane-clientconfig-webhook \ --allow tcp:15000 \ --network NETWORK\ --source-ranges CONTROL_PLANE_CIDR\ --target-tags NODE_TAGSClientConfig est un type de ressource personnalisée (CRD) Kubernetes qu'Identity Service pour GKE utilise pour configurer la manière d'interagir avec les fournisseurs d'identité.

Ouvrez la page Identifiants dans la console Google Cloud .

Ouvrez la page Identifiants.

Cliquez sur Créer des identifiants.

Sélectionnez ID client OAuth.

Si l'écran d'autorisation n'a pas encore été configuré pour le projet Google Cloud, cliquez sur Configurer l'écran d'autorisation. Suivez la documentation sur la configuration de l'écran d'autorisation. Pour ce tutoriel, définissez les valeurs suivantes :

- Le type d'utilisateur peut être interne ou externe. Pour ce tutoriel, vous pouvez sélectionner "Interne".

- Les valeurs Nom de l'application, Adresse e-mail d'assistance utilisateur et Coordonnées du développeur sont obligatoires et peuvent être de n'importe quelle valeur.

- Vous n'avez pas besoin d'ajouter de champs d'application pour ce tutoriel.

Lorsque vous avez terminé de configurer l'écran de consentement, cliquez sur "Retour au tableau de bord", puis recommencez à partir de l'étape 1 de la procédure actuelle.

Dans la liste Type d'application, sélectionnez Application Web.

Dans le champ Nom, saisissez un nom pour l'ID client. Pour ce tutoriel, utilisez

Identity Service for GKE.Cliquez sur Créer.

Une boîte de dialogue s'affiche. Copiez la valeur de Your Client ID (Votre ID client). Vous en aurez besoin plus tard dans cette procédure.

Cliquez sur OK pour fermer la boîte de dialogue.

Dans Cloud Shell, créez un répertoire sous votre répertoire d'accueil appelé

cloud-build-private-pools-gke-tutorial, puis accédez-y :mkdir -p ~/cloud-build-private-pools-gke-tutorial cd ~/cloud-build-private-pools-gke-tutorial

Dans le nouveau répertoire, créez un fichier YAML nommé

client-config-patch.yamlcontenant les valeurs dont vous aurez besoin ultérieurement pour corriger la ressource ClientConfig du service d'identité pour GKE :cat << EOF > client-config-patch.yaml spec: authentication: - name: google-oidc oidc: clientID: CLIENT_ID cloudConsoleRedirectURI: https://console.cloud.google.com/kubernetes/oidc extraParams: prompt=consent,access_type=offline issuerURI: https://accounts.google.com kubectlRedirectURI: http://localhost:10000/callback scopes: email userClaim: email userPrefix: '-' EOFRemplacez CLIENT_ID par l'ID client OAuth de l'étape précédente.

Tenez compte des remarques suivantes concernant le correctif :

Les jetons d'identité émis par le système d'authentification OAuth 2.0 de Google contiennent un identifiant numérique unique dans la revendication sub (sujet). L'utilisation de cet identifiant opaque dans les liaisons de rôle rend difficile l'identification du sujet d'une liaison de rôle. Ce correctif configure donc Identity Service for GKE pour qu'il utilise la revendication d'adresse e-mail des jetons d'identité pour identifier les utilisateurs au lieu d'utiliser la revendication sub par défaut.

Le champ d'application de l'adresse e-mail est ajouté afin que les jetons d'identité émis incluent la revendication d'adresse e-mail.

Les champs

cloudConsoleRedirectURI,extraParams,kubectlRedirectURIet "scopes" sont utilisés lorsque les développeurs s'authentifient auprès du cluster à l'aide d'Identity Service pour GKE. Elles ne sont pas utilisées lorsque les comptes de service Google s'authentifient auprès du cluster. Le champ "kubectlRedirectURI" est obligatoire.Le champ

userPrefixest un préfixe pour les utilisateurs qui s'authentifient à l'aide du fournisseur d'identité configuré. La valeur'-'signifie qu'il n'y a pas de préfixe.Le champ

spec.authenticationest un tableau. Vous pouvez utiliser plusieurs fournisseurs d'identité OpenID Connect avec Identity Service pour GKE. Par exemple, vous pouvez utiliser Google comme fournisseur d'identité pour authentifier les comptes de service Google et un autre fournisseur d'identité pour authentifier les développeurs.

Pour en savoir plus sur les champs de cette configuration, consultez Utiliser des fournisseurs d'identité externes pour s'authentifier auprès de GKE.

Dans Cloud Shell, créez un compte de service Google Cloud :

gcloud iam service-accounts create ISG_GSA \ --display-name "Configure Identity Service for GKE"Remplacez ISG_GSA par le nom que vous souhaitez utiliser pour le compte de service Google. Pour ce tutoriel, utilisez

identity-service-for-gke.Vous attribuez ce compte de service Google à une instance de VM Compute Engine afin de configurer Identity Service pour GKE et le contrôle des accès basé sur les rôles Kubernetes sur le cluster.

Attribuez le rôle Administrateur Kubernetes Engine sur le projet au compte de service Google :

gcloud projects add-iam-policy-binding PROJECT_ID \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/container.adminCe rôle fournit les autorisations requises pour effectuer les tâches suivantes dans ce tutoriel :

- Configurez les paramètres Identity Service pour GKE sur les clusters du projet.

- Créez des liaisons de rôle et des liaisons de rôle de cluster dans le cluster.

Dans Cloud Shell, créez une règle de pare-feu qui autorise l'accès SSH à l'aide du transfert TCP IAP vers toutes les instances de VM dotées du tag réseau

ssh-iap:gcloud compute firewall-rules create allow-ssh-ingress-from-iap \ --allow tcp:22 \ --description "Allow SSH tunneling using Identity-Aware Proxy" \ --network NETWORK \ --source-ranges 35.235.240.0/20 \ --target-tags ssh-iapLa plage source contient les adresses IP qu'IAP utilise pour le transfert TCP.

Créez une instance de VM Compute Engine dans le même réseau VPC que le cluster GKE :

gcloud compute instances create VM \ --metadata enable-oslogin=TRUE \ --network NETWORK \ --no-address \ --scopes cloud-platform,userinfo-email \ --service-account ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --subnet SUBNET \ --tags ssh-iap \ --zone ZONERemplacez VM par le nom que vous souhaitez utiliser pour l'instance de VM. Pour ce tutoriel, utilisez

identity-service-for-gke-configuration.Tenez compte des remarques suivantes pour la commande ci-dessus :

L'indicateur

--service-accountassocie le compte de service Google à l'instance de VM.Le champ d'application

cloud-platformest requis pour accéder à l'API Service Account Credentials.Le champ d'application

userinfo-emailest utile lorsque vous créez une instance de VM pour gérer le contrôle des accès basé sur les rôles Kubernetes. Elle est facultative pour ce tutoriel.L'indicateur

--no-addresssignifie que l'instance de VM est créée sans adresse IP externe.La valeur facultative des métadonnées d'instance

enable-osloginpermet d'activer OS Login sur l'instance de VM. OS Login permet de gérer l'accès SSH aux instances de VM à l'aide d'IAM.

Copiez le fichier correctif ClientConfig sur l'instance de VM :

gcloud compute scp client-config-patch.yaml VM:~ --tunnel-through-iap --zone ZONEL'option

--tunnel-through-iapdemande àgcloudde faire transiter la connexion par IAP.Connectez-vous à l'instance de VM via SSH :

gcloud compute ssh VM --tunnel-through-iap --zone ZONEExécutez les autres commandes de cette section depuis la session SSH.

Installez l'outil de ligne de commande

kubectlet le binaire gke-gcloud-auth-plugin dans l'instance de VM :sudo apt-get install -y kubectl google-cloud-sdk-gke-gcloud-auth-pluginRécupérez les identifiants du cluster GKE :

export USE_GKE_GCLOUD_AUTH_PLUGIN=True gcloud container clusters get-credentials CLUSTER --zone ZONEAppliquez un correctif à la ressource ClientConfig par défaut :

kubectl patch clientconfig default \ --namespace kube-public \ --patch-file client-config-patch.yaml \ --type mergeExtrayez le champ

certificateAuthorityDatade la ressource ClientConfig par défaut corrigée et stockez-le dans un fichier nommécertificateAuthorityData.pem:kubectl get clientconfig default \ --namespace kube-public \ --output jsonpath='{.spec.certificateAuthorityData}' \ | base64 --decode > certificateAuthorityData.pemExtrayez le champ "server" de la ressource ClientConfig par défaut corrigée et stockez-le dans un fichier appelé

server.txt:kubectl get clientconfig default \ --namespace kube-public \ --output jsonpath='{.spec.server}' > server.txtQuittez la session SSH :

exitDans Cloud Shell, attribuez le rôle Créateur de jetons d'identité OpenID Connect du compte de service au compte de service Google :

gcloud iam service-accounts add-iam-policy-binding \ ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorCe rôle fournit l'autorisation

iam.serviceAccounts.getOpenIdTokenrequise pour demander des jetons d'identification pour le compte de service à partir de l'API Service Account Credentials.Connectez-vous à l'instance de VM via SSH :

gcloud compute ssh VM --tunnel-through-iap --zone ZONEExécutez les autres commandes de cette section depuis la session SSH.

Demandez un jeton d'accès OAuth 2.0 au serveur de métadonnées pour le compte de service Google associé à l'instance de VM, en utilisant l'ID client OAuth comme revendication

aud(audience) demandée :ACCESS_TOKEN=$(curl --silent --header "Metadata-Flavor: Google" \ http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/token \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("access_token"))')Le corps de la réponse du serveur de métadonnées est un document JSON. La commande utilise un script Python intégré pour extraire le champ

access_tokendu corps de la réponse.Demandez un jeton d'identification à l'API Service Account Credentials pour le compte de service Google associé à l'instance de VM :

ID_TOKEN=$(curl --silent --request POST \ --data '{"audience": "CLIENT_ID", "includeEmail": true}' \ --header "Authorization: Bearer $ACCESS_TOKEN" \ --header "Content-Type: application/json; charset=utf-8" \ "https://iamcredentials.googleapis.com/v1/projects/-/serviceAccounts/ISG_GSA@PROJECT_ID.iam.gserviceaccount.com:generateIdToken" \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("token"))')Tenez compte des remarques suivantes pour la commande ci-dessus :

- Le champ

audiencedu corps JSON de la requête spécifie la revendicationaud(audience) demandée du jeton d'identité. - Le jeton d'accès de l'étape précédente est utilisé pour l'authentification auprès de l'API.

- Le champ

Affichez les revendications dans le jeton d'ID :

echo $ID_TOKEN \ | cut -d. -f2 \ | base64 --decode --ignore-garbage 2> /dev/null \ | python3 -m json.toolVérifiez que la revendication

emailcontient l'adresse e-mail du compte de service Google.Utilisez le jeton d'identité pour vous authentifier auprès du plan de contrôle à l'aide d'Identity Service pour GKE :

kubectl get namespaces \ --certificate-authority certificateAuthorityData.pem \ --server $(cat server.txt) \ --token $ID_TOKENLe résultat se présente comme suit :

Error from server (Forbidden): namespaces is forbidden: User "ISG_GSA@PROJECT_ID.iam.gserviceaccount.com" cannot list resource "namespaces" in API group "" at the cluster scopeCette erreur est fréquente. Bien que le compte de service Google ait reçu des autorisations IAM sur les clusters GKE du projet, ces autorisations ne s'appliquent pas lorsque vous vous authentifiez à l'aide d'Identity Service pour GKE. À la place, vous configurez l'accès à l'aide du contrôle des accès basé sur les rôles (RBAC) de Kubernetes.

Créez une liaison de rôle de cluster qui attribue le rôle de cluster

viewau compte de service Google lorsque le compte de service s'authentifie auprès du cluster à l'aide du fournisseur OpenID Connect de Google :kubectl create clusterrolebinding ISG_GSA-cluster-view \ --clusterrole view \ --user ISG_GSA@PROJECT_ID.iam.gserviceaccount.comSi vous définissez une valeur

userPrefixautre que-dans ClientConfig dans votre propre environnement, ajoutez le préfixe à la valeur de l'indicateur--userdans cette commande.Accédez au cluster GKE à l'aide d'Identity Service pour GKE :

kubectl get namespaces \ --certificate-authority certificateAuthorityData.pem \ --server $(cat server.txt) \ --token $ID_TOKENLe résultat se présente comme suit :

NAME STATUS AGE anthos-identity-service Active 1h default Active 1h kube-node-lease Active 1h kube-public Active 1h kube-system Active 1hQuittez la session SSH :

exitDans Cloud Shell, copiez les fichiers contenant les données de l'autorité de certification et l'URL du serveur de l'instance de VM vers le répertoire actuel :

gcloud compute scp VM:~/certificateAuthorityData.pem VM:~/server.txt . \ --tunnel-through-iap --zone ZONECréez un contexte et une configuration de cluster que vous utiliserez ultérieurement pour vous connecter au cluster GKE depuis Cloud Build :

kubectl config set-context private-cluster \ --cluster private-cluster \ --kubeconfig kubeconfigL'indicateur

--kubeconfigcrée la configuration du contexte et du cluster dans un nouveau fichier kubeconfig du répertoire actuel.Cette commande utilise le nom du cluster GKE comme nom de configuration du cluster pour le contexte. Dans votre propre environnement, vous pouvez utiliser un autre nom de configuration de cluster dans le contexte.

Définissez le champ

certificateAuthorityDatadans la configuration du cluster :kubectl config set-cluster private-cluster \ --certificate-authority certificateAuthorityData.pem \ --embed-certs \ --kubeconfig kubeconfigDéfinissez le champ

serverdans la configuration du cluster :kubectl config set-cluster private-cluster \ --kubeconfig kubeconfig \ --server $(cat server.txt)Dans Cloud Shell, créez un compte de service Google pour exécuter des compilations sur le pool privé Cloud Build :

gcloud iam service-accounts create CB_GSA \ --description "Runs builds on Cloud Build private pools" \ --display-name "Cloud Build private pool"Remplacez CB_GSA par le nom que vous souhaitez utiliser pour le compte de service Google. Pour ce tutoriel, utilisez

cloud-build-private-pool.Attribuez le rôle de compte de service Cloud Build au compte de service Google dans le projet :

gcloud projects add-iam-policy-binding PROJECT_ID \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/cloudbuild.builds.builderCe rôle fournit les autorisations par défaut du compte de service Cloud Build géré par Google.

Attribuez le rôle Créateur de jetons d'identité OpenID Connect du compte de service au compte de service Google lui-même :

gcloud iam service-accounts add-iam-policy-binding \ CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorCe rôle fournit l'autorisation

iam.serviceAccounts.getOpenIdTokenrequise pour demander des jetons d'identification pour le compte de service à partir de l'API Service Account Credentials.Connectez-vous à l'instance de VM via SSH :

gcloud compute ssh VM --tunnel-through-iap --zone ZONEExécutez les autres commandes de cette section depuis la session SSH.

Dans la session SSH, créez une liaison de rôle de cluster Kubernetes qui accorde le rôle de cluster

cluster-adminau compte de service Google lorsque le compte de service s'authentifie auprès du cluster à l'aide du fournisseur OpenID Connect de Google :kubectl create clusterrolebinding CB_GSA-cluster-admin \ --clusterrole cluster-admin \ --user CB_GSA@PROJECT_ID.iam.gserviceaccount.comLe rôle de cluster

cluster-adminaccorde de nombreuses autorisations à l'échelle du cluster. Dans votre propre environnement, vous pouvez utiliser un rôle de cluster qui ne fournit que les autorisations nécessaires aux tâches effectuées par Cloud Build. Vous pouvez également utiliser des liaisons de rôle pour n'accorder des autorisations qu'à des espaces de noms spécifiques.Si vous définissez un

userPrefixdans ClientConfig dans votre propre environnement, vous devez ajouter ce préfixe à la valeur de l'option--userdans cette commande.Quittez la session SSH :

exitDans Cloud Shell, allouez une plage d'adresses IP dans votre réseau VPC pour la connexion au pool privé :

gcloud compute addresses create RESERVED_RANGE_NAME \ --addresses RESERVED_RANGE_START_IP\ --description "Cloud Build private pool reserved range" \ --global \ --network NETWORK \ --prefix-length RESERVED_RANGE_PREFIX_LENGTH \ --purpose VPC_PEERINGRemplacez les éléments suivants :

- RESERVED_RANGE_NAME : nom de la plage d'adresses IP allouée qui héberge le pool privé Cloud Build. Pour ce tutoriel, utilisez

cloud-build-private-pool. - RESERVED_RANGE_START_IP : première adresse IP de la plage d'adresses IP allouée. Pour ce tutoriel, utilisez

192.168.12.0. - RESERVED_RANGE_PREFIX_LENGTH : longueur de préfixe (masque de sous-réseau) de la plage d'adresses IP allouée. La longueur du préfixe doit être inférieure ou égale à

/23, par exemple/22ou/21. Plus le nombre est faible, plus la plage d'adresses est étendue. Pour ce tutoriel, utilisez23et n'incluez pas la barre oblique (/) au début.

- RESERVED_RANGE_NAME : nom de la plage d'adresses IP allouée qui héberge le pool privé Cloud Build. Pour ce tutoriel, utilisez

Créez une règle de pare-feu pour autoriser le trafic entrant depuis la plage d'adresses IP réservée vers d'autres ressources de votre réseau VPC :

gcloud compute firewall-rules create allow-private-pools-ingress \ --allow all \ --network NETWORK \ --source-ranges RESERVED_RANGE_START_IP/RESERVED_RANGE_PREFIX_LENGTHCréez une connexion de service privée pour connecter votre réseau VPC au service Service Networking :

gcloud services vpc-peerings connect \ --network NETWORK \ --ranges RESERVED_RANGE_NAME \ --service servicenetworking.googleapis.comLes pools privés Cloud Build exécutent des nœuds de calcul à l'aide de Service Networking. La connexion de service privé permet à votre réseau VPC de communiquer avec le pool privé sur la plage d'adresses IP internes allouée, à l'aide d'une connexion d'appairage de réseaux VPC.

La création de la connexion de service privée peut prendre quelques minutes.

Si vous utilisez un VPC partagé dans votre propre environnement, consultez Configurer votre environnement pour en savoir plus sur les étapes supplémentaires à suivre pour créer la connexion de service privée.

Créez un pool privé Cloud Build dans un réseau VPC appartenant à Google et appairé à votre réseau VPC :

gcloud builds worker-pools create PRIVATE_POOL_NAME \ --no-public-egress \ --peered-network projects/PROJECT_ID/global/networks/NETWORK \ --region REGIONRemplacez les éléments suivants :

- PRIVATE_POOL_NAME : nom du pool privé. Pour ce tutoriel, utilisez

private-pool. - REGION : région à utiliser pour le pool privé. Pour ce tutoriel, utilisez

us-central1.

L'indicateur

--no-public-egresssignifie que les nœuds de calcul du pool privé ne disposent pas d'adresses IP publiques. Dans votre propre environnement, vous pouvez supprimer cet indicateur si vous souhaitez que les nœuds de calcul du pool privé disposent d'une connectivité Internet à l'aide d'adresses IP publiques.Pour en savoir plus sur les options de configuration supplémentaires, telles que le type de machine et la taille du disque pour les nœuds de calcul du pool privé, consultez Créer et gérer des pools privés.

- PRIVATE_POOL_NAME : nom du pool privé. Pour ce tutoriel, utilisez

Dans Cloud Shell, créez un bucket Cloud Storage pour stocker les journaux de compilation de Cloud Build :

gcloud storage buckets create gs://PROJECT_ID-build-logs --location=REGIONCréez un fichier de configuration de compilation pour Cloud Build :

cat << "EOF" > cloudbuild.yaml steps: - id: list-services name: gcr.io/google.com/cloudsdktool/google-cloud-cli entrypoint: bash args: - -eEuo - pipefail - -c - |- kubectl config use-context $_KUBECTL_CONTEXT ACCESS_TOKEN=$$(curl --silent \ --header "Metadata-Flavor: Google" \ http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/token \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("access_token"))') ID_TOKEN=$$(curl --silent --request POST \ --data '{"audience": "CLIENT_ID", "includeEmail": true}' \ --header "Authorization: Bearer $$ACCESS_TOKEN" \ --header "Content-Type: application/json; charset=utf-8" \ "https://iamcredentials.googleapis.com/v1/projects/-/serviceAccounts/$_SERVICE_ACCOUNT:generateIdToken" \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("token"))') kubectl get services --namespace $_NAMESPACE --token $$ID_TOKEN logsBucket: gs://PROJECT_ID-build-logs options: env: - KUBECONFIG=/workspace/$_KUBECONFIG substitutions: _KUBECONFIG: kubeconfig _KUBECTL_CONTEXT: private-cluster _NAMESPACE: default serviceAccount: projects/$PROJECT_ID/serviceAccounts/$_SERVICE_ACCOUNT EOFL'étape du fichier de configuration de compilation effectue les opérations suivantes :

Bascule vers le contexte

kubectlspécifié par la substitution_KUBECTL_CONTEXT. La valeur de substitution par défaut estprivate-cluster.Récupère un jeton d'accès à partir du serveur de métadonnées. Le jeton d'accès est émis pour le compte de service Google qui exécute la compilation.

Génère un jeton d'identification à l'aide de l'API Service Account Credentials. La requête de génération du jeton d'ID est authentifiée à l'aide du jeton d'accès. La revendication

aud(audience) demandée du jeton d'identité est l'ID client OAuth 2.0 spécifié par la substitution_CLIENT_ID.Liste les services Kubernetes dans l'espace de noms spécifié par la substitution

_NAMESPACE. La valeur de substitution par défaut estdefault. La requête est authentifiée à l'aide du jeton d'identité généré dans la commande précédente.

Notez les points suivants concernant le fichier de configuration de compilation :

Le caractère

$est le préfixe des substitutions.$$est utilisé pour l'extension de paramètre bash et la substitution de commande.Les substitutions

_KUBECONFIGet_KUBECTL_CONTEXTpermettent de spécifier différents fichiers kubeconfig et différents contextes lorsque vous exécutez une compilation. Ces substitutions vous permettent de gérer plusieurs configurations de cluster à l'aide d'un seul fichier kubeconfig avec plusieurs contextes ou à l'aide de plusieurs fichiers kubeconfig.La substitution

_SERVICE_ACCOUNTn'a pas de valeur par défaut. Vous devez fournir une valeur pour cette substitution lorsque vous exécutez une compilation.Le bloc

optionsdéfinit la variable d'environnementKUBECONFIGpour toutes les étapes de la compilation.L'étape de compilation utilise l'image de compilation

gcr.io/google.com/cloudsdktool/google-cloud-cli. Il s'agit d'une grande image de conteneur. Il faut donc un certain temps pour l'extraire du registre vers le nœud de calcul du pool privé. Pour réduire le temps nécessaire à l'extraction de l'image de compilateur, vous pouvez créer une image de compilateur personnalisée qui ne contient que les outils requis pour l'étape de compilation, tels quecurl,kubectlet Python.

Pour en savoir plus sur les scripts shell intégrés dans les fichiers de configuration de compilation, consultez Exécuter des scripts Bash.

Exécutez une compilation à l'aide du fichier de configuration de compilation et des fichiers du répertoire actuel :

gcloud builds submit \ --config cloudbuild.yaml \ --region REGION \ --substitutions _SERVICE_ACCOUNT=CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --worker-pool projects/PROJECT_ID/locations/REGION/workerPools/PRIVATE_POOL_NAMELa commande importe tous les fichiers du répertoire actuel dans Cloud Storage pour qu'ils puissent être utilisés par Cloud Build. L'étape de compilation utilise le fichier kubeconfig pour se connecter au cluster GKE.

Vers la fin du résultat, vous verrez des lignes semblables à celles-ci :

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 2hCette sortie montre que le nœud de calcul du pool privé s'est connecté au plan de contrôle du cluster à l'aide du proxy d'authentification Identity Service pour GKE.

Dans Cloud Shell, supprimez le pool privé Cloud Build :

gcloud builds worker-pools delete PRIVATE_POOL_NAME --region REGION --quietSupprimez la connexion de service privée à Service Networking :

gcloud services vpc-peerings delete --network NETWORK \ --service servicenetworking.googleapis.com --quiet --asyncSupprimez la plage d'adresses IP allouée aux pools privés Cloud Build :

gcloud compute addresses delete RESERVED_RANGE_NAME --global --quietSupprimez le bucket Cloud Storage et tout son contenu :

gcloud storage rm gs://PROJECT_ID-build-logs --recursiveSupprimez le cluster GKE :

gcloud container clusters delete CLUSTER --zone ZONE --quiet --asyncSupprimez l'instance de VM Compute Engine :

gcloud compute instances delete VM --zone ZONE --quietSupprimez les règles de pare-feu :

gcloud compute firewall-rules delete allow-private-pools-ingress --quiet gcloud compute firewall-rules delete allow-ssh-ingress-from-iap --quiet gcloud compute firewall-rules delete allow-control-plane-clientconfig-webhook --quietSupprimez les liaisons de rôle IAM :

gcloud projects remove-iam-policy-binding PROJECT_ID \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/cloudbuild.builds.builder gcloud projects remove-iam-policy-binding PROJECT_ID \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/container.admin gcloud iam service-accounts remove-iam-policy-binding \ CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreator gcloud iam service-accounts remove-iam-policy-binding \ ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorSupprimez les comptes de service Google :

gcloud iam service-accounts delete CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --quiet gcloud iam service-accounts delete ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --quietAccédez à la page Identifiants dans la console Google Cloud :

Ouvrez la page Identifiants.

Sélectionnez votre projet dans la liste du sélecteur de projet.

Dans le tableau ID clients OAuth 2.0, recherchez la ligne Identity Service pour GKE, puis cliquez sur l'icône Supprimer le client OAuth.

Dans la boîte de dialogue, cliquez sur Supprimer.

- Découvrez comment accéder aux clusters Anthos depuis Cloud Build avec la passerelle Connect.

- Découvrez comment accéder aux clusters GKE privés avec les pools privés Cloud Build à l'aide de Cloud VPN.

- Découvrez comment créer des clusters privés GKE avec des proxys réseau pour l'accès au plan de contrôle.

- Découvrez comment accéder à des ressources externes dans un réseau privé à l'aide d'une adresse IP externe statique.

- Découvrez GKE Identity Service. GKE Identity Service vous permet de gérer l'authentification des fournisseurs d'identité externes dans un parc de clusters Anthos.

Créer un cluster GKE privé

Enregistrer Identity Service pour GKE en tant qu'application cliente OAuth 2.0

Dans cette section, vous allez enregistrer Identity Service pour GKE en tant qu'application cliente à l'aide du système d'authentification OAuth 2.0 de Google.

Créer un compte de service Google pour configurer Identity Service pour GKE

Configurer Identity Service pour GKE

Pour configurer Identity Service pour GKE, vous devez avoir accès au plan de contrôle du cluster. Dans ce tutoriel, vous allez créer une instance de VM Compute Engine pour accéder au plan de contrôle.

Vous avez besoin d'un accès SSH à l'instance de VM. Pour activer l'accès SSH authentifié et autorisé depuis l'extérieur du réseau VPC vers l'instance de VM, vous utilisez le transfert TCP avec Identity-Aware Proxy (IAP). Cette fonctionnalité permet d'accéder à SSH sans que l'instance de VM ait besoin d'une adresse IP publique.

(Facultatif) Vérifier la configuration du cluster

Avant de continuer, vous pouvez vérifier qu'Identity Service pour GKE a été correctement configuré sur le cluster. Pour vérifier la configuration, authentifiez-vous auprès du cluster à l'aide du compte de service Google associé à l'instance de VM à l'aide d'Identity Service pour GKE.

Créer un contexte pour l'outil kubectl

La commande kubectl peut utiliser un fichier kubeconfig pour configurer l'accès aux clusters. Un fichier kubeconfig contient un ou plusieurs contextes. Chaque contexte a un nom et inclut éventuellement des informations sur la connectivité du cluster, les identifiants utilisés pour l'authentification auprès du cluster et un espace de noms par défaut.

Dans cette section, vous allez créer un fichier kubeconfig avec un contexte. Le contexte inclut les informations de connectivité du proxy Identity Service pour GKE pour votre cluster. Vous n'ajoutez aucun identifiant utilisateur au fichier kubeconfig.

Créer un compte de service Google pour Cloud Build

Créer un pool privé Cloud Build

Valider la solution

Dans cette section, vous allez vérifier la solution en exécutant une compilation sur le pool privé Cloud Build. La compilation accède au cluster GKE privé.

Dépannage

Si vous ne parvenez pas à vous connecter à l'instance de VM à l'aide de SSH, ajoutez l'indicateur --troubleshoot pour identifier la cause des problèmes de connectivité :

gcloud compute ssh VM --tunnel-through-iap --zone ZONE --troubleshoot

Si le message Error from server (NotFound): clientconfigs.authentication.gke.io "default" not found s'affiche lorsque vous corrigez le ClientConfig par défaut sur le cluster GKE, assurez-vous d'avoir créé la règle de pare-feu comme décrit dans la section Créer un cluster GKE privé. Vérifiez que la règle de pare-feu existe :

gcloud compute firewall-rules describe allow-control-plane-clientconfig-webhook

Si vous ne parvenez pas à vous authentifier auprès du proxy Identity Service pour GKE, recherchez les erreurs dans les journaux des pods du déploiement gke-oidc-service :

gcloud compute ssh VM --tunnel-through-iap --zone ZONE --command \

'kubectl logs deployment/gke-oidc-service \

--namespace anthos-identity-service --all-containers'

Si vous rencontrez d'autres problèmes avec ce tutoriel, nous vous recommandons de consulter les documents ci-dessous :

Effectuer un nettoyage

Pour éviter que les ressources utilisées lors de ce tutoriel soient facturées sur votre compte Google Cloud, supprimez le projet contenant les ressources, ou conservez le projet et supprimez les ressources individuelles.

Supprimer le projet

Delete a Google Cloud project:

gcloud projects delete PROJECT_ID

Supprimer les ressources

Si vous souhaitez conserver le projet que vous avez utilisé dans ce tutoriel, supprimez les différentes ressources :