Vertex AI の新しいトレーニング機能で ML モデルの構築、デプロイ、スケーリングを高速化

Google Cloud Japan Team

※この投稿は米国時間 2022 年 2 月 11 日に、Google Cloud blog に投稿されたものの抄訳です。

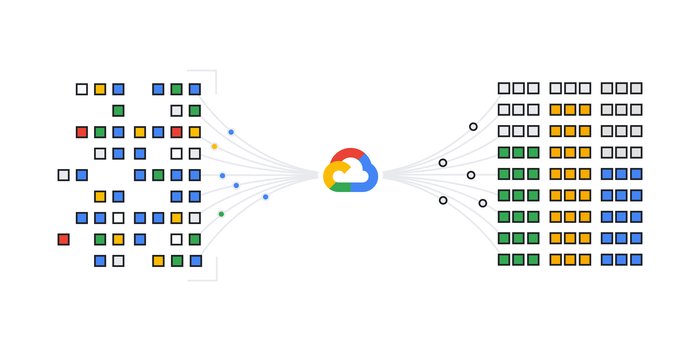

Vertex AI は十数種類の強力な MLOps ツールが 1 つのインターフェースに統合されているため、ML モデルの構築、デプロイ、スケーリングをより短時間で行うことができます。これらのツールは常時更新されています。最近強化された Vertex AI Training では、ローカルモードの改善によりデバッグのプロセスが高速化され、Auto-Container Packaging によりクラウドジョブの送信が簡略化されました。この記事では、こうした更新と、それらを使用してモデル トレーニング ワークフローを高速化する方法について紹介します。

デバッグは本質的に反復的なプロセスであり、小さなコード変更が繰り返されます。

Vertex AI Training は、VM の起動、依存関係の読み込み、データの取り込み、コードの実行、クラスタの破棄を行うマネージド クラウド環境です。単純なコード変更のテストには多くのオーバーヘッドが発生するため、デバッグのプロセスが大幅に遅れる可能性があります。一般的に、デベロッパーはクラウドジョブを送信する前に、まずローカルでコードをテストします。

Vertex AI Training の改善されたローカルモードを使用することで、Cloud VM のライフサイクルの完了を待たなくても、小規模なサンプル データセットに対して処理をローカルで繰り返してテストできるようになりました。この方法なら、クラウド スケールで実行する前に、簡単かつ高速にコードをデバッグできます。

ローカルモードを使用すると、ユーザーはコードをローカル実行として送信できるようになります。これは、Docker コンテナによって可能になる環境の一貫性により、クラウドジョブを実行する環境と同様の環境でコードが処理されるためです。その結果、信頼性と再現性が向上します。この新機能を使用すると、ジョブをクラウドに送信して VM クラスタのライフサイクル オーバーヘッドを待つ必要がないため、単純なランタイム エラーのデバッグ時間を短縮できます。環境を設定したら、gcloud を使用してローカル実行を開始できます。

クラウド スケールでコードを実行する準備が整ったら、Auto-Container Packaging でクラウドジョブの送信プロセスを簡略化できます。トレーニング アプリケーションを実行するには、コードと依存関係をアップロードする必要があります。これまで、このプロセスでは以下の 3 つのステップを踏んでいました。

Auto-Container Packaging を使用すると、この 3 つのステップによるプロセスが 1 つの作成ステップに減ります。

また、Docker の使用に慣れていない場合でも、Auto-Container Packaging を使用すれば、コンテナ化による一貫性や再現性の利点を享受できます。

前述の新しい Vertex AI Training 機能により、モデル トレーニングのワークフローがさらに簡単かつ高速になります。ローカルモードを使用すると、小さなコード変更を短時間で繰り返して、ランタイム エラーをすばやくデバッグできます。Auto-Container Packaging を使用すると、スケールアップしたクラウド ジョブとしてローカルの Python コードを送信するために必要なステップを減らすことができます。

こうした機能を実際に体験するには、こちらの Codelab をお試しください。

改善されたローカルモードについて詳しくは、ローカルモードのドキュメント ガイドをご覧ください。

Auto-Container Packaging のドキュメントは、「カスタムジョブの作成」ドキュメント ページの [gcloud] タブにあります。

Vertex AI については、デベロッパー アドボケイトによるブログ投稿をご覧ください。

- プロダクト マネージャー Winston Chiang

- ソフトウェア エンジニア Nathan Li