Creazione di deployment in più regioni per API Gateway

Questo tutorial mostra come configurare un bilanciatore del carico HTTP(S) per abilitare i deployment multiregionali per API Gateway.

La creazione di un bilanciatore del carico HTTP(S) per supportare i deployment multiregionali di API Gateway può migliorare la disponibilità e ridurre la latenza del servizio, in quanto viene gestito da più di una regione. Puoi ridurre ulteriormente la latenza e massimizzare l'uptime con il routing tra regioni, che gestisce le richieste dalla regione disponibile più vicina all'utente.

Ai fini di questo tutorial, configurerai un singolo schema URL non regionale che funziona in qualsiasi parte del mondo, ma gestisce le richieste degli utenti dal deployment di API Gateway più vicino. Con questa configurazione, le richieste vengono indirizzate idealmente alla regione che offre la latenza minima all'utente. Nel caso in cui la regione più vicina non sia disponibile o abbia superato la capacità, la richiesta viene indirizzata a un'altra regione per garantire la disponibilità.

Prima di iniziare

Prima di configurare il deployment multiregionale, segui la guida rapida di API Gateway per eseguire il deployment di un servizio Cloud Run e creare un gateway che rimandi a quel servizio.

Per questo tutorial, esegui il deployment del servizio in due regioni diverse. Ad esempio, puoi eseguire il deployment di due istanze di API Gateway:

my-gateway-eua una regione in Europamy-gateway-usa una regione negli Stati Uniti

Configura autorizzazioni

In questo tutorial creerai un gruppo di endpoint di rete (NEG) serverless e un bilanciatore del carico HTTP(S) esterno in un progetto Cloud. Per questa operazione è necessario il ruolo di proprietario o editor del progetto oppure i seguenti ruoli IAM di Compute Engine:

| Attività | Ruolo richiesto |

|---|---|

| Crea bilanciatore del carico e componenti di rete | Amministratore di rete |

| Creare e modificare i gruppi di annunci con targeting espanso | Compute Instance Admin |

| Crea e modifica certificati SSL | Amministratore della sicurezza |

Crea una risorsa del certificato SSL

Per creare un bilanciatore del carico HTTPS, è necessario aggiungere una risorsa certificato SSL al frontend del bilanciatore del carico. Crea una risorsa del certificato SSL utilizzando un certificato SSL gestito da Google o un certificato SSL autogestito.

Certificati gestiti da Google. L'utilizzo di certificati gestiti da Google è consigliato perché Google Cloud ottiene, gestisce e rinnova questi certificati automaticamente. Per creare un certificato gestito da Google, devi disporre di un dominio e dei record DNS per quel dominio affinché il certificato venga sottoposto a provisioning. Se non hai ancora un dominio, puoi acquistarlo da Google Domains. Inoltre, dovrai aggiornare il record A DNS del dominio in modo che punti all'indirizzo IP del bilanciatore del carico creato in un passaggio successivo. Per istruzioni dettagliate, vedi Utilizzo dei certificati gestiti da Google.

Certificati autofirmati. Se non vuoi configurare un dominio in questo momento, puoi utilizzare un certificato SSL autofirmato per i test.

Questo tutorial presuppone che tu abbia già creato una risorsa del certificato SSL.

Se vuoi testare questa procedura senza creare una risorsa certificato SSL (o un dominio come richiesto dai certificati gestiti da Google), puoi comunque utilizzare le istruzioni riportate in questa pagina per configurare un bilanciamento del carico HTTP.

Crea il bilanciatore del carico HTTP(S)

Crea un NEG serverless per ogni istanza di API Gateway.

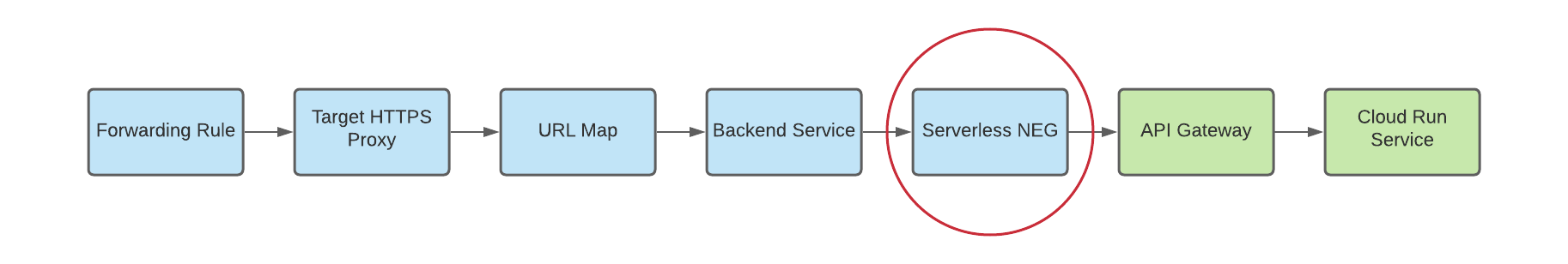

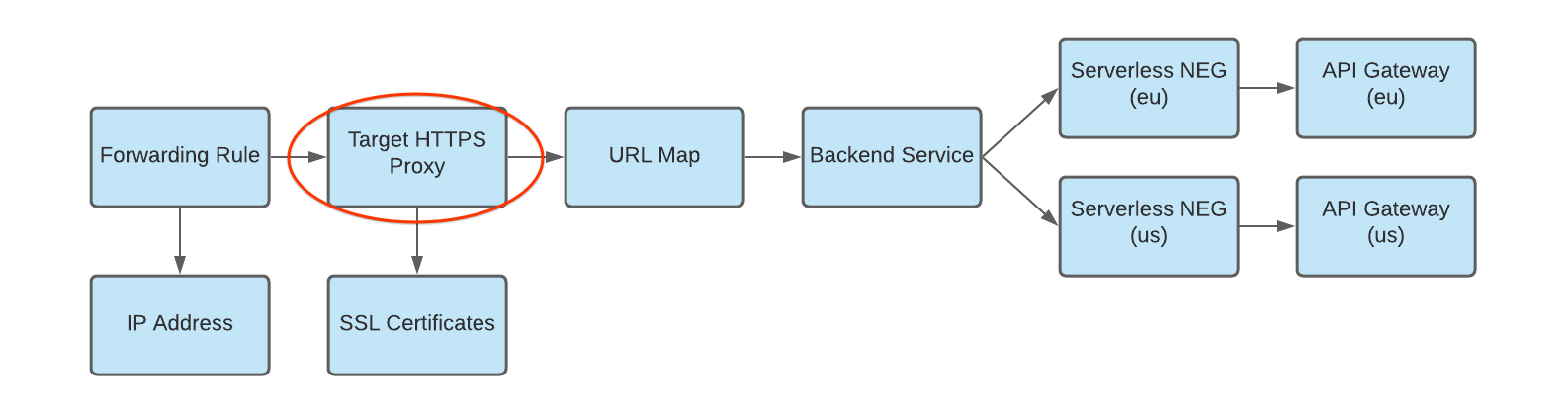

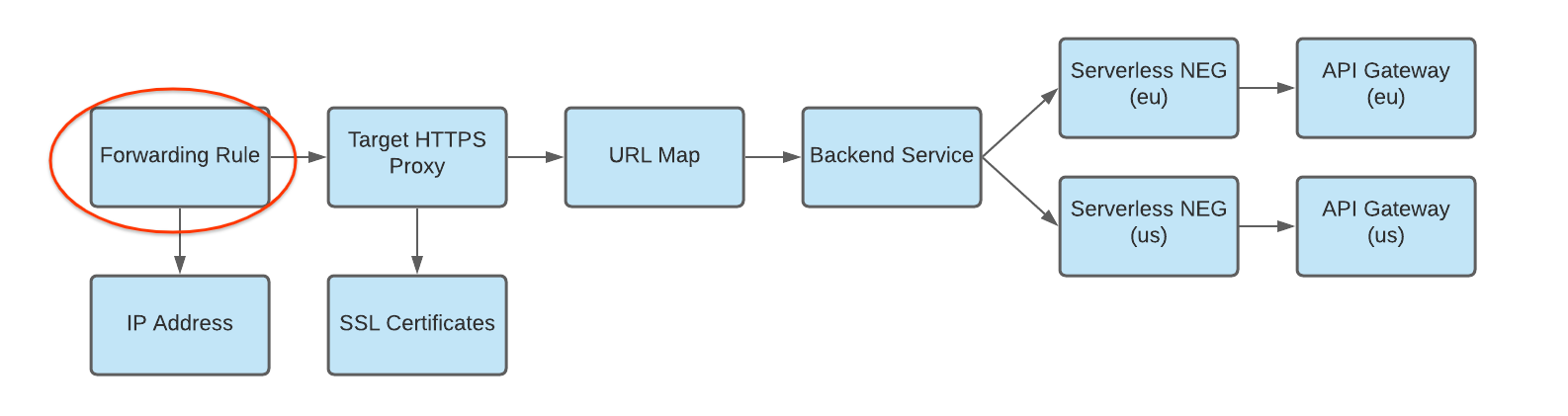

Un gruppo di endpoint di rete (NEG) specifica un gruppo di endpoint di backend per un bilanciatore del carico. Un NEG serverless è un backend che punta a un servizio come API Gateway, come mostrato nella figura seguente:

Per creare un NEG serverless per ogni istanza gateway, esegui questo comando, dove:

- SERVERLESS_NEG_NAME è il nome del NEG serverless da creare.

- GATEWAY_ID specifica il nome del gateway.

- REGION_ID è la regione di deployment per il NEG serverless (deve corrispondere alla regione del gateway).

gcloud beta compute network-endpoint-groups create SERVERLESS_NEG_NAME \ --region=REGION_ID \ --network-endpoint-type=serverless \ --serverless-deployment-platform=apigateway.googleapis.com \ --serverless-deployment-resource=GATEWAY_ID

Ad esempio:

gcloud beta compute network-endpoint-groups create api-gateway-serverless-neg-eu \ --region=europe-west1 \ --network-endpoint-type=serverless \ --serverless-deployment-platform=apigateway.googleapis.com \ --serverless-deployment-resource=my-gateway-eu

Ripeti questo comando per creare un NEG serverless per la successiva istanza del gateway, utilizzando i valori appropriati per la seconda istanza del gateway, ad esempio

api-gateway-serverless-neg-uspermy-gateway-usnella regioneus-central1.Crea un servizio di backend per definire in che modo Cloud Load Balancing distribuisce il traffico.

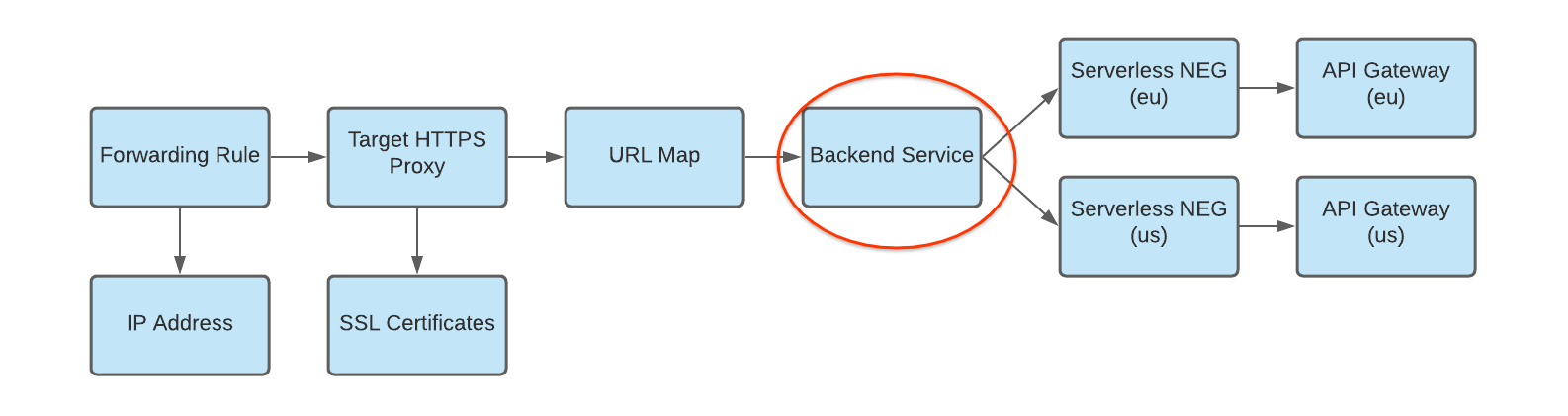

La configurazione del servizio di backend contiene un insieme di valori, come il protocollo utilizzato per connettersi ai backend, varie impostazioni di distribuzione e sessione, controlli di integrità e timeout, come mostrato nella figura seguente:

Per creare un servizio di backend e aggiungere il tuo NEG serverless come backend al servizio di backend, esegui i seguenti comandi, dove:

- BACKEND_SERVICE_NAME è il nome del servizio di backend.

- SERVERLESS_NEG_NAME è il nome del NEG serverless creato nel passaggio precedente.

- REGION_ID è la regione di deployment per il NEG serverless (deve corrispondere alla regione del gateway).

gcloud compute backend-services create BACKEND_SERVICE_NAME \ --global \

gcloud compute backend-services add-backend BACKEND_SERVICE_NAME \ --global \ --network-endpoint-group=SERVERLESS_NEG_NAME \ --network-endpoint-group-region=REGION_ID

Ad esempio:

gcloud compute backend-services add-backend api-gateway-backend-service \ --global \ --network-endpoint-group=api-gateway-serverless-neg-eu \ --network-endpoint-group-region=europe-west1

Ripeti questo comando per aggiungere il secondo NEG serverless al servizio di backend, utilizzando i valori appropriati per il secondo NEG serverless, ad esempio

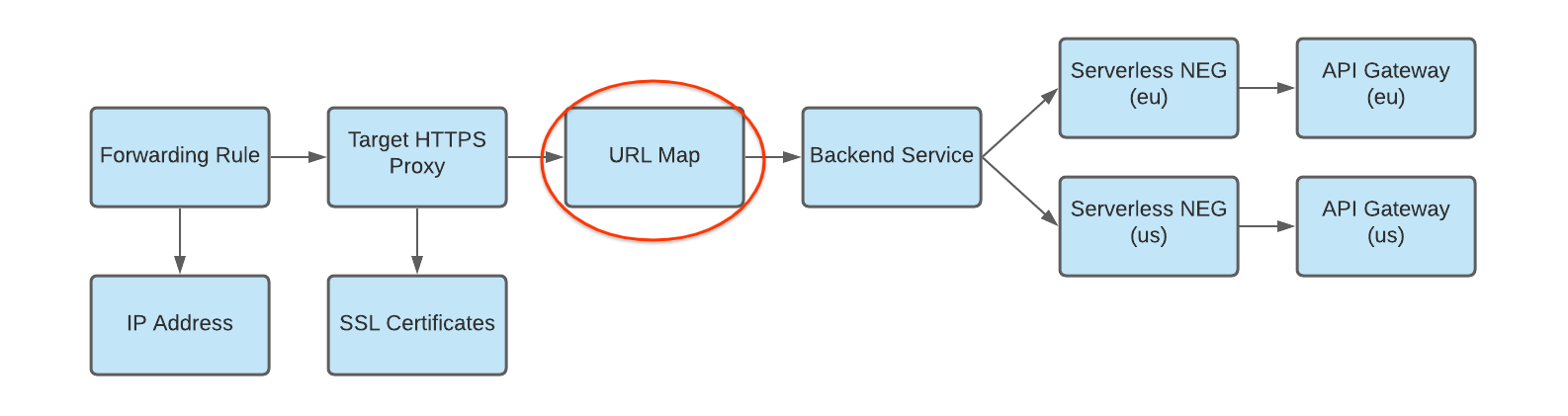

api-gateway-serverless-neg-uspermy-gateway-usnella regioneus-central1.Crea una mappa URL per instradare le richieste in entrata al servizio di backend, come mostrato nella figura seguente:

Per creare la mappa URL, esegui questo comando, dove:

- URL_MAP_NAME è il nome della mappa URL da creare.

- BACKEND_SERVICE_NAME è il nome del servizio di backend.

gcloud compute url-maps create URL_MAP_NAME \ --default-service BACKEND_SERVICE_NAME

Ad esempio:

gcloud compute url-maps create api-gateway-url-map \ --default-service api-gateway-backend-service

Questa mappa URL ha come target un solo servizio di backend che rappresenta un singolo gateway, quindi non sono necessarie regole host o matcher di percorso. Se hai più di un servizio di backend, puoi utilizzare le regole host per indirizzare le richieste a servizi diversi in base al nome host. Utilizza i matcher di percorso per indirizzare le richieste a servizi diversi in base al percorso della richiesta.

Ad esempio:

gcloud compute url-maps add-path-matcher api-gateway-url-map \ --path-matcher-name=my-pm2 \ --default-service=my-host-default-backend \ --path-rules="/video=video-service,/video/*=video-service" \ --new-hosts my-hosts.com

gcloud compute url-maps add-host-rule api-gateway-url-map \ --hosts=my-app-domain \ --path-matcher-name=my-app-path-matcher

Per scoprire di più sulle regole host e sui matcher di percorso, consulta la documentazione relativa alla mappa URL.

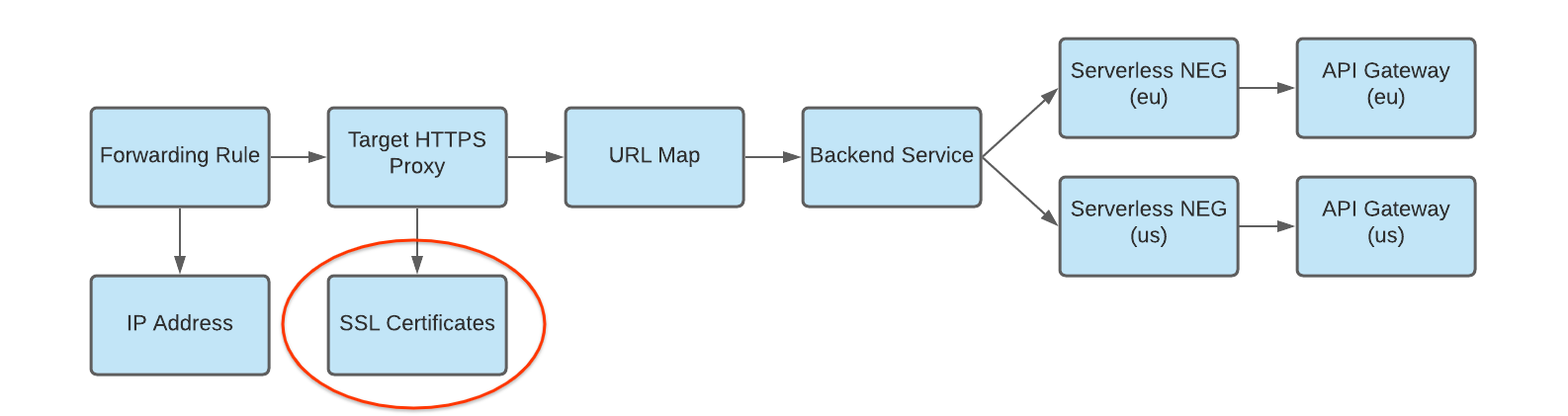

Crea un certificato SSL per il proxy di destinazione, come mostrato nella figura seguente:

Per creare un bilanciatore del carico HTTPS, è necessaria una risorsa certificato SSL per il proxy HTTPS di destinazione. Puoi creare una risorsa del certificato SSL utilizzando un certificato SSL gestito da Google o un certificato SSL autogestito. È consigliabile utilizzare i certificati gestiti da Google.

Per creare un certificato gestito da Google, devi avere un dominio. Se non hai un dominio, puoi utilizzare un certificato SSL autofirmato per i test.

Per creare una risorsa del certificato SSL gestito da Google:

gcloud compute ssl-certificates create SSL_CERTIFICATE_NAME --domains DOMAIN

Per creare una risorsa del certificato SSL autogestito:

gcloud compute ssl-certificates create SSL_CERTIFICATE_NAME \ --certificate CRT_FILE_PATH \ --private-key KEY_FILE_PATH

Crea un proxy HTTP(S) di destinazione per instradare le richieste alla mappa URL, come mostrato nella figura seguente:

Per creare il proxy di destinazione, utilizza il seguente comando, dove:

- TARGET_HTTP_PROXY_NAME è il nome del proxy di destinazione da creare.

- URL_MAP_NAME è il nome della mappa URL creata in un passaggio precedente.

- (Facoltativo) SSL_CERT_NAME è il nome del certificato SSL creato.

gcloud compute target-http-proxies create TARGET_HTTP_PROXY_NAME \ --ssl-certificates=SSL_CERT_NAME --url-map=URL_MAP_NAME

Ad esempio:

gcloud compute target-http-proxies create api-gateway-https-proxy \ --ssl-certificates=hello-cert --url-map=api-gateway-url-map

Crea una regola di forwarding per instradare le richieste in entrata al proxy, come mostrato nella figura seguente:

Utilizza il seguente comando per creare la regola di forwarding, dove:

- HTTPS_FORWARDING_RULE_NAME è il nome della regola da creare.

- TARGET_HTTP_PROXY_NAME è il nome del proxy di destinazione da creare.

gcloud compute forwarding-rules create HTTPS_FORWARDING_RULE_NAME \ --target-https-proxy=TARGET_HTTPS_PROXY_NAME \ --global \ --ports=443

Ad esempio:

gcloud compute forwarding-rules create my-fw \ --target-https-proxy=api-gateway-https-proxy \ --global \ --ports=443

Aggiorna i record DNS con l'indirizzo IP del bilanciatore del carico

Se hai un dominio personalizzato, questo passaggio è necessario per configurare le impostazioni DNS del tuo dominio in modo che puntino al nuovo indirizzo IP del tuo servizio. È necessario anche se hai creato un bilanciatore del carico HTTP(S) con un certificato gestito da Google (che richiede un dominio). L'allocazione e l'utilizzo di un indirizzo IP statico sono consigliati se utilizzati con DNS. Le istruzioni specifiche per questo passaggio dipendono dal tuo provider DNS.

Per inviare traffico al bilanciatore del carico, il record DNS del tuo dominio (in questo tutorial, my-app-domain) deve puntare agli indirizzi IP del bilanciatore del carico.

Per trovare l'indirizzo IP della regola di forwarding globale, utilizza questo comando:

gcloud compute forwarding-rules list

Aggiorna il record A o AAAA DNS del tuo dominio in modo che punti all'indirizzo IP del bilanciatore del carico, in modo che il traffico inviato all'URL del dominio personalizzato esistente venga instradato tramite il bilanciatore del carico. Potrebbero essere necessari pochi secondi o diverse ore prima che il DNS propaghi questa modifica al server DNS.

Esegui un test per verificare che il gateway riceva traffico utilizzando

curlo visitando l'URL nel browser. Ad esempio:https://my-app-domainDopo il test, dovresti vedere la risposta generata dal servizio Cloud Run. Ad esempio, potrebbe trattarsi di una pagina HTML "Hello World" o di un'altra risposta prevista generata direttamente dal servizio di backend. Ciò significa che la richiesta passa attraverso il bilanciatore del carico e il servizio di backend sta istruendo il bilanciatore del carico a inviarla al gateway.

Considerazioni

Prima di implementare un deployment multiregionale di API Gateway, tieni presente quanto segue:

API Gateway non supporta attualmente i controlli di integrità. Con la configurazione del routing tra regioni descritta sopra, se il gateway o il relativo servizio di backend restituisce errori in una regione, ma l'infrastruttura complessiva di API Gateway nella regione è disponibile e ha capacità, il bilanciatore del carico HTTP(S) non indirizzerà il traffico verso altre regioni.

La combinazione di regioni diverse in un'unica regola di forwarding richiede i prezzi del livello Premium. Per ulteriori informazioni sul calcolo dei prezzi e dell'utilizzo, consulta la sezione Prezzi di Network Service Tiers.

Best practice

Quando utilizzi la pubblicazione multiregionale, ti consigliamo di utilizzare una soluzione di archiviazione dei dati gestita e replicata a livello globale, come Cloud Spanner, per assicurarti che tutti i dati vengano gestiti a livello globale.