Vertex AI Platform

借助由 Gemini 模型增强的企业级 AI 技术,加快创新速度

Vertex AI 是一个全托管式统一 AI 开发平台,用于构建和使用生成式 AI。获取并使用 Vertex AI Studio、Agent Builder 和 200 多种基础模型。

新客户最高可获享 $300 赠金,用于试用 Vertex AI 和其他 Google Cloud 产品。

功能

Gemini - Google 强大的多模态模型

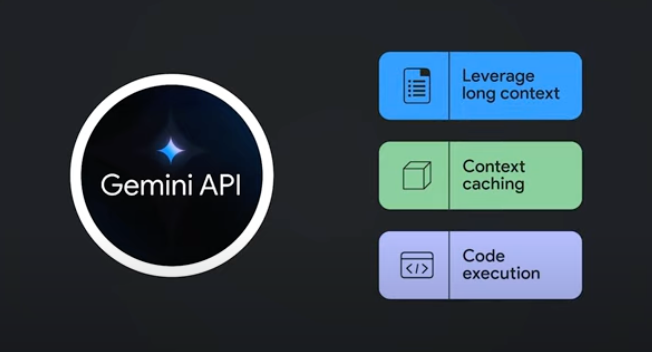

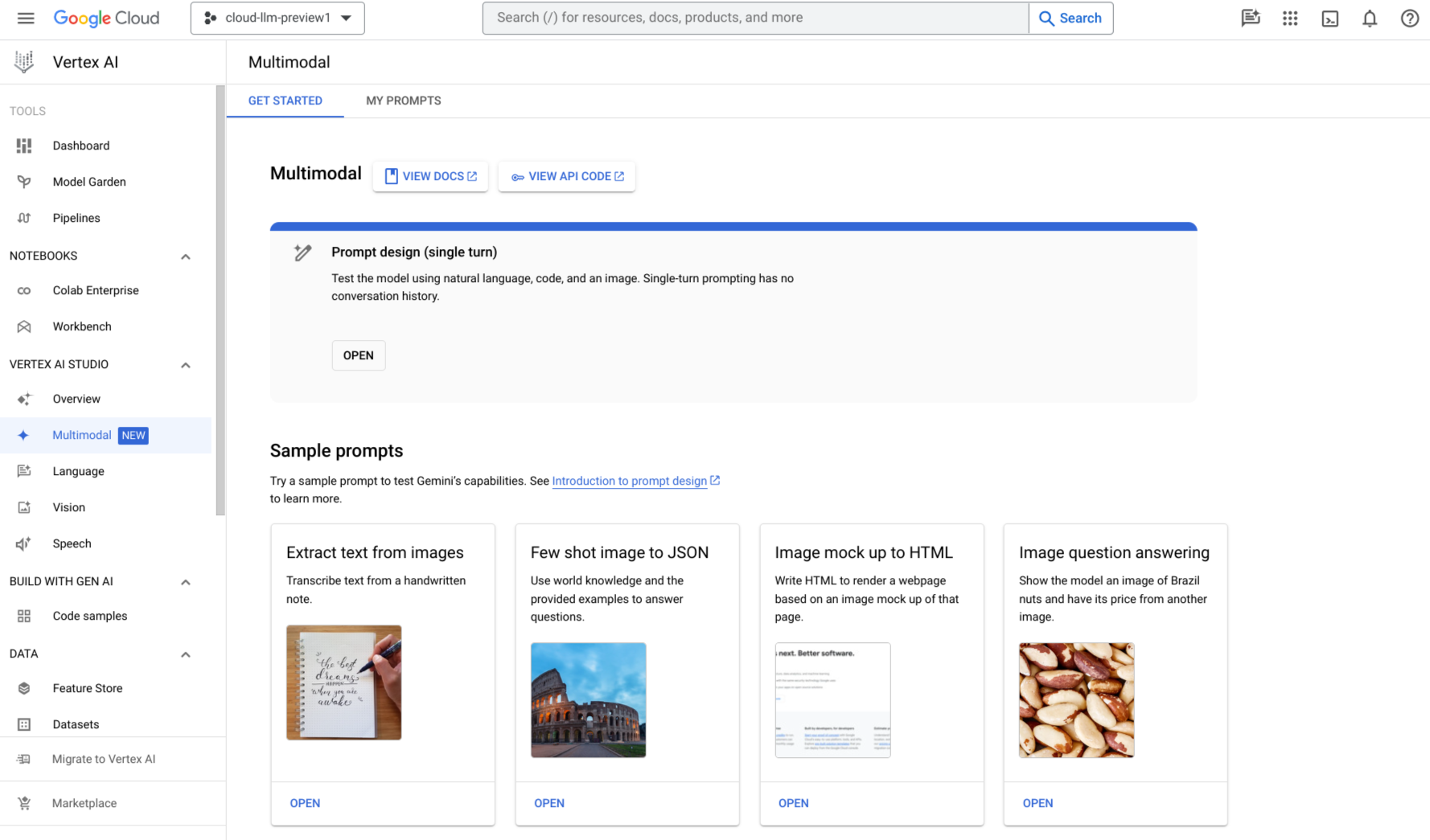

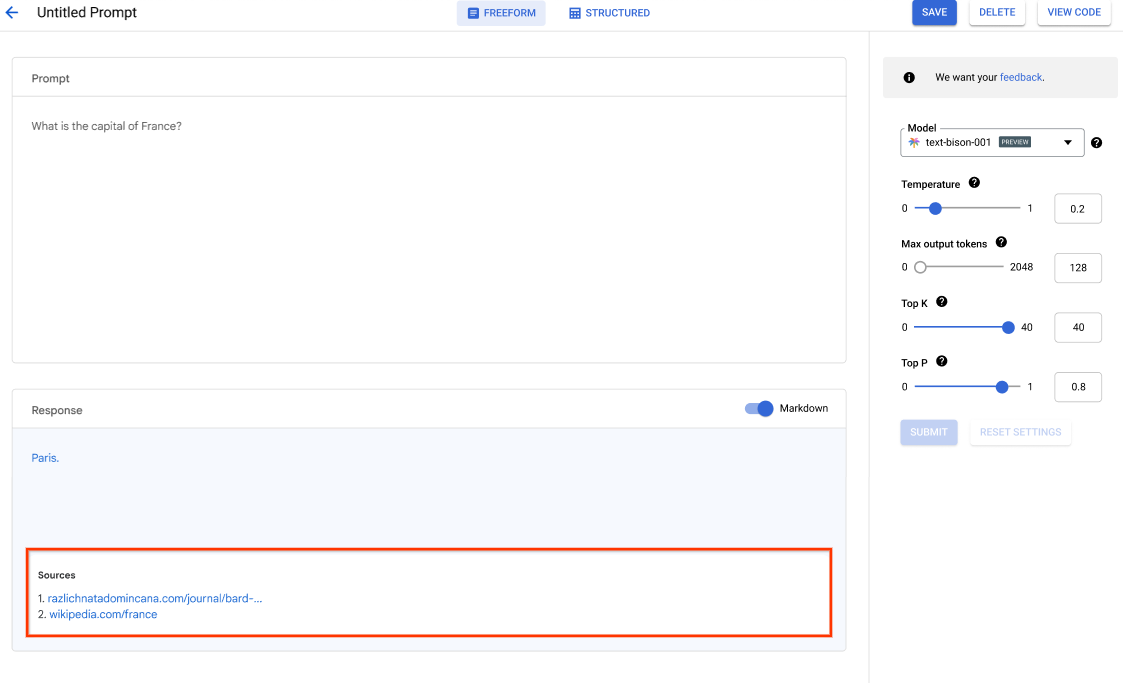

Vertex AI 支持使用 Google 的最新 Gemini 模型,包括 Gemini 3。Gemini 能够理解几乎任何输入、组合不同类型的信息,还能生成几乎任何输出。在 Vertex AI Studio 中使用文本、图片、视频或代码发出提示并测试 Gemini。利用 Gemini 的高级推理和先进的生成功能,开发者可以尝试使用示例提示,从而提取图片中的文本、将图片文本转换为 JSON,甚至可以针对上传的图片生成答案,以构建新一代 AI 应用。

200 多种生成式 AI 模型和工具

Model Garden 中提供了丰富的第一方模型(Gemini、Imagen、Chirp、Veo)、第三方模型(Anthropic 的 Claude 模型系列)和开放模型(Gemma、Llama 3.2)供您选择。使用扩展程序使模型能够检索实时信息和触发操作。您还可以使用各种调优选项,根据您自己的应用场景自定义模型。

我们的 Gen AI Evaluation Service 提供企业级工具,可对生成式 AI 模型进行客观、数据驱动的评估。

开放的集成式 AI 平台

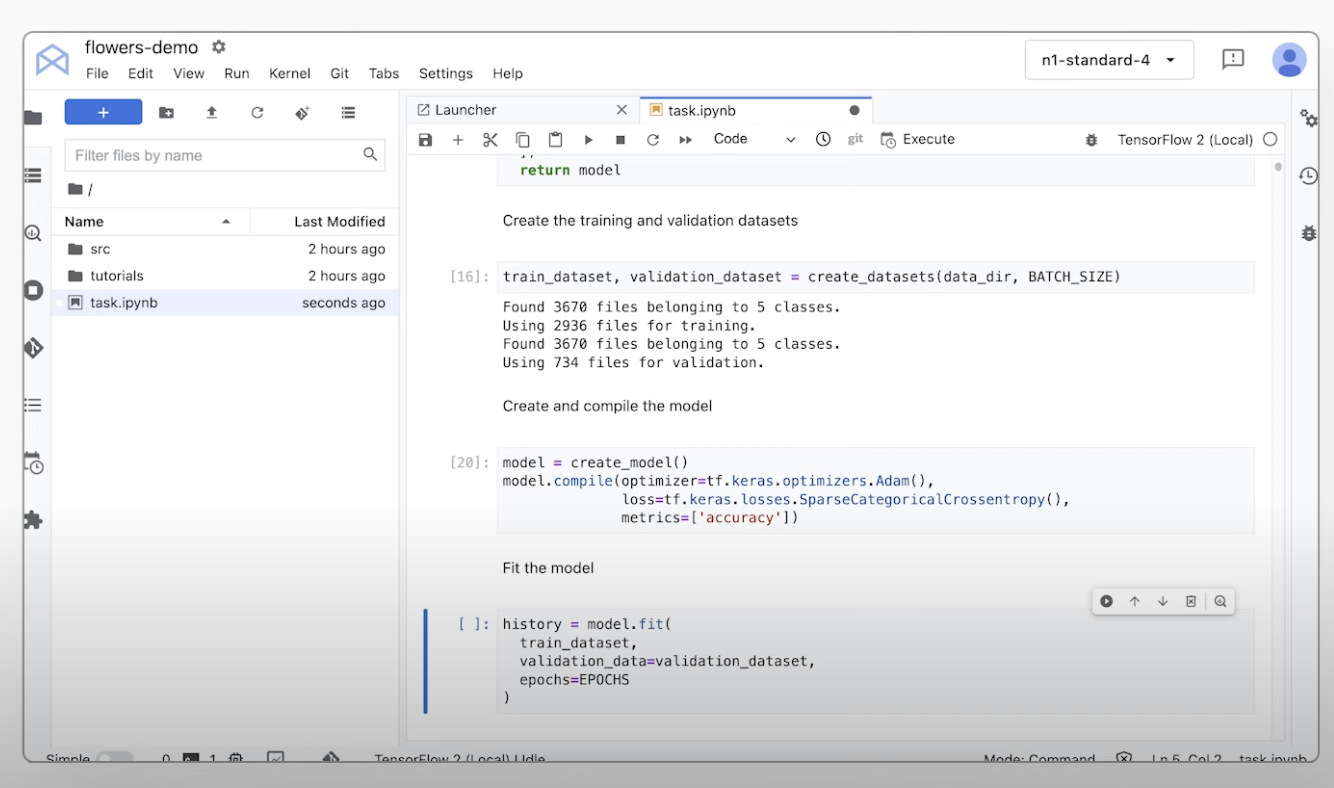

借助 Vertex AI Platform 中用于训练、调整和部署机器学习模型的工具,数据科学家可以提高工作效率。

Vertex AI 笔记本(包括您选择的 Colab Enterprise 或 Workbench)与 BigQuery 原生集成,提供了一个涵盖所有数据和 AI 工作负载的平台。

在 Vertex AI Training 和 Prediction 的帮助下,您使用自己选择的开源框架和经过优化的 AI 基础架构缩短训练时间并将模型轻松部署到生产环境中。

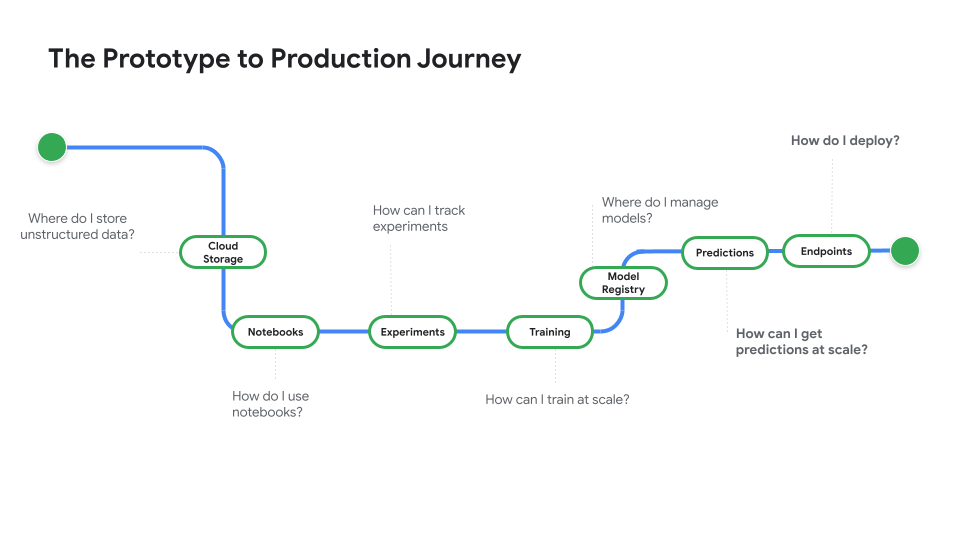

适用于预测式 AI 和生成式 AI 的 MLOps

Vertex AI Platform 为数据科学家和机器学习工程师提供专用的 MLOps 工具,可用于机器学习项目的自动化、标准化和管理。

利用模块化工具,您可以在整个开发生命周期中跨团队协作并优化模型,这包括通过 Vertex AI Evaluation 确定适合某个应用场景的最佳模型、使用 Vertex AI Pipelines 编排工作流、使用 Model Registry 管理任何模型、通过 Feature Store 提供、共享和重复使用机器学习功能,以及监控模型的输入偏差和偏移。

构建、扩缩和治理企业级智能体

Vertex AI Agent Builder 是我们开放而全面的平台,可帮助企业快速构建、扩缩和治理基于企业数据的企业级智能体。它提供您所需的全栈基础和丰富的开发者选项,可帮助您在全球范围内将您的应用和工作流转变为强大、可靠的智能体系统。

工作方式

Vertex AI 提供了多种模型训练和部署选项:

- 生成式 AI 让您可以使用大型生成式 AI 模型(包括 Gemini 3),以便您可以评估、调优和部署这些模型,并用于 AI 赋能的应用中。

- 借助 Model Garden,您可以在 Vertex AI 中发现、测试、自定义和部署各类模型,其中包括精选的开源 (OSS) 模型和资源。

- 自定义训练使您能够完全控制训练过程,包括使用您偏好的机器学习框架、编写自己的训练代码以及选择超参数调节选项。

Vertex AI 提供了多种模型训练和部署选项:

- 生成式 AI 让您可以使用大型生成式 AI 模型(包括 Gemini 3),以便您可以评估、调优和部署这些模型,并用于 AI 赋能的应用中。

- 借助 Model Garden,您可以在 Vertex AI 中发现、测试、自定义和部署各类模型,其中包括精选的开源 (OSS) 模型和资源。

- 自定义训练使您能够完全控制训练过程,包括使用您偏好的机器学习框架、编写自己的训练代码以及选择超参数调节选项。

常见用途

使用 Gemini 模型进行构建:

开始使用 Google 的多模态模型

开始使用 Google 的多模态模型

在 Google Cloud Vertex AI 中通过 Gemini API 访问 Gemini 模型

- Python

- JavaScript

- Java

- Go

- Curl

教程、快速入门和实验

开始使用 Google 的多模态模型

开始使用 Google 的多模态模型

代码示例

在 Google Cloud Vertex AI 中通过 Gemini API 访问 Gemini 模型

- Python

- JavaScript

- Java

- Go

- Curl

AI 智能体和应用

利用 Vertex AI 解锁高级 AI 功能

利用 Vertex AI 解锁高级 AI 功能

在一个可根据您的需求扩缩的平台上构建可用于生产用途的生成式 AI 智能体及应用。我们的 AI 开发平台 Vertex AI 提供了一个安全的环境,用于开发和部署 AI 模型及应用。

对于开发者来说,Vertex AI 仍然是我们先进的平台,您可以在其中使用智能体开发套件 (ADK) 等框架构建、自定义和微调复杂的智能体。

立即开始使用此 Codelab 并构建您的第一个 AI 应用

教程、快速入门和实验

利用 Vertex AI 解锁高级 AI 功能

利用 Vertex AI 解锁高级 AI 功能

在一个可根据您的需求扩缩的平台上构建可用于生产用途的生成式 AI 智能体及应用。我们的 AI 开发平台 Vertex AI 提供了一个安全的环境,用于开发和部署 AI 模型及应用。

对于开发者来说,Vertex AI 仍然是我们先进的平台,您可以在其中使用智能体开发套件 (ADK) 等框架构建、自定义和微调复杂的智能体。

立即开始使用此 Codelab 并构建您的第一个 AI 应用

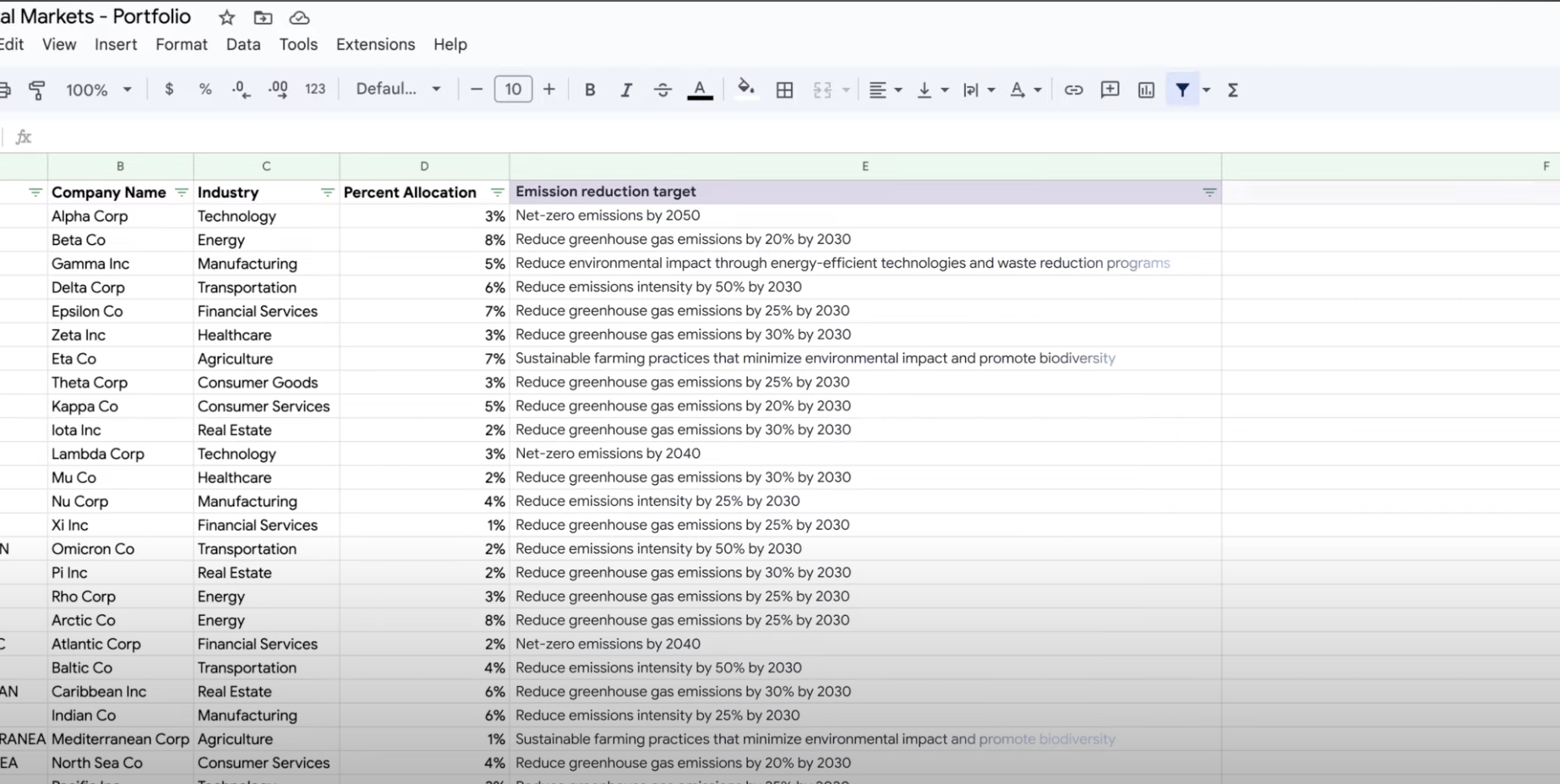

提取、汇总数据,以及对数据进行分类

使用生成式 AI 进行摘要、分类和提取

了解如何使用 Vertex AI 的生成式 AI 支持创建用于处理任意数量任务的文本提示。一些最常见的任务包括分类、摘要和提取。借助 Gemini on Vertex AI,您可以灵活地设计提示的结构和格式。

教程、快速入门和实验

使用生成式 AI 进行摘要、分类和提取

了解如何使用 Vertex AI 的生成式 AI 支持创建用于处理任意数量任务的文本提示。一些最常见的任务包括分类、摘要和提取。借助 Gemini on Vertex AI,您可以灵活地设计提示的结构和格式。

价格

| Vertex AI 定价方式 | 按所使用的 Vertex AI 工具、存储、计算和 Google Cloud 资源付费。新客户可获赠 $300 赠金,用于试用 Vertex AI 和 Google Cloud 产品。 | |

|---|---|---|

| 工具和用法 | 说明 | 价格 |

生成式 AI | 用于生成图片的 Imagen 模型 基于图片输入、字符输入或自定义训练价格。 | 起价 $0.0001 |

文本、聊天和代码生成 基于每 1,000 个输入字符(提示)和每 1,000 个输出字符(回复)。 | 起价 $0.0001 每 1,000 个字符 | |

自定义训练模型 | 联系业务代表 | |

Vertex AI 笔记本 | 计算和存储资源 基于与 Compute Engine 和 Cloud Storage 相同的费率。 | 参阅产品 |

管理费 除上述资源用量外,您还需要根据所使用的区域、实例、笔记本和代管式笔记本支付管理费用。查看详细信息。 | 参阅详细信息 | |

Vertex AI Pipelines | 执行费用和额外费用 基于执行费用、使用的资源和任何其他服务费。 | 起价 $0.03 每次流水线运行 |

Vertex AI Vector Search | 服务和构建费用 基于数据大小、您要运行的每秒查询次数 (QPS) 和使用的节点数。查看示例。 | 参考示例 |

查看所有 Vertex AI 功能和服务的价格详情。

Vertex AI 定价方式

按所使用的 Vertex AI 工具、存储、计算和 Google Cloud 资源付费。新客户可获赠 $300 赠金,用于试用 Vertex AI 和 Google Cloud 产品。

文本、聊天和代码生成

基于每 1,000 个输入字符(提示)和每 1,000 个输出字符(回复)。

Starting at

$0.0001

每 1,000 个字符

执行费用和额外费用

基于执行费用、使用的资源和任何其他服务费。

Starting at

$0.03

每次流水线运行

查看所有 Vertex AI 功能和服务的价格详情。

业务用例

充分发挥生成式 AI 的潜力

“Google Cloud 的生成式 AI 解决方案的准确性和 Vertex AI Platform 的实用性让我们信心十足地在业务核心领域实施这项尖端技术,并实现了我们的零分钟响应时间这一长期目标。”

GA Telesis 首席执行官 Abdol Moabery