Détection de l'écriture manuscrite avec reconnaissance optique des caractères (OCR)

L'API Vision peut détecter et extraire du texte à partir d'images :

DOCUMENT_TEXT_DETECTIONextrait le texte d'une image (ou d'un fichier). La réponse est optimisée pour les textes et les documents denses. Le JSON comprend des informations sur les pages, les blocs, les paragraphes, les mots et les blancs.

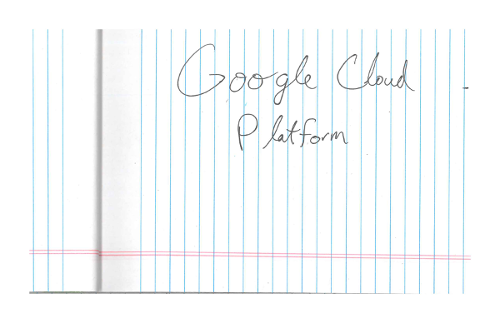

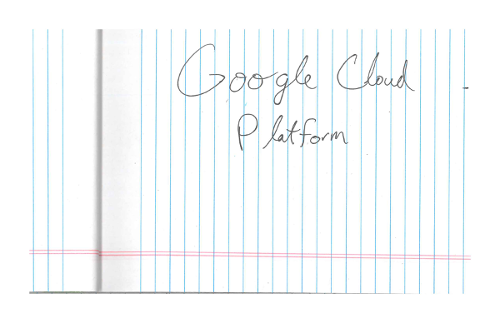

Une utilisation spécifique de DOCUMENT_TEXT_DETECTION consiste à détecter l'écriture manuscrite dans une image.

Faites l'essai

Si vous débutez sur Google Cloud, créez un compte pour évaluer les performances de l'API Cloud Vision en conditions réelles. Les nouveaux clients bénéficient également de 300 $ de crédits gratuits pour exécuter, tester et déployer des charges de travail.

Profiter d'un essai offert de l'API Cloud VisionRequêtes de détection de document texte

Configurer votre Google Cloud projet et votre authentification

Détecter le texte d'un document dans une image locale

L'API Vision permet de détecter des caractéristiques dans un fichier image local.

Pour les requêtes REST, envoyez le contenu du fichier image en tant que chaîne encodée en base64 dans le corps de votre requête.

Pour les requêtes gcloud et les bibliothèques clientes, spécifiez le chemin d'accès à une image locale dans votre requête.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- BASE64_ENCODED_IMAGE : représentation en base64 (chaîne ASCII) de vos données d'image binaires. Cette chaîne doit ressembler à la chaîne suivante :

/9j/4QAYRXhpZgAA...9tAVx/zDQDlGxn//2Q==

- PROJECT_ID : ID de votre projet Google Cloud .

Méthode HTTP et URL :

POST https://vision.googleapis.com/v1/images:annotate

Corps JSON de la requête :

{

"requests": [

{

"image": {

"content": "BASE64_ENCODED_IMAGE"

},

"features": [

{

"type": "DOCUMENT_TEXT_DETECTION"

}

]

}

]

}

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/images:annotate"

PowerShell

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/images:annotate" | Select-Object -Expand Content

Si la requête aboutit, le serveur affiche un code d'état HTTP 200 OK et la réponse au format JSON.

Go

Avant d'essayer cet exemple, suivez les instructions de configuration pour Go décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Go.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Java.

Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Node.js.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Python.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Langues supplémentaires

C# : Veuillez suivre les Instructions de configuration de C# sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour .NET.

PHP : Veuillez suivre les Instructions de configuration pour PHP sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour PHP.

Ruby : Veuillez suivre les Instructions de configuration de Ruby sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour Ruby.

Détecter le texte d'un document dans une image distante

L'API Vision permet de détecter des caractéristiques dans un fichier image distant situé dans Cloud Storage ou sur le Web. Pour envoyer une requête de fichier distant, spécifiez l'URL Web ou l'URI Cloud Storage du fichier dans le corps de la requête.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- CLOUD_STORAGE_IMAGE_URI : chemin d'accès à un fichier image valide dans un bucket Cloud Storage. Il faut au minimum disposer des droits en lecture sur le fichier.

Exemple :

gs://cloud-samples-data/vision/handwriting_image.png

- PROJECT_ID : ID de votre projet Google Cloud .

Méthode HTTP et URL :

POST https://vision.googleapis.com/v1/images:annotate

Corps JSON de la requête :

{

"requests": [

{

"image": {

"source": {

"imageUri": "CLOUD_STORAGE_IMAGE_URI"

}

},

"features": [

{

"type": "DOCUMENT_TEXT_DETECTION"

}

]

}

]

}

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/images:annotate"

PowerShell

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/images:annotate" | Select-Object -Expand Content

Si la requête aboutit, le serveur affiche un code d'état HTTP 200 OK et la réponse au format JSON.

Go

Avant d'essayer cet exemple, suivez les instructions de configuration pour Go décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Go.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Java.

Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Node.js.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Python.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

gcloud

Pour effectuer la détection de l'écriture manuscrite, utilisez la commande gcloud ml vision detect-document comme indiqué dans l'exemple suivant :

gcloud ml vision detect-document gs://cloud-samples-data/vision/handwriting_image.png

Langages supplémentaires

C# : Veuillez suivre les Instructions de configuration de C# sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour .NET.

PHP : Veuillez suivre les Instructions de configuration pour PHP sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour PHP.

Ruby : Veuillez suivre les Instructions de configuration de Ruby sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour Ruby.

Spécifier la langue (facultatif)

Les deux types de requêtes OCR sont compatibles avec un ou plusieurs paramètres languageHints qui spécifient la langue du texte de l'image. Cependant, une valeur vide donne généralement de meilleurs résultats, car l'omission d'une valeur active la détection automatique de la langue. Pour les langues basées sur l'alphabet latin, le paramètre languageHints n'est pas nécessaire. Dans de rares cas, lorsque la langue du texte de l'image est connue, le réglage de ce paramètre aide à obtenir de meilleurs résultats (bien que cela nuise fortement au fonctionnement du service si sa valeur est erronée). La détection de texte renvoie une erreur si une ou plusieurs des langues spécifiées ne font pas partie des langues compatibles.

Si vous choisissez de fournir un indicateur de langue, modifiez le corps de votre requête (fichier request.json) pour fournir la chaîne de l'une des langues compatibles dans le champ imageContext.languageHints, comme indiqué dans l'exemple ci-dessous :

{ "requests": [ { "image": { "source": { "imageUri": "IMAGE_URL" } }, "features": [ { "type": "DOCUMENT_TEXT_DETECTION" } ], "imageContext": { "languageHints": ["en-t-i0-handwrit"] } } ] }

Stockage multirégional

Vous pouvez désormais spécifier le stockage de données et le traitement OCR au niveau du continent. Les régions actuellement compatibles sont les suivantes :

us: pays des États-Unis uniquementeu: Union européenne

Emplacements

Cloud Vision vous permet de contrôler où les ressources de votre projet sont stockées et traitées. Vous pouvez notamment configurer Cloud Vision pour stocker vos données et ne procéder à leur traitement que dans l'Union européenne.

Dans Cloud Vision, les ressources sont stockées et traitées par défaut dans un emplacement global. Le maintien de vos ressources dans un emplacement ou une région spécifique n'est donc pas garanti. Pour que Google ne stocke et traite vos données que dans l'Union européenne, vous devez sélectionner la région Union européenne. Vous et vos utilisateurs pouvez accéder aux données depuis n'importe quel emplacement.

Définir l'emplacement à l'aide de l'API

L'API Vision accepte un point de terminaison global d'API (vision.googleapis.com), ainsi que deux points de terminaison régionaux : un point de terminaison en Union européenne (eu-vision.googleapis.com) et un point de terminaison aux États-Unis (us-vision.googleapis.com). Utilisez ces points de terminaison pour un traitement spécifique à la région. Par exemple, pour stocker et traiter vos données dans l'Union européenne uniquement, utilisez l'URI eu-vision.googleapis.com à la place de vision.googleapis.com pour vos appels d'API REST :

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/images:annotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/images:asyncBatchAnnotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/files:annotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/files:asyncBatchAnnotate

Pour stocker et traiter vos données aux États-Unis uniquement, utilisez le point de terminaison US (us-vision.googleapis.com) avec les méthodes précédentes.

Définir l'emplacement à l'aide des bibliothèques clientes

Par défaut, les bibliothèques clientes de l'API Vision accèdent au point de terminaison global de l'API (vision.googleapis.com). Pour ne stocker et traiter vos données qu'en Union européenne, vous devez définir explicitement le point de terminaison (eu-vision.googleapis.com). Les exemples de code ci-dessous indiquent comment configurer ce paramètre.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- REGION_ID : l'un des identifiants de zone géographique valides :

us: pays des États-Unis uniquementeu: Union européenne

- CLOUD_STORAGE_IMAGE_URI : chemin d'accès à un fichier image valide dans un bucket Cloud Storage. Il faut au minimum disposer des droits en lecture sur le fichier.

Exemple :

gs://cloud-samples-data/vision/handwriting_image.png

- PROJECT_ID : ID de votre projet Google Cloud .

Méthode HTTP et URL :

POST https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/images:annotate

Corps JSON de la requête :

{

"requests": [

{

"image": {

"source": {

"imageUri": "CLOUD_STORAGE_IMAGE_URI"

}

},

"features": [

{

"type": "DOCUMENT_TEXT_DETECTION"

}

]

}

]

}

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/images:annotate"

PowerShell

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/images:annotate" | Select-Object -Expand Content

Si la requête aboutit, le serveur affiche un code d'état HTTP 200 OK et la réponse au format JSON.

Go

Avant d'essayer cet exemple, suivez les instructions de configuration pour Go décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Go.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Java.

Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Node.js.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Cloud Vision en langage Python.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Essayer

Essayez la détection de texte et la détection de document texte dans l'outil suivant. Vous pouvez utiliser l'image déjà spécifiée (gs://cloud-samples-data/vision/handwriting_image.png) en cliquant sur Exécuter, ou spécifier votre propre image à la place.

Corps de la requête :

{

"requests": [

{

"features": [

{

"type": "DOCUMENT_TEXT_DETECTION"

}

],

"image": {

"source": {

"imageUri": "gs://cloud-samples-data/vision/handwriting_image.png"

}

}

}

]

}