Setelah melatih model, AutoML Vision menggunakan item dari set TEST untuk mengevaluasi kualitas dan akurasi model baru.

Ringkasan evaluasi

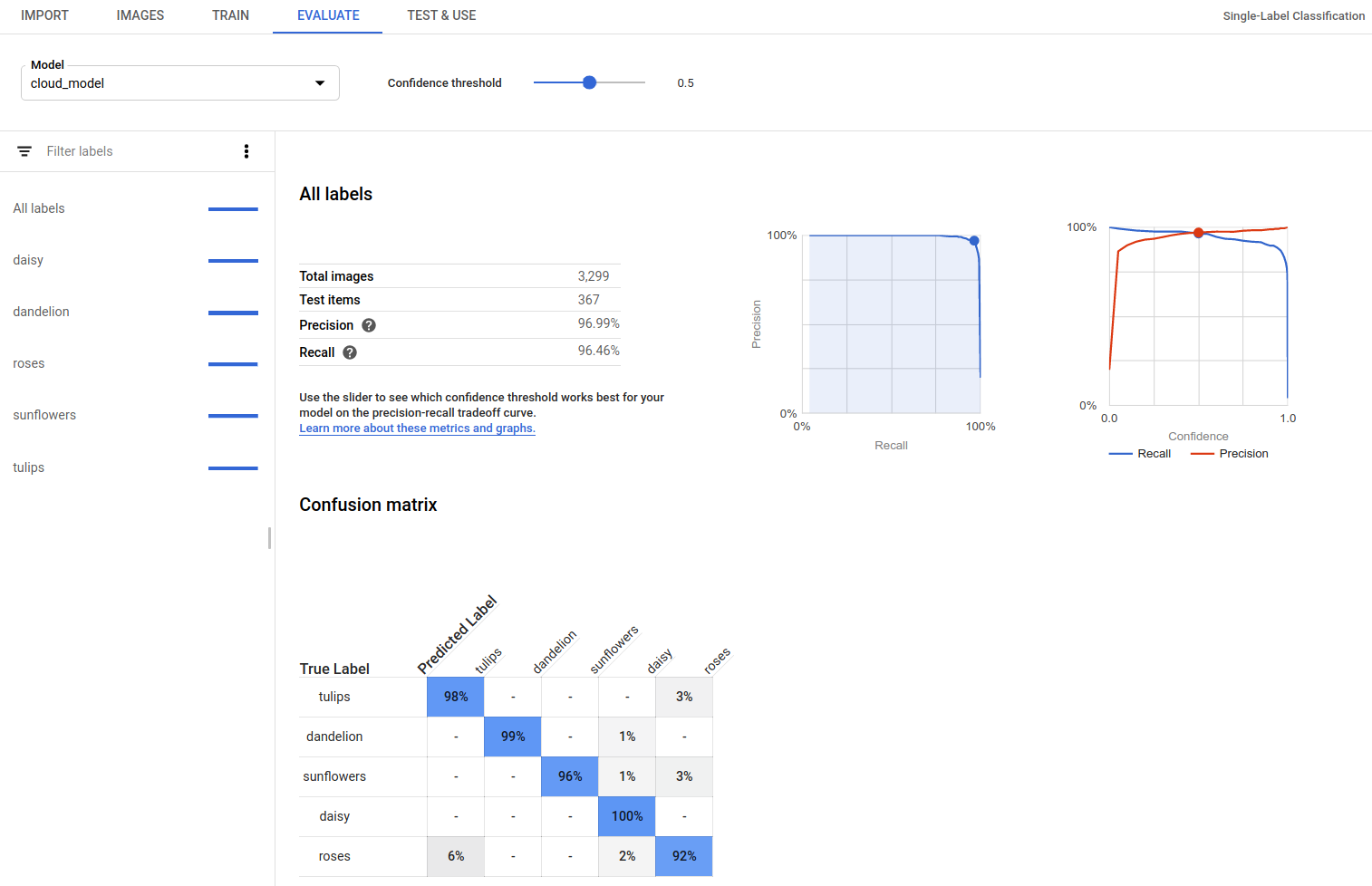

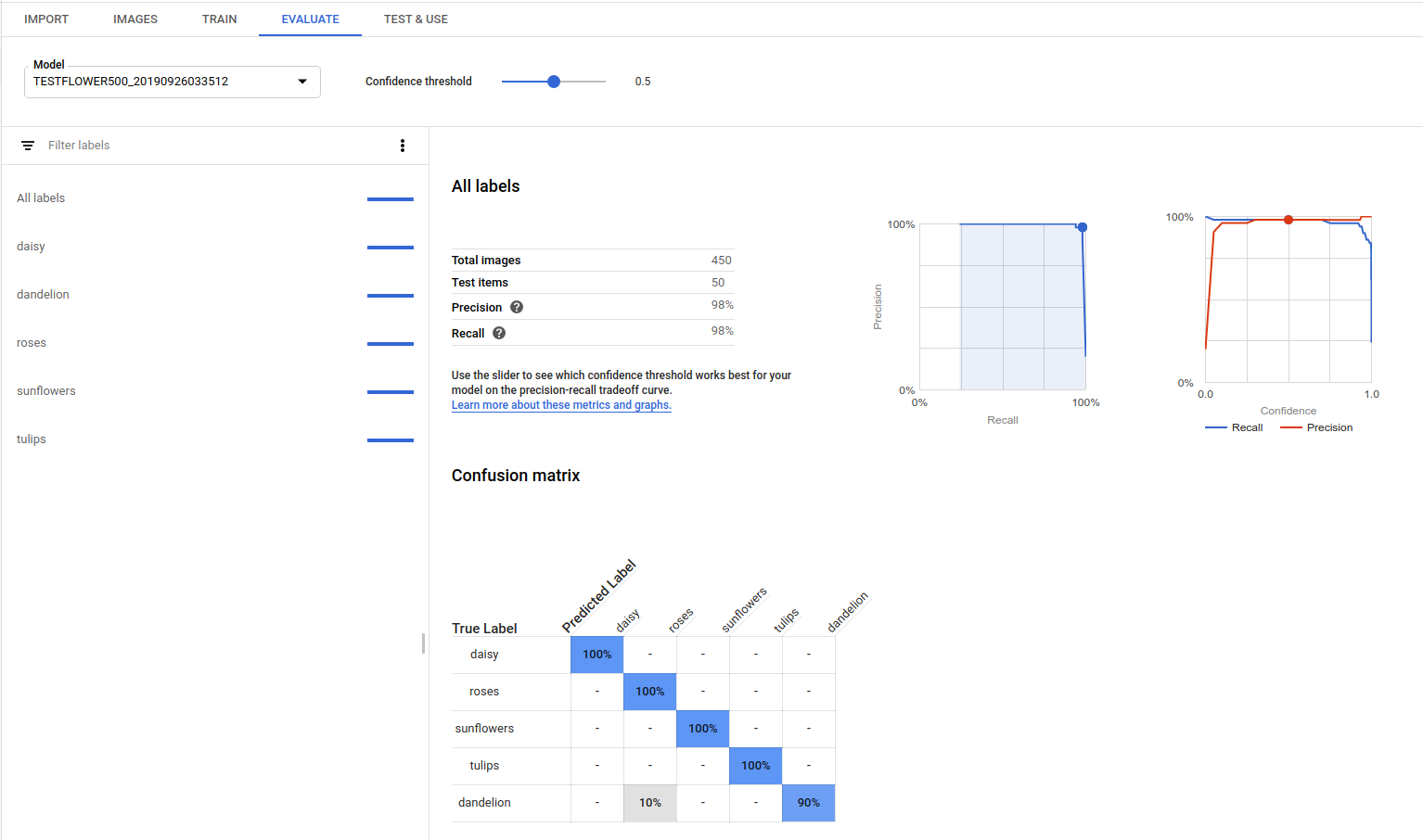

AutoML Vision menyediakan kumpulan metrik evaluasi gabungan yang menunjukkan performa model secara keseluruhan, serta metrik evaluasi untuk setiap label kategori, yang menunjukkan performa model untuk label tersebut.

AuPRC : Area di bawah kurva Presisi/Perolehan, juga disebut sebagai "presisi rata-rata". Umumnya antara 0,5 dan 1,0. Nilai yang lebih tinggi menunjukkan model yang lebih akurat.

Kurva nilai minimum keyakinan menunjukkan pengaruh nilai minimum keyakinan yang berbeda terhadap rasio positif palsu, perolehan, dan presisi. Baca hubungan presisi dan perolehan.

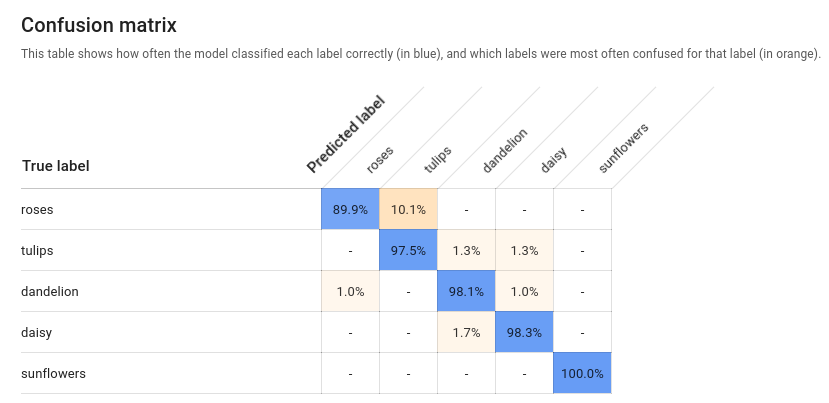

Matriks konfusi: Hanya ada untuk model label tunggal per gambar. Merepresentasikan persentase frekuensi setiap label diprediksi untuk setiap label dalam set pelatihan selama evaluasi.

Idealnya, label

onehanya akan ditetapkan ke gambar yang diklasifikasikan sebagai labelone, dll. sehingga matriks yang sempurna akan terlihat seperti:100 0 0 0 0 100 0 0 0 0 100 0 0 0 0 100Pada contoh di atas, jika gambar diklasifikasikan sebagai

onetetapi model memprediksitwo, baris pertama akan terlihat seperti ini:99 1 0 0Informasi selengkapnya dapat ditemukan dengan menelusuri 'confusion matrix machine learning'.

AutoML Vision membuat matriks kebingungan hingga 10 label. Jika Anda memiliki lebih dari 10 label, matriks akan menyertakan 10 label yang paling membingungkan (prediksi yang salah).

Gunakan data ini untuk mengevaluasi kesiapan model Anda. Kebingungan yang tinggi, skor AUC yang rendah, atau skor presisi dan perolehan yang rendah dapat menunjukkan bahwa model Anda memerlukan data pelatihan tambahan atau memiliki label yang tidak konsisten. Skor ABK yang sangat tinggi serta presisi dan perolehan yang sempurna dapat menunjukkan bahwa data terlalu mudah dan mungkin tidak digeneralisasi dengan baik.

Membuat daftar evaluasi model

Setelah melatih model, Anda dapat mencantumkan metrik evaluasi untuk model tersebut.

UI Web

Buka AutoML Vision UI dan klik tab Models (dengan ikon bohlam) di menu navigasi sebelah kiri untuk menampilkan model yang tersedia.

Untuk melihat model project yang berbeda, pilih project dari menu drop-down di kanan atas panel judul.

Klik baris untuk model yang ingin dievaluasi.

Jika perlu, klik tab Evaluasi tepat di bawah panel judul.

Jika pelatihan untuk model telah selesai, AutoML Vision akan menampilkan metrik evaluasinya.

REST

Sebelum menggunakan salah satu data permintaan, lakukan penggantian berikut:

- project-id: Project ID GCP Anda.

- model-id: ID model Anda, dari

respons saat membuat model. ID adalah elemen terakhir dari nama model Anda.

Misalnya:

- nama model:

projects/project-id/locations/location-id/models/IOD4412217016962778756 - id model:

IOD4412217016962778756

- nama model:

- model-evaluation-id: nilai ID evaluasi

dari model. Anda dapat mendapatkan ID evaluasi model dari operasi evaluasi model

list.

Metode HTTP dan URL:

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID

Untuk mengirim permintaan Anda, pilih salah satu opsi berikut:

curl

Jalankan perintah berikut:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID"

PowerShell

Jalankan perintah berikut:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID" | Select-Object -Expand Content

Anda akan menerima respons JSON yang mirip dengan contoh berikut. Kolom khusus deteksi objek utama

dicetak tebal, dan versi entri classificationEvaluationMetrics

yang disingkat ditampilkan agar lebih jelas:

Go

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Java

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Node.js

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Python

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Bahasa tambahan

C# : Ikuti Petunjuk penyiapan C# di halaman library klien, lalu kunjungi dokumentasi referensi AutoML Vision untuk .NET.

PHP : Ikuti Petunjuk penyiapan PHP di halaman library klien, lalu kunjungi dokumentasi referensi AutoML Vision untuk PHP.

Ruby: Ikuti Petunjuk persiapan Ruby di halaman library klien, lalu kunjungi Dokumentasi referensi AutoML Vision untuk Ruby.

Mendapatkan nilai evaluasi model

Anda juga bisa mendapatkan evaluasi model tertentu untuk label (displayName) menggunakan

ID evaluasi. Untuk mendapatkan ID evaluasi model, jalankan fungsi evaluasi

model daftar yang ditampilkan dalam Evaluasi model daftar.

UI web

Buka Vision Dashboard dan klik ikon bola lampu di menu navigasi kiri untuk menampilkan model yang tersedia.

Untuk melihat model project yang berbeda, pilih project dari menu drop-down di kanan atas panel judul.

Klik baris untuk model yang ingin dievaluasi.

Jika perlu, klik tab Evaluasi tepat di bawah panel judul.

Jika pelatihan untuk model telah selesai, AutoML Vision akan menampilkan metrik evaluasinya.

Untuk melihat metrik untuk label tertentu, pilih nama label dari daftar label di bagian bawah halaman.

REST

Untuk mendapatkan metrik evaluasi untuk label tertentu saja, tambahkan

/{MODEL_EVALUATION_ID} ke permintaan di atas dari

respons.

Misalnya, Anda dapat menemukan ID evaluasi model untuk rose label

(displayName) dalam nama evaluasi yang ditampilkan dari operasi

daftar:

"name": "projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/858136867710915695"

Sebelum menggunakan salah satu data permintaan, buat pengganti berikut:

- project-id: Project ID GCP Anda.

- model-id: ID model Anda, dari

respons saat membuat model. ID adalah elemen terakhir dari nama model Anda.

Misalnya:

- nama model:

projects/project-id/locations/location-id/models/IOD4412217016962778756 - id model:

IOD4412217016962778756

- nama model:

- model-evaluation-id: nilai ID evaluasi

dari model. Anda dapat mendapatkan ID evaluasi model dari operasi evaluasi model

list.

Metode HTTP dan URL:

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID

Untuk mengirim permintaan Anda, pilih salah satu opsi berikut:

curl

Jalankan perintah berikut:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID"

PowerShell

Jalankan perintah berikut:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID" | Select-Object -Expand Content

Anda akan menerima respons JSON yang mirip dengan yang berikut ini:

Go

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Java

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Node.js

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Python

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

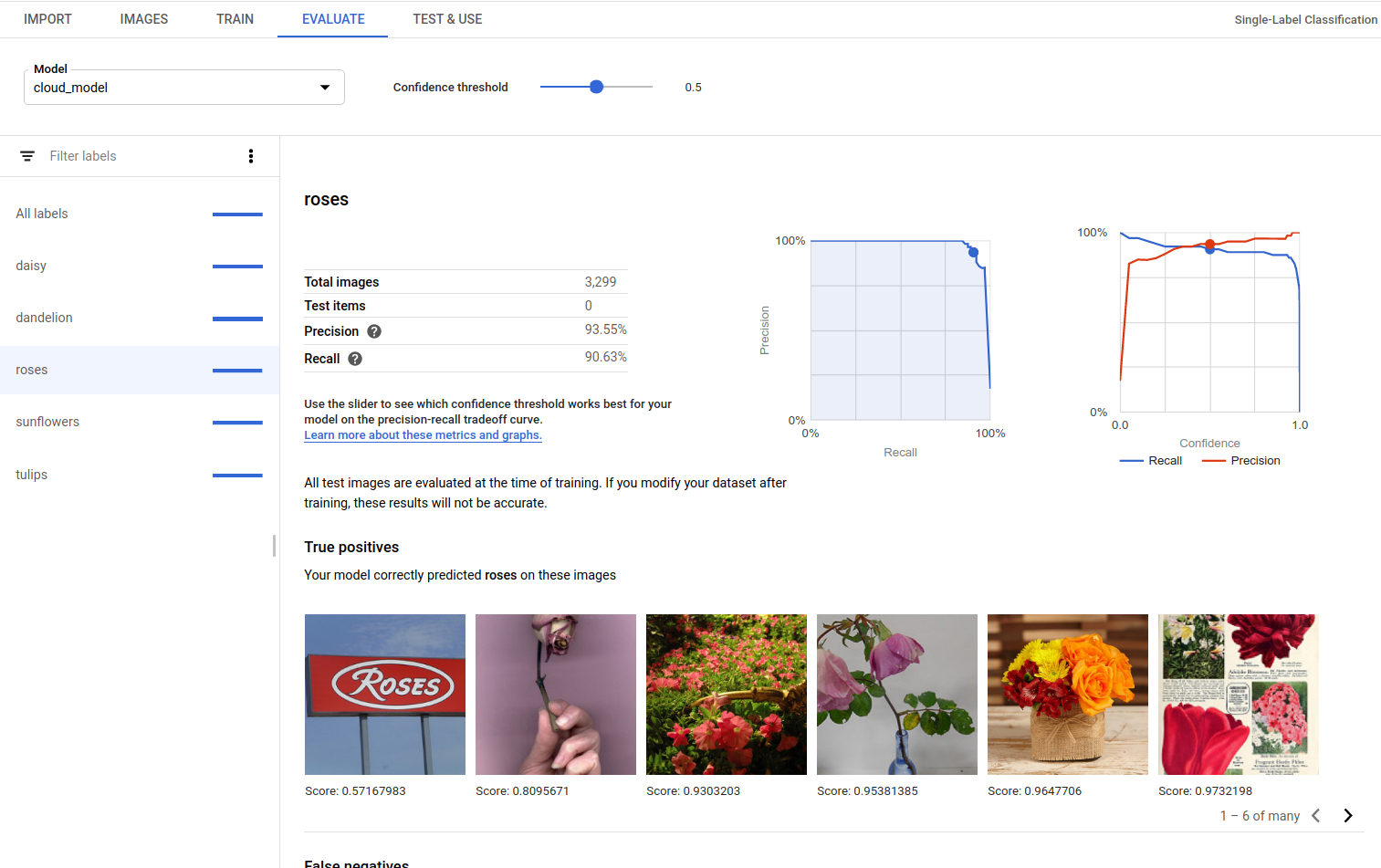

Positif Benar, Negatif Palsu, dan Positif Palsu (khusus UI)

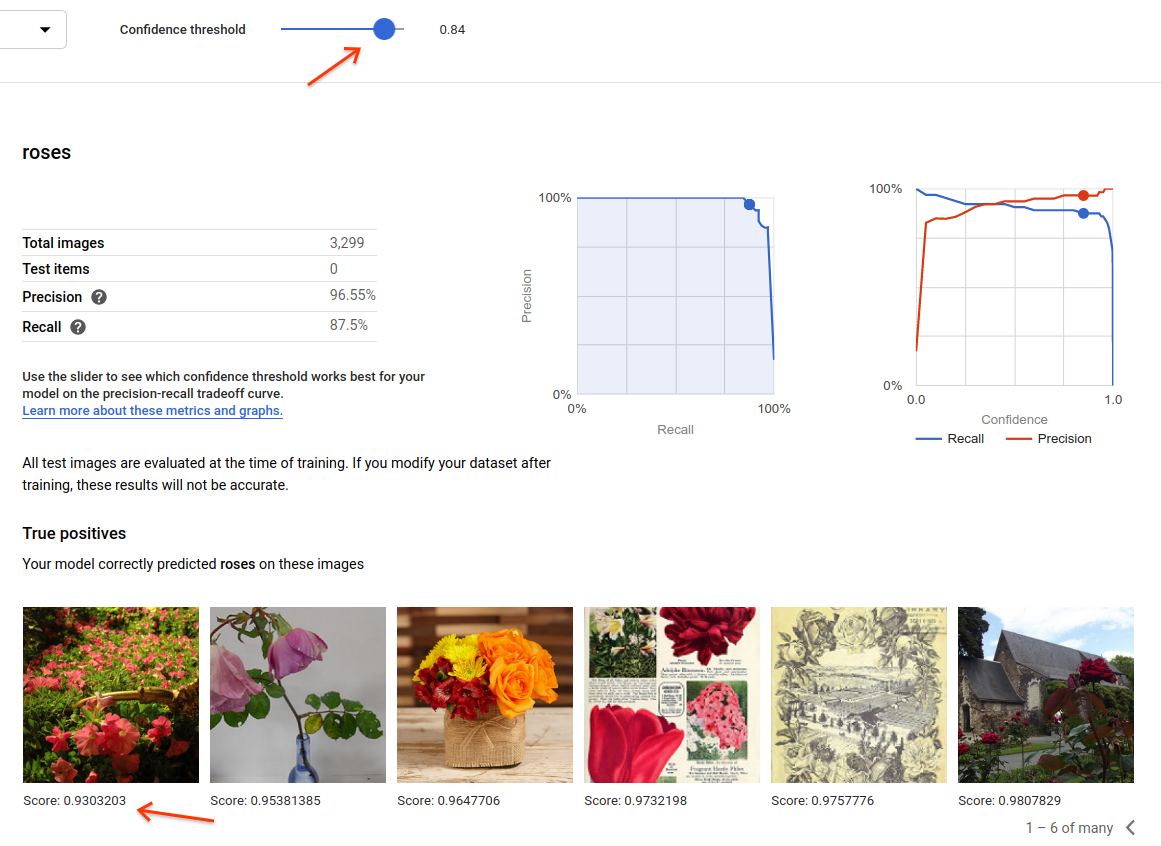

Di antarmuka pengguna, Anda dapat mengamati contoh spesifik performa model, yaitu positif benar (TP), negatif palsu (FN), dan positif palsu (PP) dari set PELATIHAN dan VALIDATION.

UI web

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan untuk bahasa ini di halaman Library Klien.

Anda dapat mengakses tampilan TP, FN, dan FP di UI dengan memilih tab Evaluate, lalu memilih label tertentu.

Dengan melihat tren dalam prediksi ini, Anda dapat mengubah set pelatihan untuk meningkatkan performa model.

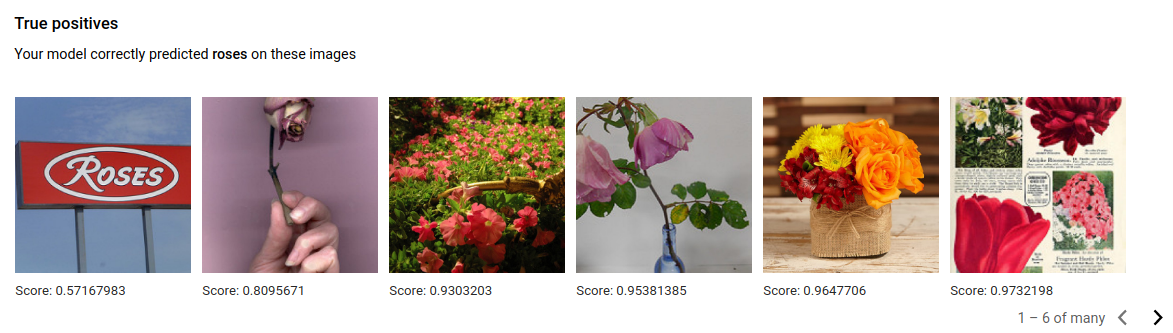

Gambar positif benar (true) adalah gambar contoh yang diberikan untuk model terlatih yang dianotasi dengan benar oleh model:

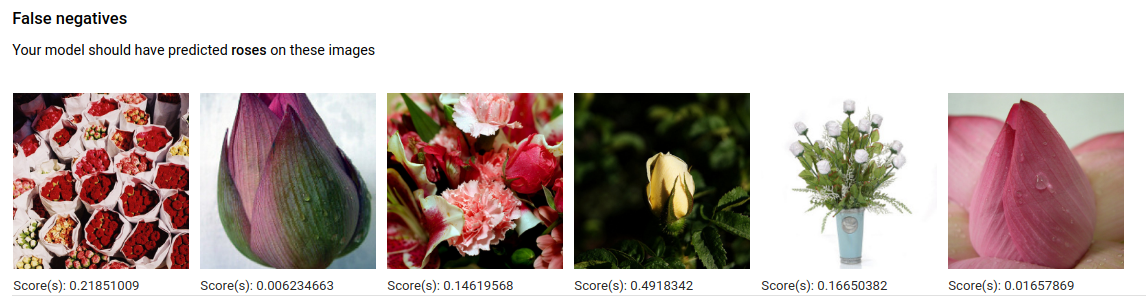

Gambar negatif palsu serupa disediakan dengan model yang dilatih, tetapi model gagal menganotasi gambar dengan benar untuk label tertentu:

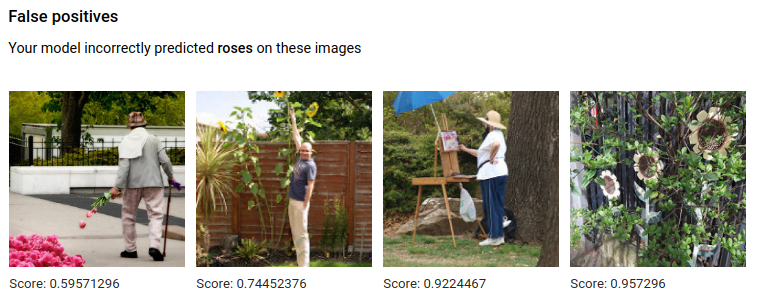

Terakhir, gambar positif palsu adalah gambar yang diberikan ke model terlatih yang dianotasi dengan label tertentu, tetapi seharusnya tidak telah dianotasi:

Model sedang memilih corner case yang menarik, yang menghadirkan peluang untuk mempertajam definisi dan label Anda guna membantu model memahami interpretasi label Anda. Misalnya, definisi yang lebih ketat akan membantu model memahami apakah Anda mempertimbangkan lukisan abstrak mawar sebagai "mawar" (atau tidak).

Dengan label berulang, latih, dan evaluasi loop, model Anda akan memunculkan ambiguitas lainnya di data Anda.

Anda juga dapat menyesuaikan nilai minimum skor dalam tampilan ini di antarmuka pengguna, dan gambar TP, FN, dan FP yang ditampilkan akan mencerminkan perubahan nilai minimum:

Melakukan Iterasi pada model Anda

Jika tidak puas dengan tingkat kualitas tersebut, Anda dapat kembali ke langkah-langkah sebelumnya untuk meningkatkan kualitasnya:

- Dengan AutoML Vision, Anda dapat mengurutkan gambar berdasarkan seberapa “bingung” model tersebut, berdasarkan label sebenarnya dan label prediksinya. Lihatlah gambar-gambar tersebut dan pastikan gambar-gambar tersebut diberi label dengan benar.

- Pertimbangkan untuk menambahkan lebih banyak gambar ke label apa pun yang berkualitas rendah.

- Anda mungkin perlu menambahkan berbagai jenis gambar (misalnya sudut yang lebih lebar, resolusi lebih tinggi atau lebih rendah, sudut pandang yang berbeda).

- Pertimbangkan untuk menghapus label sekaligus jika Anda tidak memiliki cukup gambar pelatihan.

- Ingat bahwa mesin tidak bisa membaca nama label Anda; itu hanya rangkaian huruf acak untuk mereka. Jika Anda memiliki satu label yang bertuliskan "door" dan label lainnya yang bertuliskan "door_with_knob", mesin tidak akan dapat mengetahui nuansa selain gambar yang Anda berikan.

- Tingkatkan data Anda dengan lebih banyak contoh positif dan negatif benar. Contoh yang sangat penting adalah contoh yang mendekati batas keputusan (misalnya kemungkinan akan menimbulkan kebingungan, tetapi masih diberi label dengan benar).

- Tentukan bagian LAT, TEST, VALIDATION Anda sendiri. Alat ini menetapkan gambar secara acak, tetapi gambar yang hampir duplikat dapat berakhir pada LATIHAN dan VALIDASI yang dapat menyebabkan overload dan kemudian performa yang buruk pada set PENGUJI.

Setelah membuat perubahan, latih dan evaluasi model baru sampai Anda mencapai tingkat kualitas yang cukup tinggi.