Um projeto pode ter vários conjuntos de dados, cada um usado para treinar um modelo separado. É possível ver uma lista dos conjuntos de dados disponíveis, ver um conjunto de dados específico, exportar um conjunto de dados e excluir um conjunto de dados que você não precisa mais.

Como listar conjuntos de dados

Esta seção descreve como recuperar uma lista dos conjuntos de dados disponíveis para um projeto.

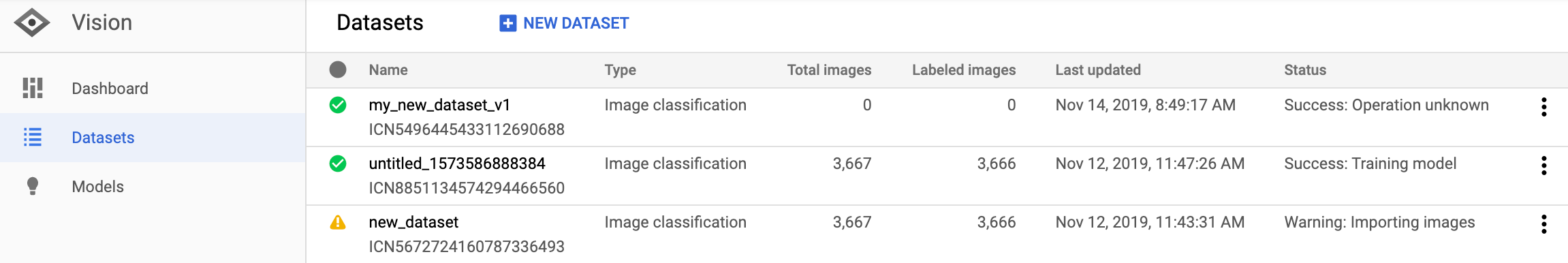

IU da Web

Para ver uma lista dos conjuntos de dados disponíveis usando Vision Dashboard, clique no link Conjuntos de dados na parte superior do menu de navegação esquerdo.

Para ver os conjuntos de dados de um projeto diferente, selecione o projeto na lista suspensa no canto superior direito da barra de título.

REST

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- project-id: o ID do projeto do GCP.

Método HTTP e URL:

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets

Para enviar a solicitação, escolha uma destas opções:

curl

execute o seguinte comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets"

PowerShell

execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets" | Select-Object -Expand Content

Você receberá uma resposta JSON semelhante a esta:

{

"datasets": [

{

"name": "projects/project-id/locations/us-central1/datasets/dataset-id",

"displayName": "my_new_dataset",

"createTime": "2019-10-29T17:31:12.010290Z",

"etag": "AB3BwFpNUaguCwKeQWtUKLBPQhZr7omCCUBz77pACPIINFpyFe7vbGhp9oZLEEGhIeM=",

"exampleCount": 3667,

"imageClassificationDatasetMetadata": {

"classificationType": "MULTICLASS"

}

},

{

"name": "projects/project-id/locations/us-central1/datasets/dataset-id",

"displayName": "new_dataset",

"createTime": "2019-10-02T00:44:57.821275Z",

"etag": "AB3BwFpU_ueMZtTD_8dt-9r8BWqunqMC76YbAbmQYQsQEbtQTxs6U3rPpgAMDCXhYPGq",

"imageClassificationDatasetMetadata": {

"classificationType": "MULTICLASS"

}

}

]

}

Go

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Java

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Node.js

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Python

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Outras linguagens

C#: Siga as Instruções de configuração do C# na página das bibliotecas de cliente e acesse a Documentação de referência do AutoML Vision para .NET.

PHP: Siga as Instruções de configuração do PHP na página das bibliotecas de cliente e acesse a Documentação de referência do AutoML Vision para PHP.

Ruby Siga estas instruções:Instruções de configuração do Ruby na página das bibliotecas de cliente e, em seguida, visite oDocumentação de referência do AutoML Vision para Ruby.

Receber um conjunto de dados

Também é possível receber um conjunto de dados específico usando um ID desse conjunto.

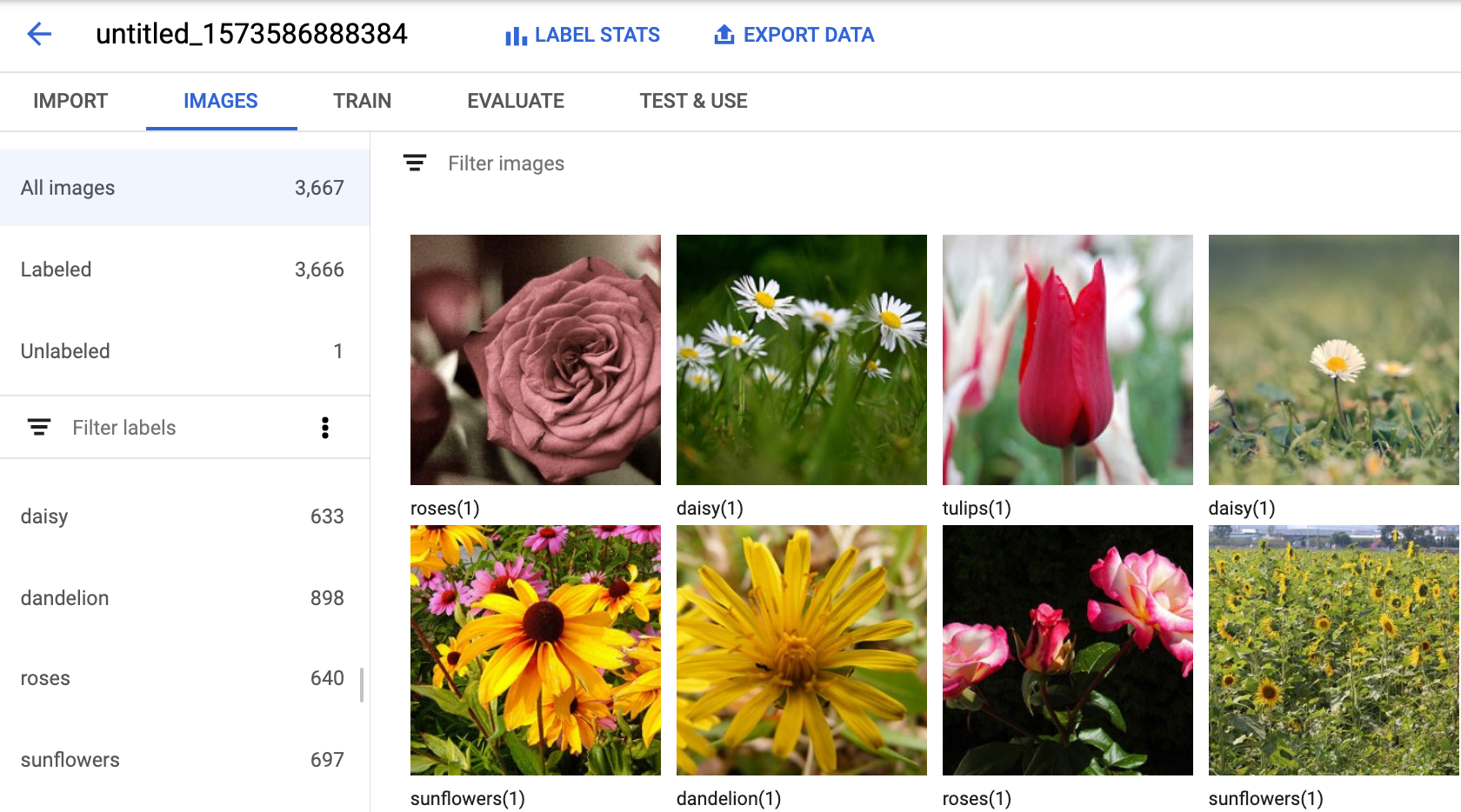

IU da Web

Para ver uma lista dos conjuntos de dados disponíveis usando a IU do AutoML Vision, clique no link Conjuntos de dados na parte superior do menu de navegação esquerdo.

Para ver os conjuntos de dados de um projeto diferente, selecione o projeto na lista suspensa no lado esquerdo da barra de título.

Acesse um conjunto de dados específico selecionando o nome dele na lista.

REST

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- project-id: o ID do projeto do GCP.

- dataset-id: ID do conjunto de dados. O ID é o último elemento do nome

do conjunto de dados. Por exemplo:

- nome do conjunto de dados:

projects/project-id/locations/location-id/datasets/3104518874390609379 - ID do conjunto de dados:

3104518874390609379

- nome do conjunto de dados:

Método HTTP e URL:

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID

Para enviar a solicitação, escolha uma destas opções:

curl

execute o seguinte comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID"

PowerShell

execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID" | Select-Object -Expand Content

Você receberá uma resposta JSON semelhante a esta:

{

"name": "projects/project-id/locations/us-central1/datasets/dataset-id",

"displayName": "display-name",

"createTime": "2019-10-29T17:31:12.010290Z",

"etag": "AB3BwFoP09ffuRNnaWMx4UGi8uvYFctvOBjns84OercuMRIdXr0YINNiUqeW85SB3g4=",

"exampleCount": 3667,

"imageClassificationDatasetMetadata": {

"classificationType": "MULTICLASS"

}

}

Go

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Java

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Node.js

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Python

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

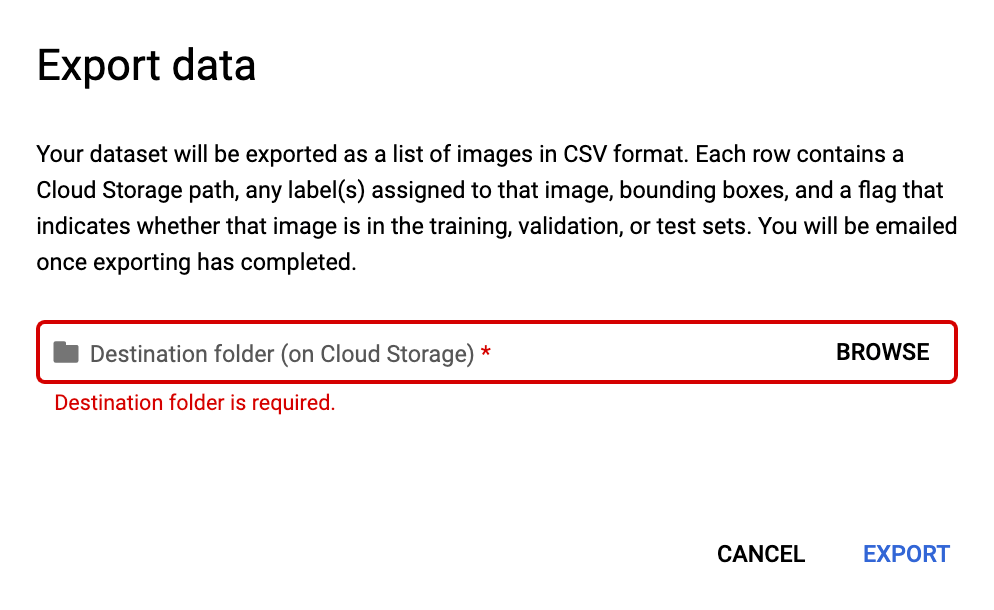

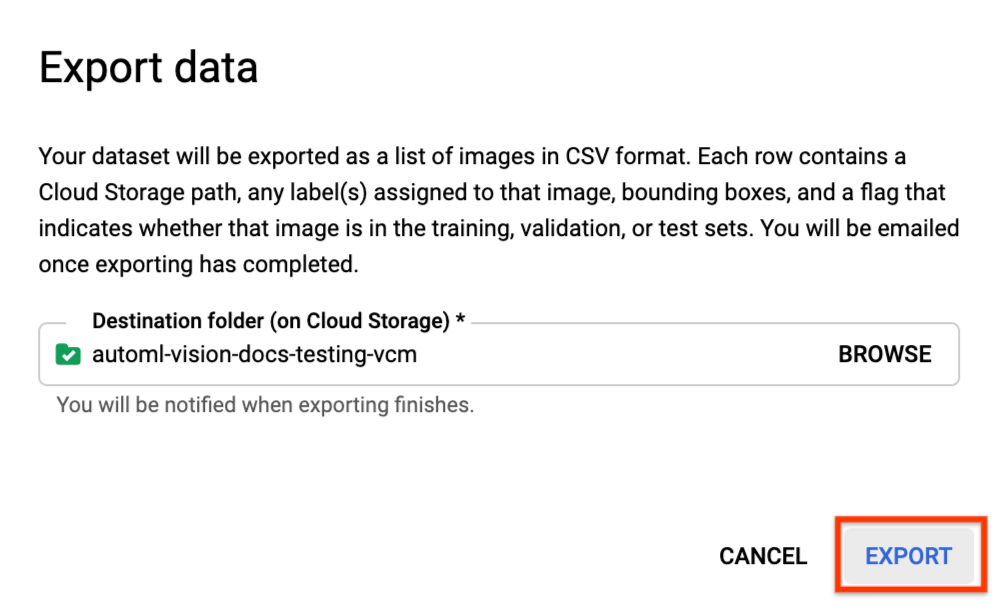

Exportar um conjunto de dados

É possível exportar um arquivo CSV com todas as informações de um conjunto de dados para um bucket do Google Cloud Storage.

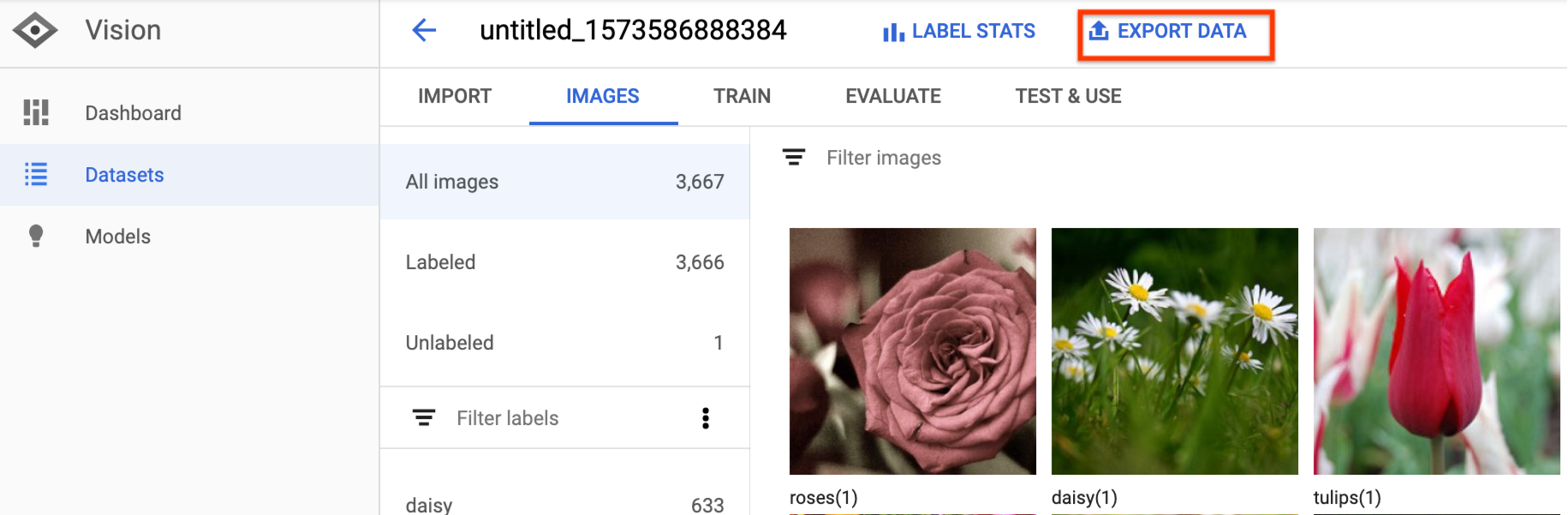

IU da Web

Para exportar um conjunto de dados que não está vazio, execute as seguintes etapas:

Selecione o conjunto de dados não vazio na página Conjuntos de dados.

A seleção do conjunto de dados não vazio levará você à página Detalhes do conjunto de dados.

Selecione a opção Exportar dados na parte superior da página de detalhes do conjunto de dados.

Isso abre uma janela em que é possível escolher um local do bucket do Google Cloud Storage ou criar um novo bucket e designá-lo como o local para armazenar o arquivo CSV.

Selecione Exportar CSV depois de selecionar um local de bucket novo ou atual do Google Cloud Storage.

Você receberá um e-mail quando o processo de exportação de dados for concluído.

REST

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- project-id: o ID do projeto do GCP.

- dataset-id: ID do conjunto de dados. O ID é o último elemento do nome

do conjunto de dados. Por exemplo:

- nome do conjunto de dados:

projects/project-id/locations/location-id/datasets/3104518874390609379 - ID do conjunto de dados:

3104518874390609379

- nome do conjunto de dados:

- output-storage-bucket: um bucket/diretório do Google Cloud Storage

em que os arquivos de saída serão salvos, expressos no seguinte formato:

gs://bucket/directory/. O usuário solicitante precisa ter permissão de gravação no bucket.

Método HTTP e URL:

POST https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID:exportData

Corpo JSON da solicitação:

{

"outputConfig": {

"gcsDestination": {

"outputUriPrefix": "CLOUD_STORAGE_BUCKET"

}

}

}

Para enviar a solicitação, escolha uma destas opções:

curl

Salve o corpo da solicitação em um arquivo com o nome request.json e execute o comando a seguir:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID:exportData"

PowerShell

Salve o corpo da solicitação em um arquivo com o nome request.json e execute o comando a seguir:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID:exportData" | Select-Object -Expand Content

Será exibido um código semelhante a este. É possível usar o ID da operação para saber o status da tarefa. Para um exemplo, consulte Como trabalhar com operações de longa duração.

{

"name": "projects/PROJECT_ID/locations/us-central1/operations/OPERATION_ID",

"metadata": {

"@type": "type.googleapis.com/google.cloud.automl.v1.OperationMetadata",

"createTime": "2019-08-12T18:52:31.637075Z",

"updateTime": "2019-08-12T18:52:31.637075Z",

"exportDataDetails": {

"outputInfo": {

"gcsOutputDirectory": "CLOUD_STORAGE_BUCKET/export_data-DATASET_NAME-TIMESTAMP_OF_EXPORT_CALL/"

}

}

}

}

Java

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Node.js

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Python

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Formato CSV exportado

O arquivo CSV exportado contém a mesma formatação que o CSV de importação de dados de treinamento:

set,path,label0[,label1,label2,...]

Esse arquivo CSV é salvo em uma pasta de exportação criada que se distingue por um carimbo de data/hora exclusivo. Veja a seguir algumas linhas de amostra de um arquivo CSV exportado:

my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/image_classification_1.csv:

TRAIN,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img874.jpg,dandelion VALIDATION,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img447.jpg,roses TRAIN,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img672.jpg,dandelion VALIDATION,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img421.jpg,sunflowers TRAIN,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img495.jpg,tulips TEST,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img014.jpg,sunflowers

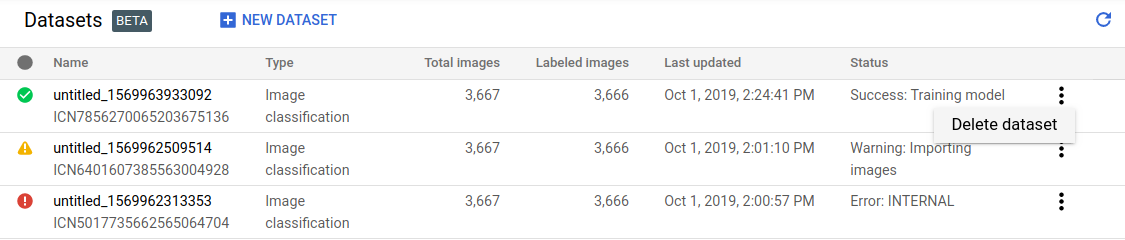

Como excluir um conjunto de dados

É possível excluir um conjunto de dados que você não precisa mais na interface do usuário ou com o ID desse conjunto usando os exemplos de código a seguir.

IU da Web

No Vision Dashboard, clique no link Conjuntos de dados na parte superior do menu de navegação esquerdo para exibir a lista de conjuntos de dados disponíveis.

Clique no menu de três pontos à extrema direita da linha que você quer excluir e selecione Excluir conjunto de dados.

Clique em Excluir na caixa de diálogo de confirmação.

REST

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- project-id: o ID do projeto do GCP.

- dataset-id: ID do conjunto de dados. O ID é o último elemento do nome

do conjunto de dados. Por exemplo:

- nome do conjunto de dados:

projects/project-id/locations/location-id/datasets/3104518874390609379 - ID do conjunto de dados:

3104518874390609379

- nome do conjunto de dados:

Método HTTP e URL:

DELETE https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID

Para enviar a solicitação, escolha uma destas opções:

curl

execute o seguinte comando:

curl -X DELETE \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID"

PowerShell

execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method DELETE `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID" | Select-Object -Expand Content

Será exibido um código semelhante a este. É possível usar o ID da operação para saber o status da tarefa. Para um exemplo, consulte Como trabalhar com operações de longa duração.

{

"name": "projects/PROJECT_ID/locations/us-central1/operations/OPERATION_ID",

"metadata": {

"@type": "type.googleapis.com/google.cloud.automl.v1.OperationMetadata",

"createTime": "2019-11-08T22:37:19.822128Z",

"updateTime": "2019-11-08T22:37:19.822128Z",

"deleteDetails": {}

},

"done": true,

"response": {

"@type": "type.googleapis.com/google.protobuf.Empty"

}

}

Go

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Java

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Node.js

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.

Python

Antes de testar esta amostra, siga as instruções de configuração dessa linguagem na página Bibliotecas de cliente.