Como avaliar modelos

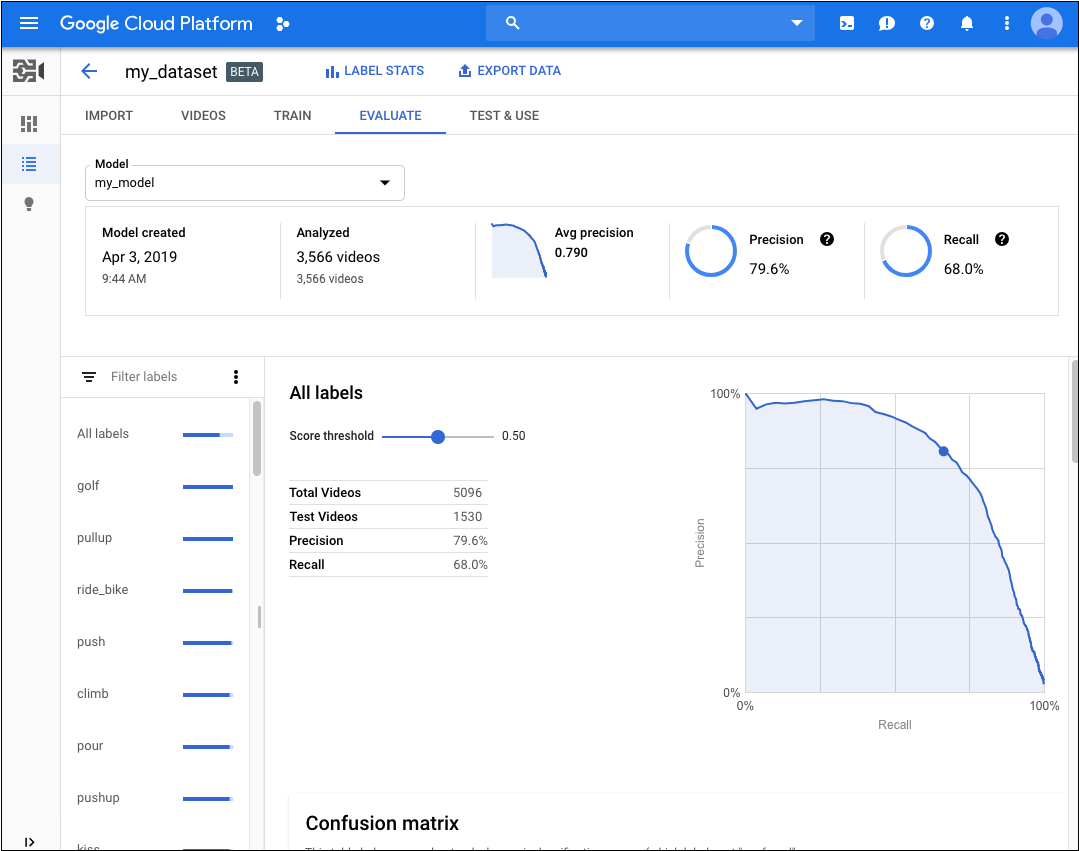

Depois de treinar um modelo, a classificação do AutoML Video Intelligence usa itens do conjunto TEST para avaliar a qualidade e a acurácia desse modelo.

Na classificação do AutoML Video Intelligence, há um conjunto agregado de métricas de avaliação que indicam o desempenho geral do modelo e outras para cada rótulo de categoria que especificam o desempenho do modelo para o rótulo.

AuPRC: área sob a curva de recall/precisão (em inglês), também conhecida como "precisão média". Normalmente entre 0,5 e 1. Valores mais altos indicam modelos mais precisos.

As curvas de limite de confiança mostram como diferentes limites de confiança afetam a precisão, o recall e as taxas de resultados verdadeiros e falsos positivos. Leia sobre o relacionamento de precisão e recall.

Use esses dados para avaliar a prontidão do seu modelo. Baixa pontuação de AUC ou baixas pontuações de precisão e recall podem indicar que o modelo precisa de dados de treinamento extras ou tem rótulos inconsistentes. Uma pontuação de AUC muito alta e precisão e recall perfeitos poderiam indicar que os dados são fáceis demais e têm pouca capacidade de generalização.

Conseguir valores de avaliação do modelo

IU da Web

-

Abra a página Modelos na IU do AutoML Video.

-

Clique na linha do modelo que você quer avaliar.

-

Clique na guia Avaliar.

Se o treinamento do modelo tiver sido concluído, o AutoML Video mostrará as métricas de avaliação.

- Para visualizar as métricas de um rótulo específico, selecione o nome dele na lista na parte inferior da página.

REST

Antes de usar os dados da solicitação, faça as substituições a seguir:

- model-name: o nome completo do modelo, com base na resposta de quando você o criou. O nome completo tem o formato: projects/project-number/locations/location-id/models/model-id

- project-number: o número do seu projeto

Método HTTP e URL:

GET https://automl.googleapis.com/v1beta1/model-name:modelEvaluations

Para enviar a solicitação, escolha uma destas opções:

curl

execute o seguinte comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-number" \

" https://automl.googleapis.com/v1beta1/model-name:modelEvaluations"

PowerShell

execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-number" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri " https://automl.googleapis.com/v1beta1/model-name:modelEvaluations" | Select-Object -Expand Content

2308399322008336298.

Java

Para autenticar no AutoML Video, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Node.js

Para autenticar no AutoML Video, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Python

Para autenticar no AutoML Video, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Iterar o modelo

Se você não estiver satisfeito com os níveis de qualidade, volte às etapas anteriores para melhorá-los:

- Talvez seja necessário adicionar diferentes tipos de vídeos (por exemplo, ângulo amplo, resolução maior ou menor, pontos de vista diferentes).

- Remova todos os rótulos se não houver vídeos de treinamento suficientes.

- Lembre-se de que a máquina não consegue ler o nome do rótulo. É apenas uma string aleatória de letras para ela. Se você tem um rótulo que diz "porta" e outro que diz "porta_com_maçaneta", a máquina não tem como descobrir a nuance além dos vídeos fornecidos.

- Aumente seus dados com mais exemplos de positivos e negativos verdadeiros. Exemplos especialmente importantes são aqueles que estão próximos da fronteira de decisão.

Depois de fazer as alterações, treine e avalie um novo modelo até atingir um nível de qualidade alto o suficiente.