LangChain in Vertex AI (Vorabversion) bietet den Vorteil, die LangChain-Open-Source-Bibliothek zum Erstellen benutzerdefinierter Generative AI-Anwendungen zu verwenden und Vertex AI für Modelle, Tools und Bereitstellung zu nutzen. Mit LangChain in Vertex AI (Vorabversion) können Sie die folgenden Schritte ausführen:

- Wählen Sie das Large Language Model (LLM) aus, mit dem Sie arbeiten möchten.

- Tools für den Zugriff auf externe APIs definieren.

- Strukturieren Sie die Schnittstelle zwischen dem Nutzer und den Systemkomponenten in einem Orchestrierungs-Framework.

- Framework für eine verwaltete Laufzeit bereitstellen.

Vorteile

- Anpassbar: Mit den standardisierten Schnittstellen von LangChain kann LangChain in Vertex AI zum Erstellen verschiedener Arten von Anwendungen verwendet werden. Sie können die Logik Ihrer Anwendung anpassen und ein beliebiges Framework einbinden, was ein hohes Maß an Flexibilität bietet.

- Vereinfachte Bereitstellung: LangChain in Vertex AI verwendet dieselben APIs wie LangChain, um mit LLMs zu interagieren und Anwendungen zu erstellen. LangChain in Vertex AI vereinfacht und beschleunigt die Bereitstellung mit Vertex AI LLMs, da die Reasoning Engine-Laufzeit die Bereitstellung mit einem Klick unterstützt, um eine konforme API basierend auf Ihrer Bibliothek zu generieren.

- Einbindung in Vertex AI-Umgebungen: Reasoning Engine für LangChain in Vertex AI verwendet die Infrastruktur und die vordefinierten Container von Vertex AI, um Sie bei der Bereitstellung Ihrer LLM-Anwendung zu unterstützen. Sie können die Vertex AI API für die Einbindung in Gemini-Modelle, Funktionsaufrufe und Erweiterungen verwenden.

- Sicher, privat und skalierbar: Sie können einen einzigen SDK-Aufruf verwenden, anstatt den Entwicklungsprozess selbst zu verwalten. Die verwaltete Reasoning Engine-Laufzeit nimmt Ihnen Aufgaben wie die Anwendungsserverentwicklung, die Containererstellung und die Konfiguration der Authentifizierung, IAM und Skalierung ab. Vertex AI kümmert sich um Autoscaling, regionale Erweiterung und Container-Sicherheitslücken.

Anwendungsfälle

Sie können LangChain in Vertex AI für die folgenden Aufgaben verwenden:

| Anwendungsfall | Beispielbeschreibung | Beispiellink |

|---|---|---|

| Entitäten aus Geschichten in natürlicher Sprache extrahieren | Extrahiert Listen von Figuren, Beziehungen, Dingen und Orten aus einer Geschichte. | Vertex AI SDK für Python-Notebook – Extraktion strukturierter Daten mit Funktionsaufrufen |

| SQL-Datenbanken mit natürlicher Sprache abfragen und verstehen | Bitten Sie das Modell, Fragen wie „Wie viel Prozent der Bestellungen werden zurückgegeben?“ in SQL-Abfragen umzuwandeln und Funktionen zu erstellen, die diese Abfragen an BigQuery senden. | Blogpost: AI-gestützte Anwendung zur BigQuery-Datenexploration mit Funktionsaufrufen in Gemini erstellen |

| Kundeninteraktionen mit Unternehmen unterstützen | Funktionen erstellen, die eine Verbindung zur API eines Unternehmens herstellen, damit das Modell genaue Antworten auf Anfragen wie „Haben Sie das Pixel 8 Pro auf Lager?“ oder "Gibt es ein Geschäft in Mountain View, Kalifornien, das ich besuchen kann, um es auszuprobieren?" | Vertex AI SDK für Python-Notebook – Funktionsaufrufe mit der Vertex AI Gemini API und Python SDK |

| Generative KI-Anwendungen durch Verbindung zu öffentlichen APIs erstellen | Währungen umrechnen. Erstellen Sie eine Funktion, die eine Verbindung zu einer Währungsaustauschanwendung herstellt, damit das Modell korrekte Antworten auf Anfragen wie „Wie hoch ist der Wechselkurs von Euro zu Dollar heute?“ liefert. |

Codelab – Interaktion mit APIs über Funktionsaufrufe in Gemini |

| Rufen Sie das Wetter für einen bestimmten Ort ab. Erstellen Sie eine Funktion, die eine Verbindung zu einer API eines meteorologischen Dienstes herstellt, damit das Modell korrekte Antworten auf Anfragen wie „Wie ist das Wetter in Paris?“ liefern kann. |

Vertex AI SDK für Python-Notebook – Funktionsaufrufe mit der Vertex AI Gemini API und Python SDK Blogpost – Funktionsaufrufe: Ein Framework zum Verbinden von Gemini mit externen Systemen, Daten und APIs |

|

| Eine Adresse in Breiten- und Längenkoordinaten umwandeln. Erstellt eine Funktion, die strukturierte Standortdaten in Breiten- und Längenkoordinaten konvertiert. Bitten Sie das Modell, die Adresse, die Stadt, den Bundesstaat und die Postleitzahl in Abfragen wie „Ich möchte die Breiten-/Längengradkoordinaten für die folgende Adresse abrufen: 1600 Amphitheatre Pkwy, Mountain View, CA 94043, USA“ zu identifizieren. |

Vertex AI SDK für Python-Notebook – Funktionsaufrufe mit der Vertex AI Gemini API und Python SDK | |

| Sprachbefehle interpretieren | Erstellen Sie Funktionen, die fahrzeuginternen Aufgaben entsprechen. Sie können beispielsweise Funktionen erstellen, die das Radio einschalten oder die Klimaanlage aktivieren. Senden Sie Audiodateien mit den Sprachbefehlen des Nutzers an das Modell und bitten Sie es, die Audiodaten in Text umzuwandeln und die Funktion zu identifizieren, die der Nutzer aufrufen möchte. | |

| Workflows auf der Grundlage von Umgebungstriggern automatisieren | Funktionen zur Darstellung von Prozessen erstellen, die automatisiert werden können. Stellen Sie dem Modell Daten von Umgebungssensoren bereit und bitten Sie es, die Daten zu parsen und zu verarbeiten, um festzustellen, ob einer oder mehrere Workflows aktiviert werden sollen. Ein Modell könnte zum Beispiel Temperaturdaten in einem Lager verarbeiten und eine Sprinklerfunktion aktivieren. | |

| Zuweisung von Support-Tickets automatisieren | Stellen Sie dem Modell Support-Tickets, Logs und kontextsensitive Regeln bereit. Bitten Sie das Modell, alle diese Informationen zu verarbeiten, um zu bestimmen, wem das Ticket zugewiesen werden soll. Rufen Sie eine Funktion auf, um das Ticket der vom Modell vorgeschlagenen Person zuzuweisen. | |

| Informationen aus einer Wissensdatenbank abrufen | Erstellen Sie Funktionen, mit denen wissenschaftliche Artikel zu einem bestimmten Thema abgerufen und zusammengefasst werden können. Befähigen Sie das Modell, Fragen zu akademischen Themen zu beantworten und die Antworten mit Zitaten zu versehen. |

Systemkomponenten

Die Erstellung und Bereitstellung einer benutzerdefinierten Generative AI-Anwendung mit OSS LangChain und Vertex AI besteht aus vier Komponenten:

| Komponente | Beschreibung |

|---|---|

| LLM |

Wenn Sie eine Abfrage an Ihre benutzerdefinierte Anwendung senden, verarbeitet das LLM die Abfrage und stellt eine Antwort bereit. Sie können eine Reihe von Tools definieren, die mit externen APIs kommunizieren, und diese dem Modell zur Verfügung stellen. Bei der Verarbeitung einer Abfrage delegiert das Modell bestimmte Aufgaben an die Tools. Dies impliziert einen oder mehrere Modellaufrufe für Grundlagenmodelle oder optimierte Modelle. Weitere Informationen finden Sie unter Modellversionen und Lebenszyklus. |

| Tool |

Sie können eine Reihe von Tools definieren, die mit externen APIs (z. B. einer Datenbank) kommunizieren, und diese dem Modell bereitstellen. Während der Verarbeitung einer Abfrage kann das Modell bestimmte Aufgaben an die Tools delegieren. Die Bereitstellung über die verwaltete Laufzeit von Vertex AI ist für die Verwendung von Tools optimiert, die auf Gemini-Funktionsaufrufen basieren, unterstützt aber auch LangChain-Tool-/Funktionsaufrufe. Weitere Informationen zu Gemini-Funktionsaufrufen finden Sie unter Funktionsaufrufe. |

| Framework für die Orchestrierung |

Mit LangChain in Vertex AI können Sie das LangChain-Orchestrierungs-Framework in Vertex AI nutzen. Entscheiden Sie mithilfe von LangChain, wie deterministisch Ihre Anwendung sein soll. Wenn Sie LangChain bereits verwenden, können Sie Ihren vorhandenen LangChain-Code verwenden, um Ihre Anwendung in Vertex AI bereitzustellen. Alternativ können Sie Ihren eigenen Anwendungscode erstellen und in einem Orchestrierungs-Framework strukturieren, das die LangChain-Vorlagen von Vertex AI nutzt. Weitere Informationen finden Sie unter Anwendung entwickeln. |

| Verwaltete Laufzeit | Mit LangChain in Vertex AI können Sie Ihre Anwendung in einer von Reasoning Engine verwalteten Laufzeit bereitstellen. Diese Laufzeit ist ein Vertex AI-Dienst, der alle Vorteile der Vertex AI-Einbindung bietet: Sicherheit, Datenschutz, Beobachtbarkeit und Skalierbarkeit. Mit einem einfachen API-Aufruf können Sie Ihre Anwendung für die Produktion und Skalierung erstellen und lokal getestete Prototypen schnell in unternehmensgerechte Bereitstellungen umwandeln. Weitere Informationen finden Sie unter Anwendung bereitstellen. |

Es gibt viele verschiedene Möglichkeiten, Prototypen zu erstellen und benutzerdefinierte generative KI-Anwendungen zu erstellen, die Agent-Funktionen nutzen können, indem Sie Tools und benutzerdefinierte Funktionen zusätzlich zu Modellen wie Gemini nutzen. Wenn es Zeit ist, Ihre Anwendung in die Produktion zu übergehen, müssen Sie überlegen, wie Sie den Agent und seine zugrunde liegenden Komponenten bereitstellen und verwalten.

Bei den Komponenten von LangChain in Vertex AI besteht das Ziel darin, Ihnen dabei zu helfen, sich auf die Aspekte der Agent-Funktionalität zu konzentrieren, die Ihnen am wichtigsten sind, z. B. benutzerdefinierte Funktionen, das Agent-Verhalten und die Modellparameter. Google kümmert sich um die Bereitstellung, die Skalierung der Paketerstellung, die Versionen usw. Wenn Sie auf einer niedrigeren Ebene im Stack arbeiten, müssen Sie möglicherweise mehr verwalten, als Sie möchten. Wenn Sie auf einer höheren Ebene im Stack arbeiten, haben Sie möglicherweise nicht so viel Entwicklerkontrolle, wie Sie möchten.

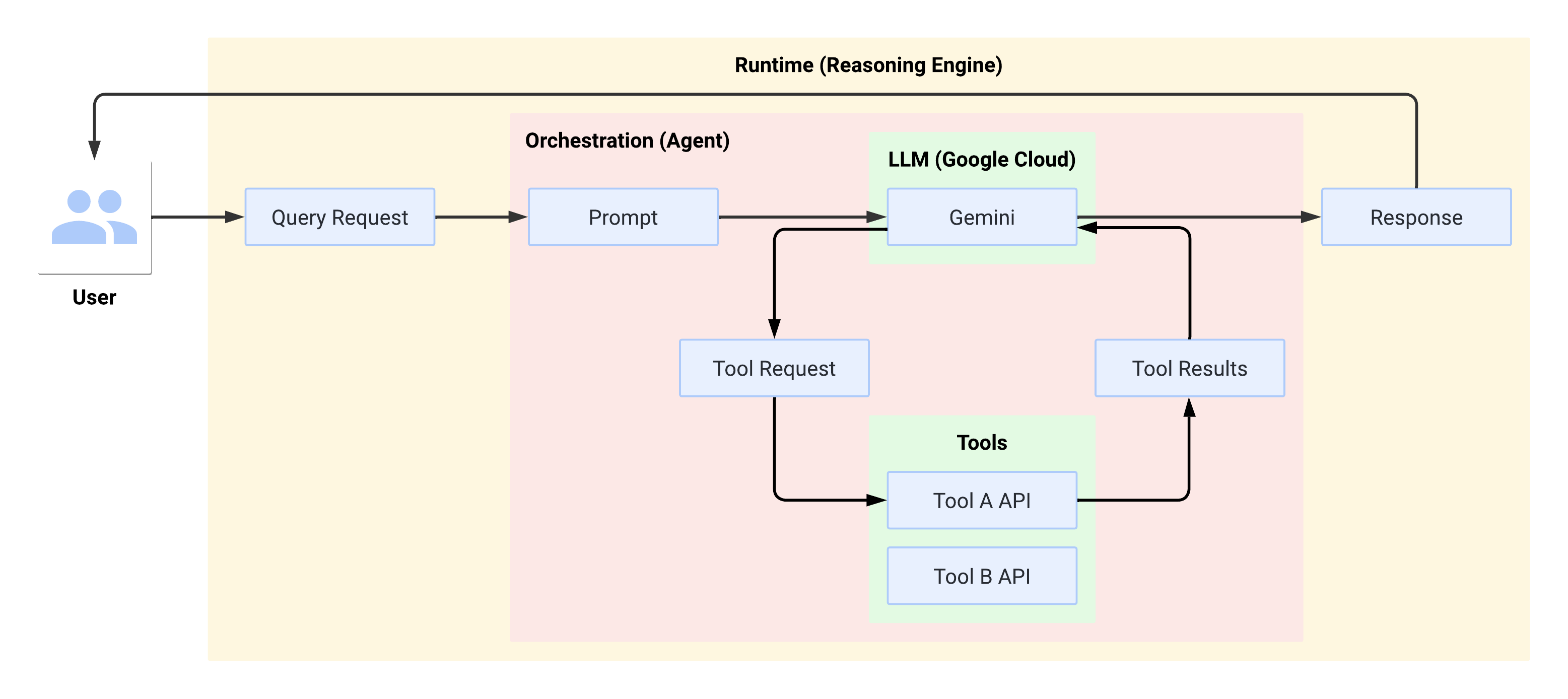

Systemablauf zur Laufzeit

Wenn der Nutzer eine Abfrage stellt, formatiert der definierte Agent sie in einen Prompt für das LLM. Das LLM verarbeitet den Prompt und bestimmt, ob eines der Tools verwendet werden soll.

Wenn das LLM ein Tool verwendet, wird ein FunctionCall mit dem Namen und den Parametern generiert, mit denen das Tool aufgerufen werden soll. Der Agent ruft das Tool mit dem FunctionCall auf und stellt die Ergebnisse vom Tool zurück für das LLM bereit.

Wenn das LLM keine Tools verwendet, generiert es Inhalte, die vom Agent an den Nutzer zurückgesendet werden.

Das folgende Diagramm veranschaulicht den Systemablauf zur Laufzeit:

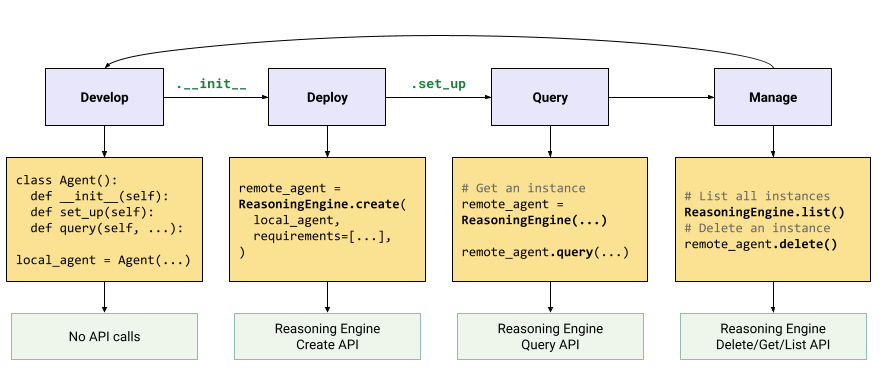

Generative AI-Anwendung erstellen und bereitstellen

Der Workflow zum Erstellen von generativen KI-Anwendungen ist:

| Schritte | Beschreibung |

|---|---|

| 1. Umgebung einrichten | Richten Sie Ihr Google-Projekt ein und installieren Sie die neueste Version des Vertex AI SDK für Python. |

| 2. Anwendung entwickeln | LangChain-Anwendung entwickeln, die in Reasoning Engine bereitgestellt werden kann |

| 3. Anwendung bereitstellen | Stellen Sie die Anwendung in Reasoning Engine bereit. |

| 4. Anwendung verwenden | Reasoning Engine für eine Antwort abfragen. |

| 5. Bereitgestellte Anwendung verwalten | Verwalten und löschen Sie Anwendungen, die Sie in Reasoning Engine bereitgestellt haben. |

| 6. Optional: Anwendungsvorlage anpassen | Vorlage für neue Anwendungen anpassen |

Die Schritte werden im folgenden Diagramm dargestellt:

Nächste Schritte

- Umgebung einrichten

- Mehr über Funktionsaufrufe erfahren.