O Vertex AI Agent Engine, que faz parte da plataforma Vertex AI, é um conjunto de serviços que permite aos desenvolvedores implantar, gerenciar e dimensionar agentes de IA em produção. O Agent Engine cuida da infraestrutura para escalonar agentes em produção, para que você possa se concentrar na criação de aplicativos. O Vertex AI Agent Engine oferece os seguintes serviços que podem ser usados individualmente ou em combinação:

Ambiente de execução:

- Implante e dimensione agentes com um ambiente de execução gerenciado e recursos de gerenciamento de ponta a ponta.

- Personalize a imagem do contêiner do agente com scripts de instalação no momento da build para dependências do sistema.

- Use recursos de segurança, incluindo compliance com VPC-SC e configuração de autenticação e IAM.

- Acessar modelos e ferramentas, como a chamada de função.

- Implante agentes criados usando diferentes frameworks Python:

- Entenda o comportamento do agente com o Google Cloud Trace (compatível com o OpenTelemetry), o Cloud Monitoring e o Cloud Logging.

Qualidade e avaliação (prévia): avalie a qualidade do agente com o serviço de avaliação de IA generativa integrado e otimize os agentes com execuções treinamento de modelo do Gemini.

Example Store (prévia): armazene e recupere dinamicamente exemplos few-shot para melhorar a performance do agente.

Sessões (prévia): com as sessões do mecanismo de agente, é possível armazenar interações individuais entre usuários e agentes, fornecendo fontes definitivas para o contexto da conversa.

Banco de memória (prévia): com o banco de memória do mecanismo de agente, é possível armazenar e recuperar informações de sessões para personalizar as interações do agente.

O Vertex AI Agent Engine faz parte do Vertex AI Agent Builder, um conjunto de recursos para descobrir, criar e implantar agentes de IA.

Criar e implantar no Vertex AI Agent Engine

Observação:para uma experiência simplificada de desenvolvimento e implantação baseada em IDE com o Vertex AI Agent Engine, considere o agent-starter-pack. Ele oferece modelos prontos para uso, uma UI integrada para testes e simplifica a implantação, as operações, a avaliação, a personalização e a capacidade de observação.

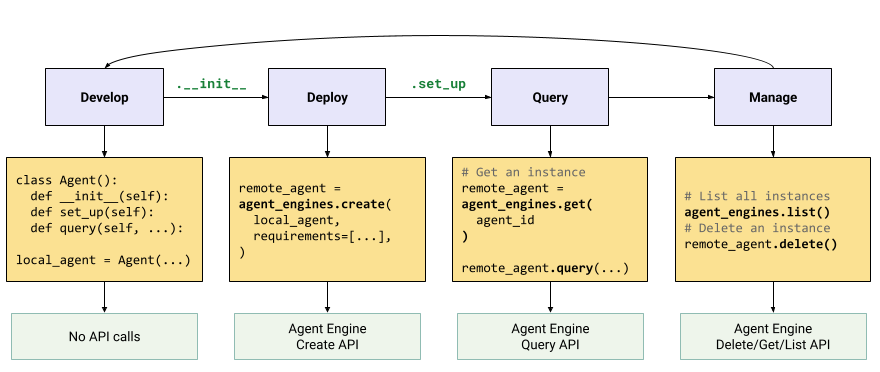

O fluxo de trabalho para criar um agente no Vertex AI Agent Engine é:

| Etapas | Descrição |

|---|---|

| 1. configurar o ambiente | Configure o projeto do Google e instale a versão mais recente do SDK da Vertex AI para Python. |

| 2. Desenvolver um agente | Desenvolver um agente que possa ser implantado no Vertex AI Agent Engine. |

| 3. Implantar o agente | Implante o agente no ambiente de execução gerenciado do Vertex AI Agent Engine. |

| 4. Usar o agente | Envie uma consulta ao agente enviando uma solicitação de API. |

| 5. Gerenciar o agente implantado | Gerencie e exclua os agentes que você implantou no Vertex AI Agent Engine. |

As etapas estão ilustradas no diagrama a seguir:

Frameworks compatíveis

A tabela a seguir descreve o nível de suporte que o Vertex AI Agent Engine oferece para várias estruturas de agente:

| Nível de suporte | Frameworks de agente |

|---|---|

| Modelo personalizado: é possível adaptar um modelo personalizado para oferecer suporte à implantação no Vertex AI Agent Engine do seu framework. | CrewAI, estruturas personalizadas |

| Integração do SDK da Vertex AI: o Vertex AI Agent Engine oferece modelos gerenciados por framework no SDK e na documentação da Vertex AI. | AG2, LlamaIndex |

| Integração total: os recursos são integrados para funcionar em todo o framework, no Vertex AI Agent Engine e no ecossistema Google Cloud mais amplo. | Agent Development Kit (ADK), LangChain, LangGraph |

Implantar na produção com o pacote inicial de agentes

O Pacote inicial de agentes é uma coleção de modelos de agentes de IA generativa prontos para produção criados para o Vertex AI Agent Engine. O pacote inicial do agente oferece o seguinte:

- Modelos de agentes pré-criados:ReAct, RAG, multiagente e outros modelos.

- Playground interativo: teste e interaja com seu agente.

- Infraestrutura automatizada: usa o Terraform para simplificar o gerenciamento de recursos.

- Pipelines de CI/CD: fluxos de trabalho de implantação automatizada que usam o Cloud Build.

- Observabilidade: suporte integrado para o Cloud Trace e o Cloud Logging.

Para começar, consulte o Guia de início rápido.

Casos de uso

Para saber mais sobre o Vertex AI Agent Engine com exemplos completos, consulte os seguintes recursos:

Segurança corporativa

O Vertex AI Agent Engine oferece suporte a vários recursos para ajudar você a atender aos requisitos de segurança corporativa, aderir às políticas de segurança da sua organização e seguir as práticas recomendadas de segurança. Há suporte para os seguintes recursos:

Chaves de criptografia gerenciadas pelo cliente (CMEK): o Vertex AI Agent Engine aceita CMEK para proteger seus dados com suas próprias chaves de criptografia, o que dá a você a propriedade e o controle total das chaves que protegem seus dados em repouso no Google Cloud. Para mais informações, consulte CMEK do Agent Engine.

VPC Service Controls: o Vertex AI Agent Engine é compatível com os VPC Service Controls para reforçar a segurança dos dados e reduzir os riscos de exfiltração de dados. Quando o VPC Service Controls é configurado, o agente implantado mantém o acesso seguro a APIs e serviços do Google, como a API BigQuery, a API Cloud SQL Admin e a API Vertex AI, verificando a operação perfeita dentro do perímetro definido. O VPC Service Controls bloqueia todo o acesso à Internet pública, confinando a movimentação de dados aos limites da rede autorizada e melhorando significativamente a postura de segurança da empresa.

Interface do Private Service Connect: o PSC-I permite que seus agentes interajam com serviços hospedados de maneira particular na VPC do usuário. Para mais informações, consulte Configurar a interface do VPC Service Controls.

HIPAA: como parte da plataforma Vertex AI, o Vertex AI Agent Engine é compatível com cargas de trabalho da HIPAA.

Regiões compatíveis

O Vertex AI Agent Engine está disponível nas seguintes regiões:

| Região | Local | Versões compatíveis |

|---|---|---|

us-central1 |

Iowa | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

us-east4 |

Norte da Virgínia | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

us-west1 |

Oregon | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

europe-west1 |

Bélgica | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

europe-west2 |

Londres | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

europe-west3 |

Frankfurt | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

europe-west4 |

Países Baixos | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

europe-southwest1 |

Madri | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

asia-east1 |

Taiwan | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

asia-northeast1 |

Tóquio | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

asia-south1 |

Mumbai | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

asia-southeast1 |

Singapura | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

australia-southeast2 |

Melbourne | O v1 é compatível com recursos do GA. O v1beta1 é compatível com recursos de pré-lançamento. |

Para o Banco de memória do mecanismo de agente (prévia), as seguintes regiões são compatíveis:

| Região | Local | Versões compatíveis |

|---|---|---|

us-central1 |

Iowa | A versão v1beta1 é compatível. |

us-east4 |

Norte da Virgínia | A versão v1beta1 é compatível. |

us-west1 |

Oregon | A versão v1beta1 é compatível. |

europe-west1 |

Bélgica | A versão v1beta1 é compatível. |

europe-west4 |

Países Baixos | A versão v1beta1 é compatível. |

europe-southwest1 |

Madri | A versão v1beta1 é compatível. |

Cota

Os limites a seguir se aplicam ao Vertex AI Agent Engine para um determinado projeto em cada região:| Descrição | Limite |

|---|---|

| Criar, excluir ou atualizar o Vertex AI Agent Engine por minuto | 10 |

| Criar, excluir ou atualizar sessões do Vertex AI Agent Engine por minuto | 100 |

Query ou StreamQuery Vertex AI Agent Engine por minuto |

90 |

| Adicionar evento às sessões por minuto do Vertex AI Agent Engine | 300 |

| Número máximo de recursos do Vertex AI Agent Engine | 100 |

| Criar, excluir ou atualizar recursos de memória do Vertex AI Agent Engine por minuto | 100 |

| Receber, listar ou extrair do Memory Bank do Vertex AI Agent Engine por minuto | 300 |

Preços

O preço do tempo de execução do Agent Engine é baseado no uso de computação (horas de vCPU) e memória (horas de GiB) do seu agente para processar solicitações. Não há cobrança pelo tempo em que um agente implantado fica ocioso.

| Produto | Código SKU | Preço |

|---|---|---|

| vCPU do ReasoningEngine | 8A55-0B95-B7DC | US$ 0,0994/vCPU-h |

| Memória do ReasoningEngine | 0B45-6103-6EC1 | US$ 0,0105/GiB-h |

Para saber mais informações, consulte Preços.