Konfigurierbare Sicherheitsfilter

Konfidenz und Schweregrad der Sicherheitsattribute

Über die Vertex AI PaLM API verarbeitete Inhalte werden anhand einer Liste von Sicherheitsattributen bewertet, die „schädliche Kategorien“ und Themen enthalten, die als sensitiv eingestuft werden können.

Jedem Sicherheitsattribut ist ein Konfidenzwert zwischen 0,0 und 1,0 zugeordnet, gerundet auf eine Dezimalstelle. Dieser Wert gibt die Wahrscheinlichkeit an, mit der eine Eingabe oder Antwort zu einer bestimmten Kategorie gehört.

Vier dieser Sicherheitsattribute (belästigte Inhalte, Anstößige, gefährliche Inhalte und sexuell explizite Inhalte) werden mit einer Sicherheitsbewertung (Schweregrad) und einem Schweregrad von 0, 0 bis 1,0 zugewiesen, gerundet auf eine Dezimalstelle. Diese Bewertungen und Bewertungen spiegeln den vorhergesagten Schweregrad der Inhalte wider, die zu einer bestimmten Kategorie gehören.

Beispielantwort

{

"predictions": [

{

"safetyAttributes": {

"categories": [

"Derogatory",

"Toxic",

"Violent",

"Sexual",

"Insult",

"Profanity",

"Death, Harm & Tragedy",

"Firearms & Weapons",

"Public Safety",

"Health",

"Religion & Belief",

"Illicit Drugs",

"War & Conflict",

"Politics",

"Finance",

"Legal"

],

"scores": [

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1

],

"safetyRatings": [

{"category": "Hate Speech", "severity": "NEGLIGIBLE", "severityScore": 0.0,"probabilityScore": 0.1},

{"category": "Dangerous Content", "severity": "LOW", "severityScore": 0.3, "probabilityScore": 0.1},

{"category": "Harassment", "severity": "MEDIUM", "severityScore": 0.6, "probabilityScore": 0.1},

{"category": "Sexually Explicit", "severity": "HIGH", "severityScore": 0.9, "probabilityScore": 0.1}

],

"blocked": false

},

"content": "<>"

}

]

}

Hinweis: Kategorien mit einem Wert von 0,0 werden in der Antwort nicht berücksichtigt. Diese Beispielantwort dient nur zur Veranschaulichung.

Beispielantwort, wenn blockiert

{

"predictions": [

{

"safetyAttributes": {

"blocked": true,

"errors": [

150,

152,

250

]

},

"content": ""

}

]

}

Sicherheitsattribute: Beschreibungen

| Sicherheitsattribut | Beschreibung |

|---|---|

| Hassreden | Negative oder schädliche Kommentare, die auf Identität und/oder geschützte Merkmale ausgerichtet sind |

| Toxisch | Unhöfliche, respektlose oder vulgäre Inhalte. |

| Sexuelle Inhalte | Enthält Verweise auf sexuelle Handlungen oder andere vulgäre Inhalte |

| Gewalt | Beschreibt Szenarien, in denen Gewalt gegen eine Person oder Gruppe dargestellt wird, oder allgemein blutrünstige Inhalte. |

| Beleidigung | Beleidigende, aufhetzende oder negative, an eine Person oder eine Gruppe an Personen gerichtete Kommentare. |

| Vulgäre Sprache | Obszöne oder vulgäre Sprache, z. B. Fluchen. |

| Tod, Schäden und Katastrophen | Menschliche Todesfälle, Katastrophen, Unfälle, Katastrophen und selbst zugefügte Schäden. |

| Waffen | Inhalte, die Messer, Gewehre, Personenwaffen und Zubehör wie Munition, Holster usw. erwähnen. |

| Öffentliche Sicherheit | Dienstleistungen und Organisationen, die Unterstützung bieten und der öffentlichen Sicherheit dienen. |

| Gesundheit | Menschliche Gesundheit, darunter: Erkrankungen, Krankheiten und Störungen Medizinische Therapien, Medikamente, Impfungen und Medizinische Anwendungen Ressourcen zur Heilung, u. a. Hilfsgruppen |

| Religion und Glauben | Glaubenssysteme, die sich mit der Möglichkeit übernatürlicher Gesetze und Wesen befassen; Religion, Glauben, spirituelle Praktiken, Kirchen und Orte der Götterverehrung. Umfasst Astrologie und das Okkulte. |

| Unzulässige Arzneimittel | Freizeitdrogen und illegale Drogen; Drogenzubehör und -anbau, Headshops usw. Umfasst die medizinische Verwendung von Medikamenten, die in der Regel in der Freizeit konsumiert werden (z. B. Marihuana). |

| Krieg und Konflikte | Kriege, militärische Konflikte und schwerwiegende physische Konfrontationen großer Menschenmengen. Umfasst die Diskussion von Militärdiensten, auch wenn sie in keinem direkten Zusammenhang mit einem Krieg oder Konflikt stehen. |

| Finanzen | Finanzdienstleistungen für Nutzer und Unternehmen, z. B. Bankwesen, Darlehen, Kredite, Investitionen, Versicherungen und mehr |

| Politik | Politische Nachrichten und Medien; Diskussionen über soziale, staatliche und öffentliche Richtlinien. |

| Recht | Rechtsbezogene Inhalte, z. B. Strafverfolgungsbehörden, Rechtsinformationen, primäre Rechtsmaterialien, paralegale Rechtsdienstleistungen, juristische Veröffentlichungen und -technologien, Expertenzeugen, Rechtsbeistände und andere Rechtsdienstleister. |

Sicherheitsattribute mit Sicherheitsbewertungen

| Sicherheitsattribut | Definition | Ebenen |

|---|---|---|

| Hassrede | Negative oder schädliche Kommentare, die auf Identität und/oder geschützte Merkmale ausgerichtet sind | Hoch, Mittel, Niedrig, Vernachlässigbar |

| Belästigung | Böswillige, einschüchternde, mobbende oder missbräuchliche Kommentare, die auf andere Personen ausgerichtet sind. | Hoch, Mittel, Niedrig, Vernachlässigbar |

| sexuell explizit | Enthält Verweise auf sexuelle Handlungen oder andere vulgäre Inhalte | Hoch, Mittel, Niedrig, Vernachlässigbar |

| Gefährliche Inhalte | Fördert oder ermöglicht den Zugriff auf schädliche Waren, Dienste und Aktivitäten | Hoch, Mittel, Niedrig, Vernachlässigbar |

Sicherheitsgrenzwerte

Für folgende Sicherheitsattribute gelten Sicherheitsgrenzwerte:

- Hassrede

- Belästigung

- sexuell explizit

- Gefährliche Inhalte

Google blockiert Modellantworten, die die angegebenen Schweregrade für diese Sicherheitsattribute überschreiten. Wenden Sie sich an Ihr Google Cloud-Account-Management-Team, um die Option anzufordern, einen Sicherheitsgrenzwert zu ändern.

Konfidenz- und Schweregradschwellenwerte testen

Sie können die Sicherheitsfilter von Google testen und für Ihr Unternehmen geeignete Konfidenzgrenzwerte definieren. Über diese Grenzwerte können Sie umfassende Maßnahmen ergreifen, um Inhalte zu erkennen, die gegen die Nutzungsrichtlinien oder Nutzungsbedingungen von Google verstoßen, und entsprechende Maßnahmen zu ergreifen.

Konfidenzwerte sind nur Vorhersagen. Sie sollten diese Werte nicht als absolut zuverlässig oder genau ansehen. Google ist nicht dafür verantwortlich, diese Werte für Geschäftsentscheidungen zu interpretieren oder zu verwenden.

Wichtig: Wahrscheinlichkeit und Schweregrad

Mit Ausnahme der vier Sicherheitsattribute mit Sicherheitsbewertungen basieren die Konfidenzwerte der PaLM API-Sicherheit auf der Wahrscheinlichkeit, dass Inhalte unsicher sind, und nicht auf dem Schweregrad. Dies ist wichtig, da einige Inhalte mit geringer Wahrscheinlichkeit unsicher sind, obwohl der Schweregrad des Schadens hoch sein kann. Vergleichen Sie beispielsweise folgende Sätze:

- Der Roboter hat mich geboxt.

- Der Roboter hat mich in Stücke geschnitten.

Satz 1 kann eine höhere Wahrscheinlichkeit für unsichere Ergebnisse verursachen, aber Sie können Satz 2 in Bezug auf Gewalt einen höheren Schweregrad zuweisen.

Daher ist es wichtig, dass Kunden Tests sorgfältig durchführen und überlegen, welches Maß an Sicherheitsblockaden zur Unterstützung ihrer wichtigsten Anwendungsfälle erforderlich ist, während gleichzeitig der Schaden für Endnutzer minimiert wird.

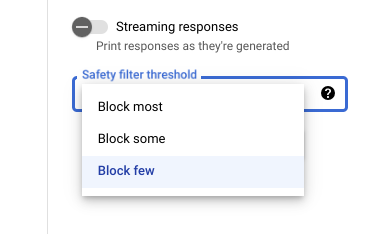

Sicherheitseinstellungen in Vertex AI Studio

Mit dem anpassbaren Schwellenwert für Sicherheitsfilter können Sie die Wahrscheinlichkeit anpassen, dass für Sie Antworten angezeigt werden, die möglicherweise schädlich sind. Modellantworten werden auf der Grundlage der Wahrscheinlichkeit blockiert, dass sie Diskriminierung, gefährliche oder sexuell explizite Inhalte enthält. Die Sicherheitsfiltereinstellung befindet sich auf der rechten Seite des Prompt-Felds von Vertex AI Studio. Sie können zwischen drei Optionen wählen: block most, block some und block few.

Zitatfilter

Unsere Funktionen zu generativem Code sind zum Erstellen von Originalinhalten und nicht für eine umfassende Replizierung bereits bestehender Inhalte vorgesehen. Wir haben unsere Systeme so konzipiert, dass die Wahrscheinlichkeit eines solchen Auftretens begrenzt wird und die Funktionen dieser Systeme kontinuierlich verbessert werden. Wenn diese Funktionen eine bestimmte Webseite dennoch umfassend zitieren, wird diese Webseite als Verweis angegeben.

Manchmal sind dieselben Inhalte auf mehreren Webseiten zu finden. Wir werden dann versuchen, eine beliebte Quelle anzugeben. Bei Zitaten von Code-Repositories kann auch auf eine gültige Open-Source-Lizenz verwiesen werden. Es liegt in Ihrer Verantwortung, die Lizenzanforderungen einzuhalten.

Weitere Informationen zu den Metadaten des Zitatfilters finden Sie in der Referenz zur Citation API.

Sicherheitsfehler

Sicherheitsfehlercodes sind dreistellige Codes, die den Grund dafür angeben, warum eine Aufforderung oder Antwort blockiert wurde. Die erste Ziffer ist ein Präfix, das angibt, ob der Code für die Eingabeaufforderung oder die Antwort gilt. Die verbleibenden Ziffern geben den Grund für die Blockierung an.

Der Fehlercode 251 weist beispielsweise darauf hin, dass die Antwort aufgrund eines Problems mit Volksverhetzung in der Antwort des Modells blockiert wurde.

In einer einzelnen Antwort können mehrere Fehlercodes zurückgegeben werden.

Wenn Fehler auftreten, die den Inhalt in Ihrer Antwort vom Modell (Präfix = 2, z. B. 250) blockieren, passen Sie die Einstellung temperature in Ihrer Anfrage an. So lässt sich eine andere Gruppe von Antworten generieren, die weniger wahrscheinlich blockwert werden.

Fehlercode-Präfix

Das Fehlercode-Präfix ist die erste Ziffer des Fehlercodes.

| 1 | Der Fehlercode gilt für die Eingabeaufforderung, die an das Modell gesendet wird. |

| 2 | Der Fehlercode gilt für die Antwort vom Modell. |

Fehlercode-Ursache

Die Fehlercode-Ursache ist die zweite und dritte Ziffer des Fehlercodes.

Fehlercode-Ursachen, die mit 3 oder 4 beginnen, geben Eingabeaufforderungen oder Antworten an, die aufgrund des Konfidenzsgrenzwerts für einen Sicherheitsattributverstoß blockiert wurden.

Fehlercode-Ursachen, die mit 5 beginnen, geben Eingabeaufforderungen oder Antworten an, bei denen unsichere Inhalte gefunden wurden.

| 10 | Die Antwort wurde aufgrund eines Qualitätsproblems oder einer Parametereinstellung, die sich auf Zitatemetadaten auswirkt, blockiert. Dies gilt nur für Antworten des Modells. Der Wert ist Der Zitationsdienst ermittelt Qualitätsprobleme oder Probleme, die aus einer Parametereinstellung stammen. Versuchen Sie, die Parameter Weitere Informationen finden Sie unter Zitatfilter. |

| 20 | Die angegebene oder zurückgegebene Sprache wird nicht unterstützt. Eine Liste der unterstützten Sprachen finden Sie unter Sprachunterstützung. |

| 30 | Die Eingabeaufforderung oder Antwort wurde blockiert, weil sie als schädlich eingestuft wurde. Ein Begriff ist in der Sperrliste für Begriffe enthalten. Formulieren Sie die Eingabeaufforderung um. |

| 31 | Der Inhalt umfasst möglicherweise vertrauliche personenidentifizierbare Informationen. Formulieren Sie den Prompt um. |

| 40 | Die Eingabeaufforderung oder Antwort wurde blockiert, weil sie als schädlich eingestuft wurde. Der Inhalt verstößt gegen die SafeSearch. Formulieren Sie den Prompt um. |

| 50 | Die Aufforderung oder Antwort wurde blockiert, da sie sexuell explizite Inhalte enthalten kann. Formulieren Sie den Prompt um. |

| 51 | Die Eingabeaufforderung oder Antwort wurde blockiert, weil sie möglicherweise Sprachinhalte enthält. Formulieren Sie den Prompt um. |

| 52 | Die Eingabeaufforderung oder Antwort wurde blockiert, weil sie möglicherweise belästigende Inhalte umfasst. Formulieren Sie den Prompt um. |

| 53 | Die Eingabeaufforderung oder Antwort wurde blockiert, weil sie möglicherweise gefährliche Inhalte umfasst. Formulieren Sie den Prompt um. |

| 54 | Die Eingabeaufforderung oder Antwort wurde blockiert, weil sie möglicherweise schädliche Inhalte umfasst. Formulieren Sie den Prompt um. |

| 00 | Ursache unbekannt. Formulieren Sie den Prompt um. |

Nächste Schritte

- Weitere Informationen zu verantwortungsbewusster Anwendung von KI

- Data Governance