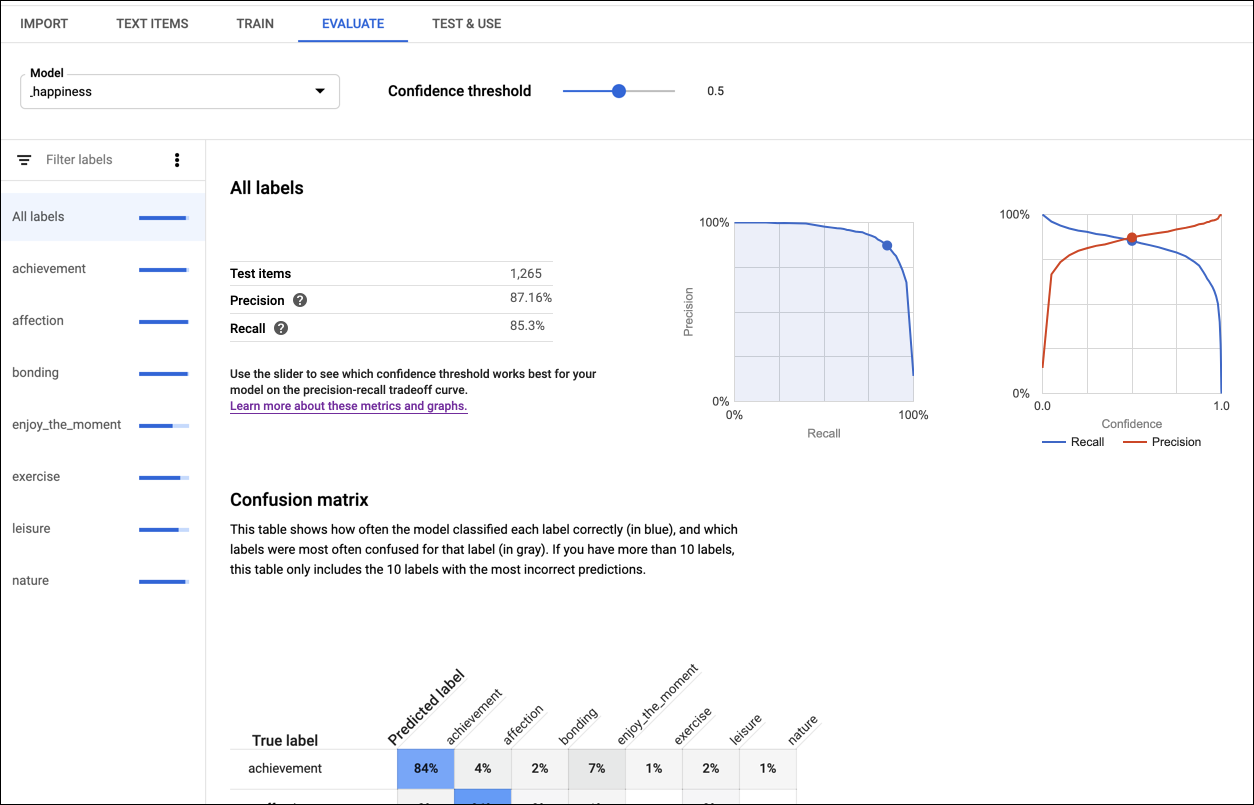

Dopo aver addestrato un modello, AutoML Natural Language utilizza i documenti TEST set per valutare la qualità e l'accuratezza del nuovo modello.

AutoML Natural Language fornisce un set aggregato di metriche di valutazione che indicano come tutte le prestazioni del modello, oltre che le metriche di valutazione per ogni etichetta di categoria, che indica le prestazioni del modello per quell'etichetta.

La precisione e il richiamo misurano l'efficacia con cui il modello acquisisce informazioni. e quanto tralascia. La precisione indica, da tutti i documenti identificati come una particolare entità o etichetta, quante dovevano essere l'entità o l'etichetta. Il richiamo indica, da tutti i documenti che dovrebbero essere stati identificati come entità o etichetta specifica, quante sono state effettivamente assegnate a quella entità o etichetta.

La matrice di confusione (presente solo per i modelli con etichetta singola per documento)

rappresenta la percentuale di volte in cui ogni etichetta è stata prevista

del set di addestramento durante la valutazione. Idealmente, verrebbe assegnata l'etichetta one

solo ai documenti classificati come etichetta one e così via, quindi una matrice perfetta sarebbe

come:

100 0 0 0

0 100 0 0

0 0 100 0

0 0 0 100

Nell'esempio precedente, se un documento è stato classificato come one, ma il modello ha previsto two,

la prima riga avrà invece il seguente aspetto:

99 1 0 0

AutoML Natural Language crea la matrice di confusione per un massimo di 10 etichette. Se hai più di 10 etichette, la matrice include le 10 etichette con maggiore confusione (previsioni errate).

Per i modelli di sentiment:

L'errore assoluto medio (MAE) e l'errore quadratico medio (MSE) misurano il valore distanza tra il valore di sentiment previsto e il valore di sentiment effettivo. Valori più bassi indicano modelli più accurati.

Il kappa con ponderazione lineare e il kappa con ponderazione quadratica misurano il grado di precisione i valori di sentiment assegnati dal modello concordano con i valori assegnati dall'utente valutatori. Valori più alti indicano modelli più accurati.

Utilizza queste metriche per valutare l'idoneità del modello. Punteggi bassi di precisione e richiamo può indicare che il modello ha bisogno di ulteriori dati di addestramento o annotazioni. Precisione e un richiamo perfetti possono indicare che i dati sono troppo facili e non generalizzano bene. Consulta la Guida per principianti per altri suggerimenti sulla valutazione dei modelli.

Se i livelli qualitativi non sono soddisfacenti, puoi tornare ai passaggi precedenti per migliorare la qualità:

- Valuta la possibilità di aggiungere altri documenti a tutte le etichette di bassa qualità.

- Potresti dover aggiungere diversi tipi di documenti. Ad esempio, più a lungo o documenti più brevi, documenti di autori diversi con formulazioni diverse o stile.

- Puoi ripulire le etichette.

- Valuta la possibilità di rimuovere completamente le etichette se non hai abbastanza documenti di addestramento.

Dopo aver apportato le modifiche, addestra e valuta un nuovo modello fino a raggiungere un livello qualitativo sufficientemente alto.

UI web

Per rivedere le metriche di valutazione per il tuo modello:

Fai clic sull'icona a forma di lampadina nella barra di navigazione a sinistra per visualizzare i modelli disponibili.

Per visualizzare i modelli di un altro progetto, seleziona il progetto dal menu a discesa in alto a destra nella barra del titolo.

Fai clic sulla riga relativa al modello da valutare.

Se necessario, fai clic sulla scheda Valuta appena sotto la barra del titolo.

Se l'addestramento è stato completato per il modello, AutoML Natural Language mostra e le metriche di valutazione.

Per visualizzare le metriche per un'etichetta specifica, seleziona il nome dell'etichetta dall'elenco di etichette nella parte inferiore della pagina.

Esempi di codice

Gli esempi forniscono una valutazione per il modello nel suo complesso. Puoi anche ottenere

per un'etichetta specifica (displayName) utilizzando un ID valutazione.

REST

Prima di utilizzare i dati della richiesta, effettua le seguenti sostituzioni:

- project-id: il tuo ID progetto

- location-id: la località della risorsa,

us-central1per la località globale oeuper l'Unione europea - model-id: il tuo ID modello

Metodo HTTP e URL:

GET https://automl.googleapis.com/v1/projects/project-id/locations/location-id/models/model-id/modelEvaluations

Per inviare la richiesta, espandi una delle seguenti opzioni:

Dovresti ricevere una risposta JSON simile alla seguente:

{

"modelEvaluation": [

{

"name": "projects/434039606874/locations/us-central1/models/7537307368641647584/modelEvaluations/9009741181387603448",

"annotationSpecId": "17040929661974749",

"classificationMetrics": {

"auPrc": 0.99772006,

"baseAuPrc": 0.21706384,

"evaluatedExamplesCount": 377,

"confidenceMetricsEntry": [

{

"recall": 1,

"precision": -1.3877788e-17,

"f1Score": -2.7755576e-17,

"recallAt1": 0.9761273,

"precisionAt1": 0.9761273,

"f1ScoreAt1": 0.9761273

},

{

"confidenceThreshold": 0.05,

"recall": 0.997,

"precision": 0.867,

"f1Score": 0.92746675,

"recallAt1": 0.9761273,

"precisionAt1": 0.9761273,

"f1ScoreAt1": 0.9761273

},

{

"confidenceThreshold": 0.1,

"recall": 0.995,

"precision": 0.905,

"f1Score": 0.9478684,

"recallAt1": 0.9761273,

"precisionAt1": 0.9761273,

"f1ScoreAt1": 0.9761273

},

{

"confidenceThreshold": 0.15,

"recall": 0.992,

"precision": 0.932,

"f1Score": 0.96106446,

"recallAt1": 0.9761273,

"precisionAt1": 0.9761273,

"f1ScoreAt1": 0.9761273

},

{

"confidenceThreshold": 0.2,

"recall": 0.989,

"precision": 0.951,

"f1Score": 0.96962786,

"recallAt1": 0.9761273,

"precisionAt1": 0.9761273,

"f1ScoreAt1": 0.9761273

},

{

"confidenceThreshold": 0.25,

"recall": 0.987,

"precision": 0.957,

"f1Score": 0.9717685,

"recallAt1": 0.9761273,

"precisionAt1": 0.9761273,

"f1ScoreAt1": 0.9761273

},

...

],

},

"createTime": "2018-04-30T23:06:14.746840Z"

},

{

"name": "projects/434039606874/locations/us-central1/models/7537307368641647584/modelEvaluations/9009741181387603671",

"annotationSpecId": "1258823357545045636",

"classificationMetrics": {

"auPrc": 0.9972302,

"baseAuPrc": 0.1883289,

...

},

"createTime": "2018-04-30T23:06:14.649260Z"

}

]

}

Python

Per scoprire come installare e utilizzare la libreria client per AutoML Natural Language, consulta Librerie client di AutoML Natural Language. Per ulteriori informazioni, consulta API AutoML Natural Language Python documentazione di riferimento.

Per eseguire l'autenticazione ad AutoML Natural Language, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Java

Per scoprire come installare e utilizzare la libreria client per AutoML Natural Language, consulta Librerie client di AutoML Natural Language. Per ulteriori informazioni, consulta API AutoML Natural Language Java documentazione di riferimento.

Per eseguire l'autenticazione ad AutoML Natural Language, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Node.js

Per scoprire come installare e utilizzare la libreria client per AutoML Natural Language, consulta Librerie client di AutoML Natural Language. Per ulteriori informazioni, consulta API AutoML Natural Language Node.js documentazione di riferimento.

Per eseguire l'autenticazione ad AutoML Natural Language, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Go

Per scoprire come installare e utilizzare la libreria client per AutoML Natural Language, consulta Librerie client di AutoML Natural Language. Per ulteriori informazioni, consulta API AutoML Natural Language Go documentazione di riferimento.

Per eseguire l'autenticazione ad AutoML Natural Language, configura le credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Linguaggi aggiuntivi

C#: Segui le Istruzioni per la configurazione di C# Nella pagina delle librerie client e poi visita Documentazione di riferimento di AutoML Natural Language per .NET.

PHP Segui le Istruzioni per la configurazione dei file PHP Nella pagina delle librerie client e poi visita Documentazione di riferimento di AutoML Natural Language per PHP.

Rubino: Segui le Istruzioni per la configurazione di Ruby Nella pagina delle librerie client e poi visita Documentazione di riferimento di AutoML Natural Language per Ruby.