Document AI genera métricas de evaluación, como precisión y recuperación, para ayudarte a determinar el rendimiento predictivo de tus procesadores.

Estas métricas de evaluación se generan comparando las entidades que devuelve el procesador (las predicciones) con las anotaciones en los documentos de prueba. Si tu procesador no tiene un conjunto de datos de prueba, primero debes crear un conjunto de datos y etiquetar los documentos de prueba.

Ejecutar una evaluación

Una evaluación se ejecuta automáticamente cada vez que entrenas o actualizas una versión del procesador.

También puedes ejecutar una evaluación de forma manual. Esto es necesario para generar métricas actualizadas después de modificar el conjunto de prueba o si estás evaluando una versión del procesador previamente entrenada.

IU web

En la consola de Google Cloud , ve a la página Procesadores y elige tu procesador.

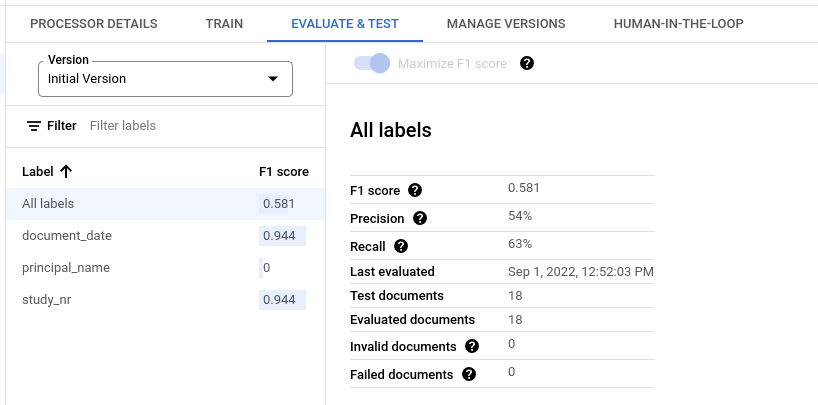

En la pestaña Evaluar y probar, selecciona la Versión del procesador que deseas evaluar y, luego, haz clic en Ejecutar nueva evaluación.

Una vez que se complete, la página contendrá métricas de evaluación para todas las etiquetas y para cada etiqueta individual.

Python

Para obtener más información, consulta la documentación de referencia de la API de Document AI Python.

Para autenticarte en Document AI, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Obtén los resultados de una evaluación

IU web

En la consola de Google Cloud , ve a la página Procesadores y elige tu procesador.

En la pestaña Evaluar y probar, selecciona la Versión del procesador para ver la evaluación.

Una vez que se complete, la página contendrá métricas de evaluación para todas las etiquetas y para cada etiqueta individual.

Python

Para obtener más información, consulta la documentación de referencia de la API de Document AI Python.

Para autenticarte en Document AI, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Enumera todas las evaluaciones de una versión del procesador

Python

Para obtener más información, consulta la documentación de referencia de la API de Document AI Python.

Para autenticarte en Document AI, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Métricas de evaluación para todas las etiquetas

Las métricas de Todas las etiquetas se calculan en función de la cantidad de verdaderos positivos, falsos positivos y falsos negativos en el conjunto de datos para todas las etiquetas y, por lo tanto, se ponderan según la cantidad de veces que aparece cada etiqueta en el conjunto de datos. Para obtener las definiciones de estos términos, consulta Métricas de evaluación para etiquetas individuales.

Precisión: Es la proporción de predicciones que coinciden con las anotaciones en el conjunto de prueba. Se define como

True Positives / (True Positives + False Positives)Recuperación: Es la proporción de anotaciones en el conjunto de prueba que se predijeron correctamente. Se define como

True Positives / (True Positives + False Negatives)Puntuación F1: Es la media armónica de la precisión y la recuperación, que combina ambas en una sola métrica y les otorga el mismo peso. Se define como

2 * (Precision * Recall) / (Precision + Recall)

Métricas de evaluación para etiquetas individuales

Verdaderos positivos: Son las entidades predichas que coinciden con una anotación en el documento de prueba. Para obtener más información, consulta el comportamiento de la coincidencia.

Falsos positivos: Son las entidades predichas que no coinciden con ninguna anotación en el documento de prueba.

Falsos negativos: Son las anotaciones en el documento de prueba que no coinciden con ninguna de las entidades predichas.

- Falsos negativos (por debajo del umbral): Son las anotaciones en el documento de prueba que habrían coincidido con una entidad predicha, pero el valor de confianza de la entidad predicha está por debajo del umbral de confianza especificado.

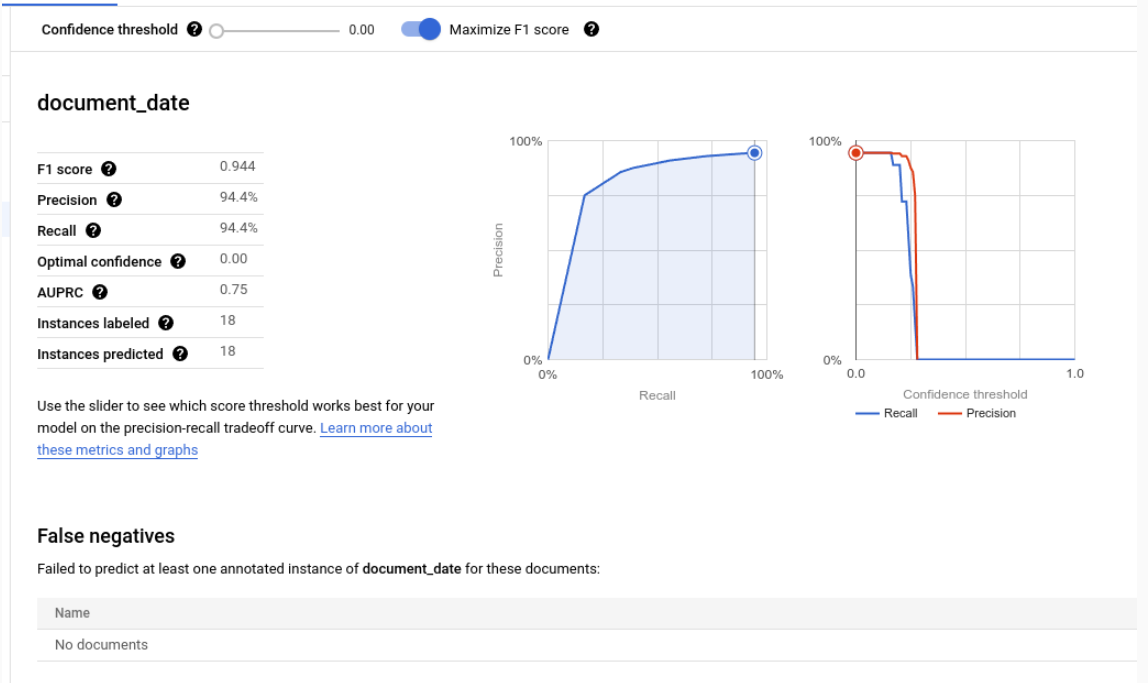

Límite de confianza

La lógica de evaluación ignora las predicciones con una confianza inferior al umbral de confianza especificado, incluso si la predicción es correcta. Document AI proporciona una lista de falsos negativos (por debajo del umbral), que son las anotaciones que tendrían una coincidencia si el umbral de confianza se estableciera en un valor más bajo.

Document AI calcula automáticamente el umbral óptimo, que maximiza la puntuación F1 y, de forma predeterminada, establece el umbral de confianza en este valor óptimo.

Puedes elegir tu propio umbral de confianza moviendo la barra deslizante. En general, un umbral de confianza más alto genera lo siguiente:

- Mayor precisión, ya que es más probable que las predicciones sean correctas

- menor recuperación, ya que hay menos predicciones.

Entidades tabulares

Las métricas de una etiqueta superior no se calculan promediando directamente las métricas secundarias, sino aplicando el umbral de confianza de la etiqueta superior a todas sus etiquetas secundarias y agregando los resultados.

El umbral óptimo para el elemento principal es el valor del umbral de confianza que, cuando se aplica a todos los elementos secundarios, genera la puntuación F1 máxima para el elemento principal.

Comportamiento de coincidencia

Una entidad predicha coincide con una anotación si se cumplen las siguientes condiciones:

- El tipo de la entidad predicha (

entity.type) coincide con el nombre de la etiqueta de la anotación. - El valor de la entidad predicha (

entity.mention_textoentity.normalized_value.text) coincide con el valor de texto de la anotación, sujeto a la coincidencia aproximada si está habilitada.

Ten en cuenta que el tipo y el valor de texto son todo lo que se usa para la coincidencia. No se usa otra información, como las anclas de texto y los cuadros delimitadores (con la excepción de las entidades tabulares que se describen a continuación).

Etiquetas de una sola ocurrencia en comparación con etiquetas de varias ocurrencias

Las etiquetas de ocurrencia única tienen un valor por documento (por ejemplo, el ID de factura), incluso si ese valor se anota varias veces en el mismo documento (por ejemplo, el ID de factura aparece en cada página del mismo documento). Incluso si las múltiples anotaciones tienen texto diferente, se consideran iguales. En otras palabras, si una entidad predicha coincide con alguna de las anotaciones, se considera una coincidencia. Las anotaciones adicionales se consideran menciones duplicadas y no contribuyen a ninguno de los recuentos de verdaderos positivos, falsos positivos o falsos negativos.

Las etiquetas de ocurrencia múltiple pueden tener varios valores diferentes. Por lo tanto, cada entidad y anotación predichas se consideran y se correlacionan por separado. Si un documento contiene N anotaciones para una etiqueta de ocurrencia múltiple, puede haber N coincidencias con las entidades predichas. Cada entidad y anotación predichas se cuentan de forma independiente como un verdadero positivo, un falso positivo o un falso negativo.

Coincidencias parciales

El botón de activación Fuzzy Matching te permite ajustar o relajar algunas de las reglas de coincidencia para disminuir o aumentar la cantidad de coincidencias.

Por ejemplo, sin la coincidencia aproximada, la cadena ABC no coincide con abc debido al uso de mayúsculas. Sin embargo, con la coincidencia parcial, sí coinciden.

Cuando se habilita la coincidencia parcial, se aplican los siguientes cambios en las reglas:

Normalización de espacios en blanco: Quita los espacios en blanco iniciales y finales, y condensa los espacios en blanco intermedios consecutivos (incluidos los saltos de línea) en espacios únicos.

Eliminación de signos de puntuación iniciales o finales: Quita los siguientes signos de puntuación iniciales o finales

!,.:;-"?|.Coincidencia que no distingue mayúsculas de minúsculas: Convierte todos los caracteres en minúsculas.

Normalización de dinero: Para las etiquetas con el tipo de datos

money, quita los símbolos de moneda iniciales y finales.

Entidades tabulares

Las entidades y las anotaciones principales no tienen valores de texto y se correlacionan en función de los cuadros delimitadores combinados de sus elementos secundarios. Si solo hay un elemento superior predicho y uno anotado, se correlacionan automáticamente, independientemente de los cuadros delimitadores.

Una vez que se vinculan los padres, sus hijos se vinculan como si fueran entidades no tabulares. Si no se encuentran coincidencias entre los padres, Document AI no intentará encontrar coincidencias entre sus hijos. Esto significa que las entidades secundarias se pueden considerar incorrectas, incluso con el mismo contenido de texto, si no coinciden sus entidades principales.

Las entidades principales y secundarias son una función en versión preliminar y solo se admiten para tablas con un nivel de anidación.

Exporta métricas de evaluación

En la consola de Google Cloud , ve a la página Procesadores y elige tu procesador.

En la pestaña Evaluar y probar, haz clic en Descargar métricas para descargar las métricas de evaluación como un archivo JSON.