Início rápido: conclua uma tarefa de revisão

Cada processador cria uma "tarefa HITL" que é atribuída a um conjunto de etiquetadores humanos (denominado "conjunto de etiquetadores") que reveem os documentos processados pelo processador. Após o processamento, estes documentos são colocados na fila para revisão HITL pelo conjunto de etiquetadores atribuído.

Antes de começar

Conclua o Início rápido: configure a revisão humana antes de continuar.Adicione etiquetadores

- Depois de configurar a revisão humana, deve receber um email semelhante ao seguinte:

From: AI Platform <noreply-aiplatform@google.com>\

Subject: Added to AI Platform SpecialistPool Test Labeler Group

Hello AI Platform Customer,

You are added as a manager to specialist pool

cloudml_data_specialists_us_central1_785484070008756xxxx.

To view details, visit Manager console

https://datacompute.google.com/cm/

Sincerely,

The Google Cloud AI Team

Clique no link no email (ou corte e cole no navegador) para navegar para a página de gestão:

A tarefa criada pelo processador recém-criado tem o mesmo nome que o processador (por exemplo, "Faturas do departamento A") e é apresentada no separador Tarefas.

Clique no separador Etiquetadores

Clique em Adicionar etiquetador e adicione, pelo menos, um etiquetador (email). Um gestor pode ser um etiquetador, pelo que pode adicionar-se a si próprio.

Para um conjunto de etiquetadores criado recentemente, a tarefa tem de ser atribuída explicitamente ao etiquetador individual no separador Atribuições. Ou seja, a adição do conjunto de etiquetadores não atribui automaticamente a tarefa a estes novos etiquetadores. Se o conjunto de etiquetadores já tiver aprovisionado etiquetadores, o conjunto é atribuído automaticamente à tarefa.

Publique um documento inicial para revisão

Envie um documento para extração através do processador criado. Consulte os guias de instruções, conforme necessário. Atualmente, as chamadas online (sincronizadas) e em lote (assíncronas) suportam o encaminhamento de revisão humana para processadores suportados.

Para fins de teste, pode usar uma extração de baixa qualidade conhecida para acionar a revisão humana, uma vez que a pontuação de confiança está abaixo do limite, ou pode definir o limite para 100%. Geralmente, os limites de documentos são de 5 páginas e um máximo de 20 MB, mas verifique os limites específicos do processador.

Existe uma API para acompanhar cada documento encaminhado para revisão humana. Como parte da resposta dos processadores, existe uma

humanReviewOperationstring que é o ID da operação (nome da tarefa) do documento na revisão humana. Esta operação de longa duração (também denominada LRO) pode ser consultada para verificar o estado.Pode consultar o estado de um documento encaminhado para revisão humana com o método

projects.locations.operations.getPode forçar a revisão humana de um documento com o método

reviewDocument(tenha em atenção que é específico do processador):A utilização do método

reviewDocumentrequer que a caixa de verificação Revisão humana ATIVADA esteja selecionada. A utilização desta API não substitui as definições de configuração.Pode seguir o guia Peça uma revisão humana para usar este método.

Reveja o documento

Se o documento acionar o processo de revisão humana, mas não existirem etiquetadores no conjunto, o gestor recebe um email.

> Hello AI Platform Customer, > > There is a running task for Project with Job ID 404298342016955xxxx,\ > Labeling Task ID cloudml_data_us_central1_prod_11b273b4dabdxxxx,\ > Display name \ > datalabeling-job-8005676103232389120-for-hitl-340697311810578xxxx,\ > replication count 1\ > Please see attachment for instruction.\ > Please add labelers and have them finish the task at Labeler console \ > [https://datacompute.google.com/w/cloudml_data_specialists_us_central1_7854840700087566336](https://datacompute.google.com/w/cloudml_data_specialists_us_central1_7854840700087566336){: target="external" class="external" track-type="quickstart" track-name="externalLink" track-metadata-position="body" }.\ > To view details, visit Manager console \ > [https://datacompute.google.com/cm/cloudml_data_specialists_us_central1_7854840700087566336/tasks](https://datacompute.google.com/cm/cloudml_data_specialists_us_central1_7854840700087566336/tasks){: target="external" class="external" track-type="quickstart" track-name="externalLink" track-metadata-position="body" }. > > Sincerely,\ The Google Cloud AI Team

Estes links destinam-se ao gestor de etiquetagem para atribuir trabalho de etiquetagem.

Se os etiquetadores não estiverem inscritos no grupo de etiquetagem e forem adicionados recentemente, o gestor de etiquetagem tem de enviar um email semelhante com instruções aos etiquetadores adicionados.

Passos do etiquetador

Procedimento de etiquetagem

Email do etiquetador

Se um etiquetador já estiver inscrito num grupo de etiquetagem no passo 2e, o sistema atribui-lhe automaticamente a tarefa e o etiquetador recebe um email como este:

O link neste email é o mecanismo para o etiquetador selecionado fazer o trabalho de etiquetagem no documento.

Ações de etiquetagem:

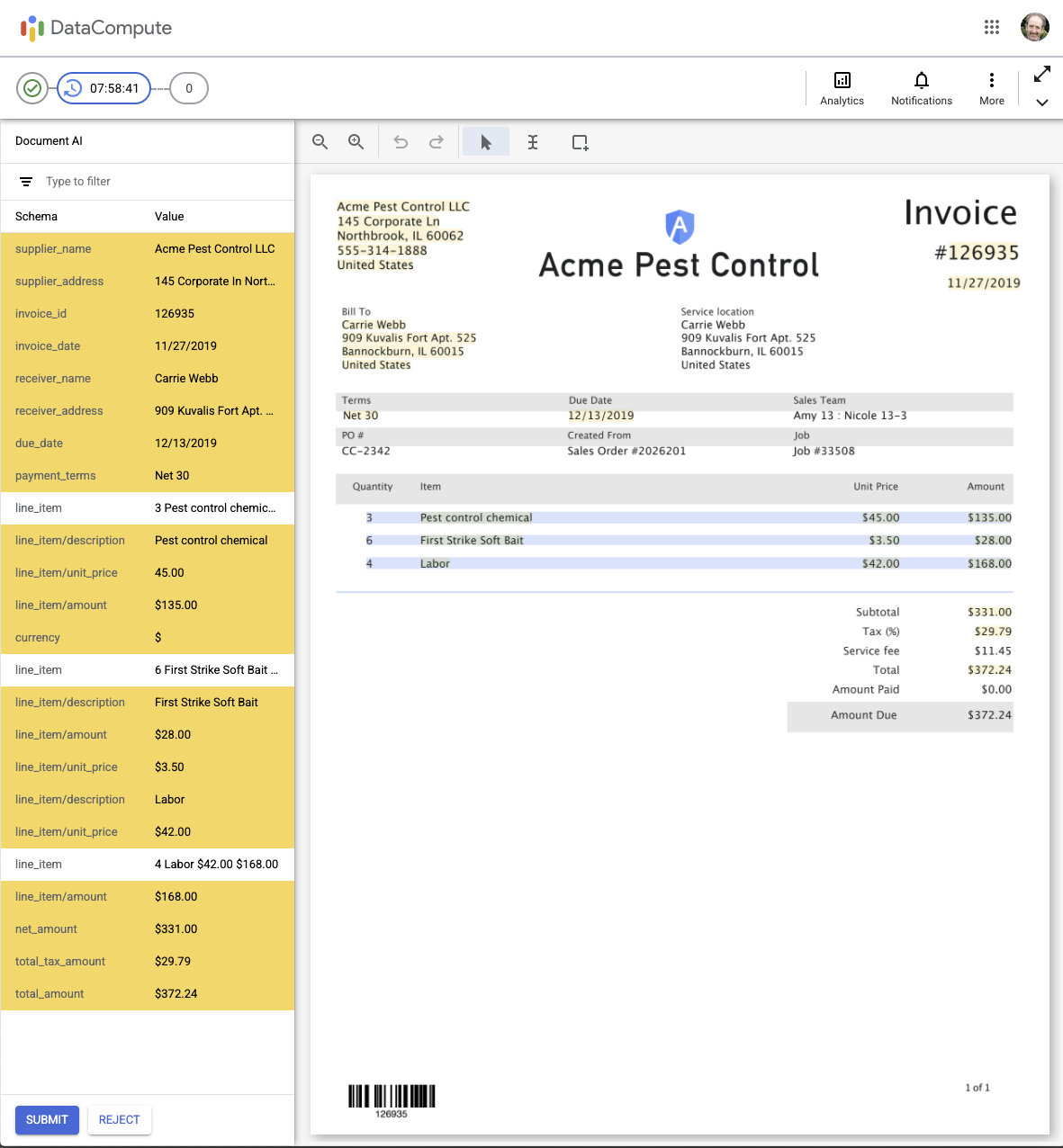

Quando um etiquetador clica no link para fazer a etiquetagem, vê a interface do utilizador de revisão humana de IA interativa apresentada abaixo. As linhas realçadas (a amarelo) indicam as linhas que não estão a passar na validação (ou seja, estão abaixo do limiar de classificação de confiança configurado) e precisam de revisão.

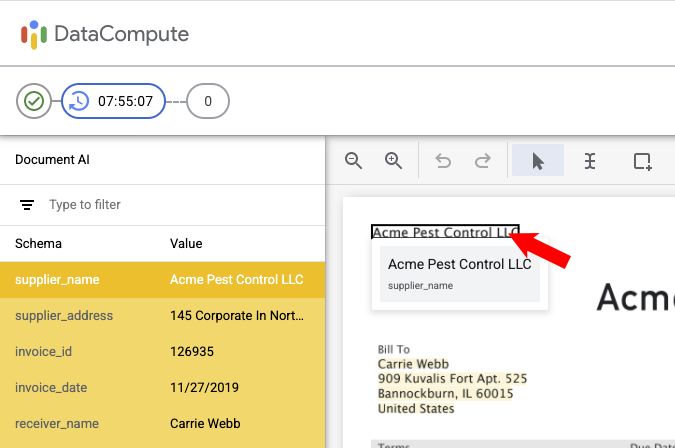

Rever Quando passa o cursor do rato sobre um campo de texto reconhecido, é apresentado o texto reconhecido e (com um tipo de letra mais pequeno abaixo) o nome do campo (esquema). A linha também é realçada no painel esquerdo.

O utilizador pode aumentar/diminuir o zoom com os ícones de lupa na parte superior esquerda da barra de ferramentas.

Alterar campo

Clicando (com o botão esquerdo do rato) no campo, pode editá-lo:

Pode alterar o valor ou a etiqueta no painel esquerdo. Em seguida, clique em Aplicar.

EM ALTERNATIVA, pode redimensionar a caixa delimitadora em torno do texto do documento clicando num dos ícones de canto de redimensionamento na imagem do documento:

Conforme mostrado, se for selecionado um texto diferente, este altera o texto no valor do campo no painel do lado esquerdo. Em seguida, pode editar ainda mais este texto, se necessário. Em seguida, clique em Aplicar.

Certifique-se de que revê todas as páginas através do controlo de páginas no canto superior direito.

Depois de fazer todas as alterações necessárias às etiquetas, clique em ENVIAR (na parte inferior esquerda). O JSON de resultado é guardado na pasta "Localização dos resultados".

Se não for possível etiquetar o documento de forma satisfatória, pode clicar em REJEITAR (na parte inferior esquerda) e, em seguida, selecionar um motivo para rejeitar o documento: - Selecione um motivo e, de seguida, clique em Rejeitar documento.

Os etiquetadores também podem clicar nos seguintes ícones no canto superior direito:

- Estatísticas: para mostrar quantos documentos foram revistos (Respostas) e o tempo total.

- Notificações: para mostrar as notificações que recebeu.

- Mais (3 pontos): para Ignorar o documento, Encontrar respostas ou enviar Feedback (se estiver ativado).

- Ativar/desativar barra do título (setas diagonais): esta opção oculta (ou mostra) a barra do título do DataCompute para ter mais espaço.

Gestor de etiquetagem

Reveja o documento a partir do Cloud Storage

Se quiser verificar o documento, tem duas opções:

Opção 1:

- Localize o Cloud Storage a partir da localização configurada anteriormente

- Obtenha e transfira os documentos

Opção 2:

- Memorize o URI para obter o documento da resposta de previsão

- URI de chamada para obter o documento revisto

O que se segue?

- Faça a gestão de tarefas de etiquetagem através da consola do gestor de etiquetagem.

- Veja uma lista e descrições dos processadores disponíveis atualmente.