O BigQuery se integra à Document AI para ajudar a criar análises de documentos e casos de uso de IA generativa. À medida que a transformação digital acelera, as organizações geram grandes quantidades de texto e outros dados de documentos, que têm um potencial imenso para insights e para impulsionar novos casos de uso de IA generativa. Para ajudar a aproveitar esses dados, anunciamos uma integração entre o BigQuery e a Document AI, que permite extrair insights de dados de documentos e criar novos aplicativos de modelo de linguagem grande (LLM).

Visão geral

Os clientes do BigQuery agora podem criar extratores personalizados da Document AI, com tecnologia dos modelos de fundação de ponta do Google, que podem ser personalizados com base nos próprios documentos e metadados. Esses modelos personalizados podem ser invocados do BigQuery para extrair dados estruturados de documentos de maneira segura e controlada, usando a simplicidade e o poder do SQL. Antes dessa integração, alguns clientes tentavam criar pipelines independentes da Document AI, o que envolvia a seleção manual da lógica e do esquema de extração. A falta de recursos de integração integrados os obrigou a desenvolver uma infraestrutura personalizada para sincronizar e manter a consistência dos dados. Isso transformou cada projeto de análise de documentos em uma tarefa substancial que exigia um investimento significativo. Agora, com essa integração, os clientes podem criar modelos remotos no BigQuery para extratores personalizados na Document AI e usá-los para realizar análises de documentos e IA generativa em grande escala, inaugurando uma nova era de insights e inovação baseados em dados.

Uma experiência unificada e governada de dados para IA

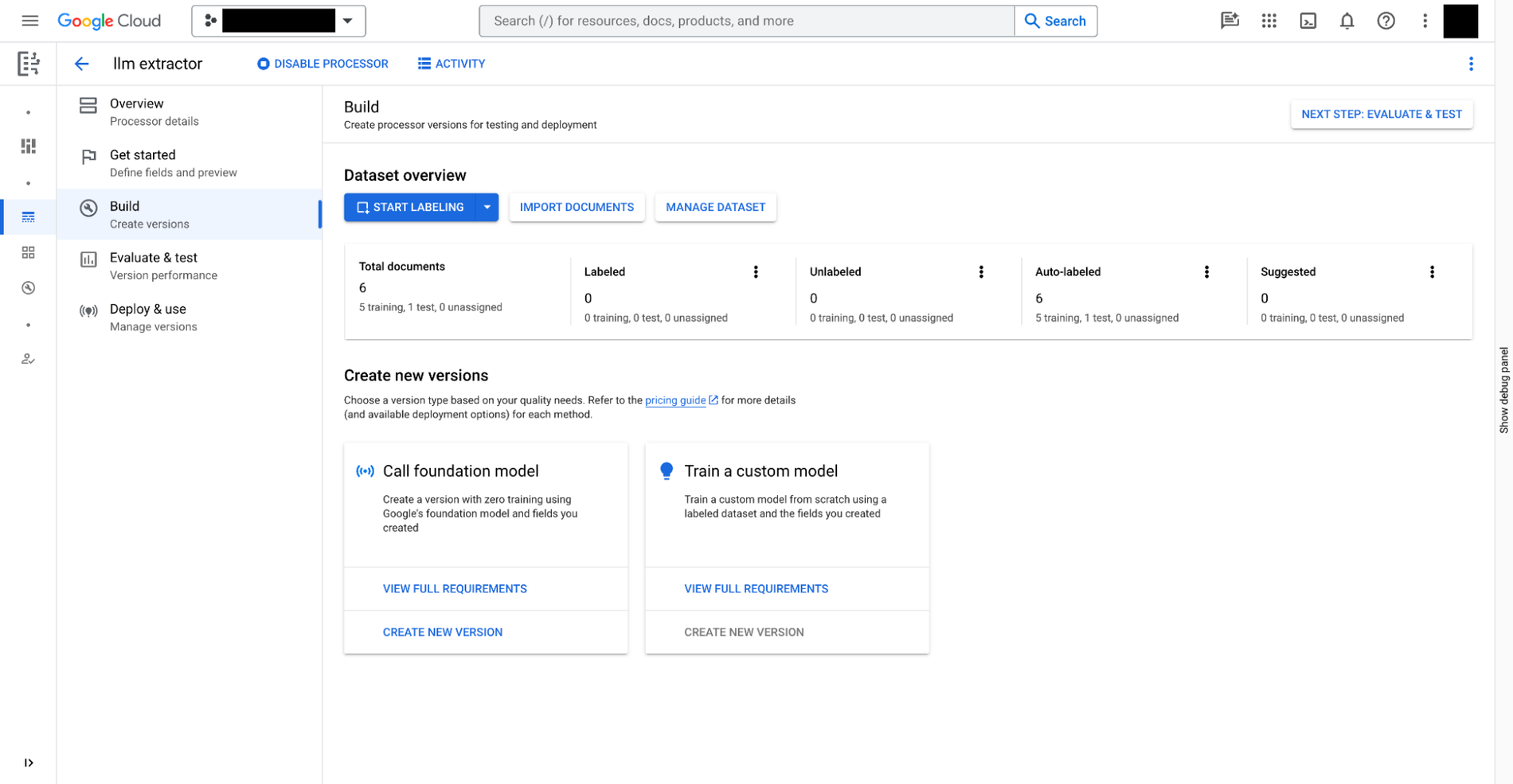

É possível criar um extrator personalizado na Document AI em três etapas:

- Defina os dados que você precisa extrair dos documentos. Ele é chamado de

document schemae fica armazenado com cada versão do extrator personalizado, acessível no BigQuery. - Se quiser, forneça outros documentos com anotações como exemplos da extração.

- Treine o modelo para o extrator personalizado com base nos modelos de fundação fornecidos na Document AI.

Além dos extratores personalizados que exigem treinamento manual, a Document AI também oferece extratores prontos para uso de despesas, recibos, faturas, formulários fiscais, documentos de identificação do governo e uma infinidade de outros cenários na galeria de processadores.

Depois que o extrator personalizado estiver pronto, acesse o BigQuery Studio para analisar os documentos usando SQL nas quatro etapas a seguir:

- Registre um modelo remoto do BigQuery para o extrator usando SQL. O modelo pode entender o esquema do documento (criado acima), invocar o extrator personalizado e analisar os resultados.

- Crie tabelas de objetos usando SQL para os documentos armazenados no Cloud Storage. É possível controlar os dados não estruturados nas tabelas definindo políticas de acesso no nível da linha, o que limita o acesso dos usuários a determinados documentos e restringe o poder da IA para privacidade e segurança.

- Use a função

ML.PROCESS_DOCUMENTna tabela de objetos para extrair campos relevantes fazendo chamadas de inferência para o endpoint de API. Também é possível filtrar os documentos para as extrações com uma cláusulaWHEREfora da função. A função retorna uma tabela estruturada, com cada coluna sendo um campo extraído. - Combine os dados extraídos com outras tabelas do BigQuery para combinar dados estruturados e não estruturados, gerando valores comerciais.

O exemplo a seguir ilustra a experiência do usuário:

# Create an object table in BigQuery that maps to the document files stored in Cloud Storage.

CREATE OR REPLACE EXTERNAL TABLE `my_dataset.document`

WITH CONNECTION `my_project.us.example_connection`

OPTIONS (

object_metadata = 'SIMPLE',

uris = ['gs://my_bucket/path/*'],

metadata_cache_mode= 'AUTOMATIC',

max_staleness= INTERVAL 1 HOUR

);

# Create a remote model to register your Doc AI processor in BigQuery.

CREATE OR REPLACE MODEL `my_dataset.layout_parser`

REMOTE WITH CONNECTION `my_project.us.example_connection`

OPTIONS (

remote_service_type = 'CLOUD_AI_DOCUMENT_V1',

document_processor='PROCESSOR_ID'

);

# Invoke the registered model over the object table to parse PDF document

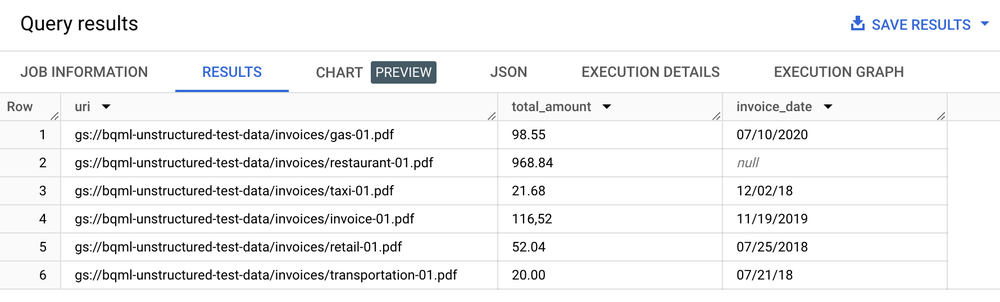

SELECT uri, total_amount, invoice_date

FROM ML.PROCESS_DOCUMENT(

MODEL `my_dataset.layout_parser`,

TABLE `my_dataset.document`,

PROCESS_OPTIONS => (

JSON '{"layout_config": {"chunking_config": {"chunk_size": 250}}}')

)

WHERE content_type = 'application/pdf';

Tabela de resultados

Análise de texto, resumo e outros casos de uso de análise de documentos

Depois de extrair o texto dos documentos, você pode realizar análises de várias maneiras:

- Use o BigQuery ML para realizar análises de texto: o BigQuery ML oferece suporte ao treinamento e à implantação de modelos de incorporação de várias maneiras. Por exemplo, você pode usar o BigQuery ML para identificar o sentimento do cliente em ligações de suporte ou classificar o feedback do produto em diferentes categorias. Se você usa Python, também pode usar o BigQuery DataFrames para pandas e APIs semelhantes ao scikit-learn para análise de texto nos seus dados.

- Use o LLM

text-embedding-004para gerar embeddings dos documentos divididos em partes: o BigQuery tem uma funçãoML.GENERATE_EMBEDDINGque chama o modelotext-embedding-004para gerar embeddings. Por exemplo, é possível usar a Document AI para extrair o feedback dos clientes e resumir esse feedback usando o PaLM 2, tudo com o SQL do BigQuery. - Combine metadados de documentos com outros dados estruturados armazenados em tabelas do BigQuery:

Por exemplo, você pode gerar embeddings usando os documentos divididos em partes e usá-los para pesquisa vetorial.

# Example 1: Parse the chunked data

CREATE OR REPLACE TABLE docai_demo.demo_result_parsed AS (SELECT

uri,

JSON_EXTRACT_SCALAR(json , '$.chunkId') AS id,

JSON_EXTRACT_SCALAR(json , '$.content') AS content,

JSON_EXTRACT_SCALAR(json , '$.pageFooters[0].text') AS page_footers_text,

JSON_EXTRACT_SCALAR(json , '$.pageSpan.pageStart') AS page_span_start,

JSON_EXTRACT_SCALAR(json , '$.pageSpan.pageEnd') AS page_span_end

FROM docai_demo.demo_result, UNNEST(JSON_EXTRACT_ARRAY(ml_process_document_result.chunkedDocument.chunks, '$')) json)

# Example 2: Generate embedding

CREATE OR REPLACE TABLE `docai_demo.embeddings` AS

SELECT * FROM ML.GENERATE_EMBEDDING(

MODEL `docai_demo.embedding_model`,

TABLE `docai_demo.demo_result_parsed`

);

Implementar casos de uso de pesquisa e IA generativa

Depois de extrair o texto estruturado dos documentos, é possível criar índices otimizados para consultas de agulha no palheiro, o que é possível com os recursos de pesquisa e indexação do BigQuery, liberando um recurso de pesquisa avançado. Essa integração também ajuda a desbloquear novos aplicativos generativos de LLM, como a execução de processamento de arquivos de texto para filtragem de privacidade, verificações de segurança de conteúdo e divisão de tokens usando SQL e modelos personalizados da Document AI. O texto extraído, combinado com outros metadados, simplifica a curadoria do corpus de treinamento necessário para ajustar modelos de linguagem grandes. Além disso, você está criando casos de uso de LLM em dados empresariais governados, que foram fundamentados com os recursos de geração de incorporação e gerenciamento de índice de vetor do BigQuery. Ao sincronizar esse índice com a Vertex AI, você pode implementar casos de uso de geração aumentada de recuperação para uma experiência de IA mais governada e simplificada.

Exemplo de aplicativo

Confira um exemplo de um aplicativo completo usando o conector do Document AI:

- Consulte esta demonstração do relatório de despesas no GitHub.

- Leia a postagem do blog complementar.

- Assista a um vídeo detalhado do Google Cloud Next 2021.