Tugas kualitas data Dataplex Universal Catalog memungkinkan Anda menentukan dan menjalankan pemeriksaan kualitas data di seluruh tabel di BigQuery dan Cloud Storage. Tugas kualitas data Dataplex Universal Catalog juga memungkinkan Anda menerapkan kontrol data reguler di lingkungan BigQuery.

Kapan harus membuat tugas kualitas data Dataplex Universal Catalog

Tugas kualitas data Dataplex Universal Catalog dapat membantu Anda dalam hal berikut:

- Memvalidasi data sebagai bagian dari pipeline produksi data.

- Memantau secara rutin kualitas set data berdasarkan ekspektasi Anda.

- Membuat laporan kualitas data untuk persyaratan peraturan.

Manfaat

- Spesifikasi yang dapat disesuaikan. Anda dapat menggunakan sintaksis YAML yang sangat fleksibel untuk mendeklarasikan aturan kualitas data.

- Implementasi serverless. Dataplex Universal Catalog tidak memerlukan penyiapan infrastruktur apa pun.

- Zero-copy dan bentang bawah otomatis. Pemeriksaan YAML dikonversi ke SQL dan didorong ke BigQuery, sehingga tidak ada data yang disalin.

- Pemeriksaan kualitas data yang dapat dijadwalkan. Anda dapat menjadwalkan pemeriksaan kualitas data melalui penjadwal serverless di Dataplex Universal Catalog, atau menggunakan Dataplex API melalui penjadwal eksternal seperti Cloud Composer untuk integrasi pipeline.

- Pengalaman terkelola. Dataplex Universal Catalog menggunakan mesin kualitas data open source, CloudDQ, untuk menjalankan pemeriksaan kualitas data. Namun, Dataplex Universal Catalog memberikan pengalaman terkelola yang lancar untuk menjalankan pemeriksaan kualitas data Anda.

Cara kerja tugas kualitas data

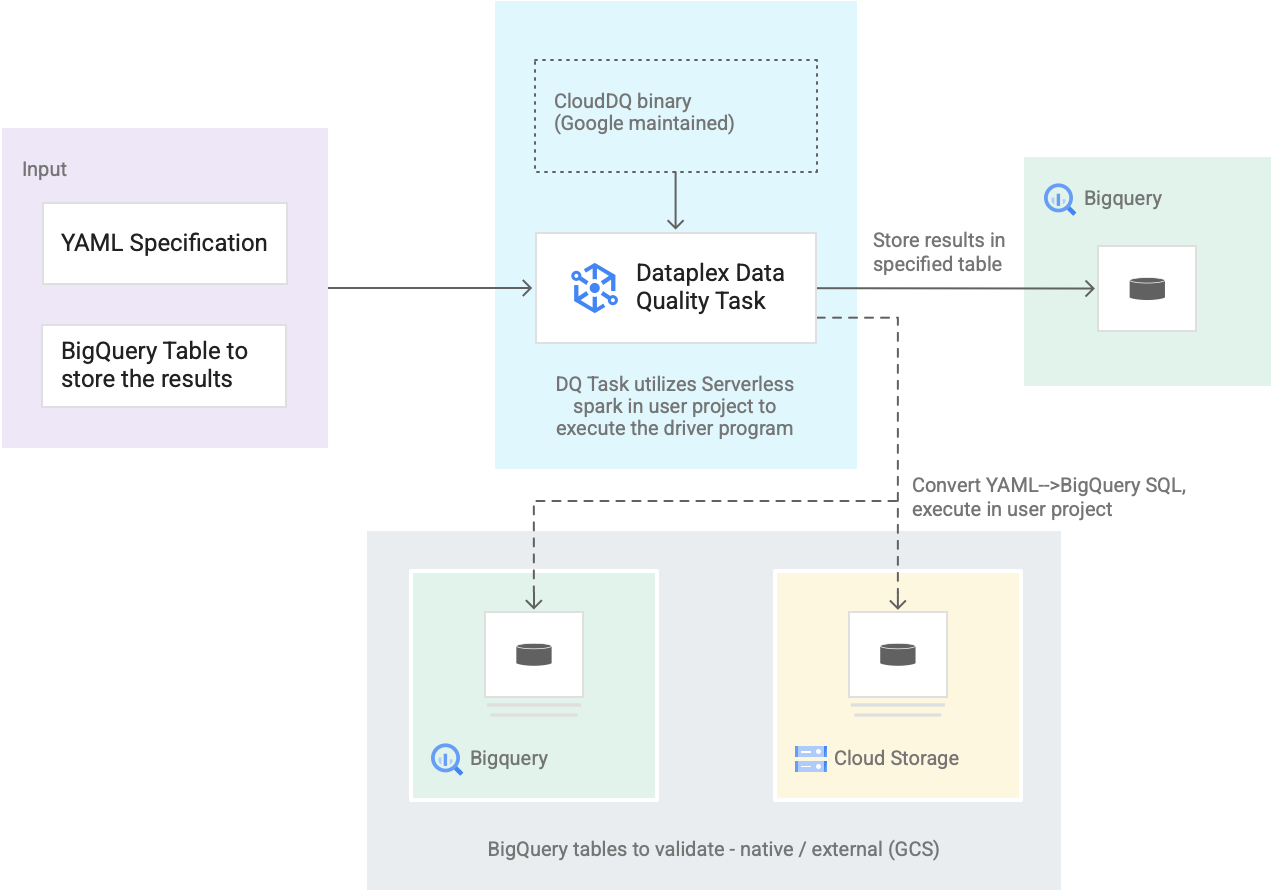

Diagram berikut menunjukkan cara kerja tugas kualitas data Dataplex Universal Catalog:

- Input dari pengguna

- Spesifikasi YAML: Sekumpulan yang berisi satu atau beberapa file YAML yang menentukan aturan kualitas data berdasarkan sintaksis spesifikasi. Anda menyimpan file YAML di bucket Cloud Storage di project Anda. Pengguna dapat menjalankan beberapa aturan secara bersamaan, dan aturan tersebut dapat diterapkan ke berbagai tabel BigQuery, termasuk tabel di berbagai set data atau project Google Cloud. Spesifikasi mendukung operasi inkremental hanya untuk memvalidasi data baru. Untuk membuat spesifikasi YAML, lihat Membuat file spesifikasi.

- Tabel hasil BigQuery: Tabel yang ditentukan pengguna tempat penyimpanan hasil validasi kualitas data. Google Cloud Project tempat tabel ini berada dapat menjadi project yang berbeda dengan project yang menggunakan tugas kualitas data Dataplex Universal Catalog.

- Tabel untuk divalidasi

- Dalam spesifikasi YAML, Anda harus menentukan tabel mana yang ingin divalidasi untuk aturan tertentu, yang juga dikenal sebagai binding aturan. Tabel tersebut dapat berupa tabel native BigQuery atau tabel eksternal BigQuery di Cloud Storage. Spesifikasi YAML memungkinkan Anda menentukan tabel di dalam atau di luar zona Dataplex Universal Catalog.

- Tabel BigQuery dan Cloud Storage yang divalidasi dalam satu operasi dapat menjadi bagian dari project yang berbeda.

- Tugas kualitas data Dataplex Universal Catalog: Tugas kualitas data Dataplex Universal Catalog dikonfigurasi dengan biner CloudDQ PySpark bawaan yang dikelola serta menggunakan spesifikasi YAML dan tabel hasil BigQuery sebagai input. Serupa dengan tugas Dataplex Universal Catalog lainnya, tugas kualitas data Dataplex Universal Catalog berjalan di lingkungan Spark serverless, mengonversi spesifikasi YAML menjadi kueri BigQuery, lalu menjalankan kueri tersebut pada tabel yang ditentukan dalam file spesifikasi.

Harga

Saat menjalankan tugas kualitas data Dataplex Universal Catalog, Anda akan dikenai biaya atas penggunaan BigQuery dan Serverless for Apache Spark (Batch).

Tugas kualitas data Dataplex Universal Catalog mengonversi file spesifikasi menjadi kueri BigQuery dan menjalankannya di project pengguna. Lihat bagian Harga BigQuery.

Dataplex Universal Catalog menggunakan Spark untuk menjalankan program driver CloudDQ open source yang dikelola Google guna mengonversi spesifikasi pengguna ke kueri BigQuery. Lihat harga Serverless untuk Apache Spark.

Penggunaan Dataplex Universal Catalog untuk mengatur data atau penggunaan penjadwal serverless di Dataplex Universal Catalog untuk menjadwalkan pemeriksaan kualitas data tidak akan dikenai biaya. Lihat Harga Katalog Universal Dataplex.