Dataplex Universal Catalog는 BigQuery 테이블을 자동으로 프로파일링하여 데이터를 더 쉽게 이해하고 분석할 수 있도록 지원합니다.

프로파일링은 데이터에 대한 자세한 상태 보고서를 받는 것과 같습니다. 일반적인 값, 데이터가 분산된 방식(분포), 누락된 항목 수 (null 수)와 같은 주요 통계를 제공합니다. 이 정보는 분석 속도를 높여줍니다.

데이터 프로파일링은 민감한 정보를 자동으로 감지하고 액세스 제어 정책을 설정할 수 있도록 지원합니다. 데이터의 신뢰성을 유지하기 위해 데이터 품질 검사 규칙을 추천합니다.

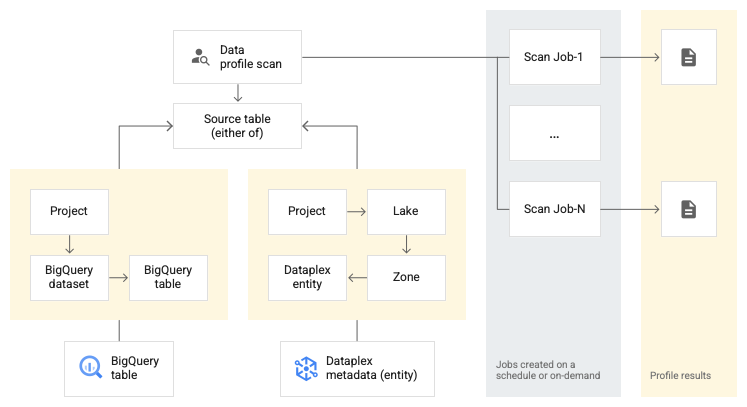

개념 모델

Dataplex Universal Catalog를 사용하면 데이터 프로필 스캔을 만들어 데이터 프로필을 더욱 심층적으로 이해할 수 있습니다.

다음 다이어그램은 Dataplex Universal Catalog가 데이터를 스캔하여 통계적 특성을 보고하는 방법을 보여줍니다.

데이터 프로필 스캔은 BigQuery 테이블 하나와 연결되고 테이블을 스캔하여 데이터 프로파일링 결과를 생성합니다. 데이터 프로필 스캔은 여러 구성 옵션을 지원합니다.

구성 옵션

이 섹션에서는 데이터 프로필 스캔을 실행하는 데 사용할 수 있는 구성 옵션을 설명합니다.

예약 옵션

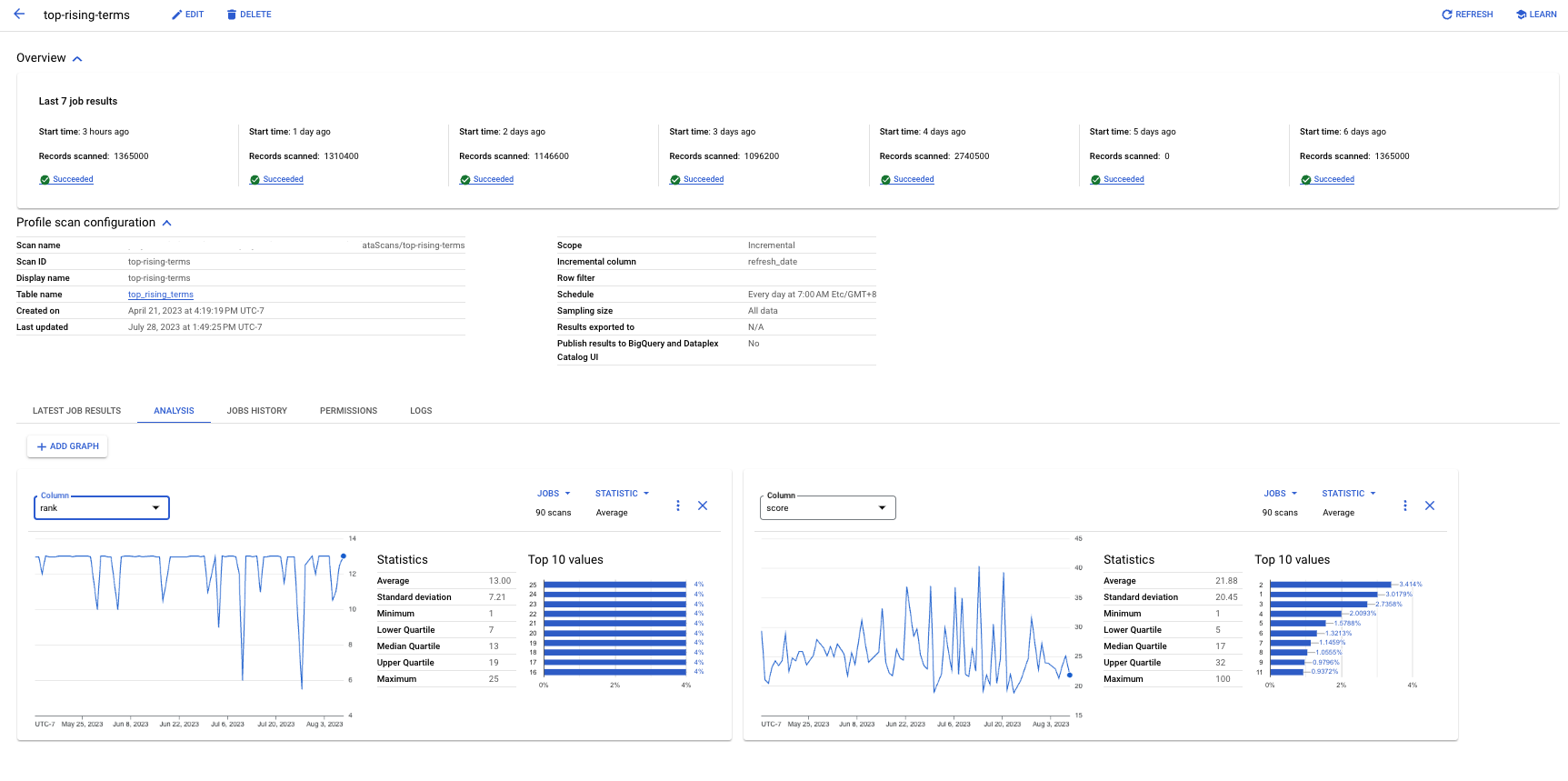

정의된 빈도로 데이터 프로필 스캔을 예약하거나 요청 시 스캔을 실행할 수 있습니다.

범위

스캔할 데이터의 범위를 지정할 수 있습니다.

전체 테이블: 데이터 프로필 스캔에서 전체 테이블이 스캔됩니다. 샘플링, 행 필터, 열 필터는 프로파일링 통계를 계산하기 전에 전체 테이블에 적용됩니다.

증분: 지정한 증분 데이터가 데이터 프로필 스캔에서 스캔됩니다. 증분으로 사용할 테이블의

Date또는Timestamp열을 지정합니다. 일반적으로 이 테이블은 테이블의 파티션을 나눈 열입니다. 샘플링, 행 필터, 열 필터는 프로파일링 통계를 계산하기 전에 증분 데이터에 적용됩니다.

데이터 필터링

행 필터와 열 필터를 사용하여 프로파일링을 위해 스캔할 데이터를 필터링할 수 있습니다. 필터를 사용하면 실행 시간과 비용을 줄이고 민감하거나 유용하지 않은 데이터를 제외할 수 있습니다.

행 필터: 행 필터를 사용하면 특정 기간 또는 특정 세그먼트(예: 리전)의 데이터에 집중할 수 있습니다. 예를 들어 특정 날짜 이전의 타임스탬프를 사용하여 데이터를 필터링할 수 있습니다.

열 필터: 열 필터를 사용하면 데이터 프로필 스캔을 실행할 테이블에서 특정 열을 포함하거나 제외할 수 있습니다.

샘플 데이터

데이터 프로필 스캔을 실행할 수 있도록 데이터에서 샘플링할 레코드의 비율을 지정할 수 있습니다. 더 작은 데이터 샘플에 데이터 프로필 스캔을 만들면 전체 데이터 세트 쿼리 실행 시간과 비용이 줄어들 수 있습니다.

여러 데이터 프로필 스캔

Google Cloud 콘솔을 사용하여 한 번에 데이터 프로필 스캔 여러 개를 만들 수 있습니다. 데이터 세트 하나에서 테이블을 최대 100개까지 선택하고 데이터 세트마다 데이터 프로필 스캔을 만들 수 있습니다. 자세한 내용은 여러 데이터 프로필 스캔 만들기를 참조하세요.

BigQuery 테이블로 스캔 결과 내보내기

추가 분석을 위해 데이터 프로필 스캔 결과를 BigQuery 테이블로 내보낼 수 있습니다. 보고를 맞춤설정하려면 BigQuery 테이블 데이터를 Looker 대시보드에 연결하면 됩니다. 여러 스캔에서 동일한 결과 테이블을 사용하여 집계 보고서를 빌드할 수 있습니다.

데이터 프로파일링 결과

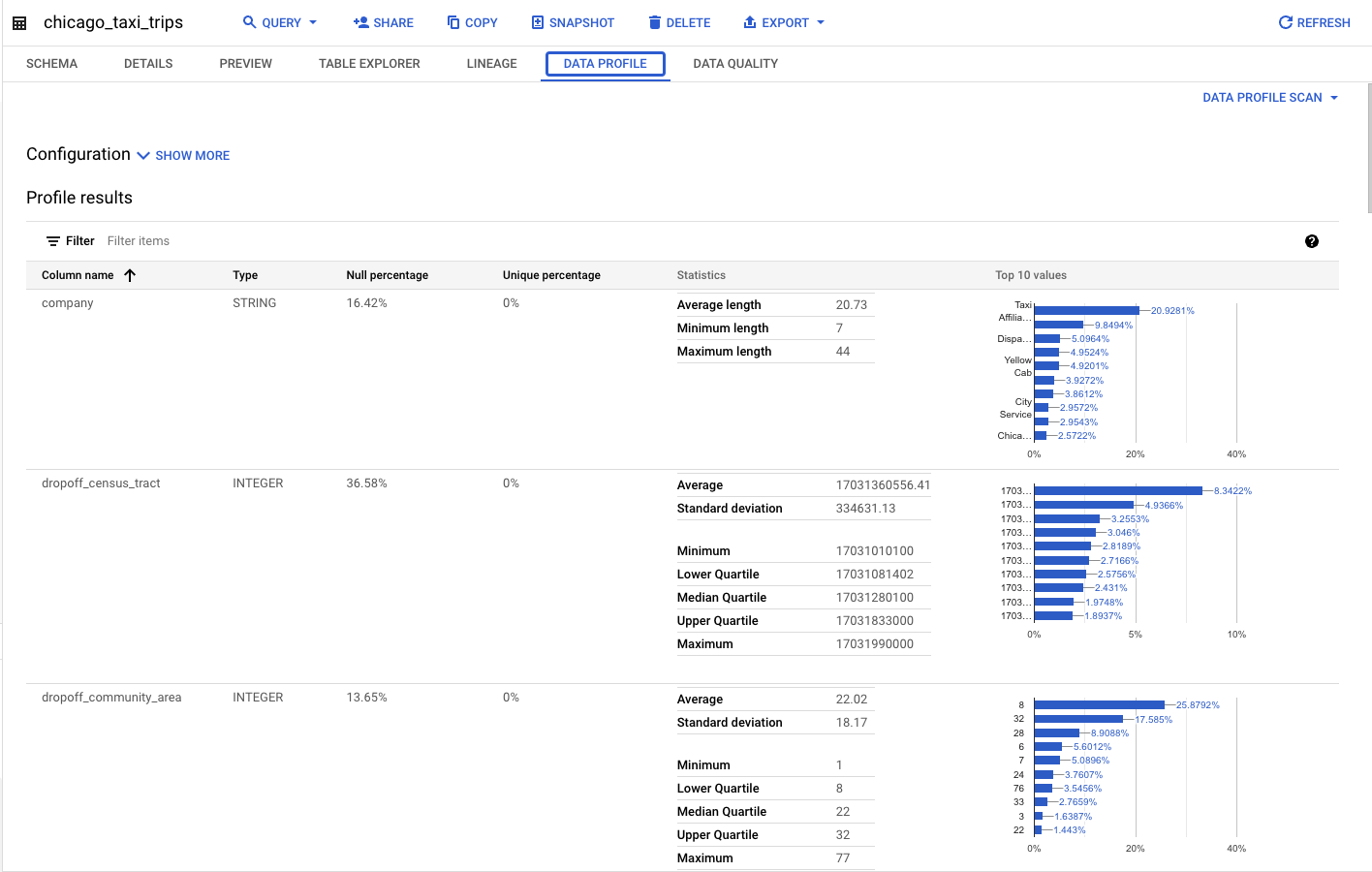

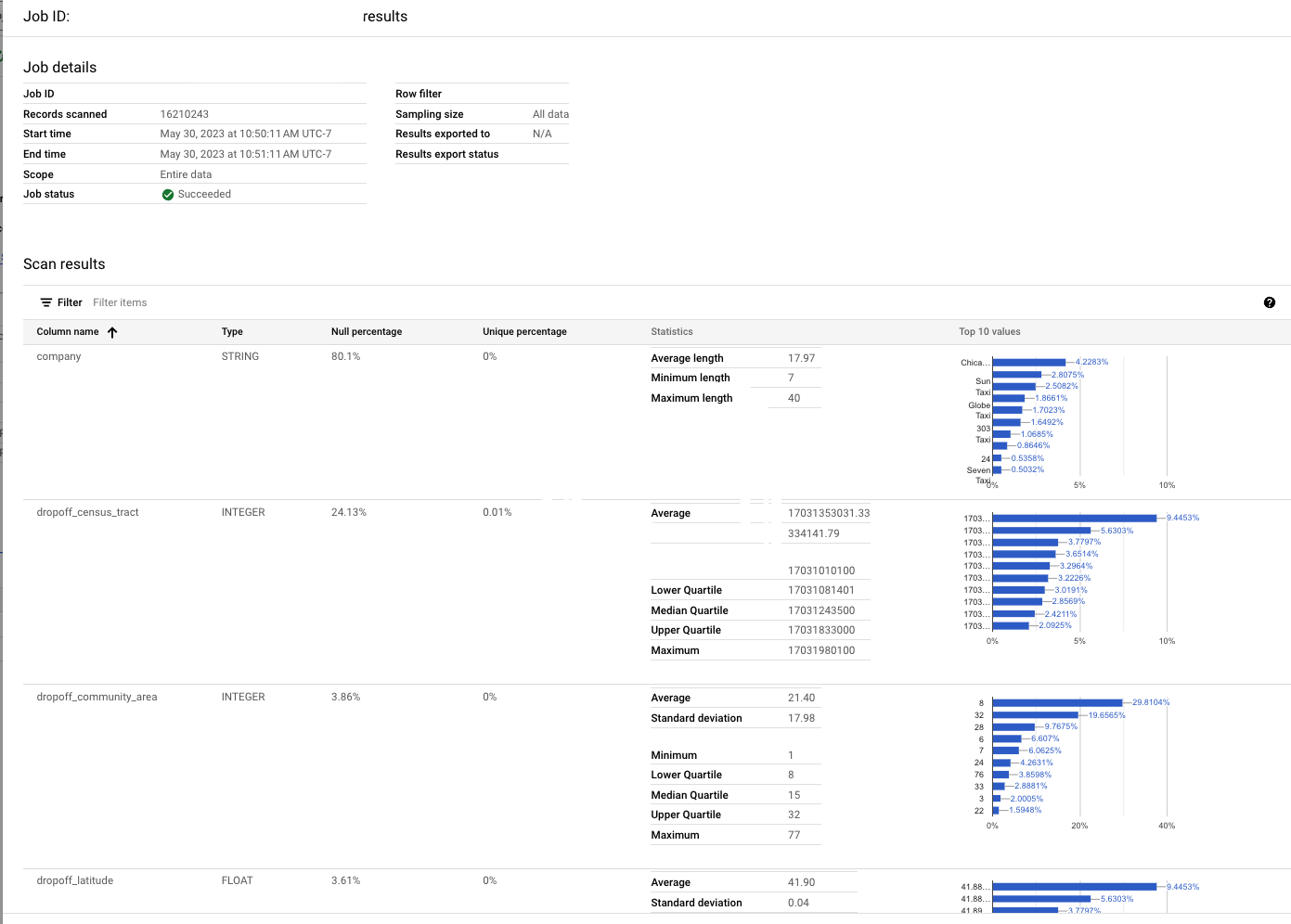

데이터 프로파일링 결과에는 다음 값이 포함됩니다.

| 열 유형 | 데이터 프로파일링 결과 |

|---|---|

| 숫자 열 |

|

| 문자열 열 |

|

| 중첩되지 않은 기타 열(날짜, 시간, 타임스탬프, 바이너리 등) |

|

| 다른 모든 중첩 또는 복합 데이터 유형 열(예: 레코드, 배열, JSON) 또는 반복 모드가 사용된 모든 열. |

|

모든 작업에서 스캔된 레코드 수가 결과에 포함됩니다.

보고 및 모니터링

다음 보고서 및 메서드를 사용하여 데이터 프로파일링 결과를 모니터링하고 분석할 수 있습니다.

BigQuery 및 Dataplex Universal Catalog 페이지에서 소스 테이블과 함께 게시된 보고서

데이터 프로필 스캔에서Google Cloud 콘솔의 BigQuery 및 Dataplex Universal Catalog 페이지에 결과를 게시하도록 구성한 경우 모든 프로젝트의 소스 테이블 데이터 프로필 탭에 있는 해당 페이지에서 최신 데이터 프로필 스캔 결과를 볼 수 있습니다.

작업별 기록 보고서

Dataplex Universal Catalog 및 BigQuery의 데이터 프로파일링 및 품질 > 데이터 프로필 스캔 페이지에서 최신 작업과 이전 작업에 대한 세부 보고서를 볼 수 있습니다. 이러한 보고서에는 열 수준 프로필 정보와 사용된 구성이 포함됩니다.

분석 탭

Dataplex Universal Catalog 및 BigQuery의 데이터 프로파일링 및 품질> 데이터 프로필 스캔 페이지에서 분석 탭을 사용하여 여러 프로필 작업에 대한 특정 열 통계 추세를 볼 수 있습니다. 예를 들어 증분 스캔이 있으면 시간 경과에 따른 값의 평균 추세를 확인할 수 있습니다.

자체 대시보드 또는 분석 빌드

데이터 프로필 스캔에서 결과를 BigQuery 테이블로 내보내도록 구성한 경우 Looker Studio와 같은 도구를 사용하여 자체 대시보드를 빌드할 수 있습니다.

제한사항

- 데이터 프로파일링은

BIGNUMERIC을 제외한 모든 열 유형의 BigQuery 테이블에 지원됩니다.BIGNUMERIC열이 있는 테이블에 대한 스캔을 만들면 검증 오류가 발생하고 생성에 실패합니다.

가격 책정

가격 책정에 대한 자세한 내용은 Dataplex Universal Catalog 가격 책정을 참조하세요.

다음 단계

- 데이터 프로파일링 사용 방법 알아보기

- 자동 데이터 품질 알아보기

- 자동 데이터 품질 사용 방법 알아보기

- 데이터 인사이트를 생성하여 데이터를 탐색하는 방법을 알아보세요.