Dataplex Universal Catalog を使用すると、BigQuery テーブル内のデータの品質を定義して測定できます。データ スキャンを自動化して、定義済みルールに照らしてデータを検証し、データが品質要件を満たしていない場合はアラートを記録できます。自動データ品質を使用すると、データ品質ルールとデプロイメントをコードとして管理することで、データ プロダクション パイプラインの完全性を向上させることができます。

データの異常をスキャンするには、Dataplex Universal Catalog データ プロファイル スキャンをご覧ください。スキャンでデータ品質ルールを生成できます。事前定義された品質ルールを使用することも、カスタムルールを作成することもできます。

Dataplex Universal Catalog には、自動データ品質と統合されたモニタリング、トラブルシューティング、Cloud Logging アラートが用意されています。

概念モデル

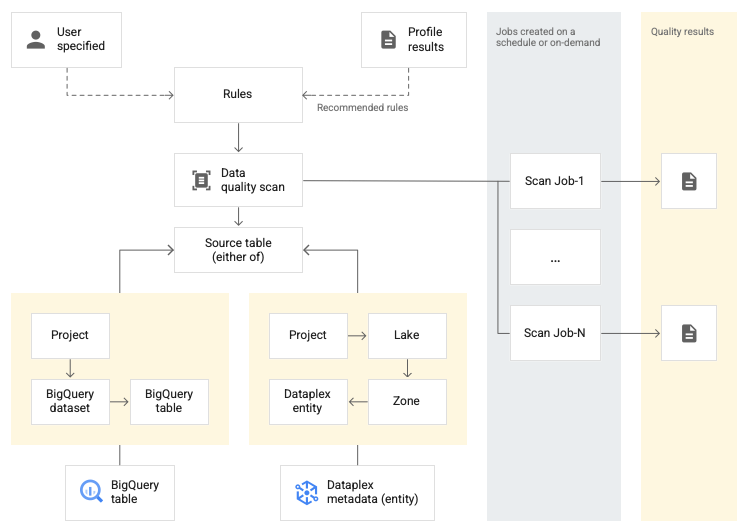

データのスキャンは、BigQuery と Cloud Storage からデータをサンプリングして、さまざまなタイプのメタデータを推測する Dataplex Universal Catalog ジョブです。自動データ品質を使用してテーブルの品質を測定するには、data quality タイプの DataScan オブジェクトを作成します。スキャンは 1 つの BigQuery テーブルでのみ実行されます。スキャンでは Google のテナント プロジェクトのリソースを使用するため、独自のインフラストラクチャを設定する必要はありません。

データ品質スキャンの作成と使用は、次の手順から成ります。

- データ品質ルールを定義する

- ルールの実行を構成する

- データ品質スキャンの結果を分析する

- モニタリングとアラートを設定する

- データ品質エラーのトラブルシューティング

ルールの定義

データ品質スキャンに関連付けられたデータ品質ルールは、データの期待値を定義します。データ品質ルールは次の方法で作成できます。

- Dataplex Universal Catalog のデータ プロファイリングの推奨事項を使用する

- 事前定義ルールを使用する

- カスタム SQL ルールを作成する

事前定義ルール

Dataplex Universal Catalog は、次のカテゴリの事前定義ルールをサポートしています。

- 行レベル

行レベルのカテゴリルールの場合、期待値は各データ行に対して適用されます。各行は独立して条件に合格または不合格になります(例:

column_A_value < 1)。行レベルのチェックでは、合格のしきい値を指定する必要があります。ルールに合格する行の割合がしきい値を下回ると、ルールは不合格となります。

- 集計

集計ルールの場合、データ全体で集計された単一の値に対して期待値が適用されます(例:

Avg(someCol) >= 10)。合格するには、チェックの評価がブール値trueになる必要があります。集計ルールは、行ごとに独立して合格や不合格の回数を示すものではありません。

どちらのルールカテゴリでも、次のパラメータを設定できます。

- ルールが適用される列

- ディメンション

次の表では、サポートされている行レベルと集計ルールの種類を示します。

| ルールタイプ ( Google Cloud コンソールでの名前) |

行レベルルールまたは集計ルール | 説明 | サポートされている列の型 | ルール固有のパラメータ |

|---|---|---|---|---|

RangeExpectation(範囲チェック) |

行レベル | 値が min と max の範囲内にあるかどうかを確認します。 | すべての数値型、日付型、タイムスタンプ型の列。 | 必須:

|

NonNullExpectation(NULL チェック) |

行レベル | 列の値が NULL でないことを確認します。 | サポートされているすべての列の型。 | 必須:

|

SetExpectation(セットのチェック) |

行レベル | 列の値が、セット内の指定された値のいずれかであるかどうかを確認します。 | サポートされているすべての列の型(Record と Struct を除く)。 |

必須:

|

RegexExpectation(正規表現チェック) |

行レベル | 指定された正規表現と値を照合します。 | 文字列 | 必須:

|

Uniqueness(一意性チェック) |

集計 | 列内のすべての値が一意かどうかを確認します。 | サポートされているすべての列の型(Record と Struct を除く)。 |

必須:

|

StatisticRangeExpectation(統計情報のチェック) |

集計 | 指定された統計測定値が範囲の期待値と一致しているかどうかを確認します。 | サポートされているすべての数値列の型。 | 必須:

|

サポートされているカスタム SQL ルールの種類

SQL ルールを使用すると、カスタム ロジックで検証を柔軟に拡張できます。これらのルールには次の種類があります。

| ルールの種類 | 行レベルルールまたは集計ルール | 説明 | サポートされている列の型 | ルール固有のパラメータ | 例 |

|---|---|---|---|---|---|

| 行の条件 | 行レベル |

この式は、たとえば参照整合性チェックを行うために、別テーブルへの参照を含めることができます。 |

すべての列 | 必須:

|

grossWeight <= netWeight |

| テーブル条件 (集計 SQL 式) |

集計 | これらのルールはテーブルごとに 1 回実行されます。ブール値の SQL 式には、式サブクエリを使用して別のテーブルへの参照を含めることができます。 |

すべての列 | 必須:

|

単純な集計の例: 式サブクエリを使用して、別のテーブル全体で値を比較する: |

| SQL アサーション | 集計 | アサーション ルールは、データ品質クエリを使用して、クエリで指定された 1 つ以上の条件を満足しない行を見つけます。無効な状態に一致する行を返すように評価される SQL ステートメントを指定します。クエリで行が返された場合、ルールは不合格となります。 SQL ステートメントの末尾のセミコロンを省略します。 SQL ステートメントには、式サブクエリを使用して別のテーブルへの参照を含めることができます。 |

すべての列 | 必須:

|

式サブクエリを使用して、別のテーブル全体で値を比較する: |

ルールの例については、自動データ品質のサンプルルールをご覧ください。

サポートされている SQL 関数については、GoogleSQL リファレンスをご覧ください。

ディメンション

ディメンションを使用すると、モニタリングとアラートに対する複数のデータ品質ルールの結果を集計できます。すべてのデータ品質ルールをディメンションに関連付ける必要があります。Dataplex Universal Catalog には、次のディメンションが用意されています。

- 鮮度

- 鮮度は、データが最後に更新された日時を測定します。この情報は、データが有用なほど新しいかどうかを判断するのに役立ちます。

- ボリューム

- ボリュームは、想定されるデータがすべて存在するかどうかを測定します。

- 完全性

- 完全性では、データに目的に必要な情報がすべて含まれているかどうかを評価します。

- 有効期間

- 有効性は、データが形式、許容範囲、その他の条件に関する事前定義済みの標準に準拠しているかどうかを評価します。たとえば、有効な日付の形式が

YYYY/mm/ddである場合、08-12-2019 は無効なデータです。別の例として、商品の有効な販売価格が 10~20 ドルの場合、販売価格が 100 ドルは無効なデータです。 - 整合性

- 整合性とは、テーブルや列など、複数のインスタンスでデータの値が同じであることを指します。データの不整合は、たとえば、商品の収益が販売データベースまたは使用状況データベースから読み取られたときに異なる場合に発生します。

- 精度

- 精度はデータの正しさを表します。有効なデータは必ずしも正確であるとは限りません。たとえば、有効な髪の色が茶色だとして、ある人が茶色の髪を持っていない場合、不正確なデータとなります。

- 一意性

- 一意性は、データが重複なく一意かどうかを測定します。

ルールで入力された入力

すべての値パラメータは、文字列値として API に渡されます。Dataplex Universal Catalog では、BigQuery で指定された形式に従った入力が必要です。

バイナリ型のパラメータは、base64 でエンコードされた文字列として渡すことができます。

| タイプ | サポートされている形式 | 例 |

|---|---|---|

| バイナリ | Base64 でエンコードされた値 | YXBwbGU= |

| タイムスタンプ | YYYY-[M]M-[D]D[( |T)[H]H:[M]M:[S]S[.F]] [time_zone] または YYYY-[M]M-[D]D[( |T)[H]H:[M]M:[S]S[.F]][time_zone_offset] |

2014-09-27 12:30:00.45-08 |

| 日付 | YYYY-M[M]-D[D] | 2014-09-27 |

| 時間 | [H]H:[M]M:[S]S[.DDDDDD] | 12:30:00.45 |

| 日時 | YYYY-[M]M-[D]D [[H]H:[M]M:[S]S[.DDDDDD]] | 2014-09-27 12:30:00.45 |

データ参照パラメータ

カスタム SQL ルールを作成する場合、ソーステーブルとそのフィルタを明示的に記述する代わりに、ルールでデータ参照パラメータ ${data()} を使用することで、データソース テーブルとそのすべての前提条件フィルタを参照できます。Dataplex Universal Catalog は、このパラメータをソーステーブルとそのフィルタへの参照として解釈します。前提条件フィルタの例としては、行フィルタ、サンプリング パーセンテージ、増分フィルタなどがあります。

たとえば、my_project_id.dim_dataset.dim_currency というデータソース テーブルがあるとします。新しい日次データに対してのみスキャンする増分データ品質スキャンを実行したいとします。テーブルに、今日のエントリをフィルタする行フィルタ transaction_timestamp >= current_date() が適用されています。

今日の discount_pct を使用して行を見つけるカスタム SQL ルールは、次のようになります。

discount_pct IN (SELECT discount_pct FROM my_project_id.dim_dataset.dim_currency WHERE transaction_timestamp >= current_date())

データ参照パラメータを使用すると、ルールを簡素化できます。テーブルとその前提条件フィルタの記述を ${data()} パラメータに置き換えます。

discount_pct IN (SELECT discount_pct FROM ${data()})

Dataplex Universal Catalog は、${data()} パラメータを、今日のエントリ my_project_id.dim_dataset.dim_currency WHERE transaction_timestamp >= current_date() を含むデータソース テーブルへの参照として解釈します。この例では、データ参照パラメータは増分データのみを参照します。

${data()} パラメータでは大文字と小文字が区別されます。

サブクエリ内でエイリアスを使用して参照元テーブルの列を参照する場合は、データ参照パラメータを使用して参照元テーブルを参照するか、テーブル参照を省略します。WHERE 句で直接テーブル参照を使用して、参照元テーブルの列を参照しないでください。

推奨:

データ参照パラメータを使用して参照元テーブルを参照します。

discount_pct IN ( SELECT discount_pct FROM `my_project_id.dim_dataset.dim_currency` AS temp-table WHERE temp-table.transaction_timestamp = ${data()}.timestamp )テーブル参照を省略します。

discount_pct IN ( SELECT discount_pct FROM `my_project_id.dim_dataset.dim_currency` AS temp-table WHERE temp-table.transaction_timestamp = timestamp )

非推奨:

直接テーブル参照を使用して、参照元テーブルの列を参照しないでください。

discount_pct IN ( SELECT discount_pct FROM `my_project_id.dim_dataset.dim_currency` AS temp-table WHERE temp-table.transaction_timestamp = `my_project_id.dim_dataset.dim_currency`.timestamp )

ルールの実行

データ品質スキャンを特定の間隔で実行するようにスケジュール設定することも、スキャンをオンデマンドで実行することもできます。

データ品質スキャンを実行すると、Dataplex Universal Catalog によってジョブが作成されます。データ品質スキャンの仕様の一部として、ジョブの範囲を次のいずれかに指定できます。

- テーブル全体

- それぞれのジョブでテーブル全体が検証されます。

- 増分

- それぞれのジョブで増分データが検証されます。増分を定めるには、テーブル内にマーカーとして使用可能な

Date/Timestamp列を用意します。通常、これはテーブルが分割される列です。

データをフィルタする

行フィルタを使用してデータ品質のためにスキャンされるデータをフィルタリングできます。行フィルタを作成すると、特定の期間内や特定のセグメント(特定のリージョンなど)のデータにフォーカスできます。フィルタを使用すると、実行時間とコストを削減できます。たとえば、特定の日付より前のタイムスタンプを持つデータを除外できます。

サンプルデータ

データ品質スキャンを実行するために、データからサンプリングするレコードの割合を指定できます。より少ないサンプルのデータでデータ品質スキャンを作成すると、実行時間とデータセット全体のクエリにかかる費用を削減できます。

データ品質スキャンの結果

データ品質スキャンの結果は、Dataplex Universal Catalog と BigQuery で確認できます。次の方法でスキャン結果を確認して分析することもできます。

結果を BigQuery にエクスポートする

スキャン結果を BigQuery テーブルにエクスポートして、さらに分析を行うことができます。レポートをカスタマイズするには、BigQuery テーブルデータを Looker ダッシュボードに接続します。複数のスキャンで同じ結果テーブルを使用することで、集計レポートを作成できます。

結果を Dataplex Universal Catalog のメタデータとして公開する

データ品質スキャンの結果は、Dataplex Universal Catalog のメタデータとして公開できます。最新の結果は、ソーステーブルを表す Dataplex Universal Catalog エントリに

data-quality-scorecardシステム アスペクト タイプで保存されます。結果は、 Google Cloud コンソールのソーステーブルの BigQuery ページと Dataplex Universal Catalog ページにある [データ品質] タブで確認できます。API を使用して結果を取得することもできます。Dataplex Universal Catalog のメタデータの詳細については、Dataplex Universal Catalog のメタデータ管理についてをご覧ください。

データ品質スコアを確認する

各スキャン結果には、合格したルールの割合を示すデータ品質スコアが表示されます。スコアは、ジョブ全体レベル、列レベル(ルールが列に対して評価される場合)、ディメンション レベルで報告されます。データ品質スコアを使用して、テーブルまたは列全体でデータ品質を正規化し、傾向を追跡することで、品質要件を満たしていないデータを特定します。

詳細については、データ品質スキャンの結果を表示するをご覧ください。

モニタリングとアラート

データ品質スキャンをモニタリングしてアラートを取得するには、次の方法を使用します。

Cloud Logging でアラートを設定する

ログ エクスプローラの

data_scanログとdata_quality_scan_rule_resultログを使用して、データ品質ジョブをモニタリングできます。データ品質ジョブごとに、

data_scan_typeフィールドがDATA_QUALITYに設定されたdata_scanログに次の情報が含まれます。- データスキャンに使用されるデータソース。

- ジョブの実行の詳細(作成時間、開始時間、終了時間、ジョブの状態など)。

- データ品質ジョブの結果: 合格または不合格。

- ディメンション レベルの合格または不合格。

成功したすべてのジョブには、

data_quality_scan_rule_resultログが含まれています。このログには、そのジョブ内の各ルールに関する詳細情報が含まれています。- ルール情報、ルールタイプ、評価タイプ、ディメンションなどの構成情報

- 合格または不合格、合計行数、合格行数、null 行数、評価された行数などの結果情報。

ログの情報は、API とGoogle Cloud コンソールで確認できます。この情報を使用して、アラートを設定できます。詳細については、Cloud Logging でアラートを設定するをご覧ください。

メール通知レポートを送信する

データ品質スキャンジョブのステータスと結果に関するアラートを送信するメール通知レポートを送信できます。通知レポートは、次のシナリオで利用できます。

- データ品質スコアが指定した目標スコアより低い

- ジョブが失敗した

- ジョブが完了した

通知レポートは、データ品質スキャンを作成するときに構成します。

データ品質エラーのトラブルシューティング

ルールが不合格となると、Dataplex Universal Catalog は失敗したレコードを取得するクエリを生成します。このクエリを実行して、ルールと一致しなかったレコードを確認できます。詳細については、データ品質エラーのトラブルシューティングをご覧ください。

制限事項

- ルールの推奨事項は gcloud CLI ではサポートされていません。

- ディメンションの選択は、事前定義された 7 つのディメンションのいずれかに固定されます。

- データ品質スキャンあたりのルール数は 1,000 に制限されています。

- 列レベルでレポートされるデータ品質スコアは、API でのみサポートされています。

料金

料金の詳細については、Dataplex Universal Catalog の料金をご覧ください。

次のステップ

- 自動データ品質を使用する方法を確認する。

- データ プロファイリングについて確認する。

- データ プロファイリングを使用する方法を確認する。