Langkah 3: Tentukan mekanisme integrasi

Halaman ini menjelaskan langkah ketiga untuk men-deploy Data Foundation Cortex Framework, yaitu inti Cortex Framework. Pada langkah ini, Anda akan mengonfigurasi integrasi dengan sumber data yang Anda pilih. Jika Anda menggunakan data contoh, lewati langkah ini.

Ringkasan Integrasi

Cortex Framework membantu Anda memusatkan data dari berbagai sumber, bersama dengan platform lainnya. Tindakan ini akan membuat satu sumber tepercaya untuk data Anda. Cortex Data Foundation terintegrasi dengan setiap sumber data dengan cara yang berbeda-beda, tetapi sebagian besar mengikuti prosedur yang serupa:

- Lapisan Source to Raw: Menyerap data dari sumber data ke set data mentah menggunakan API. Hal ini dicapai dengan menggunakan pipeline Dataflow yang dipicu melalui DAG Cloud Composer.

- Lapisan mentah ke lapisan CDC: Terapkan pemrosesan CDC pada set data mentah dan simpan output di set data CDC. Hal ini dilakukan oleh DAG Cloud Composer yang menjalankan SQL BigQuery.

- Lapisan CDC ke Lapisan pelaporan: Membuat tabel pelaporan akhir dari tabel CDC dalam set data Pelaporan. Hal ini dilakukan dengan membuat tampilan runtime di atas tabel CDC atau menjalankan DAG Cloud Composer untuk data terwujud dalam tabel BigQuery - bergantung pada konfigurasinya. Untuk mengetahui informasi selengkapnya tentang konfigurasi, lihat Menyesuaikan file setelan pelaporan.

File config.json mengonfigurasi setelan yang diperlukan untuk terhubung ke sumber data guna mentransfer data dari berbagai beban kerja. Lihat opsi integrasi untuk setiap sumber data di referensi berikut.

- Operasional:

- Pemasaran:

- Keberlanjutan:

Untuk mengetahui informasi selengkapnya tentang Diagram Entitas-Hubungan yang didukung oleh setiap sumber data, lihat folder docs di repositori Cortex Framework Data Foundation.

Deployment K9

Deployer K9 menyederhanakan integrasi berbagai sumber data. Deployer K9 adalah dataset yang telah ditentukan sebelumnya dalam lingkungan BigQuery yang bertanggung jawab untuk menyerap, memproses, dan memodelkan komponen yang dapat digunakan kembali di berbagai sumber data.

Misalnya, dimensi time dapat digunakan kembali di semua sumber data tempat tabel mungkin perlu mengambil hasil analisis berdasarkan kalender Gregorian. Deployer K9 menggabungkan data eksternal seperti cuaca atau Google Trends dengan sumber data lain (misalnya, SAP, Salesforce, Marketing). Kumpulan data yang telah di-enrich ini memungkinkan insight yang lebih mendalam dan analisis yang lebih komprehensif.

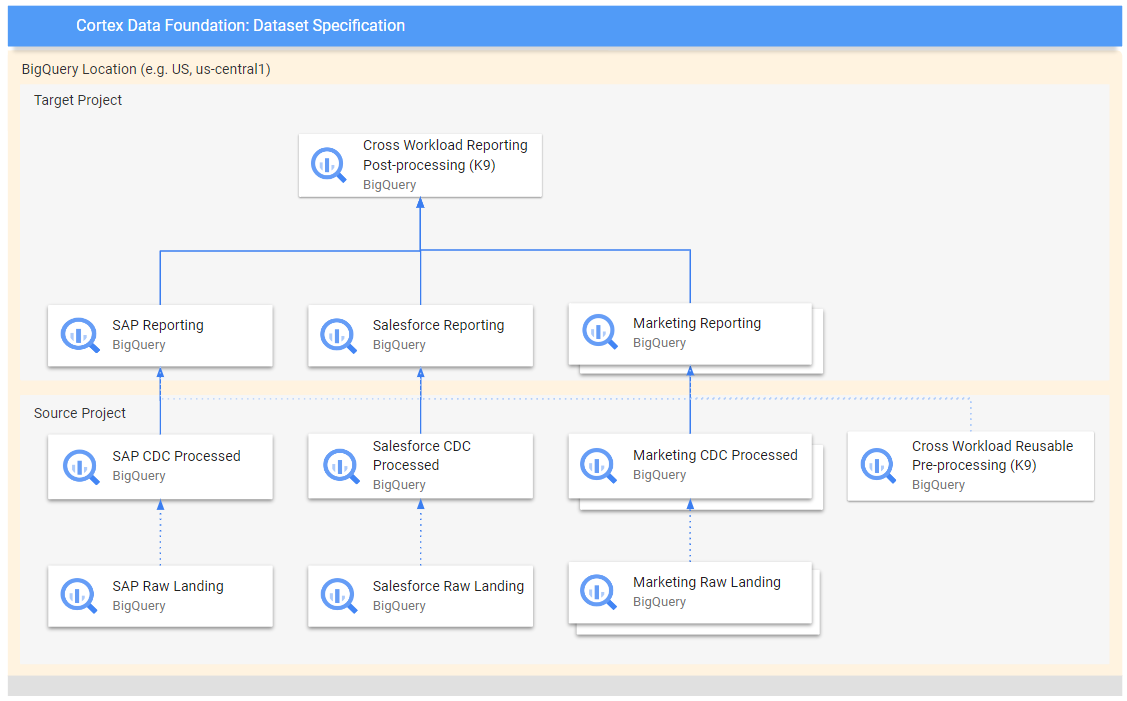

Diagram berikut menunjukkan alur data dari berbagai sumber mentah ke berbagai lapisan pelaporan:

Dalam diagram, project sumber berisi data mentah dari sumber data yang dipilih (SAP, Salesforce, dan Pemasaran). Sementara project target berisi data yang diproses, yang berasal dari proses Pengambilan Data Perubahan (CDC).

Langkah K9 pra-pemrosesan berjalan sebelum semua beban kerja memulai deployment-nya, sehingga model yang dapat digunakan kembali tersedia selama deployment-nya. Langkah ini mengubah data dari berbagai sumber untuk membuat set data yang konsisten dan dapat digunakan kembali.

Langkah-langkah K9 pasca-pemrosesan terjadi setelah semua beban kerja men-deploy model pelaporannya untuk mengaktifkan pelaporan lintas beban kerja atau meningkatkan model untuk menemukan dependensi yang diperlukan dalam setiap set data pelaporan.

Mengonfigurasi deployment K9

Konfigurasi Directed Acyclic Graph (DAG) dan model yang akan dibuat dalam file manifes K9.

Langkah pra-pemrosesan K9 penting karena memastikan bahwa semua workload dalam pipeline data memiliki akses ke data yang disiapkan secara konsisten. Tindakan ini mengurangi redundansi dan memastikan konsistensi data.

Untuk mengetahui informasi selengkapnya tentang cara mengonfigurasi set data eksternal untuk K9, lihat Mengonfigurasi set data eksternal untuk K9.

Langkah berikutnya

Setelah Anda menyelesaikan langkah ini, lanjutkan ke langkah-langkah deployment berikut:

- Menetapkan workload.

- Buat clone repositori.

- Tentukan mekanisme integrasi (halaman ini).

- Menyiapkan komponen.

- Konfigurasi deployment.

- Jalankan deployment.