3단계: 통합 메커니즘 결정

이 페이지에서는 Cortex Framework의 핵심인 Cortex Framework Data Foundation을 배포하는 세 번째 단계를 설명합니다. 이 단계에서는 선택한 데이터 소스와의 통합을 구성합니다. 샘플 데이터를 사용하는 경우 이 단계를 건너뛰세요.

통합 개요

Cortex Framework를 사용하면 다양한 소스와 다른 플랫폼의 데이터를 중앙 집중화할 수 있습니다. 이렇게 하면 데이터의 단일 정보 소스가 생성됩니다. Cortex Data Foundation은 각 데이터 소스와 다양한 방식으로 통합되지만 대부분 유사한 절차를 따릅니다.

- 소스에서 원시 레이어: API를 사용하여 데이터 소스에서 원시 데이터 세트로 데이터를 수집합니다. 이는 Cloud Composer DAG를 통해 트리거되는 Dataflow 파이프라인을 사용하여 달성됩니다.

- 원시 레이어에서 CDC 레이어로: 원시 데이터 세트에 CDC 처리를 적용하고 출력을 CDC 데이터 세트에 저장합니다. 이는 BigQuery SQL을 실행하는 Cloud Composer DAG를 통해 이루어집니다.

- CDC 레이어에서 보고 레이어: 보고 데이터 세트의 CDC 테이블에서 최종 보고 테이블을 만듭니다. 이는 구성 방식에 따라 CDC 테이블 위에 런타임 뷰를 만들거나 BigQuery 테이블의 구체화된 데이터에 대해 Cloud Composer DAG를 실행하여 달성됩니다. 구성 관련 자세한 내용은 보고 설정 파일 맞춤설정을 참고하세요.

config.json 파일은 다양한 워크로드에서 데이터를 전송하기 위해 데이터 소스에 연결하는 데 필요한 설정을 구성합니다. 다음 리소스에서 각 데이터 소스의 통합 옵션을 확인하세요.

- 운영:

- 마케팅:

- 지속 가능성:

각 데이터 소스에서 지원하는 엔티티-관계 다이어그램에 관한 자세한 내용은 Cortex Framework Data Foundation 저장소의 docs 폴더를 참고하세요.

K9 배포

K9 배포자는 다양한 데이터 소스의 통합을 간소화합니다. K9 배포자는 BigQuery 환경 내에 사전 정의된 데이터 세트로, 다양한 데이터 소스에서 재사용할 수 있는 구성요소를 수집, 처리, 모델링하는 역할을 합니다.

예를 들어 time 측정기준은 테이블이 그레고리력에 기반한 분석 결과를 가져와야 할 수 있는 모든 데이터 소스에서 재사용할 수 있습니다. K9 배포자는 날씨나 Google 트렌드와 같은 외부 데이터를 다른 데이터 소스(예: SAP, Salesforce, 마케팅)와 결합합니다. 이렇게 풍부해진 데이터 세트를 사용하면 더 깊은 통찰력을 얻고 더 포괄적인 분석을 할 수 있습니다.

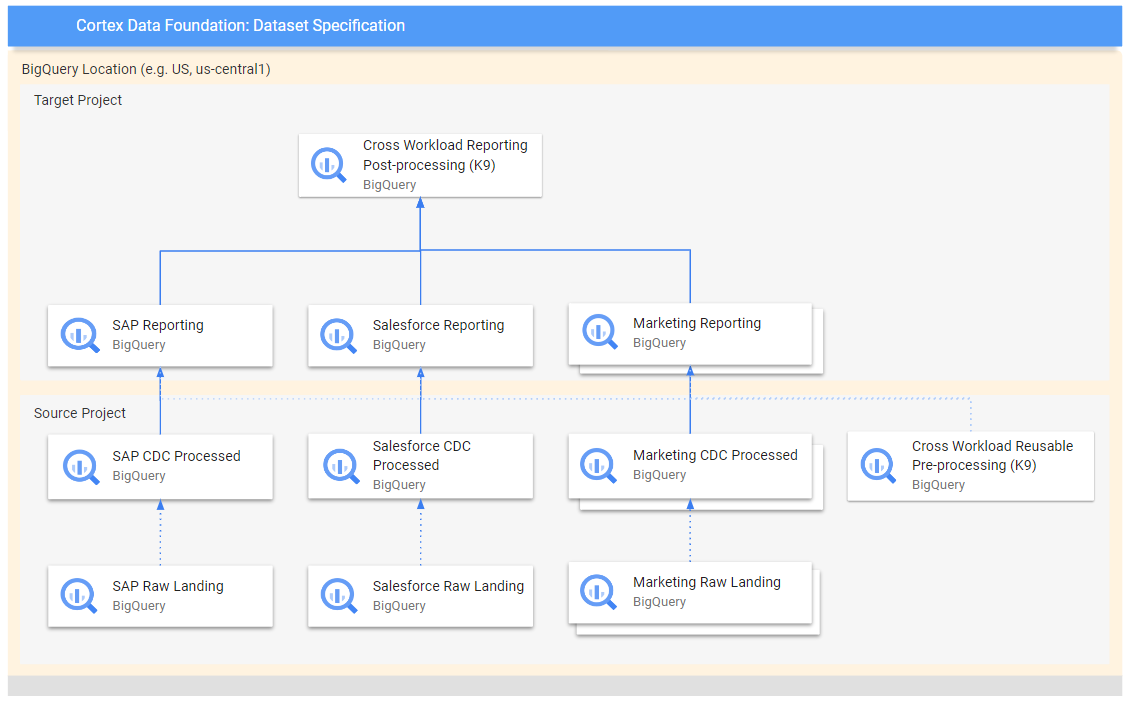

다음 다이어그램은 다양한 원시 소스에서 다양한 보고 레이어로의 데이터 흐름을 보여줍니다.

다이어그램에서 소스 프로젝트에는 선택한 데이터 소스 (SAP, Salesforce, 마케팅)의 원시 데이터가 포함되어 있습니다. 타겟 프로젝트에는 변경 데이터 캡처 (CDC) 프로세스에서 파생된 처리된 데이터가 포함됩니다.

사전 처리 K9 단계는 모든 워크로드가 배포를 시작하기 전에 실행되므로 재사용 가능한 모델은 배포 중에 사용할 수 있습니다. 이 단계에서는 다양한 소스의 데이터를 변환하여 일관되고 재사용 가능한 데이터 세트를 만듭니다.

후처리 K9 단계는 모든 워크로드가 교차 워크로드 보고를 지원하거나 각 개별 보고 데이터 세트 내에서 필요한 종속 항목을 찾기 위해 모델을 보강하도록 보고 모델을 배포한 후에 발생합니다.

K9 배포 구성

K9 매니페스트 파일에서 생성할 방향성 비순환 그래프 (DAG)와 모델을 구성합니다.

K9 사전 처리 단계는 데이터 파이프라인 내의 모든 워크로드가 일관되게 준비된 데이터에 액세스할 수 있도록 하므로 중요합니다. 이렇게 하면 중복이 줄어들고 데이터 일관성이 보장됩니다.

K9의 외부 데이터 세트를 구성하는 방법에 대한 자세한 내용은 K9의 외부 데이터 세트 구성을 참고하세요.

다음 단계

이 단계를 완료한 후 다음 배포 단계로 이동합니다.