Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

En esta página, se describe cómo actualizar tu entorno a una versión nueva de Cloud Composer o Airflow.

Acerca de las operaciones de actualización

Puedes actualizar Cloud Composer, la versión de Airflow o ambos al mismo tiempo.

Cuando cambias la versión de Airflow o Cloud Composer que usa tu entorno, sucede lo siguiente:

Cloud Composer vuelve a implementar los componentes de tu entorno con versiones nuevas de las imágenes de Cloud Composer.

Cloud Composer aplica cambios de configuración de Airflow, como paquetes de PyPI personalizados o anulaciones de opciones de configuración de Airflow, si tu entorno los tenía antes de la actualización.

Cloud Composer actualiza la conexión

airflow_dbde Airflow para que apunte a la nueva base de datos de Cloud SQL.

La actualización no cambia la forma en que te conectas a los recursos de tu entorno, como la URL del bucket de tu entorno o el servidor web de Airflow.

Limitaciones de las operaciones de actualización

Las operaciones de actualización tienen las siguientes limitaciones:

- No puedes pasar a una versión anterior de Cloud Composer o Airflow.

En la consola de Google Cloud, solo puedes actualizar a las versiones más recientes compatibles de Cloud Composer.

En Google Cloud CLI, la API o Terraform, puedes actualizar un entorno a las versiones compatibles más recientes, tres versiones anteriores de Cloud Composer, la última versión de parche de la versión menor anterior y a versiones con un cronograma de actualización extendido. No es posible actualizar a otras versiones de Cloud Composer, incluso si aún son compatibles y se pueden usar para crear un entorno nuevo.

La versión a la que actualices debe ser compatible con la versión de Python actual de tu entorno.

Los límites de cuota de la API de Compute Engine pueden impedir las actualizaciones. En la consola de Google Cloud, navega a la página IAM y administración > Cuotas y límites del sistema y verifica si no se supera la cuota de la API de Compute Engine para la CPU. Si se acerca el límite de la cuota, solicita una extensión de la cuota antes de continuar con la operación de actualización.

No es posible actualizar a una versión principal diferente de Cloud Composer o Airflow sin cambiar de entorno. Puedes transferir manualmente los DAG y la configuración entre entornos. Para obtener más información, consulte:

No puedes actualizar el entorno si la base de datos de Airflow contiene más de 16 GB de datos. Durante una actualización, se muestra una advertencia si el tamaño de la base de datos de Airflow es superior a 16 GB. En este caso, realiza el mantenimiento de la base de datos para reducir el tamaño de la base de datos.

Si usas el mecanismo XCom para transferir archivos, asegúrate de usarlo de acuerdo con los lineamientos de Airflow. La transferencia de archivos grandes o una gran cantidad de archivos con XCom afecta el rendimiento de la base de datos de Airflow y puede provocar fallas cuando se cargan instantáneas o se actualiza el entorno. Considera usar alternativas como Cloud Storage para transferir grandes volúmenes de datos.

Antes de comenzar

Te recomendamos crear una instantánea nueva del entorno para poder volver a crearlo en caso de que sea necesario.

Tu cuenta debe tener una función que pueda activar las operaciones de actualización del entorno. Además, la cuenta de servicio del entorno debe tener un rol que tenga suficientes permisos para realizar operaciones de actualización. Para obtener más información, consulta Control de acceso.

Comprueba que tu entorno esté actualizado

Cloud Composer muestra advertencias cuando la imagen de tu entorno se acerca a la fecha de finalización de la asistencia completa. Puedes usar estas advertencias para mantener siempre tu entorno compatible.

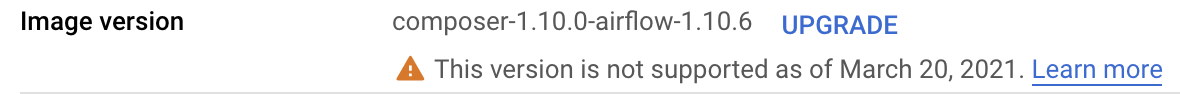

Cloud Composer realiza un seguimiento de la versión con imágenes de Cloud Composer en la que se basa tu entorno. Cuando se acerque la fecha de finalización de la compatibilidad, podrás ver una advertencia en la lista de entornos y en la página Detalles del entorno.

Para comprobar si tu entorno está actualizado, haz lo siguiente:

Console

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Detalles del entorno.

Ve a la pestaña Configuración del entorno.

En el campo Versión de la imagen, se muestra uno de los siguientes mensajes:

Versión disponible más reciente: Tu imagen de entorno es totalmente compatible.

Nueva versión disponible: La imagen de tu entorno es completamente compatible y puedes actualizarla a una versión posterior.

La compatibilidad con esta versión de imagen finaliza en… La imagen del entorno se acerca al final del período de asistencia completa.

Esta versión no es compatible desde… Tu entorno pasó el período de asistencia completa.

gcloud

Esta funcionalidad no está disponible a través de Google Cloud CLI. En su lugar, puedes ver las actualizaciones disponibles, que muestra las versiones nuevas que están disponibles.

API

Esta funcionalidad no está disponible a través de la API. En su lugar, puedes ver las actualizaciones disponibles, que muestra las versiones nuevas que están disponibles.

Cómo ver las actualizaciones disponibles

Para ver las versiones de Cloud Composer a las que puedes actualizar, sigue estos pasos:

Console

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Detalles del entorno.

Ve a la pestaña Configuración del entorno y haz clic en Actualizar versión con imágenes.

Para ver la lista de versiones disponibles, haz clic en el menú desplegable Versión con imágenes de Cloud Composer.

gcloud

gcloud composer environments list-upgrades \

ENVIRONMENT_NAME \

--location LOCATION

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno.

Ejemplo:

gcloud composer environments list-upgrades example-environment \

--location us-central1

API

Puedes ver las versiones disponibles para una ubicación. Para ello, crea una solicitud a la API de imageVersions.list.

Por ejemplo:

// GET https://composer.googleapis.com/v1/projects/example-project/

// locations/us-central1/imageVersions

Verifica los conflictos de paquetes de PyPI antes de la actualización

Puedes verificar si los paquetes de PyPI instalados en tu entorno tienen conflictos con los paquetes preinstalados en la imagen nueva de Cloud Composer.

Una verificación exitosa significa que no hay conflictos en las dependencias de paquetes de PyPI entre la versión actual y la especificada. Sin embargo, es posible que una operación de actualización aún no sea exitosa por otros motivos.

Console

Para ejecutar una verificación de actualización en tu entorno, haz lo siguiente:

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Detalles del entorno.

Ve a la pestaña Configuración del entorno, busca la entrada Versión con imágenes y haz clic en Actualizar.

En el cuadro de diálogo Actualización de la versión del entorno, en la lista desplegable Versión nueva, selecciona la versión de Cloud Composer a la que deseas actualizar.

En la sección Compatibilidad de paquetes de PyPI, haz clic en Verificar la presencia de conflictos.

Espera hasta que se complete la verificación. Si hay conflictos de dependencia de paquetes de PyPI, los mensajes de error que se muestran contienen detalles sobre los paquetes y las versiones de paquetes en conflicto.

gcloud

Para ejecutar una verificación de actualización en tu entorno, ejecuta el comando environments check-upgrade con la versión con imágenes de Cloud Composer a la que quieres actualizar.

gcloud composer environments check-upgrade \

ENVIRONMENT_NAME \

--location LOCATION \

--image-version VERSION

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno.VERSIONpor la nueva versión con imágenes de Cloud Composer a la que deseas actualizar, en formatocomposer-a.b.c-airflow-x.y.z. También puedes usar todos los alias de versión.

Ejemplo:

gcloud composer environments check-upgrade example-environment \

--location us-central1 \

--image-version composer-1.20.12-airflow-1.10.15

Resultado de ejemplo:

Waiting for [projects/example-project/locations/us-central1/environments/

example-environment] to be checked for PyPI package conflicts when upgrading

to composer-1.20.12-airflow-1.10.15. Operation [projects/example-project/locations/

us-central1/operations/04d0e8b2-...]...done.

...

Response:

'@type': type.googleapis.com/

google.cloud.orchestration.airflow.service.v1.CheckUpgradeResponse

buildLogUri: https://console.cloud.google.com/cloud-build/builds/79738aa7-...

containsPypiModulesConflict: CONFLICT

pypiConflictBuildLogExtract: |-

The Cloud Build image build failed: Build failed; check build logs for

details. Full log can be found at https://console.cloud.google.com/

cloud-build/builds/79738aa7-...

Error details: tensorboard 2.2.2 has requirement

setuptools>=41.0.0, but you have setuptools 40.3.0.

Como alternativa, puedes ejecutar una verificación de actualización de forma asíncrona. Usa el argumento --async para realizar una llamada asíncrona y, luego, verifica el resultado con el comando gcloud composer operations describe.

API

Realiza una solicitud a la API de environments.checkUpgrade.

Especifica la versión con imágenes en el campo imageVersion:

{

"imageVersion": "VERSION"

}

Reemplaza VERSION por la versión nueva a la que deseas actualizar, en el formato composer-a.b.c-airflow-x.y.z.

Actualiza tu entorno

Para actualizar tu entorno a una versión posterior de Cloud Composer o Airflow, sigue estos pasos:

Console

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Detalles del entorno.

Ve a la pestaña Configuración del entorno.

Busca el elemento Versión con imágenes y haz clic en Actualizar.

En el menú desplegable Versión con imágenes, selecciona una versión de Cloud Composer a la que deseas actualizar.

Haz clic en Actualizar.

gcloud

gcloud composer environments update \

ENVIRONMENT_NAME \

--location LOCATION \

--image-version VERSION

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno.VERSIONpor la nueva versión con imágenes de Cloud Composer a la que deseas actualizar, en formatocomposer-a.b.c-airflow-x.y.z. También puedes usar todos los alias de versión.

Por ejemplo:

gcloud composer environments update

example-environment \

--location us-central1 \

--image-version composer-1.20.12-airflow-1.10.15

API

Realiza una solicitud a la API de

environments.patch.En esta solicitud, realiza lo siguiente:

En el parámetro

updateMask, especifica la máscaraconfig.softwareConfig.imageVersion.En el cuerpo de la solicitud, en el campo

imageVersion, especifica una versión nueva a la que deseas actualizar.

Por ejemplo:

// PATCH https://composer.googleapis.com/v1/projects/example-project/

// locations/us-central1/environments/example-environment?updateMask=

// config.softwareConfig.imageVersion

{

"config": {

"softwareConfig": {

"imageVersion": "composer-1.20.12-airflow-1.10.15"

}

}

}

Terraform

El campo image_version en el bloque config.software_config controla la imagen de Cloud Composer de tu entorno. En este campo, especifica una nueva imagen de Cloud Composer.

resource "google_composer_environment" "example" {

provider = google-beta

name = "ENVIRONMENT_NAME"

region = "LOCATION"

config {

software_config {

image_version = "VERSION"

}

}

}

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno. la nueva versión con imágenes de Cloud Composer a la que deseas actualizar, en formatocomposer-a.b.c-airflow-x.y.zTambién puedes usar todos los alias de versión.

Ejemplo:

resource "google_composer_environment" "example" {

provider = google-beta

name = "example-environment"

region = "us-central1"

config {

software_config {

image_version = "composer-1.20.12-airflow-1.10.15"

}

}

}