Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

本页面介绍常见工作流问题的问题排查步骤和信息。

许多 DAG 执行问题都是由非最佳环境性能引起的。 您可以按照优化环境性能和费用指南优化环境。

某些 DAG 执行问题可能是由 Airflow 调度程序无法正常或最佳运行引起的。请按照调度程序问题排查说明解决这些问题。

排查工作流问题

要开始排查问题,请按如下所述操作:

检查 Airflow 日志。

您可以通过替换以下 Airflow 配置选项来提高 Airflow 的日志记录级别。

部分 键 值 logginglogging_level默认值为 INFO。 设置为DEBUG可在日志消息中获得更高的详细程度。查看监控信息中心。

查看 Cloud Monitoring。

在 Google Cloud 控制台中,检查环境的组件对应的页面上是否存在错误。

在 Airflow 网页界面中,检查相应 DAG 的 Graph View 中是否显示失败的任务实例。

部分 键 值 webserverdag_orientationLR、TB、RL或BT

调试运算符故障

要调试某个操作器的故障,请执行以下操作:

- 检查任务特定的错误。

- 检查 Airflow 日志。

- 查看 Cloud Monitoring。

- 检查特定于运营商的日志。

- 修正错误。

- 将 DAG 上传到

/dags文件夹。 - 在 Airflow 网页界面中,清除该 DAG 的过往状态。

- 恢复或运行该 DAG。

排查任务执行问题

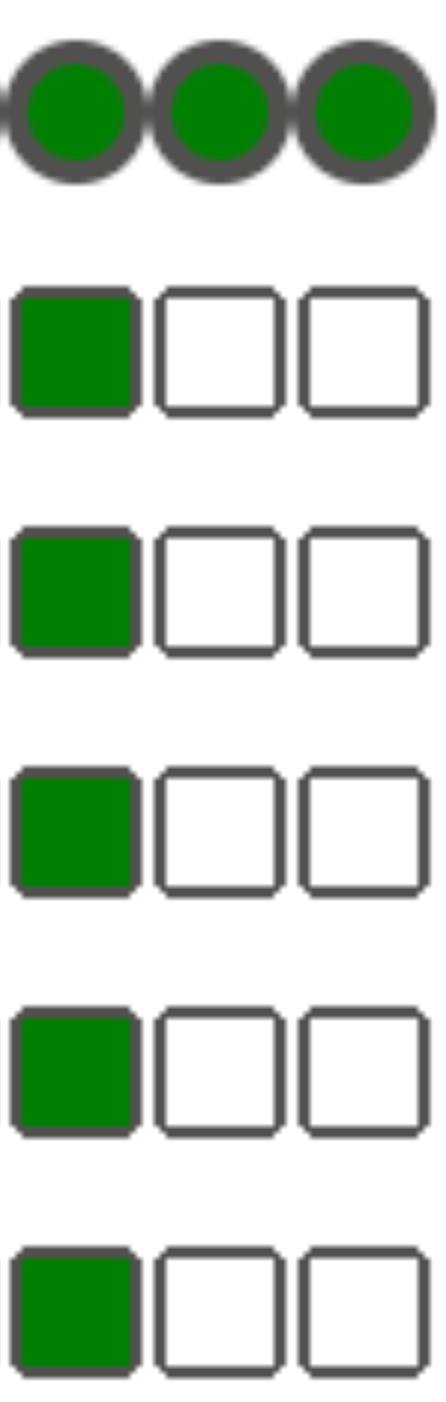

Airflow 是一个分布式系统,包含许多实体,例如调度器、执行器、工作器,这些实体通过任务队列和 Airflow 数据库相互通信,并发送信号(例如 SIGTERM)。下图显示了 Airflow 组件之间的互连概览。

在 Airflow 这样的分布式系统中,可能会出现一些网络连接问题,或者底层基础架构可能会遇到间歇性问题;这可能会导致任务失败并重新安排执行,或者任务可能无法成功完成(例如,僵尸任务或卡在执行中的任务)。Airflow 具有处理此类情况的机制,可自动恢复正常运行。以下部分介绍了 Airflow 在执行任务期间发生的常见问题。

任务失败且没有发出任何日志

由于 DAG 解析错误,任务失败且没有发出日志

有时,可能会出现细微的 DAG 错误,导致 Airflow 调度器可以安排任务执行,DAG 处理器可以解析 DAG 文件,但随后 Airflow 工作器因 DAG 文件中存在编程错误而无法执行 DAG 中的任务。这可能会导致 Airflow 任务被标记为 Failed,但没有执行日志。

解决方案:

在 Airflow 工作器日志中验证,Airflow 工作器是否未因 DAG 缺失或 DAG 解析错误而引发任何错误。

增加与 DAG 解析相关的参数:

将 [dagbag-import-timeout][ext-airflow-dagrun-import-timeout] 增加到至少 120 秒(或根据需要增加到更长时间)。

将 dag-file-processor-timeout 增加到至少 180 秒(或根据需要增加到更长时间)。此值必须高于

dagbag-import-timeout。

另请参阅排查 DAG 处理器问题。

任务突然中断

在任务执行期间,Airflow worker 可能会因与任务本身无关的问题而突然终止,请参阅常见根本原因,了解此类情况的列表和可能的解决方案。以下各部分将介绍可能由这些根本原因引起的一些其他症状:

僵尸任务

Airflow 会检测到任务与执行该任务的进程之间存在两种不匹配情况:

僵尸任务是指本应运行但未运行的任务。如果任务的进程被终止或未响应,如果 Airflow 工作器因过载而未及时报告任务状态,或者如果执行任务的虚拟机已关闭,则可能会发生这种情况。Airflow 会定期查找此类任务,并根据任务的设置使任务失败或重试任务。

发现僵尸任务

resource.type="cloud_composer_environment" resource.labels.environment_name="ENVIRONMENT_NAME" log_id("airflow-scheduler") textPayload:"Detected zombie job"僵尸任务是指不应运行的任务。Airflow 会定期查找此类任务并将其终止。

如需详细了解如何排查僵尸任务问题,请参阅常见根本原因。

SIGTERM 信号

Linux、Kubernetes、Airflow 调度器和 Celery 使用 SIGTERM 信号来终止负责运行 Airflow 工作器或 Airflow 任务的进程。

在环境中发送 SIGTERM 信号的原因可能有多种:

任务已成为僵尸任务,必须停止。

调度程序发现任务重复,并向任务发送“正在终止实例”和 SIGTERM 信号以停止任务。

在 Pod 横向自动扩缩中,GKE 控制平面会发送 SIGTERM 信号来移除不再需要的 Pod。

调度器可以向 DagFileProcessorManager 进程发送 SIGTERM 信号。调度程序使用此类 SIGTERM 信号来管理 DagFileProcessorManager 进程生命周期,可以安全地忽略这些信号。

示例:

Launched DagFileProcessorManager with pid: 353002 Sending Signals.SIGTERM to group 353002. PIDs of all processes in the group: [] Sending the signal Signals.SIGTERM to group 353002 Sending the signal Signals.SIGTERM to process 353002 as process group is missing.local_task_job 中心跳回调与退出回调之间的竞态条件,用于监控任务的执行。如果心跳检测到某个任务被标记为成功,则无法区分是任务本身成功,还是 Airflow 被告知将该任务视为成功。不过,它会终止任务运行程序,而无需等待其退出。

您可以放心地忽略此类 SIGTERM 信号。相应任务已处于成功状态,DAG 运行的整体执行不会受到影响。

日志条目

Received SIGTERM.是常规退出与成功状态下的任务终止之间的唯一区别。图 2. 心跳和退出回调之间的竞态条件(点击可放大) Airflow 组件使用的资源(CPU、内存)超出集群节点允许的范围。

GKE 服务会执行维护操作,并向即将升级的节点上运行的 Pod 发送 SIGTERM 信号。

当任务实例因 SIGTERM 而终止时,您可以在执行该任务的 Airflow 工作器的日志中看到以下日志条目:

{local_task_job.py:211} WARNING - State of this instance has been externally set to queued. Terminating instance. {taskinstance.py:1411} ERROR - Received SIGTERM. Terminating subprocesses. {taskinstance.py:1703} ERROR - Task failed with exception

可能的解决方案:

当运行任务的虚拟机的内存不足时,就会出现此问题。这与 Airflow 配置无关,而是与虚拟机可用的内存量有关。

在 Cloud Composer 2 中,您可以为 Airflow 工作器分配更多 CPU 和内存资源。

您可以降低

[celery]worker_concurrency并发 Airflow 配置选项的值。此选项决定了给定的 Airflow 工作器同时执行的任务数量。

如需详细了解如何优化环境,请参阅优化环境性能和费用。

Airflow 任务被 Negsignal.SIGKILL 中断

有时,您的任务使用的内存可能超过 Airflow 工作器分配的内存。在这种情况下,它可能会被 Negsignal.SIGKILL 中断。系统会发送此信号,以避免进一步消耗内存,从而影响其他 Airflow 任务的执行。在 Airflow worker 的日志中,您可能会看到以下日志条目:

{local_task_job.py:102} INFO - Task exited with return code Negsignal.SIGKILL

Negsignal.SIGKILL 也可能会显示为代码 -9。

可能的解决方案:

降低 Airflow 工作器的

worker_concurrency。增加 Airflow 工作器可用的内存量。

在 Cloud Composer 中,使用 KubernetesPodOperator 或 GKEStartPodOperator 管理资源密集型任务,以实现任务隔离和自定义资源分配。

优化任务以减少内存用量。

任务因资源压力而失败

症状:在执行任务期间,负责执行 Airflow 任务的 Airflow 工作器的子进程突然中断。Airflow 工作器的日志中显示的错误可能类似于以下内容:

...

File "/opt/python3.8/lib/python3.8/site-packages/celery/app/trace.py", line 412, in trace_task R = retval = fun(*args, **kwargs) File "/opt/python3.8/lib/python3.8/site-packages/celery/app/trace.py", line 704, in __protected_call__ return self.run(*args, **kwargs) File "/opt/python3.8/lib/python3.8/site-packages/airflow/executors/celery_executor.py", line 88, in execute_command _execute_in_fork(command_to_exec) File "/opt/python3.8/lib/python3.8/site-packages/airflow/executors/celery_executor.py", line 99, in _execute_in_fork

raise AirflowException('Celery command failed on host: ' + get_hostname())airflow.exceptions.AirflowException: Celery command failed on host: airflow-worker-9qg9x

...

解决方案:

在 Cloud Composer 2 中,增加内存限制以供 Airflow 工作器使用。

如果您的环境也生成了僵尸任务,请参阅排查僵尸任务问题。

如需查看有关调试内存不足问题的教程,请参阅调试内存不足和存储空间不足 DAG 问题。

任务因 Pod 逐出而失败

Google Kubernetes Engine pod 受到 Kubernetes pod 生命周期和 pod 逐出的约束。 在 Cloud Composer 中,任务高峰是导致 pod 逐出的最常见原因。

当特定 Pod 过度使用某个节点的资源(相对于该节点配置的资源消耗预期)时,可能会发生 Pod 逐出。例如,当一个 Pod 中运行多个内存密集型任务时,系统可能会执行逐出,并且这些任务的组合负载会导致该 Pod 运行的节点超出内存消耗限制。

如果 Airflow 工作器 Pod 被逐出,则该 Pod 上运行的所有任务实例都会中断,之后被 Airflow 标记为失败。

日志被缓冲。如果工作器 Pod 在缓冲区刷新之前被逐出,则不会发出日志。如果任务失败且没有日志,则表示 Airflow 工作器已因内存不足 (OOM) 重启。即使未发出 Airflow 日志,Cloud Logging 中也可能存在一些日志。

要查看日志,请执行以下操作:

在 Google Cloud 控制台中,前往环境页面。

在环境列表中,点击您的环境名称。环境详情页面会打开。

前往日志标签页。

在所有日志 > Airflow 日志 > 工作器下查看各个 Airflow 工作器的日志。

具体情况:

在 Google Cloud 控制台中,前往工作负载页面。

如果存在显示

Evicted的airflow-workerPod,请点击每个被逐出的 pod 并查看窗口顶部的The node was low on resource: memory消息。

解决方案:

检查来自

airflow-workerpod 的日志,了解可能的逐出原因。如需详细了解如何从各个 Pod 提取日志,请参阅已部署工作负载的问题排查。确保 DAG 中的任务遵循幂等原则且可重试。

避免将不必要的文件下载到 Airflow worker 的本地文件系统。

Airflow worker 的本地文件系统容量有限。 Airflow 工作器的存储空间可以从 1 GB 到 10 GB 不等。 当存储空间用完时,Airflow 工作器 Pod 会被 GKE 控制平面逐出。这会导致被逐出的工作器正在执行的所有任务失败。

问题操作示例:

- 下载文件或对象,并将其本地存储在 Airflow worker 中。请改为将这些对象直接存储在合适的服务中,例如 Cloud Storage 存储桶。

- 从 Airflow 工作器访问

/data文件夹中的大型对象。 Airflow 工作器会将对象下载到其本地文件系统。请改为实现 DAG,以便在 Airflow 工作器 Pod 之外处理大型文件。

常见根本原因

Airflow 工作器内存不足

每个 Airflow 工作器最多可以同时运行 [celery]worker_concurrency 个任务实例。如果这些任务实例的累计内存消耗量超过 Airflow 工作器的内存限制,系统会终止该工作器上的随机进程以释放资源。

发现 Airflow 工作器内存不足事件

resource.type="k8s_node"

resource.labels.cluster_name="GKE_CLUSTER_NAME"

log_id("events")

jsonPayload.message:"Killed process"

jsonPayload.message:("airflow task" OR "celeryd")有时,Airflow 工作器的内存不足会导致在 SQL Alchemy 会话期间向数据库、DNS 服务器或 DAG 调用的任何其他服务发送格式错误的数据包。在这种情况下,连接的另一端可能会拒绝或断开来自 Airflow worker 的连接。例如:

"UNKNOWN:Error received from peer

{created_time:"2024-11-31T10:09:52.217738071+00:00", grpc_status:14,

grpc_message:"failed to connect to all addresses; last error: UNKNOWN:

ipv4:<ip address>:443: handshaker shutdown"}"

解决方案:

优化任务以减少内存使用量,例如避免使用顶级代码。

减少

[celery]worker_concurrency。增加 Airflow 工作器的内存,以适应

[celery]worker_concurrency更改。在低于 2.6.0 的 Cloud Composer 2 版本中,如果

[celery]worker_concurrency的值较低,请使用当前公式更新该值。

Airflow worker 被逐出

Pod 逐出是在 Kubernetes 上运行工作负载的正常部分。如果 Pod 耗尽存储空间,或者为了为优先级更高的工作负载释放资源,GKE 会逐出这些 Pod。

了解 Airflow 工作器逐出

resource.type="k8s_pod"

resource.labels.cluster_name="GKE_CLUSTER_NAME"

resource.labels.pod_name:"airflow-worker"

log_id("events")

jsonPayload.reason="Evicted"解决方案:

- 如果因存储空间不足而发生逐出,您可以减少存储空间用量,或在不再需要临时文件时立即将其移除。或者,您也可以增加可用存储空间,或在专用 pod 中运行工作负载(使用

KubernetesPodOperator)。

Airflow worker 已终止

Airflow 工作器可能会在外部被移除。如果当前正在运行的任务在正常终止期间未完成,则会被中断,并最终可能会被检测为僵尸任务。

发现 Airflow 工作器 pod 终止

resource.type="k8s_cluster" resource.labels.cluster_name="GKE_CLUSTER_NAME" protoPayload.methodName:"pods.delete" protoPayload.response.metadata.name:"airflow-worker"

可能的情形和解决方案:

在环境修改(例如升级或软件包安装)期间,Airflow 工作器会重启:

了解 Composer 环境修改

resource.type="cloud_composer_environment" resource.labels.environment_name="ENVIRONMENT_NAME" log_id("cloudaudit.googleapis.com%2Factivity")您可以在没有运行关键任务时执行此类操作,也可以启用任务重试。

在维护操作期间,各种组件可能暂时无法使用。

了解 GKE 维护操作

resource.type="gke_nodepool" resource.labels.cluster_name="GKE_CLUSTER_NAME" protoPayload.metadata.operationType="UPGRADE_NODES"

您可以指定维护窗口,以最大限度地减少

与关键任务执行重叠。

在 Cloud Composer 2 版本(低于 2.4.5)中,正在终止的 Airflow 工作人员可能会忽略 SIGTERM 信号并继续执行任务:

了解 Composer 自动伸缩功能如何缩减规模

resource.type="cloud_composer_environment" resource.labels.environment_name="ENVIRONMENT_NAME" log_id("airflow-worker-set") textPayload:"Workers deleted"您可以升级到已修复此问题的更高版本的 Cloud Composer。

Airflow 工作器处于高负载状态

Airflow 工作器可用的 CPU 和内存资源量受环境配置的限制。如果资源利用率接近限制,可能会导致资源争用和任务执行期间出现不必要的延迟。在资源长时间不足的极端情况下,可能会导致僵尸任务。

解决方案:

- 监控工作器的 CPU 和内存用量,并进行调整以避免超过 80%。

用于发现 Pod 重启或逐出原因的 Cloud Logging 查询

Cloud Composer 的环境使用 GKE 集群作为计算基础设施层。在本部分中,您可以找到一些实用查询,这些查询有助于查找 Airflow 工作器或 Airflow 调度程序重启或被逐出的原因。

以下查询可以按以下方式进行调整:

您可以在 Cloud Logging 中指定所需的时间轴。例如,过去 6 小时、3 天,或者您可以自定义时间范围。

您必须在 CLUSTER_NAME 中指定环境的集群的名称。

您可以通过添加 POD_NAME 将搜索范围限定为特定 Pod。

发现已重启的容器

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"will be restarted"

resource.labels.cluster_name="CLUSTER_NAME"

将结果限制为特定 Pod 的替代查询:

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"will be restarted"

resource.labels.cluster_name="CLUSTER_NAME"

"POD_NAME"

发现因内存不足事件而关闭的容器

resource.type="k8s_node"

log_id("events")

(jsonPayload.reason:("OOMKilling" OR "SystemOOM")

OR jsonPayload.message:("OOM encountered" OR "out of memory"))

severity=WARNING

resource.labels.cluster_name="CLUSTER_NAME"

将结果限制为特定 Pod 的替代查询:

resource.type="k8s_node"

log_id("events")

(jsonPayload.reason:("OOMKilling" OR "SystemOOM")

OR jsonPayload.message:("OOM encountered" OR "out of memory"))

severity=WARNING

resource.labels.cluster_name="CLUSTER_NAME"

"POD_NAME"

发现已停止执行的容器

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"ContainerDied"

severity=DEFAULT

resource.labels.cluster_name="CLUSTER_NAME"

将结果限制为特定 Pod 的替代查询:

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"ContainerDied"

severity=DEFAULT

resource.labels.cluster_name="CLUSTER_NAME"

"POD_NAME"

Airflow 数据库处于高负载状态

各种 Airflow 组件使用数据库相互通信,尤其是存储任务实例的心跳。数据库资源短缺会导致查询时间变长,并可能影响任务执行。

有时,Airflow 工作器的日志中会显示以下错误:

(psycopg2.OperationalError) connection to server at <IP address>,

port 3306 failed: server closed the connection unexpectedly

This probably means the server terminated abnormally before or while

processing the request.

解决方案:

- 避免在顶级 DAG 代码中使用大量

Variables.get指令。请改用 Jinja 模板来检索 Airflow 变量的值。 - 优化(减少)顶级 DAG 代码中 Jinja 模板中 xcom_push 和 xcom_pull 指令的使用。

- 请考虑升级到更大的环境规模(中或大)。

- 减少调度器数量

- 降低 DAG 解析频率。

- 监控数据库 CPU 和内存用量。

Airflow 数据库暂时不可用

Airflow 工作器可能需要一些时间来检测并妥善处理间歇性错误,例如暂时性连接问题。这可能会超出默认的僵尸进程检测阈值。

了解 Airflow 检测信号超时

resource.type="cloud_composer_environment"

resource.labels.environment_name="ENVIRONMENT_NAME"

log_id("airflow-worker")

textPayload:"Heartbeat time limit exceeded"解决方案:

增加僵尸任务的超时时间,并替换

[scheduler]scheduler_zombie_task_thresholdAirflow 配置选项的值:部分 键 值 备注 schedulerscheduler_zombie_task_threshold新超时时间(以秒为单位) 默认值为 300

任务因执行期间发生错误而失败

正在终止实例

Airflow 使用终止实例机制来关闭 Airflow 任务。此机制适用于以下情况:

- 当调度程序终止未按时完成的任务时。

- 当任务超时或执行时间过长时。

当 Airflow 终止任务实例时,您可以在执行该任务的 Airflow 工作器的日志中看到以下日志条目:

INFO - Subtask ... WARNING - State of this instance has been externally set

to success. Terminating instance.

INFO - Subtask ... INFO - Sending Signals.SIGTERM to GPID <X>

INFO - Subtask ... ERROR - Received SIGTERM. Terminating subprocesses.

可能的解决方案:

检查任务代码中是否存在可能导致其运行时间过长的错误。

增加 Airflow 工作器的 CPU 和内存,以便更快地执行任务。

增加

[celery_broker_transport_options]visibility_timeoutAirflow 配置选项的值。因此,调度器会等待更长时间,直到任务完成,然后才会将任务视为僵尸任务。此选项对于耗时数小时的任务尤其有用。如果该值过低(例如 3 小时),则调度器会将运行 5 或 6 小时的任务视为“挂起”(僵尸任务)。

增加

[core]killed_task_cleanup_timeAirflow 配置选项的值。值越大,Airflow 工作器完成任务的时间就越长。如果该值过低,Airflow 任务可能会突然中断,而没有足够的时间来顺利完成其工作。

DAG 执行未在预期时间内结束

具体情况:

有时,DAG 运行不会结束,因为 Airflow 任务卡住,导致 DAG 运行时间超出预期。在正常情况下,Airflow 任务不会无限期地处于排队或运行状态,因为 Airflow 具有超时和清理程序,有助于避免这种情况。

修复:

使用 DAG 的

dagrun_timeout参数。 例如:dagrun_timeout=timedelta(minutes=120)。因此,每次 DAG 运行都必须在 DAG 运行超时时间内完成。如需详细了解 Airflow 任务状态,请参阅 Apache Airflow 文档。使用任务执行超时参数为基于 Apache Airflow 运算符运行的任务定义默认超时时间。

在任务执行期间或紧接其后,抛出查询异常时与 Postgres 服务器的连接中断。

满足以下条件时,通常会发生 Lost connection to Postgres server during query 异常:

- DAG 使用

PythonOperator或自定义运算符。 - DAG 向 Airflow 数据库发出查询。

如果通过可调用的函数进行了多次查询,则回溯可能会错误地指向 Airflow 代码中的 self.refresh_from_db(lock_for_update=True) 行;它是任务执行后的第一个数据库查询。导致出现异常的实际原因发生在这之前,即 SQLAlchemy 会话未正确关闭时。

SQLAlchemy 会话限定在线程范围内,并且在稍后可在 Airflow 代码中继续的可调用函数会话中创建。如果一次会话中的查询之间存在严重延迟,则表示 Postgres 服务器可能已经关闭了连接。Cloud Composer 环境中的连接超时设置为大约 10 分钟。

解决方案:

- 使用

airflow.utils.db.provide_session修饰器。此修饰器在session参数中提供到 Airflow 数据库的有效会话,并在函数结束时正确关闭会话。 - 请勿使用单个长时间运行的函数。请改为将所有数据库查询移动到单独的函数中,以使多个函数具有

airflow.utils.db.provide_session修饰器。在这种情况下,会话会在检索查询结果后自动关闭。

连接到 Airflow 元数据数据库时出现短暂中断

Cloud Composer 在分布式基础设施上运行。这意味着,有时可能会出现一些暂时性问题,这些问题可能会中断 Airflow 任务的执行。

在这种情况下,您可能会在 Airflow 工作器的日志中看到以下错误消息:

"Can't connect to Postgres server on 'airflow-sqlproxy-service.default.svc.cluster.local' (111)"

或

"Can't connect to Postgres server on 'airflow-sqlproxy-service.default.svc.cluster.local' (104)"

此类间歇性问题也可能是由为 Cloud Composer 环境执行的维护操作引起的。

此类错误通常是间歇性的,如果您的 Airflow 任务是幂等的,并且您已配置重试,则不会受到影响。您还可以考虑定义维护窗口。

导致此类错误的另一个原因可能是环境的集群中缺少资源。在这种情况下,您可以按照扩缩环境或优化环境说明中的描述扩缩或优化环境。

DAG 运行标记为成功,但没有已执行的任务

如果 DAG 运行作业 execution_date 早于 DAG 的 start_date,您可能会看到没有任务运行作业但仍标记为成功的 DAG 运行作业。

原因

在以下情况下可能会发生此情况:

不匹配是由 DAG 的

execution_date和start_date之间的时区差异造成的。例如,使用pendulum.parse(...)设置start_date时可能会发生这种情况。DAG 的

start_date设置为动态值,例如airflow.utils.dates.days_ago(1)

解决方案

确保

execution_date和start_date使用的是同一时区。指定静态

start_date并将其与catchup=False结合使用,以避免运行具有过去开始日期的 DAG。

最佳做法

更新或升级操作对 Airflow 任务执行的影响

更新或升级操作会中断当前正在执行的 Airflow 任务,除非任务以可延迟模式执行。

建议您在预计对 Airflow 任务执行影响最小的情况下执行这些操作,并在 DAG 和任务中设置适当的重试机制。

请勿同时安排以程序化方式生成的 DAG

以编程方式从 DAG 文件生成 DAG 对象是一种高效的方法,可用于编写许多只有细微差别的类似 DAG。

请务必不要立即安排执行所有此类 DAG。Airflow 工作器很可能没有足够的 CPU 和内存资源来执行同时调度的所有任务。

为避免在调度程序化 DAG 时出现问题,请执行以下操作:

- 提高工作器并发数并扩缩环境,以便环境可以同时执行更多任务。

- 以一种方式生成 DAG,使其时间表在时间上均匀分布,以避免同时安排数百个任务,从而使 Airflow 工作器有时间执行所有已安排的任务。

控制 DAG、任务的执行时间以及同一 DAG 的并行执行

如果您想控制特定 DAG 的单次 DAG 执行持续时间,可以使用 dagrun_timeout DAG 参数来实现。例如,如果您预计单次 DAG 运行(无论执行成功还是失败)的持续时间不得超过 1 小时,则将此参数设置为 3600 秒。

您还可以控制单个 Airflow 任务的持续时间。为此,您可以使用 execution_timeout。

如果您想控制特定 DAG 的活跃 DAG 运行次数,可以使用 [core]max-active-runs-per-dag

Airflow 配置选项来实现此目的。

如果您希望在给定时间只运行一个 DAG 实例,请将 max-active-runs-per-dag 参数设置为 1。

避免增加进出 Airflow 数据库的网络流量

您的环境的 GKE 集群和 Airflow 数据库之间的流量网络量取决于 DAG 数量、DAG 中的任务数量以及 DAG 访问 Airflow 数据库中的数据的方式。以下因素可能会影响网络用量:

对 Airflow 数据库的查询。如果您的 DAG 执行了大量查询,则会生成大量流量。示例:在继续其他任务、查询 XCom 表、转储 Airflow 数据库内容之前检查任务的状态。

任务数量过多。要安排的任务越多,产生的网络流量就越多。此考虑因素适用于 DAG 中的任务总数和调度频率。在 Airflow 调度器安排 DAG 运行时,它会向 Airflow 数据库发出查询并产生流量。

Airflow 网页界面会向 Airflow 数据库发出查询,因此会产生网络流量。大量使用包含图表、任务和图示的页面可能会产生大量网络流量。