Esegui un DAG Apache Airflow in Cloud Composer 2

Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Questa guida rapida mostra come creare un ambiente Cloud Composer e come eseguire un DAG Apache Airflow in Cloud Composer 2.

Se non hai mai utilizzato Airflow, consulta il tutorial sui concetti di Airflow nella documentazione di Apache Airflow per saperne di più su concetti, oggetti e utilizzo di Airflow.

Se vuoi utilizzare Google Cloud CLI, consulta Esegui un DAG Apache Airflow in Cloud Composer (Google Cloud CLI).

Se vuoi creare un ambiente utilizzando Terraform, consulta Creare ambienti (Terraform).

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Composer API.

-

Per ottenere le autorizzazioni necessarie per completare questa guida rapida, chiedi all'amministratore di concederti i seguenti ruoli IAM nel tuo progetto:

-

Per visualizzare, creare e gestire l'ambiente Cloud Composer:

-

Amministratore ambienti e oggetti Storage (

roles/composer.environmentAndStorageObjectAdmin) -

Utente service account (

roles/iam.serviceAccountUser)

-

Amministratore ambienti e oggetti Storage (

-

Per visualizzare i log:

Visualizzatore log (

roles/logging.viewer)

Per ulteriori informazioni sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

-

Per visualizzare, creare e gestire l'ambiente Cloud Composer:

Crea un nuovo service account, come descritto nella documentazione di Identity and Access Management.

Assegna un ruolo, come descritto nella documentazione di Identity and Access Management. Il ruolo richiesto è Worker Composer (

composer.worker).Nella console Google Cloud , vai alla pagina Crea ambiente.

Se questo è il primo ambiente nel tuo progetto, viene visualizzata una sezione Concedi le autorizzazioni necessarie al service account di Cloud Composer.

Aggiungi l'account di servizio Cloud Composer come nuova entità nel service account del tuo ambiente e concedigli il ruolo Estensione agente di servizio API Cloud Composer v2.

Verifica di utilizzare il account di servizio previsto per il tuo ambiente e fai clic su Concedi.

Nel campo Nome, inserisci

example-environment.Nell'elenco a discesa Località, seleziona una regione per l'ambiente Cloud Composer. Questa guida utilizza la regione

us-central1.Per le altre opzioni di configurazione dell'ambiente, utilizza i valori predefiniti forniti.

Fai clic su Crea e attendi la creazione dell'ambiente.

Al termine, accanto al nome dell'ambiente viene visualizzato un segno di spunta verde.

- Crea un DAG,

composer_sample_dag. Questo DAG viene eseguito ogni giorno. - Esegue un'attività,

print_dag_run_conf. L'attività stampa la configurazione dell'esecuzione del DAG utilizzando l'operatore bash. Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente,

example-environment. Viene visualizzata la pagina Dettagli ambiente.Fai clic su Apri cartella DAG. Viene visualizzata la pagina Dettagli bucket.

Fai clic su Carica file e seleziona la tua copia di

quickstart.py.Per caricare il file, fai clic su Apri.

- Analizza il file DAG che hai caricato. Potrebbero essere necessari alcuni minuti prima che il DAG diventi disponibile per Airflow.

- Aggiunge il DAG all'elenco dei DAG disponibili.

- Esegue il DAG in base alla pianificazione fornita nel file DAG.

Attendi circa cinque minuti per dare ad Airflow il tempo di elaborare il file DAG che hai caricato in precedenza e di completare la prima esecuzione del DAG (spiegata in seguito).

Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente,

example-environment. Viene visualizzata la pagina Dettagli ambiente.Vai alla scheda DAG.

Verifica che il DAG

composer_quickstartsia presente nell'elenco dei DAG.

Figura 1. L'elenco dei DAG mostra il DAG composer_quickstart (fai clic per ingrandire) Nella scheda DAG, fai clic su

composer_quickstart. Si apre la scheda Esecuzioni per il DAG.Nell'elenco delle esecuzioni DAG, fai clic sulla prima voce.

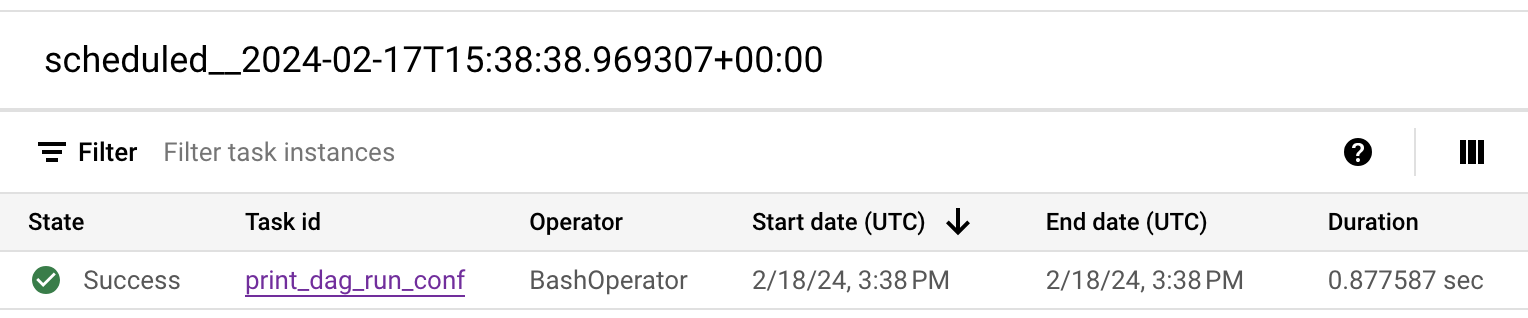

Figura 2. L'elenco delle esecuzioni di DAG per il DAG composer_quickstart (fai clic per ingrandire) Vengono visualizzati i dettagli dell'esecuzione del DAG, che forniscono informazioni sulle singole attività del DAG di esempio.

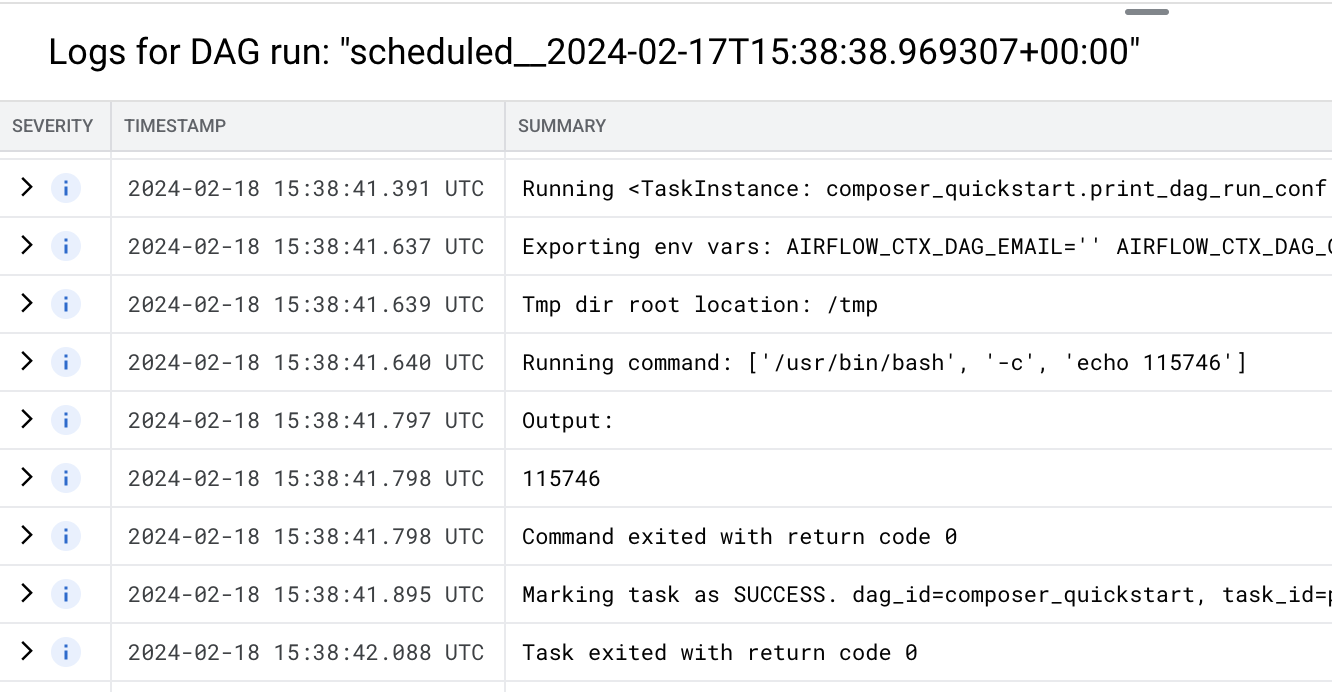

Figura 3. L'elenco delle attività eseguite nell'esecuzione del DAG (fai clic per ingrandire) La sezione Log per l'esecuzione del DAG elenca i log per tutte le attività nell'esecuzione del DAG. Puoi visualizzare l'output del comando

echonei log.

Figura 4. Log dell'attività print_dag_run_conf (fai clic per ingrandire) Elimina l'ambiente Cloud Composer:

Nella console Google Cloud , vai alla pagina Ambienti.

Seleziona

example-environmente fai clic su Elimina.Attendi l'eliminazione dell'ambiente.

Elimina il bucket del tuo ambiente. L'eliminazione dell'ambiente Cloud Composer non elimina il bucket.

Nella console Google Cloud , vai alla pagina Storage > Browser.

Seleziona il bucket dell'ambiente e fai clic su Elimina. Ad esempio, questo bucket può essere denominato

us-central1-example-environ-c1616fe8-bucket.

Crea il account di servizio di un ambiente

Quando crei un ambiente, specifichi un account di servizio. Questo service account è chiamato service account dell'ambiente. Il tuo ambiente utilizza questo account di servizio per eseguire la maggior parte delle operazioni.

Il account di servizio per il tuo ambiente non è un account utente. Un account di serviziot è un particolare tipo di account utilizzato da un'applicazione o da un'istanza di macchina virtuale (VM), non da una persona fisica.

Per creare un account di servizio per il tuo ambiente:

Creazione di un ambiente

Creare un file DAG

Un DAG di Airflow è una raccolta di attività organizzate che vuoi pianificare ed eseguire. I DAG sono definiti in file Python standard.

Questa guida utilizza un DAG di Airflow di esempio definito nel file quickstart.py.

Il codice Python in questo file esegue le seguenti operazioni:

Salva una copia del file quickstart.py sulla tua macchina locale:

Carica il file DAG nel bucket dell'ambiente

Ogni ambiente Cloud Composer ha un bucket Cloud Storage associato. Airflow in Cloud Composer pianifica solo

i DAG che si trovano nella cartella /dags di questo bucket.

Per pianificare il DAG, carica quickstart.py dalla tua macchina locale nella cartella /dags del tuo ambiente:

Visualizzare il DAG

Dopo aver caricato il file DAG, Airflow esegue le seguenti operazioni:

Verifica che il DAG venga elaborato senza errori e sia disponibile in Airflow visualizzandolo nell'interfaccia utente DAG. La UI DAG è l'interfaccia di Cloud Composer per visualizzare le informazioni sui DAG nella console Google Cloud . Cloud Composer fornisce anche l'accesso alla UI di Airflow, un'interfaccia web nativa di Airflow.

Visualizzare i dettagli dell'esecuzione del DAG

Una singola esecuzione di un DAG è detta esecuzione di DAG. Airflow esegue immediatamente un'esecuzione DAG per il DAG di esempio perché la data di inizio nel file DAG è impostata su ieri. In questo modo, Airflow recupera la pianificazione del DAG specificato.

Il DAG di esempio contiene un'attività, print_dag_run_conf, che esegue il comando echo

nella console. Questo comando restituisce i metadati del DAG

(l'identificatore numerico dell'esecuzione del DAG).

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questa pagina, segui questi passaggi.

Elimina le risorse utilizzate in questo tutorial:

Passaggi successivi