Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Cette page répertorie les problèmes connus liés à Cloud Composer. Pour en savoir plus sur les problèmes résolus, consultez les notes de version.

Certains problèmes affectent des versions antérieures et peuvent être résolus en mettant à niveau votre environnement.

Les plages d'adresses non-RFC 1918 sont partiellement compatibles avec les pods et les services.

Cloud Composer dépend de GKE pour assurer la compatibilité des adresses non-RFC 1918 avec les pods et les services. Seule la liste suivante de plages non-RFC 1918 est acceptée dans Cloud Composer :

- 100.64.0.0/10

- 192.0.0.0/24

- 192.0.2.0/24

- 192.88.99.0/24

- 198.18.0.0/15

- 198.51.100.0/24

- 203.0.113.0/24

- 240.0.0.0/4

Les libellés d'environnement ajoutés lors d'une mise à jour ne sont pas entièrement propagés

Lorsque vous mettez à jour les libellés d'environnement, ils ne sont pas appliqués aux VM Compute Engine du cluster de l'environnement. Pour contourner ce problème, vous pouvez appliquer les libellés manuellement.

Impossible de créer des environnements Cloud Composer lorsque la règle d'administration constraints/compute.disableSerialPortLogging est activée

La création de l'environnement Cloud Composer échoue si la règle d'administration constraints/compute.disableSerialPortLogging est appliquée au projet cible.

Diagnostic

Pour savoir si vous êtes concerné par ce problème, procédez comme suit :

Accédez au menu GKE dans la consoleGoogle Cloud . Accéder au menu GKE

Sélectionnez ensuite le cluster que vous venez de créer. Recherchez l'erreur suivante :

Not all instances running in IGM after 123.45s.

Expect <number of desired instances in IGM>. Current errors:

Constraint constraints/compute.disableSerialPortLogging violated for

project <target project number>.

Solutions :

Désactivez la règle d'administration sur le projet dans lequel l'environnement Cloud Composer sera créé.

Une règle d'administration peut toujours être désactivée au niveau du projet même si elle est activée au niveau des ressources parentes (organisation ou dossier). Pour en savoir plus, consultez la page Personnaliser les règles pour les contraintes booléennes.

Utiliser des filtres d'exclusion

L'utilisation d'un filtre d'exclusion pour les journaux des ports série permet d'atteindre le même objectif que la désactivation de la règle d'organisation, car Logging comprend des journaux de la console série. Pour en savoir plus, consultez la page Filtres d'exclusion.

Utiliser Deployment Manager pour gérer les ressources Google Cloud protégées par VPC Service Controls

Les versions 2.0.x de Cloud Composer 1 et Cloud Composer 2 utilisent Deployment Manager pour créer des composants d'environnements Cloud Composer.

En décembre 2020, il se peut que vous ayez été informé que vous devrez peut-être effectuer une configuration supplémentaire de VPC Service Controls pour pouvoir gérer les ressources protégées par VPC Service Controls à l'aide de Deployment Manager.

Nous souhaitons préciser qu'aucune action n'est requise de votre part si vous utilisez Cloud Composer et que vous n'utilisez pas Deployment Manager directement pour gérer les ressources Google Cloud mentionnées dans l'annonce de Deployment Manager.

Deployment Manager affiche des informations sur une fonctionnalité non compatible

L'avertissement suivant peut s'afficher dans l'onglet Deployment Manager :

The deployment uses actions, which are an unsupported feature. We recommend

that you avoid using actions.

Pour les déploiements de Deployment Manager appartenant à Cloud Composer, vous pouvez ignorer cet avertissement.

Impossible de supprimer un environnement après la suppression de son cluster

Ce problème s'applique aux versions 2.0.x de Cloud Composer 1 et Cloud Composer 2.

Si vous supprimez le cluster GKE de votre environnement avant l'environnement lui-même, les tentatives de suppression de votre environnement entraînent l'erreur suivante :

Got error "" during CP_DEPLOYMENT_DELETING [Rerunning Task. ]

Pour supprimer un environnement lorsque son cluster est déjà supprimé :

Dans la console Google Cloud , accédez à la page Deployment Manager.

Recherchez tous les déploiements marqués avec des libellés :

goog-composer-environment:<environment-name>goog-composer-location:<environment-location>.

Vous devriez voir deux déploiements marqués avec les libellés décrits :

- Un déploiement nommé

<environment-location>-<environment-name-prefix>-<hash>-sd - Un déploiement nommé

addons-<uuid>

Supprimez manuellement les ressources toujours répertoriées dans ces deux déploiements et existant dans le projet (par exemple, les sujets et les abonnements Pub/Sub). Pour ce faire :

Sélectionnez les déploiements.

Cliquez sur Supprimer.

Sélectionnez l'option Supprimer deux déploiements et toutes les ressources créées par ceux-ci, telles que les VM, les équilibreurs de charge et les disques, puis cliquez sur Tout supprimer.

L'opération de suppression échoue, mais les ressources restantes sont supprimées.

Supprimez les déploiements en utilisant l'une des options suivantes :

Dans la console Google Cloud , sélectionnez à nouveau les deux déploiements. Cliquez sur Supprimer, puis sélectionnez l'option Supprimer deux déploiements, mais conserver les ressources créées par ceux-ci.

Exécutez une commande gcloud pour supprimer les déploiements avec la règle

ABANDON:gcloud deployment-manager deployments delete addons-<uuid> \ --delete-policy=ABANDON gcloud deployment-manager deployments delete <location>-<env-name-prefix>-<hash>-sd \ --delete-policy=ABANDON

Avertissements concernant les entrées en double de la tâche "echo" appartenant au DAG "echo-airflow_monitoring"

L'entrée suivante peut s'afficher dans les journaux Airflow :

in _query db.query(q) File "/opt/python3.6/lib/python3.6/site-packages/MySQLdb/

connections.py", line 280, in query _mysql.connection.query(self, query)

_mysql_exceptions.IntegrityError: (1062, "Duplicate entry

'echo-airflow_monitoring-2020-10-20 15:59:40.000000' for key 'PRIMARY'")

Vous pouvez ignorer ces entrées de journal, car cette erreur n'a aucune incidence sur le traitement du DAG et des tâches par Airflow.

Nous nous efforçons d'améliorer le service Cloud Composer pour supprimer ces avertissements des journaux Airflow.

Échec de la création d'un environnement dans des projets où des API Identity-Aware Proxy ont été ajoutées au périmètre VPC Service Controls

Dans les projets où VPC Service Controls est activé, le compte cloud-airflow-prod@system.gserviceaccount.com nécessite un accès explicite dans votre périmètre de sécurité pour créer des environnements.

Pour créer des environnements, vous pouvez utiliser l'une des solutions suivantes :

N'ajoutez pas l'API Cloud Identity-Aware Proxy ni l'API TCP d'Identity-Aware Proxy au périmètre de sécurité.

Ajoutez le compte de service

cloud-airflow-prod@system.gserviceaccount.comen tant que membre de votre périmètre de sécurité en utilisant la configuration suivante dans le fichier de conditions YAML :- members: - serviceAccount:cloud-airflow-prod@system.gserviceaccount.com

La création ou la mise à niveau de l'environnement Cloud Composer échoue lorsque la règle compute.vmExternalIpAccess est désactivée

Ce problème s'applique aux environnements Cloud Composer 1 et Cloud Composer 2.

Les clusters GKE appartenant à Cloud Composer configurés en mode adresse IP publique nécessitent une connectivité externe pour leurs VM. De ce fait, la règle compute.vmExternalIpAccess ne peut pas interdire la création de VM ayant des adresses IP externes. Pour en savoir plus sur cette règle d'administration, consultez Contraintes liées aux règles d'administration.

La première exécution du DAG pour un fichier de DAG importé comporte plusieurs tâches ayant échoué

Lorsque vous importez un fichier de DAG, il se peut que les premières tâches de la première exécution de DAG associée à ce fichier échouent avec l'erreur Unable to read remote log.... Ce problème est dû au fait que le fichier de DAG est synchronisé entre le bucket de votre environnement, les nœuds de calcul Airflow et les programmeurs Airflow de votre environnement. Si le programmeur obtient le fichier de DAG et planifie son exécution par un nœud de calcul alors que ce nœud de calcul ne dispose pas encore du fichier de DAG, l'exécution de la tâche échoue.

Pour atténuer ce problème, les environnements avec Airflow 2 sont configurés pour effectuer par défaut deux tentatives pour chaque tâche ayant échoué. Si une tâche échoue, elle est relancée deux fois avec un intervalle de cinq minutes.

Annonces concernant la suppression de la compatibilité avec les API bêta obsolètes dans les versions de GKE

Cloud Composer gère les clusters GKE sous-jacents appartenant à Cloud Composer. À moins que vous n'utilisiez explicitement ces API dans vos DAG et votre code, vous pouvez ignorer les annonces concernant les abandons d'API GKE. Cloud Composer se charge de toutes les migrations, si nécessaire.

Cloud Composer ne devrait pas être concerné par la faille Apache Log4j 2 (CVE-2021-44228)

En réponse à la faille Apache Log4j 2 (CVE-2021-44228), Cloud Composer a mené une enquête approfondie et nous pensons que Cloud Composer n'est pas vulnérable à cette exploitation.

Les nœuds de calcul ou les programmeurs Airflow peuvent rencontrer des problèmes lors de l'accès au bucket Cloud Storage de l'environnement.

Cloud Composer utilise gcsfuse pour accéder au dossier /data dans le bucket de l'environnement et pour enregistrer les journaux des tâches Airflow dans le répertoire /logs (si cette option est activée). Si gcsfuse est surchargé ou si le bucket de l'environnement n'est pas disponible, vous pouvez rencontrer des échecs d'instances de tâches Airflow et voir des erreurs Transport endpoint is not connected dans les journaux Airflow.

Solutions :

- Désactivez l'enregistrement des journaux dans le bucket de l'environnement. Cette option est déjà désactivée par défaut si un environnement est créé avec Cloud Composer 2.8.0 ou version ultérieure.

- Passez à Cloud Composer 2.8.0 ou version ultérieure.

- Réduisez

[celery]worker_concurrencyet augmentez plutôt le nombre de nœuds de calcul Airflow. - Réduisez la quantité de journaux produits dans le code du DAG.

- Suivez les recommandations et les bonnes pratiques pour implémenter des DAG et activer les nouvelles tentatives pour les tâches.

Il arrive parfois que l'UI Airflow ne recharge pas un plug-in une fois qu'il a été modifié.

Si un plug-in se compose de nombreux fichiers qui importent d'autres modules, l'UI Airflow peut ne pas être en mesure de reconnaître qu'un plug-in doit être rechargé. Dans ce cas, redémarrez le serveur Web Airflow de votre environnement.

Le cluster de l'environnement comporte des charges de travail à l'état "Non programmable"

Ce problème connu ne s'applique qu'à Cloud Composer 2.

Dans Cloud Composer 2, une fois l'environnement créé, plusieurs charges de travail du cluster de l'environnement restent à l'état "Non planifiable".

Lorsqu'un environnement est mis à l'échelle, de nouveaux pods de nœud de calcul sont créés et Kubernetes tente de les exécuter. S'il n'y a pas de ressources disponibles pour les exécuter, les pods de nœuds de calcul sont marqués comme non programmables.

Dans ce cas, l'autoscaler de cluster ajoute des nœuds, ce qui prend quelques minutes. Tant que cette opération n'est pas terminée, les pods restent à l'état "Non programmable" et n'exécutent aucune tâche.

Les charges de travail DaemonSet non planifiables nommées composer-gcsfuse et composer-fluentd qui ne peuvent pas démarrer sur les nœuds où les composants Airflow ne sont pas présents n'affectent pas votre environnement.

Si ce problème persiste pendant une longue période (plus d'une heure), vous pouvez consulter les journaux de l'autoscaler de cluster. Vous pouvez les trouver dans la visionneuse de journaux avec le filtre suivant :

resource.type="k8s_cluster"

logName="projects/<project-name>/logs/container.googleapis.com%2Fcluster-autoscaler-visibility"

resource.labels.cluster_name="<cluster-name>"

Il contient des informations sur les décisions prises par l'autoscaler de cluster. Développez n'importe quel noDecisionStatus pour connaître la raison pour laquelle le cluster ne peut pas être mis à l'échelle à la hausse ou à la baisse.

Erreur 504 lors de l'accès à l'interface utilisateur d'Airflow

Vous pouvez obtenir l'erreur 504 Gateway Timeout lorsque vous accédez à l'interface utilisateur d'Airflow. Cette erreur peut avoir plusieurs causes :

Problème de communication temporaire. Dans ce cas, réessayez d'accéder à l'interface utilisateur d'Airflow ultérieurement. Vous pouvez également redémarrer le serveur Web Airflow.

(Cloud Composer 3 uniquement) Problème de connectivité. Si l'UI Airflow est définitivement indisponible et que des erreurs de délai avant expiration ou 504 sont générées, assurez-vous que votre environnement peut accéder à

*.composer.googleusercontent.com.(Cloud Composer 2 uniquement) Problème de connectivité. Si l'UI Airflow est définitivement indisponible et que des erreurs de délai avant expiration ou 504 sont générées, assurez-vous que votre environnement peut accéder à

*.composer.cloud.google.com. Si vous utilisez l'accès privé à Google et que vous envoyez du trafic via des adresses IP virtuellesprivate.googleapis.com, ou si vous utilisez VPC Service Controls et que vous envoyez du trafic via des adresses IP virtuellesrestricted.googleapis.com, assurez-vous que votre Cloud DNS est également configuré pour les noms de domaine*.composer.cloud.google.com.Le serveur Web Airflow ne répond pas. Si l'erreur 504 persiste, mais que vous pouvez toujours accéder à l'interface utilisateur Airflow à certains moments, cela signifie que le serveur Web Airflow est peut-être surchargé et ne répond plus. Essayez d'augmenter les paramètres de scaling et de performances du serveur Web.

Erreur 502 lors de l'accès à l'interface utilisateur d'Airflow

L'erreur 502 Internal server exception indique que l'UI Airflow ne peut pas traiter les requêtes entrantes. Cette erreur peut avoir plusieurs causes :

Problème de communication temporaire. Réessayez d'accéder à l'interface utilisateur d'Airflow plus tard.

Échec du démarrage du serveur Web. Pour commencer, le serveur Web doit d'abord synchroniser les fichiers de configuration. Consultez les journaux du serveur Web pour trouver des entrées de journal semblables à

GCS sync exited with 1: gcloud storage cp gs://<bucket-name>/airflow.cfg /home/airflow/gcs/airflow.cfg.tmpouGCS sync exited with 1: gcloud storage cp gs://<bucket-name>/env_var.json.cfg /home/airflow/gcs/env_var.json.tmp. Si ces erreurs s'affichent, vérifiez si les fichiers mentionnés dans les messages d'erreur sont toujours présents dans le bucket de l'environnement.En cas de suppression accidentelle (par exemple, en raison de la configuration d'une règle de conservation), vous pouvez les restaurer :

Définissez une nouvelle variable d'environnement dans votre environnement. Vous pouvez utiliser n'importe quel nom et valeur de variable.

Remplacez une option de configuration Airflow. Vous pouvez utiliser une option de configuration Airflow inexistante.

Le pointeur de la souris sur une instance de tâche dans la vue arborescente génère une erreur TypeError non interceptée

Dans Airflow 2, il arrive que la vue arborescente de l'UI Airflow ne fonctionne pas correctement lorsqu'un fuseau horaire autre que celui par défaut est utilisé. Pour contourner ce problème, configurez explicitement le fuseau horaire dans l'interface utilisateur Airflow.

L'interface utilisateur Airflow dans Airflow 2.2.3 ou les versions antérieures est vulnérable à la faille CVE-2021-45229.

Comme indiqué dans CVE-2021-45229, l'écran "Déclencher un DAG avec une configuration" était susceptible d'être la cible d'attaques XSS via l'argument de requête origin.

Recommandation : Mettez à niveau la dernière version de Cloud Composer compatible avec Airflow 2.2.5.

Les workers nécessitent plus de mémoire que dans les versions précédentes d'Airflow.

Symptômes :

Dans votre environnement Cloud Composer 2, toutes les charges de travail du cluster de l'environnement des nœuds de calcul Airflow sont à l'état

CrashLoopBackOffet n'exécutent pas de tâches. Vous pouvez également voir les avertissementsOOMKillingqui sont générés si vous êtes concerné par ce problème.Ce problème peut empêcher les mises à niveau de l'environnement.

Cause :

- Si vous utilisez une valeur personnalisée pour l'option de configuration Airflow

[celery]worker_concurrencyet des paramètres de mémoire personnalisés pour les nœuds de calcul Airflow, ce problème peut se produire lorsque la consommation de ressources approche de la limite. - Les exigences de mémoire des nœuds de calcul Airflow dans Airflow 2.6.3 avec Python 3.11 sont 10 % plus élevées que celles des nœuds de calcul dans les versions antérieures.

- Les exigences de mémoire des nœuds de calcul Airflow dans Airflow 2.3 et les versions ultérieures sont 30 % plus élevées que celles des nœuds de calcul dans Airflow 2.2 ou Airflow 2.1.

Solutions :

- Supprimez le remplacement de

worker_concurrencyafin que Cloud Composer calcule automatiquement cette valeur. - Si vous utilisez une valeur personnalisée pour

worker_concurrency, définissez-la sur une valeur inférieure. Vous pouvez utiliser la valeur calculée automatiquement comme point de départ. - Vous pouvez également augmenter la quantité de mémoire disponible pour les nœuds de calcul Airflow.

- Si vous ne pouvez pas mettre à niveau votre environnement vers une version ultérieure en raison de ce problème, appliquez l'une des solutions proposées avant la mise à niveau.

Déclencher des DAG via des réseaux privés à l'aide de Cloud Run Functions

Cloud Composer n'est pas compatible avec le déclenchement de DAG avec des fonctions Cloud Run via des réseaux privés à l'aide du connecteur VPC.

Recommandation : Utilisez Cloud Run Functions pour publier des messages sur Pub/Sub. Ces événements peuvent actionner des capteurs Pub/Sub pour déclencher des DAG Airflow ou implémenter une approche basée sur des opérateurs différables.

Dossiers vides dans Scheduler et Workers

Cloud Composer ne supprime pas activement les dossiers vides des nœuds de calcul et des planificateurs Airflow. Ces entités peuvent être créées à la suite du processus de synchronisation des buckets d'environnement lorsque ces dossiers existaient dans le bucket et ont finalement été supprimés.

Recommandation : Ajustez vos DAG pour qu'ils soient prêts à ignorer ces dossiers vides.

Ces entités sont finalement supprimées des stockages locaux des programmeurs et des nœuds de calcul Airflow lorsque ces composants sont redémarrés (par exemple, à la suite d'opérations de scaling à la baisse ou de maintenance dans le cluster de votre environnement).

Compatibilité avec Kerberos

Cloud Composer n'est pas compatible avec la configuration Kerberos d'Airflow.

Compatibilité des classes de calcul dans Cloud Composer 2 et Cloud Composer 3

Cloud Composer 3 et Cloud Composer 2 ne sont compatibles qu'avec la classe de calcul à usage général. Cela signifie qu'il n'est pas possible d'exécuter des pods qui demandent d'autres classes de calcul (telles que Équilibré ou Scale-Out).

La classe à usage général permet d'exécuter des pods demandant jusqu'à 110 Go de mémoire et jusqu'à 30 processeurs (comme décrit dans Demandes maximales de la classe de calcul).

Si vous souhaitez utiliser une architecture basée sur ARM ou si vous avez besoin de plus de processeur et de mémoire, vous devez utiliser une autre classe de calcul, qui n'est pas compatible avec les clusters Cloud Composer 3 et Cloud Composer 2.

Recommandation : Utilisez GKEStartPodOperator pour exécuter des pods Kubernetes sur un autre cluster compatible avec la classe de calcul sélectionnée. Si vous exécutez des pods personnalisés nécessitant une autre classe de calcul, ils doivent également s'exécuter sur un cluster autre que Cloud Composer.

Assistance pour les opérateurs Google Campaign Manager 360

Les opérateurs Google Campaign Manager dans les versions de Cloud Composer antérieures à la version 2.1.13 sont basés sur l'API Campaign Manager 360 v3.5, qui est obsolète et dont la date d'arrêt est le 1er mai 2023.

Si vous utilisez des opérateurs Google Campaign Manager, mettez à niveau votre environnement vers Cloud Composer version 2.1.13 ou ultérieure.

Assistance pour les opérateurs Google Display & Video 360

Les opérateurs Google Display & Video 360 dans les versions de Cloud Composer antérieures à 2.1.13 sont basés sur l'API Display & Video 360 v1.1, qui est obsolète et dont la date d'arrêt est le 27 avril 2023.

Si vous utilisez des opérateurs Google Display & Video 360, mettez à niveau votre environnement vers Cloud Composer version 2.1.13 ou ultérieure. De plus, vous devrez peut-être modifier vos DAG, car certains opérateurs Google Display & Video 360 sont obsolètes et remplacés par de nouveaux.

GoogleDisplayVideo360CreateReportOperatorest désormais obsolète. Utilisez plutôtGoogleDisplayVideo360CreateQueryOperator. Cet opérateur renvoiequery_idau lieu dereport_id.GoogleDisplayVideo360RunReportOperatorest désormais obsolète. Utilisez plutôtGoogleDisplayVideo360RunQueryOperator. Cet opérateur renvoiequery_idetreport_idau lieu dereport_iduniquement, et nécessitequery_idau lieu dereport_idcomme paramètre.- Pour vérifier si un rapport est prêt, utilisez le nouveau capteur

GoogleDisplayVideo360RunQuerySensorqui utilise les paramètresquery_idetreport_id. L'ancien capteurGoogleDisplayVideo360ReportSensorne nécessitait quereport_id. GoogleDisplayVideo360DownloadReportV2Operatornécessite désormais les paramètresquery_idetreport_id.- Dans

GoogleDisplayVideo360DeleteReportOperator, aucune modification ne peut affecter vos DAG.

Restrictions concernant le nom de la plage secondaire

CVE-2023-29247 (la page "Détails de l'instance de la tâche" de l'UI est vulnérable à une attaque XSS stockée)

L'interface utilisateur Airflow dans les versions 2.0.x à 2.5.x d'Airflow est vulnérable à la faille CVE-2023-29247.

Si vous utilisez une version de Cloud Composer antérieure à la version 2.4.2 et que vous pensez que votre environnement pourrait être vulnérable à l'exploitation, veuillez lire la description et les solutions possibles ci-dessous.

Dans Cloud Composer, l'accès à l'interface utilisateur d'Airflow est protégé par IAM et le contrôle des accès à l'interface utilisateur d'Airflow.

Cela signifie que pour exploiter la faille de l'UI Airflow, les pirates informatiques doivent d'abord accéder à votre projet, ainsi qu'aux autorisations et rôles IAM nécessaires.

Solution :

Vérifiez les autorisations et les rôles IAM dans votre projet, y compris les rôles Cloud Composer attribués à des utilisateurs individuels. Assurez-vous que seuls les utilisateurs approuvés peuvent accéder à l'interface utilisateur d'Airflow.

Vérifiez les rôles attribués aux utilisateurs via le mécanisme de contrôle des accès à l'UI Airflow (il s'agit d'un mécanisme distinct qui offre un accès plus précis à l'UI Airflow). Assurez-vous que seuls les utilisateurs approuvés peuvent accéder à l'interface utilisateur d'Airflow et que tous les nouveaux utilisateurs sont enregistrés avec un rôle approprié.

Envisagez de renforcer la sécurité avec VPC Service Controls.

Le DAG de surveillance Airflow de l'environnement Composer Cloud Composer 2 n'est pas recréé après sa suppression

Le DAG de surveillance Airflow n'est pas recréé automatiquement s'il est supprimé par l'utilisateur ou déplacé du bucket dans les environnements avec composer-2.1.4-airflow-2.4.3.

Solution :

- Ce problème a été résolu dans les versions ultérieures, comme composer-2.4.2-airflow-2.5.3. L'approche suggérée consiste à mettre à niveau votre environnement vers une version plus récente.

- Une solution de contournement alternative ou temporaire à la mise à niveau de l'environnement consiste à copier le DAG airflow_monitoring à partir d'un autre environnement avec la même version.

Il n'est pas possible de réduire l'espace de stockage Cloud SQL

Cloud Composer utilise Cloud SQL pour exécuter la base de données Airflow. Au fil du temps, l'espace de stockage sur disque de l'instance Cloud SQL peut augmenter, car le disque est mis à l'échelle pour s'adapter aux données stockées par les opérations Cloud SQL lorsque la base de données Airflow augmente.

Il n'est pas possible de réduire la taille du disque Cloud SQL.

Pour contourner ce problème, si vous souhaitez utiliser la plus petite taille de disque Cloud SQL, vous pouvez recréer des environnements Cloud Composer avec des instantanés.

La métrique "Utilisation de l'espace disque de la base de données" ne diminue pas après la suppression d'enregistrements de Cloud SQL

Les bases de données relationnelles, telles que Postgres ou MySQL, ne suppriment pas physiquement les lignes lorsqu'elles sont supprimées ou mises à jour. Au lieu de cela, il les marque comme "tuples morts" pour maintenir la cohérence des données et éviter de bloquer les transactions simultanées.

MySQL et Postgres implémentent tous deux des mécanismes de récupération d'espace après la suppression d'enregistrements.

Bien qu'il soit possible de forcer la base de données à récupérer l'espace disque inutilisé, il s'agit d'une opération gourmande en ressources qui verrouille également la base de données, ce qui rend Cloud Composer indisponible. Il est donc recommandé de s'appuyer sur les mécanismes de création pour récupérer l'espace inutilisé.

Accès bloqué : erreur d'autorisation

Si ce problème affecte un utilisateur, la boîte de dialogue Accès bloqué : erreur d'autorisation contient le message Error 400: admin_policy_enforced.

Si l'option Contrôles des API > Applications tierces non configurées > Ne pas autoriser les utilisateurs à accéder aux applications tierces est activée dans Google Workspace et que l'application Apache Airflow dans Cloud Composer n'est pas explicitement autorisée, les utilisateurs ne peuvent pas accéder à l'interface utilisateur Airflow, sauf s'ils autorisent explicitement l'application.

Pour autoriser l'accès, suivez les étapes décrites dans Autoriser l'accès à l'interface utilisateur Airflow dans Google Workspace.

Boucle de connexion lors de l'accès à l'interface utilisateur d'Airflow

Ce problème peut avoir les causes suivantes :

Si des liaisons d'accès contextuel Chrome Enterprise Premium sont utilisées avec des niveaux d'accès qui reposent sur des attributs d'appareil, et que l'application Apache Airflow dans Cloud Composer n'est pas exemptée, il est impossible d'accéder à l'interface utilisateur Airflow en raison d'une boucle de connexion. Pour autoriser l'accès, suivez les étapes décrites dans Autoriser l'accès à l'interface utilisateur d'Airflow dans les liaisons d'accès contextuel.

Si des règles d'entrée sont configurées dans un périmètre VPC Service Controls qui protège le projet, et que la règle d'entrée qui autorise l'accès au service Cloud Composer utilise le type d'identité

ANY_SERVICE_ACCOUNTouANY_USER_ACCOUNT, les utilisateurs ne peuvent pas accéder à l'interface utilisateur Airflow et sont bloqués dans une boucle de connexion. Pour en savoir plus sur la résolution de ce problème, consultez Autoriser l'accès à l'interface utilisateur Airflow dans les règles d'entrée VPC Service Controls.

Instances de tâches ayant réussi dans le passé marquées comme ÉCHOUÉES

Dans certaines circonstances et dans de rares cas, les instances de tâches Airflow qui ont réussi dans le passé peuvent être marquées comme FAILED.

Si cela se produit, cela est généralement dû à une opération de mise à jour ou de mise à niveau de l'environnement, ou à une maintenance GKE.

Remarque : Le problème en lui-même n'indique aucun problème dans l'environnement et n'entraîne aucun échec réel dans l'exécution des tâches.

Ce problème est résolu dans Cloud Composer version 2.6.5 ou ultérieure.

Les composants Airflow rencontrent des problèmes de communication avec d'autres parties de la configuration Cloud Composer.

Ce problème ne concerne que les versions 2.10.2 et antérieures de Cloud Composer 2.

Dans de très rares cas, la lenteur de la communication avec le serveur de métadonnées Compute Engine peut entraîner un fonctionnement non optimal des composants Airflow. Par exemple, le planificateur Airflow peut être redémarré, les tâches Airflow peuvent nécessiter de nouvelles tentatives ou le temps de démarrage des tâches peut être plus long.

Symptômes :

Les erreurs suivantes s'affichent dans les journaux des composants Airflow (tels que les planificateurs, les nœuds de calcul ou le serveur Web Airflow) :

Authentication failed using Compute Engine authentication due to unavailable metadata server

Compute Engine Metadata server unavailable on attempt 1 of 3. Reason: timed out

...

Compute Engine Metadata server unavailable on attempt 2 of 3. Reason: timed out

...

Compute Engine Metadata server unavailable on attempt 3 of 3. Reason: timed out

Solution :

(Recommandé) Mettez à niveau votre environnement vers une version ultérieure de Cloud Composer. Ce problème est résolu à partir de la version 2.11.0 de Cloud Composer.

Pour résoudre temporairement ce problème, vous pouvez définir la variable d'environnement suivante :

GCE_METADATA_TIMEOUT=30. Assurez-vous de supprimer ce paramètre lorsque vous êtes prêt à mettre à niveau votre environnement.

Le dossier /data n'est pas disponible dans le serveur Web Airflow

Dans Cloud Composer 2 et Cloud Composer 3, le serveur Web Airflow est conçu pour être un composant en lecture seule. Cloud Composer ne synchronise pas le dossier data/ avec ce composant.

Parfois, vous pouvez souhaiter partager des fichiers communs entre tous les composants Airflow, y compris le serveur Web Airflow.

Solution :

Encapsulez les fichiers à partager avec le serveur Web dans un module PYPI et installez-le en tant que package PYPI standard. Une fois le module PYPI installé dans l'environnement, les fichiers sont ajoutés aux images des composants Airflow et sont disponibles pour eux.

Ajoutez des fichiers au dossier

plugins/. Ce dossier est synchronisé avec le serveur Web Airflow.

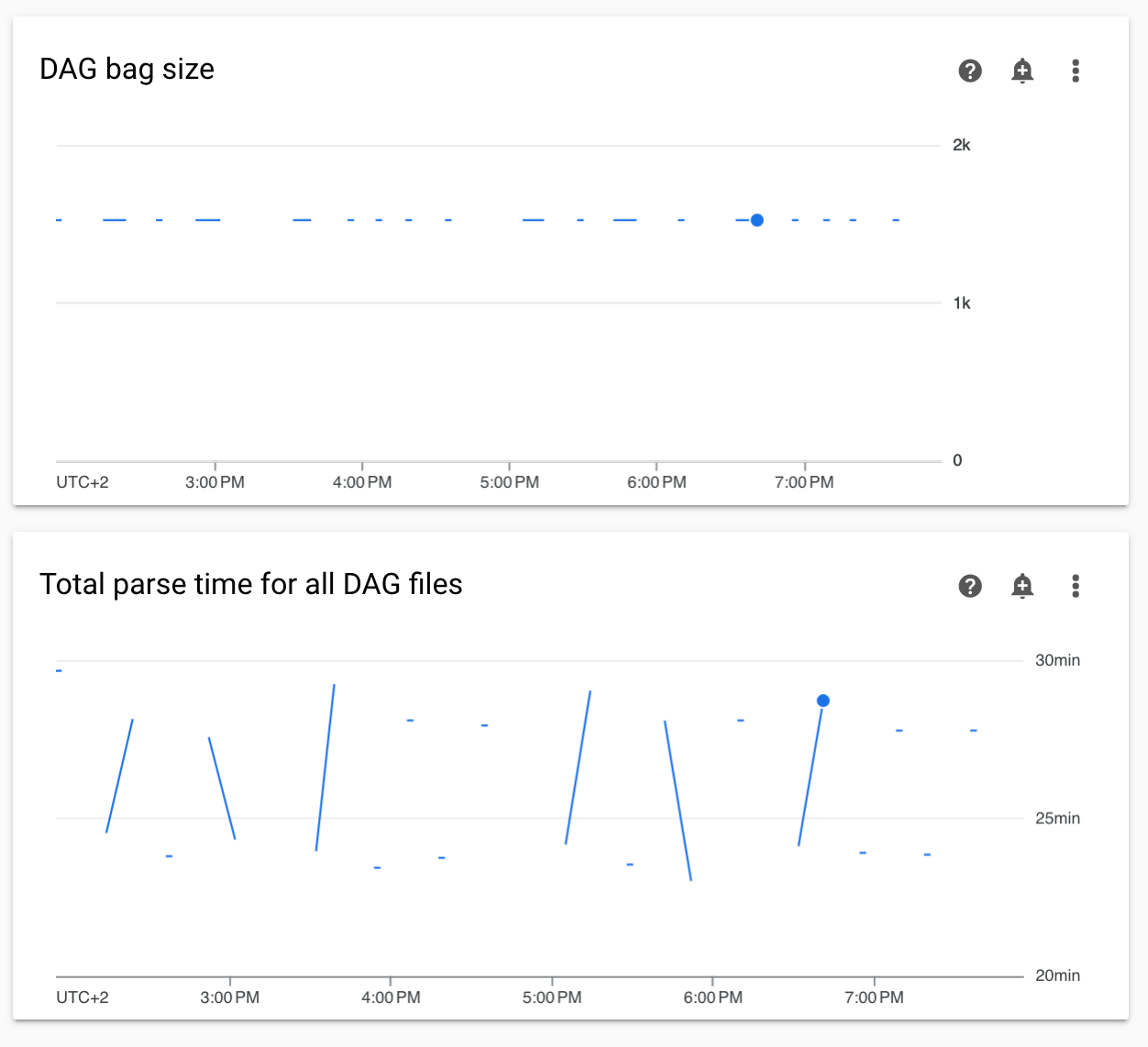

Diagrammes de la durée d'analyse des DAG non continus et de la taille du DAG bag dans la section "Surveillance"

Les diagrammes non continus des temps d'analyse des DAG et de la taille du DAG bag sur le tableau de bord de surveillance indiquent des problèmes liés à des temps d'analyse des DAG longs (plus de cinq minutes).

Solution : nous vous recommandons de maintenir la durée d'analyse totale du DAG sous les cinq minutes. Pour réduire le temps d'analyse des DAG, suivez les consignes de rédaction des DAG.

Les journaux des composants Cloud Composer sont manquants dans Cloud Logging

Un problème est survenu dans le composant de l'environnement chargé d'importer les journaux des composants Airflow dans Cloud Logging. Ce bug entraîne parfois la disparition des journaux au niveau de Cloud Composer pour un composant Airflow. Le même journal reste disponible au niveau du composant Kubernetes.

Fréquence du problème : très rare, sporadique

Cause :

Comportement incorrect du composant Cloud Composer chargé d'importer les journaux dans Cloud Logging.

Solutions :

Mettez à niveau votre environnement vers Cloud Composer version 2.10.0 ou ultérieure.

Dans les versions antérieures de Cloud Composer, la solution temporaire lorsque vous rencontrez ce problème consiste à lancer une opération Cloud Composer qui redémarre les composants pour lesquels le journal est manquant.

Il n'est pas possible de passer à l'édition GKE Enterprise pour le cluster de l'environnement.

Cette remarque s'applique à Cloud Composer 1 et Cloud Composer 2.

Le cluster GKE de l'environnement Cloud Composer est créé dans GKE Standard Edition.

Depuis décembre 2024, le service Cloud Composer ne permet pas de créer des environnements Cloud Composer avec des clusters dans l'édition Enterprise.

Les environnements Cloud Composer n'ont pas été testés avec GKE Enterprise Edition, qui utilise un modèle de facturation différent.

D'autres informations concernant l'édition GKE Standard par rapport à l'édition Enterprise seront communiquées au deuxième trimestre 2025.

Composants Airflow rencontrant des problèmes de communication avec d'autres parties de la configuration Cloud Composer

Dans certains cas, en raison d'une résolution DNS ayant échoué, les composants Airflow peuvent rencontrer des problèmes lors de la communication avec d'autres composants Cloud Composer ou points de terminaison de service en dehors de l'environnement Cloud Composer.

Symptômes :

Les erreurs suivantes peuvent s'afficher dans les journaux des composants Airflow (tels que les planificateurs, les nœuds de calcul ou le serveur Web Airflow) :

google.api_core.exceptions.ServiceUnavailable: 503 DNS resolution failed ...

... Timeout while contacting DNS servers

ou

Could not access *.googleapis.com: HTTPSConnectionPool(host='www.googleapis.com', port=443): Max retries exceeded with url: / (Caused by NameResolutionError("<urllib3.connection.HTTPSConnection object at 0x7c5ef5adba90>: Failed to resolve 'www.googleapis.com' ([Errno -3] Temporary failure in name resolution)"))

ou

redis.exceptions.ConnectionError: Error -3 connecting to

airflow-redis-service.composer-system.svc.cluster.local:6379.

Temporary failure in name resolution.

Solutions possibles :

Passez à Cloud Composer 2.9.11 ou

Définissez la variable d'environnement suivante :

GCE_METADATA_HOST=169.254.169.254.

L'environnement est à l'état ERROR après la suppression ou la désactivation du compte de facturation du projet, ou la désactivation de l'API Cloud Composer

Les environnements Cloud Composer concernés par ces problèmes ne peuvent pas être récupérés :

- Après la suppression ou la désactivation du compte de facturation du projet, même si un autre compte a été associé ultérieurement.

- Après la désactivation de l'API Cloud Composer dans le projet, même si elle a été activée ultérieurement.

Pour résoudre le problème, vous pouvez procéder comme suit :

Vous pouvez toujours accéder aux données stockées dans les buckets de votre environnement, mais ceux-ci ne sont plus utilisables. Vous pouvez créer un environnement Cloud Composer, puis transférer vos DAG et vos données.

Si vous souhaitez effectuer l'une des opérations qui rendent vos environnements non récupérables, veillez à sauvegarder vos données, par exemple en créant un instantané de l'environnement. Vous pouvez ainsi créer un autre environnement et transférer ses données en chargeant cet instantané.

Avertissements concernant le budget d'interruption de pods pour les clusters d'environnement

Vous pouvez voir les avertissements suivants dans l'interface utilisateur GKE pour les clusters d'environnement Cloud Composer :

GKE can't perform maintenance because the Pod Disruption Budget allows

for 0 Pod evictions. Update the Pod Disruption Budget.

A StatefulSet is configured with a Pod Disruption Budget but without readiness

probes, so the Pod Disruption Budget isn't as effective in gauging application

readiness. Add one or more readiness probes.

Il n'est pas possible de supprimer ces avertissements. Nous nous efforçons d'empêcher la génération de ces avertissements.

Solutions possibles :

- Ignorez ces avertissements jusqu'à ce que le problème soit résolu.

Il est impossible de supprimer la valeur d'un champ dans une connexion Airflow.

Cause :

L'interface utilisateur Apache Airflow présente une limite qui empêche de définir des valeurs vides pour les champs de connexion. Lorsque vous essayez de le faire, le système rétablit les paramètres enregistrés précédemment.

Solutions possibles :

Bien que la version 2.10.4 d'Apache Airflow inclue une solution permanente, une solution temporaire existe pour les utilisateurs des versions antérieures. Pour ce faire, supprimez la connexion, puis recréez-la en laissant les champs obligatoires vides. L'interface de ligne de commande est la méthode recommandée pour supprimer la connexion :

gcloud composer environments run ENVIRONMENT_NAME \

--location LOCATION \

connections delete -- \

CONNECTION_ID

Après avoir supprimé la connexion, recréez-la à l'aide de l'interface utilisateur Airflow en veillant à ce que les champs que vous souhaitez laisser vides le soient effectivement. Vous pouvez également créer la connexion en exécutant la commande CLI Airflow connections add avec Google Cloud CLI.

Les journaux des tâches Airflow ne sont pas collectés si [core]execute_tasks_new_python_interpreter est défini sur "True"

Cloud Composer ne collecte pas les journaux des tâches Airflow si l'option de configuration Airflow [core]execute_tasks_new_python_interpreter est définie sur True.

Solution possible :

- Supprimez le remplacement de cette option de configuration ou définissez sa valeur sur

False.

Étapes suivantes

- Résoudre les problèmes de création d'environnement

- Découvrez comment résoudre les problèmes liés aux DAG.

- Résoudre les problèmes liés à Airflow Scheduler