Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

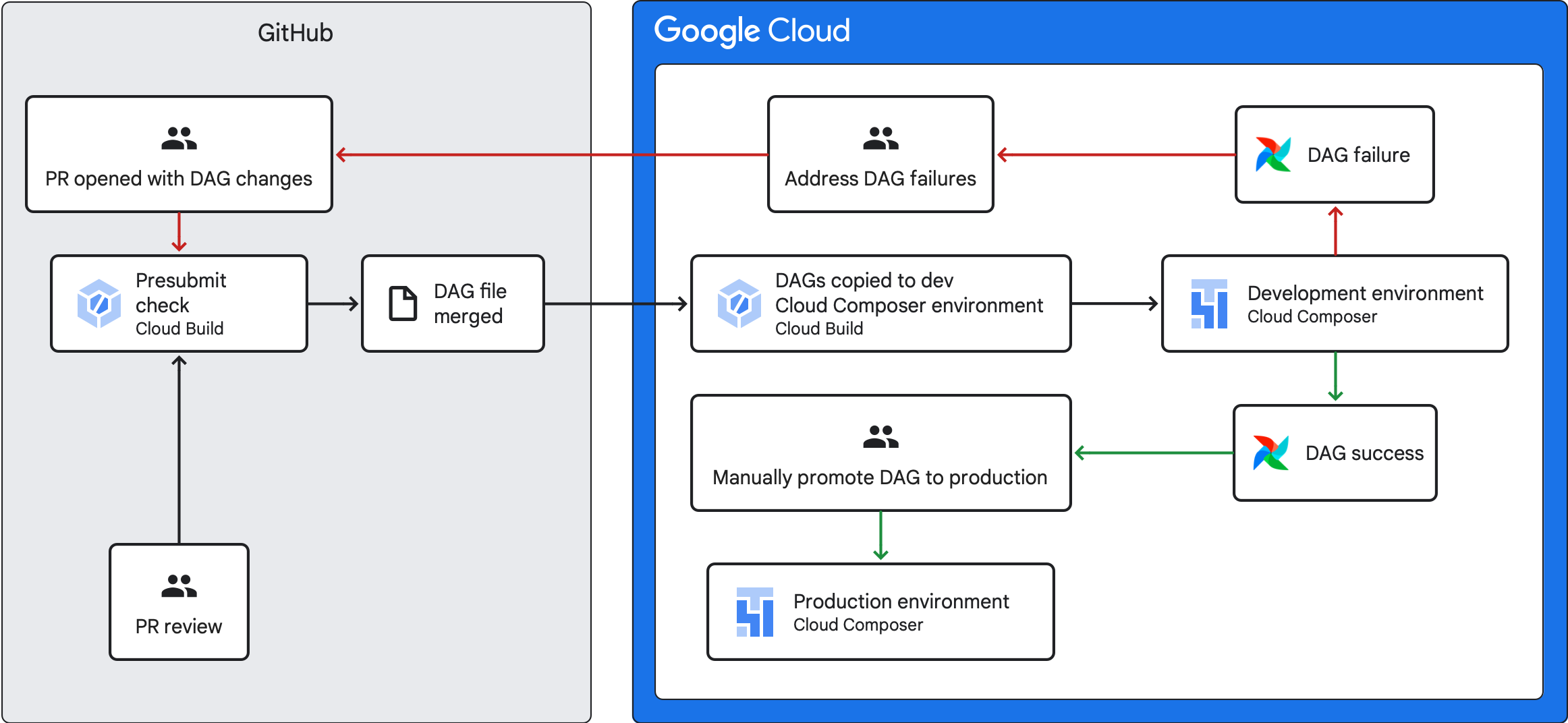

En esta guía se explica cómo crear una canalización de CI/CD para probar, sincronizar e implementar DAGs en tu entorno de Cloud Composer desde tu repositorio de GitHub.

Si solo quieres sincronizar datos de otros servicios, consulta el artículo Transferir datos de otros servicios.

Descripción general de los flujos de procesamiento de CI/CD

El flujo de procesamiento de CI/CD que prueba, sincroniza y despliega los DAGs tiene los siguientes pasos:

Haces un cambio en un DAG e insertas ese cambio en una rama de desarrollo de tu repositorio.

Abre una solicitud de extracción en la rama principal de tu repositorio.

Cloud Build ejecuta pruebas unitarias para comprobar que tu DAG sea válido.

Tu solicitud de extracción se ha aprobado y se ha combinado con la rama principal de tu repositorio.

Cloud Build sincroniza tu entorno de desarrollo de Cloud Composer con estos nuevos cambios.

Verificas que el DAG funciona correctamente en tu entorno de desarrollo.

Si tu DAG funciona como esperabas, súbelo a tu entorno de producción de Cloud Composer.

Objetivos

- Ejecuta una comprobación previa automática con Cloud Build. Esta comprobación ejecuta pruebas unitarias de un DAG.

- Sincroniza los DAGs de tu entorno de desarrollo de Cloud Composer con los de tu repositorio de GitHub.

Antes de empezar

En esta guía se presupone que trabajas con dos entornos de Cloud Composer idénticos: un entorno de desarrollo y un entorno de producción.

En esta guía, solo se configura una canalización de CI/CD para el entorno de desarrollo. Asegúrate de que el entorno que utilices no sea un entorno de producción.

En esta guía se da por hecho que tienes tus DAGs y sus pruebas almacenados en un repositorio de GitHub.

La pipeline de CI/CD de ejemplo muestra el contenido de un repositorio de ejemplo. Los DAGs y las pruebas se almacenan en el directorio

dags/, mientras que los archivos de requisitos, el archivo de restricciones y los archivos de configuración de Cloud Build se almacenan en el nivel superior. La utilidad de sincronización de DAG y sus requisitos se encuentran en el directorioutils.

Crear una tarea de comprobación previa y pruebas unitarias

La primera tarea de Cloud Build ejecuta una comprobación previa al envío, que ejecuta pruebas unitarias de tus DAGs.

Añadir pruebas unitarias

Si aún no lo has hecho, escribe pruebas unitarias para tus DAGs. Guarda estas pruebas junto con los DAGs en tu repositorio. Cada prueba debe tener el sufijo _test. Por ejemplo, el archivo de prueba del DAG en example_dag.py es example_dag_test.py. Estas son las pruebas que se ejecutan como comprobación previa en tu repositorio.

Crear una configuración YAML de Cloud Build para la comprobación previa a la confirmación

En tu repositorio, crea un archivo YAML llamado test-dags.cloudbuild.yaml que configure tu tarea de Cloud Build para las comprobaciones previas a la confirmación. En él, hay tres pasos:

- Instala las dependencias que necesiten tus DAGs.

- Instala las dependencias que necesiten tus pruebas unitarias.

- Ejecuta las pruebas de DAG.

Crear el activador de Cloud Build para la comprobación previa a la confirmación

Sigue la guía Crear repositorios desde GitHub para crear un activador basado en una aplicación de GitHub con las siguientes configuraciones:

Nombre:

test-dagsEvento: solicitud de extracción

Origen: repositorio. Elige el repositorio.

Fuente - Rama base:

^main$(cambiamainpor el nombre de la rama base de tu repositorio, si es necesario)Fuente: control de comentarios (no obligatorio)

Configuración de compilación: archivo de configuración de Cloud Build:

/test-dags.cloudbuild.yaml(ruta al archivo de compilación)

Crear un trabajo de sincronización de DAGs y añadir una secuencia de comandos de utilidad de DAGs

A continuación, configura una tarea de Cloud Build que ejecute una secuencia de comandos de utilidad de DAGs. La secuencia de comandos de utilidad de este trabajo sincroniza tus DAGs con tu entorno de Cloud Composer después de que se combinen en la rama principal de tu repositorio.

Añadir la secuencia de comandos de utilidad de los DAGs

Añade la secuencia de comandos de la utilidad DAG a tu repositorio. Esta secuencia de comandos de utilidad copia todos los archivos DAG del directorio dags/ de tu repositorio en un directorio temporal e ignora todos los archivos Python que no sean DAG. A continuación, la secuencia de comandos usa la biblioteca de cliente de Cloud Storage para subir todos los archivos de ese directorio temporal al directorio dags/ del bucket de tu entorno de Cloud Composer.

Crear una configuración YAML de Cloud Build para sincronizar DAGs

En tu repositorio, crea un archivo YAML llamado add-dags-to-composer.cloudbuild.yaml que configure tu trabajo de Cloud Build para sincronizar los DAGs. En él, hay dos pasos:

Instala las dependencias que necesita la secuencia de comandos de utilidad de los DAGs.

Ejecuta la secuencia de comandos de la utilidad para sincronizar los DAGs de tu repositorio con tu entorno de Cloud Composer.

Crea el activador de Cloud Build

Sigue la guía Crear repositorios desde GitHub para crear un activador basado en una aplicación de GitHub con las siguientes configuraciones:

Nombre:

add-dags-to-composerEvento: inserción en una rama

Origen: repositorio. Elige el repositorio.

Fuente - Rama base:

^main$(cambiamainpor el nombre de la rama base de tu repositorio, si es necesario)Fuente: filtro de archivos incluidos (glob):

dags/**Configuración de compilación: archivo de configuración de Cloud Build:

/add-dags-to-composer.cloudbuild.yaml(ruta al archivo de compilación)

En la configuración avanzada, añade dos variables de sustitución:

_DAGS_DIRECTORY: el directorio en el que se encuentran los DAGs en tu repositorio. Si usas el repositorio de ejemplo de esta guía, esdags/._DAGS_BUCKET: el segmento de Cloud Storage que contiene el directoriodags/de tu entorno de desarrollo de Cloud Composer. Omite el prefijogs://. Por ejemplo:us-central1-example-env-1234ab56-bucket.

Probar tu flujo de procesamiento de CI/CD

En esta sección, sigue un flujo de desarrollo de DAG que utilice los activadores de Cloud Build que acabas de crear.

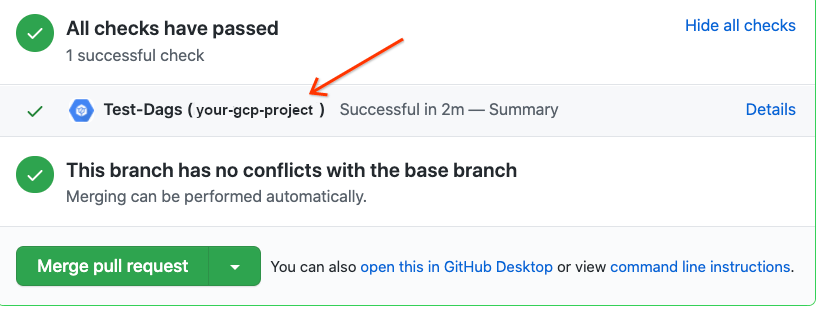

Ejecutar una tarea de envío previo

Crea una solicitud de extracción en tu rama principal para probar la compilación. Busca la comprobación previa en la página. Haz clic en Detalles y elige Ver más detalles en Google Cloud Build para ver los registros de compilación en laGoogle Cloud consola.

Si la comprobación previa al envío ha fallado, consulta Solucionar errores de compilación.

Validar que tu DAG funciona en tu entorno de desarrollo

Una vez que se apruebe tu solicitud de extracción, combínala con tu rama principal. Usa la consolaGoogle Cloud para ver los resultados de tu compilación. Si tienes muchos activadores de Cloud Build, puedes filtrar tus compilaciones por el nombre del activador

add-dags-to-composer.

Una vez que el trabajo de sincronización de Cloud Build se haya completado correctamente, el DAG sincronizado aparecerá en tu entorno de desarrollo de Cloud Composer. Ahí puedes comprobar que el DAG funciona correctamente.

Añade el DAG a tu entorno de producción

Una vez que el DAG funcione como se espera, añádelo manualmente a tu entorno de producción. Para ello, sube el archivo DAG

al directorio dags/ del segmento de tu entorno de producción de Cloud Composer.

Si la tarea de sincronización de tu DAG ha fallado o si tu DAG no se comporta como esperabas en tu entorno de desarrollo de Cloud Composer, consulta Solucionar errores de compilación.

Solucionar errores de compilación

En esta sección se explica cómo abordar situaciones habituales de fallos de compilación.

¿Qué ocurre si no supero la comprobación previa al envío?

En tu solicitud de extracción, haz clic en Detalles y elige Ver más detalles en Google Cloud Build para ver los registros de compilación en la consola deGoogle Cloud . Usa estos registros para depurar el problema con tu DAG. Una vez que haya resuelto los problemas, confirme la corrección y envíela a su rama. La comprobación previa se vuelve a ejecutar y puedes seguir iterando con los registros como herramienta de depuración.

¿Qué ocurre si falla mi trabajo de sincronización de DAG?

Usa la consola Google Cloud para ver los resultados de tu compilación. Si tienes muchos activadores de Cloud Build, puedes filtrar tus compilaciones por el nombre del activador

add-dags-to-composer. Examina los registros del trabajo de compilación y resuelve los errores. Si necesitas más ayuda para resolver los errores, utiliza los canales de asistencia.

¿Qué ocurre si mi DAG no funciona correctamente en mi entorno de Cloud Composer?

Si tu DAG no funciona como esperabas en tu entorno de desarrollo de Cloud Composer, no lo asciendas manualmente a tu entorno de producción de Cloud Composer. En su lugar, haz una de las siguientes acciones:

- Revierte la solicitud de extracción con los cambios que han dañado tu DAG para restaurarlo al estado inmediatamente anterior a los cambios (esto también revierte todos los demás archivos de esa solicitud de extracción).

- Crea una solicitud de extracción para revertir manualmente los cambios del DAG dañado.

- Crea una solicitud de extracción para corregir los errores de tu DAG.

Si sigues alguno de estos pasos, se activará una nueva comprobación previa al envío y, al combinar, se activará el trabajo de sincronización de DAG.