Explainable AI を使って、車両の破損を特定する効果的な方法を考案する

Google Cloud Japan Team

※この投稿は米国時間 2023 年 7 月 8 日に、Google Cloud blog に投稿されたものの抄訳です。

保険代理店にとって、破損した車両の写真をもとに正確な賠償請求資料を作成することは非常に重要な作業です。その重要性を踏まえ、タイの大手テクノロジー企業である KASIKORN Business-Technology Group(KBTG)Labs は、ML 技術を使って請求手続きをスピードアップするとともに、請求情報の正確性の確保を徹底しています。

KBTG は、火災、海上、自動車保険を取り扱うタイの保険会社 Muang Thai Insurance PCL(MTI)と提携しています。事故で車両が破損した際は、修理店が損害を評価し、賠償請求資料を保険会社に提出するのが一般的な流れです。この請求資料は保険会社による検証を経て、仲介業者がさらに検証し、証拠写真を提出します。

現在、損害評価から請求審査までの一連の手続きは、複数のパートナー会社や仲介業者が介在してすべて人手によって行われており、時間や費用がかかるという問題があります。この問題に対処するため、KBTG Labs は Google Cloud と連携してあるソリューションを打ち出しました。

ソリューション アーキテクチャの構築

これまで請求処理に使用されていたデータセットは、データの品質と量に難点がありました。具体的には、画像を撮影する距離が遠すぎたり近すぎたりして破損箇所を特定しづらい、説明が正確でないといった問題です。

Google Cloud はこうした問題に対処するため、カスケード モデルのアプローチを取り入れたソリューション アーキテクチャを構築し、画質評価を組み込むことを提案しました。

上図の推論パイプラインは、スケーラビリティ、高可用性、フォールト トレラントを考慮した設計となっています。実行のためのマイクロサービスと、入力に基づくモデル選択、中間モデルの出力は、Google Kubernetes Engine が担当します。続けて、画像が Cloud Storage に保存され、バケット内での予測のために送信されます。この画像は、のちにラベルが付けられて、継続的なトレーニングに使用されます。結果は Cloud SQL に保存され、推論および分析に利用されます。Image Qualifier モデルは Vertex AI を使って、入力画像の良し悪しを分類しています。このモデルタイプは、モデルの推論に進む前の画質フィルタとして機能しており、画質が一定の基準に達している場合にのみモデルを実行することで、処理を効率化しています。

さまざまな画像での実験

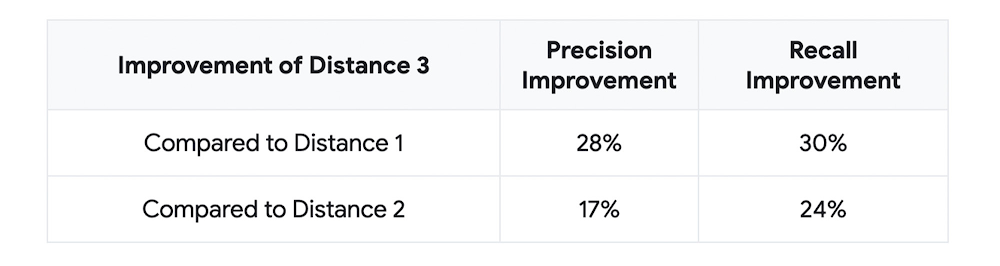

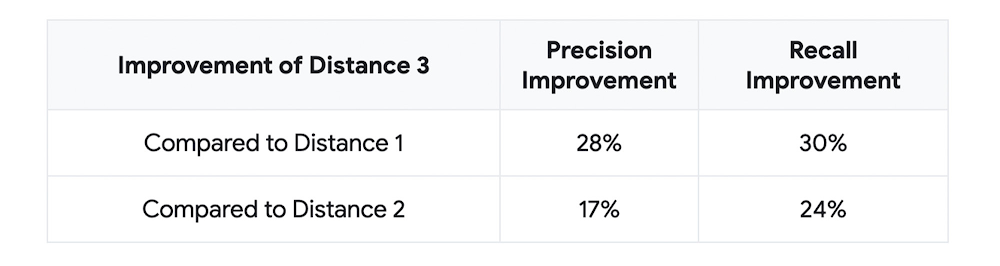

上述のとおり、Google Cloud が提案したアーキテクチャには、画像が ML に適しているかどうかを判断する Image Qualifier モデルが含まれています。このプロジェクトの後半で、担当チームはモデル内の画像を「良質」または「不良」に分類する実験を行いました。この分析作業を通して明らかになったのは、画像の撮影距離が最も重要な要素であるという事実です。適切な距離指標を用いて撮影された画像では、ML モデルの適合率や再現率が約 30% 上昇しました。以下の表に、実験結果を示します。

注:

距離 1 = 車の全体像ではないが、複数のパーツを捉えている画像(車両全体が見えているラベル 0 よりもクローズアップの画像)

距離 2 = 写真の中央に主なパーツ 1 つのみを捉えた画像(ラベル 1 よりもクローズアップの画像)

距離 3 = 至近距離から撮影されたため、車のパーツが特定できず、使用不可の画像

Explainable AI によるモデル予測の向上

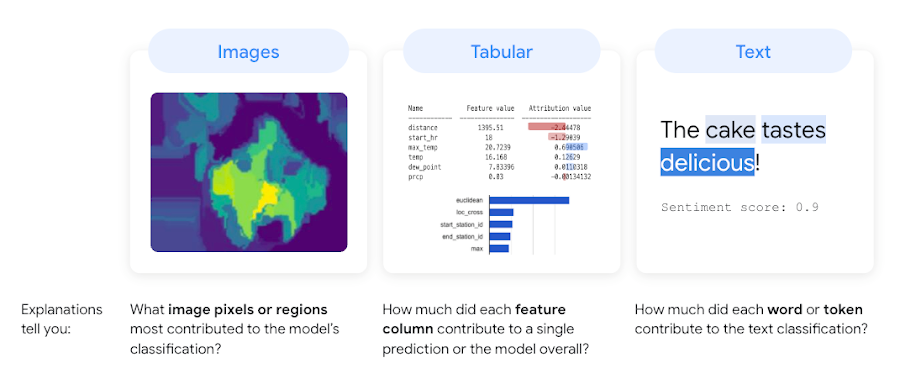

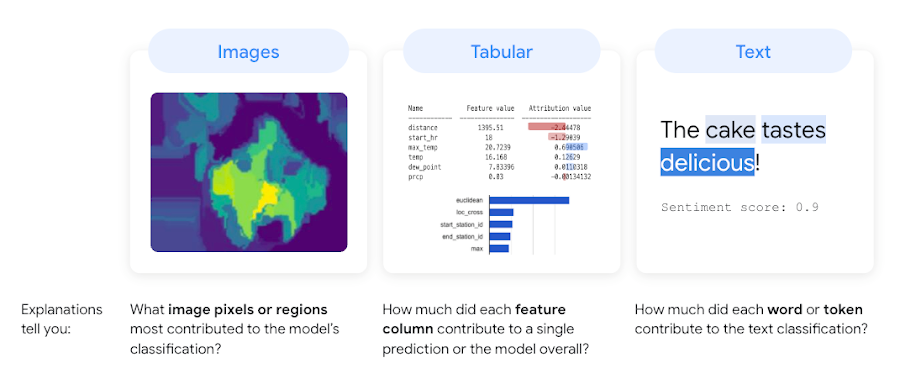

画像分類において説明能力をさらに強化するために、チームは Google Cloud プロダクトの Explainable AI を使用しました。Explainable AI は Vertex AI の一部であり、モデルの予測に対して「特徴アトリビューション」および「特徴の重要度」の値を生成できるようにするものです。特徴アトリビューションとは、入力内の各特徴がモデル予測およびモデルの全体的な予測能力に対してどの程度貢献しているかを示す、説明可能性のメソッドです。

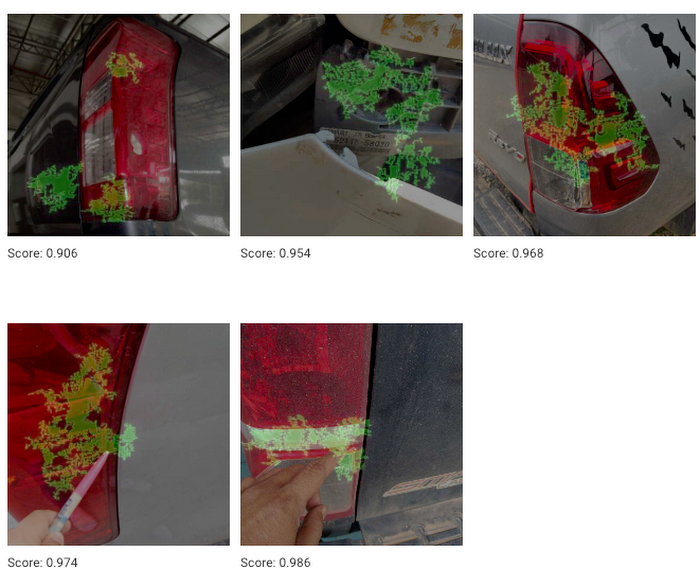

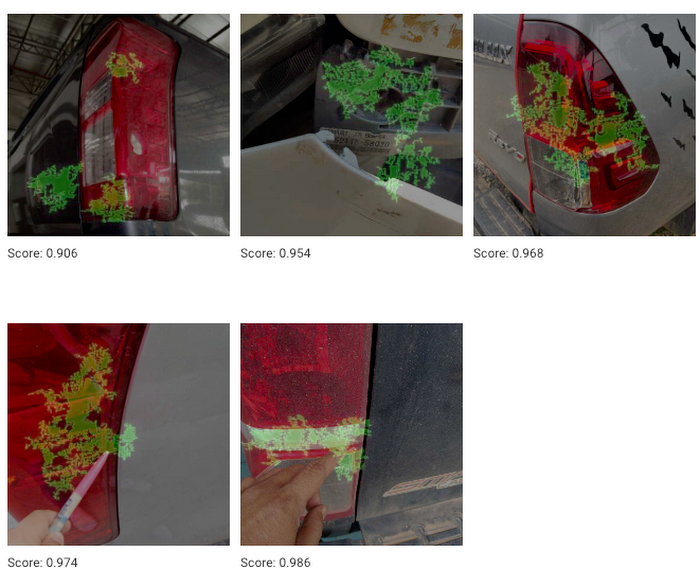

以下は、破損の真陽性の例(破損として認定対象であると ML が正しく予測できた画像の例)です。ご覧のとおり、どの写真も光が反射しています。Explainable AI は、車のライト上の緑の点がある箇所に集中し、この明るく浮かび上がった部分に基づいて、破損であるかどうかを判断しています。

当初想定していたアーキテクチャでは、破損の分類と物体の検出を互いに独立した処理と見なしていました。しかし、モデルの動作およびそのパフォーマンスを最適化する方法について説明や分析情報を提供するなかで、破損箇所の背景に写り込んだ物体の影響をできるだけ回避するためには、破損の特定および物体の検出を同時に行ったほうがよいということが明らかになりました。

明らかになったポイントと、さらなる改善のためのステップ

Explainable AI によって明らかになったのは、ML モデルが、破損箇所だけでなく破損した物体そのものにも着目しているという事実です。この結果を受け、物体を検出するためには、単純な分類モデルから学習するより、破損そのものが役に立つ、という仮説が浮かび上がっています。

このプロジェクトを通じて、車両の破損を検出するには撮影距離が重要なポイントであるということ、ならびに、背景にうつりこんだ物体の影響をできるだけ回避することの重要性が明らかになりました。Google Cloud は、これらの結果を踏まえ、物体の検出プロセスを含めて、実験結果を評価していく予定です。

ビジネスにおいて Vertex AI をどのように活用できるかについて詳しくは、Google Cloud のプロダクト ページをご覧ください。Explainable AI について詳しくは、こちらをご覧ください。

- ML / AI 担当戦略的クラウド エンジニア Akshit Ahluwalia