LangChain di Vertex AI (Pratinjau) memungkinkan Anda memanfaatkan library open source LangChain untuk membangun aplikasi AI Generatif kustom dan menggunakan Vertex AI untuk model, alat, dan deployment. Dengan fitur ini, Anda dapat memilih model bahasa besar yang ingin digunakan, menentukan alat untuk mengakses API eksternal, menyusun antarmuka antara pengguna dan komponen sistem dalam framework orkestrasi, dan men-deploy framework ke runtime terkelola.

Komponen sistem

Membangun dan men-deploy aplikasi AI generatif kustom menggunakan OSS LangChain dan Vertex AI terdiri dari empat komponen berikut:

| Komponen | Deskripsi |

|---|---|

| Model Gemini |

Saat pengguna mengirimkan kueri ke aplikasi kustomnya, model bahasa besar akan memproses kueri tersebut dan memberikan respons. Anda bisa memilih untuk mendefinisikan set alat yang berkomunikasi dengan API eksternal dan menyediakannya ke model. Saat memproses kueri, model dapat memilih untuk mendelegasikan tugas tertentu ke alat. Hal ini secara inheren dapat menyiratkan satu atau beberapa panggilan model ke model generik atau yang disesuaikan. Untuk mempelajari lebih lanjut, lihat Versi dan siklus proses model. |

| Alat Panggilan Fungsi Gemini |

Anda dapat memilih untuk mendefinisikan serangkaian alat yang berkomunikasi dengan API eksternal (seperti database, dll.) dan memberikannya ke model. Saat memproses kueri, model dapat memilih untuk mendelegasikan tugas tertentu ke alat yang telah ditentukan sebelumnya. Deployment melalui runtime terkelola Vertex AI dioptimalkan untuk menggunakan alat berdasarkan Gemini Function Calling, tetapi mendukung semua implementasi alat OSS LangChain. Untuk mempelajari Panggilan Fungsi Gemini lebih lanjut, lihat Panggilan fungsi. |

| Framework Orkestrasi Agen |

LangChain di Vertex AI memungkinkan Anda memanfaatkan framework orkestrasi OSS LangChain di Vertex AI. Dengan menggunakan LangChain, Anda dapat menentukan seberapa determenistik aplikasi Anda. Jika sudah menggunakan LangChain, Anda cukup menggunakan kode LangChain open source yang sudah ada untuk men-deploy aplikasi di Vertex AI. Jika tidak, Anda dapat membuat kode aplikasi sendiri dan menyusunnya dalam framework orkestrasi dengan memanfaatkan template LangChain dari Vertex AI. Untuk mempelajari lebih lanjut, lihat Mengembangkan aplikasi. |

| Mesin Penalaran Runtime Terkelola |

LangChain di Vertex AI memungkinkan Anda men-deploy aplikasi ke runtime yang dikelola Reasoning Engine. Runtime ini adalah layanan Vertex AI yang memiliki semua manfaat integrasi Vertex AI: keamanan, privasi, kemampuan observasi, dan skalabilitas. Anda dapat memproduksi dan menskalakan aplikasi dengan panggilan API sederhana, yang dengan cepat mengubah prototipe yang diuji secara lokal menjadi deployment yang siap digunakan perusahaan. Untuk mempelajari lebih lanjut, lihat Men-deploy aplikasi. |

Ada banyak cara untuk membuat prototipe dan membangun aplikasi AI Generatif kustom yang memanfaatkan kemampuan agen dengan memberi lapisan alat, fungsi kustom, dan selain model seperti Gemini. Jika tiba waktunya untuk memindahkan aplikasi ke produksi, Anda perlu mempertimbangkan cara men-deploy dan mengelola agen dan semua komponen yang mendasarinya.

Jika Anda bekerja di level yang lebih rendah dalam stack, Anda akan mencoba mengelola terlalu banyak hal. Jika Anda bekerja di level stack yang lebih tinggi, Anda akan kehilangan kontrol developer. Dengan komponen LangChain di Vertex AI, tujuannya adalah membantu Anda berfokus pada dan menyesuaikan aspek fungsi agen yang paling penting bagi Anda, seperti fungsi kustom, perilaku agen, dan parameter model, sementara Google menangani deployment, penskalaan pengemasan, versi, dll.

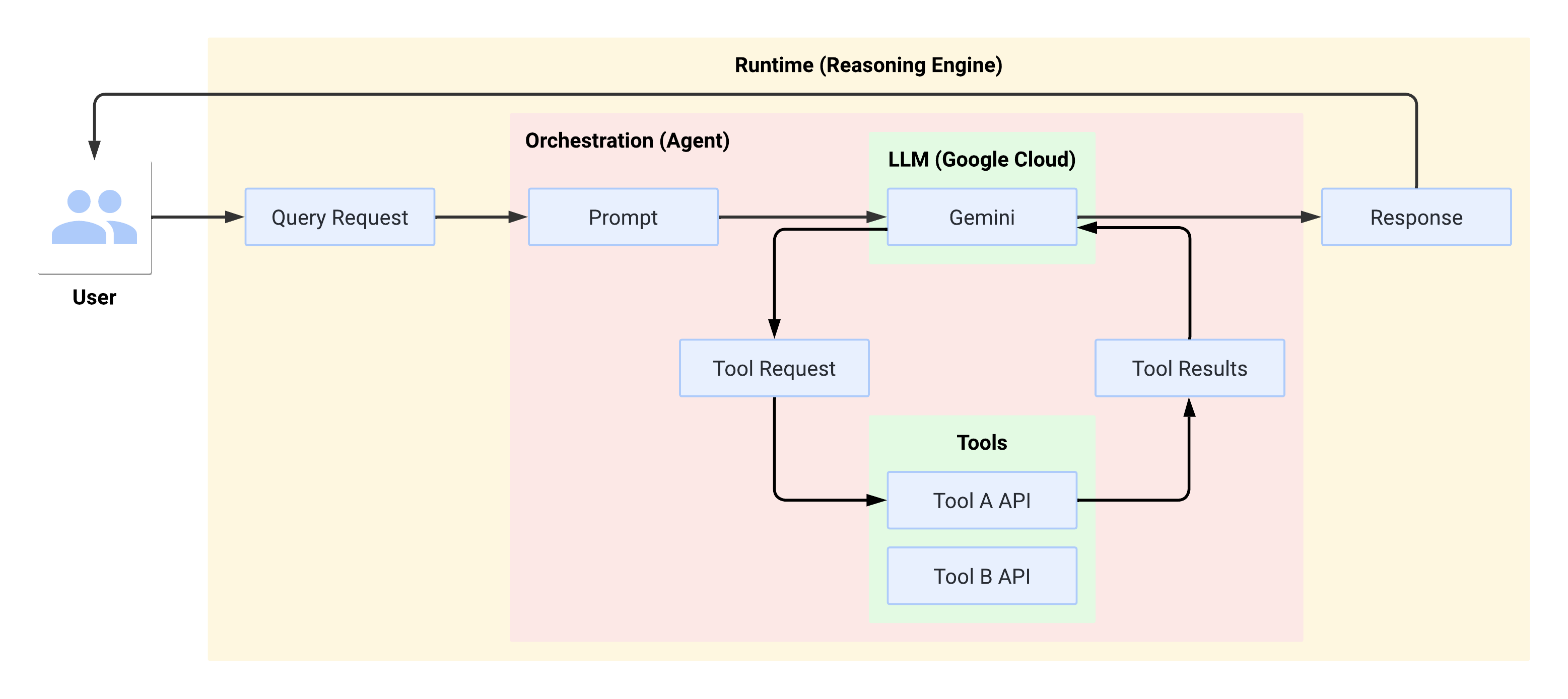

Alur sistem saat runtime

Saat pengguna membuat kueri, agen yang ditentukan akan memformatnya menjadi permintaan untuk LLM. LLM memproses perintah dan menentukan apakah LLM ingin menggunakan salah satu alat atau tidak.

Jika LLM memilih untuk menggunakan alat, LLM akan menghasilkan FunctionCall dengan nama

dan parameter yang digunakan untuk memanggil alat. Agen memanggil alat

dengan FunctionCall dan memberikan hasil dari alat kembali ke LLM.

Jika LLM memilih untuk tidak menggunakan alat apa pun, LLM akan menghasilkan konten yang

disampaikan kembali oleh agen kepada pengguna.

Diagram berikut mengilustrasikan alur sistem pada saat runtime:

Membuat dan men-deploy aplikasi AI generatif

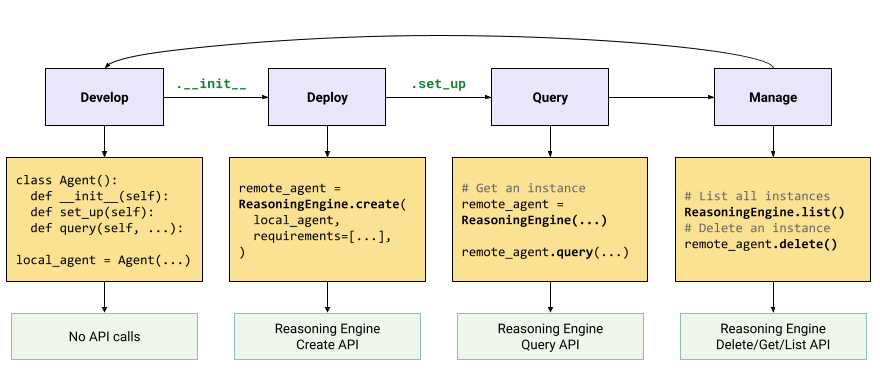

Keseluruhan alur kerja untuk membangun aplikasi AI generatif adalah sebagai berikut:

| Langkah | Deskripsi |

|---|---|

| 1. Menyiapkan lingkungan | Siapkan project Google Anda dan instal Vertex AI SDK versi terbaru untuk Python. |

| 2. Mengembangkan aplikasi | Mengembangkan aplikasi LangChain yang dapat di-deploy di Reasoning Engine. |

| 3. Men-deploy aplikasi | Men-deploy aplikasi di Reasoning Engine. |

| 4. Menggunakan aplikasi | Mesin Penalaran Kueri untuk konten. |

| 5. Mengelola aplikasi yang di-deploy | Mengelola dan menghapus aplikasi yang telah Anda deploy ke Reasoning Engine. |

Langkah-langkah ini diilustrasikan dalam diagram berikut:

Manfaat

- Dapat disesuaikan sepenuhnya: Dengan memanfaatkan antarmuka standar LangChain, LangChain di Vertex AI dapat diadopsi untuk membangun segala jenis aplikasi. Sangat mudah untuk menyesuaikan logika aplikasi Anda dan menggunakan framework open source atau framework lokal, yang memberikan tingkat fleksibilitas yang tinggi.

- Mudah digunakan: LangChain di Vertex AI menggunakan API yang sederhana dan intuitif yang sama dengan LangChain OSS untuk berinteraksi dengan LLM dan membangun aplikasi. Framework ini membuat deployment cepat dan mudah dengan LLM Vertex AI karena runtime Reasoning Engine mendukung deployment sekali klik untuk menghasilkan API yang sesuai berdasarkan library Anda.

- Integrasi dengan ekosistem Google Cloud dan Vertex AI: Reasoning Engine for LangChain di Vertex AI menggunakan infrastruktur Vertex AI dan container bawaan untuk mempercepat deployment aplikasi LLM Anda. Alat ini memiliki integrasi SDK yang bersih dengan layanan Google Cloud, seperti Gemini API, Function Calling, dan Ekstensi yang lancar dan aman.

- Aman, pribadi, dan skalabel: Anda dapat menggunakan panggilan SDK tunggal, tanpa perlu mengelola proses pengembangan sendiri. Runtime terkelola Reasoning Engine membebaskan Anda dari tugas-tugas seperti pengembangan server aplikasi, pembuatan container, dan konfigurasi autentikasi, IAM, serta penskalaan. Vertex AI menangani penskalaan otomatis, ekspansi regional, kerentanan container, serta kemampuan observasi dan horizontal. Library ini membuat setiap Reasoning Engine dalam container terpisah dan mendukung sejumlah pengoptimalan horizontal.

Kasus penggunaan

Anda dapat menggunakan LangChain di Vertex AI untuk tugas berikut:

- Ekstrak entity dari cerita natural language: Ekstrak daftar karakter, hubungan, benda, dan tempat dari cerita.

Vertex AI SDK untuk notebook Python - Ekstraksi data terstruktur menggunakan panggilan fungsi - Membuat kueri dan memahami database SQL menggunakan natural language: Minta model untuk mengonversi pertanyaan seperti

What percentage of orders are returned?ke dalam kueri SQL dan membuat fungsi yang mengirimkan kueri tersebut ke BigQuery.

Postingan blog - Membangun Aplikasi Eksplorasi Data BigQuery yang didukung AI menggunakan Panggilan Fungsi di Gemini - Membantu pelanggan berinteraksi dengan bisnis: Buat fungsi yang terhubung ke API bisnis, sehingga model dapat memberikan jawaban akurat untuk kueri seperti

Do you have the Pixel 8 Pro in stock?atauIs there a store in Mountain View, CA that I can visit to try it out?

Vertex AI SDK untuk notebook Python - Pemanggilan Fungsi dengan Vertex AI Gemini API & Python SDK - Bangun aplikasi AI generatif dengan menghubungkan ke API publik, seperti:

- Mengonversi antar-mata uang: Buat fungsi yang terhubung ke aplikasi pertukaran mata uang, sehingga model dapat memberikan jawaban akurat untuk kueri seperti

What's the exchange rate for euros to dollars today?

Codelab - Cara Berinteraksi dengan API Menggunakan Panggilan Fungsi di Gemini - Mendapatkan cuaca untuk lokasi tertentu: Buat fungsi yang terhubung ke API layanan meteorologi, yang memungkinkan model memberikan jawaban akurat untuk kueri seperti

What's the weather like in Paris?

Vertex AI SDK untuk notebook Python - Panggilan Fungsi dengan Vertex AI Gemini API & Python SDK

Postingan blog - Panggilan fungsi: Framework native untuk menghubungkan Gemini ke sistem eksternal, data, dan API - Mengonversi alamat menjadi koordinat lintang dan bujur: Buat fungsi yang mengonversi data lokasi terstruktur menjadi koordinat lintang dan bujur. Minta model untuk mengidentifikasi alamat, kota, negara bagian/provinsi, dan kode pos dalam kueri seperti

I want to get the lat/lon coordinates for the following address: 1600 Amphitheatre Pkwy, Mountain View, CA 94043, US.

Vertex AI SDK untuk notebook Python - Pemanggilan Fungsi dengan Vertex AI Gemini API & Python SDK

- Mengonversi antar-mata uang: Buat fungsi yang terhubung ke aplikasi pertukaran mata uang, sehingga model dapat memberikan jawaban akurat untuk kueri seperti

- Menafsirkan perintah suara: Buat fungsi yang sesuai dengan tugas di kendaraan. Misalnya, Anda dapat membuat fungsi yang menyalakan radio atau mengaktifkan AC. Kirim file audio perintah suara pengguna ke model, dan minta model untuk mengonversi audio menjadi teks dan mengidentifikasi fungsi yang ingin dipanggil pengguna.

- Mengotomatiskan alur kerja berdasarkan pemicu lingkungan: Buat fungsi untuk mewakili proses yang dapat diotomatiskan. Berikan data dari sensor lingkungan pada model, lalu minta model tersebut untuk mengurai dan memproses data guna menentukan apakah satu atau beberapa alur kerja harus diaktifkan. Misalnya, model dapat memproses data suhu di warehouse dan memilih untuk mengaktifkan fungsi sprinkler.

- Mengotomatiskan penetapan tiket dukungan: Berikan tiket dukungan, log, dan aturan kontekstual kepada model. Minta model untuk memproses semua informasi ini untuk menentukan kepada siapa tiket harus diberikan. Panggil fungsi untuk menetapkan tiket kepada orang yang disarankan oleh model.

- Mengambil informasi dari pusat informasi: Membuat fungsi yang mengambil artikel akademik tentang subjek tertentu dan meringkasnya. Memungkinkan model menjawab pertanyaan tentang subjek akademik dan memberikan kutipan untuk jawabannya.