Filtros de seguridad configurables

Confianza del atributo de seguridad y puntuación de gravedad

El contenido procesado a través de la API de Vertex AI PaLM se evalúa en función de una lista de atributos de seguridad, que incluyen “categorías perjudiciales” y temas que pueden considerarse sensibles.

Cada atributo de seguridad tiene asociado una puntuación de confianza entre 0.0 y 1.0, redondeada a un decimal, que refleja la probabilidad de que la entrada o respuesta pertenezca a una categoría determinada.

Cuatro de estos atributos de seguridad (acoso, incitación al odio o a la violencia, contenido peligroso y contenido sexual explícito) reciben una calificación de seguridad (nivel de gravedad) y una puntuación de gravedad que varía de 0.0 a 1.0, redondeada a un decimal. Estas calificaciones y puntuaciones reflejan la gravedad prevista del contenido que pertenece a una categoría determinada.

Respuesta de muestra

{

"predictions": [

{

"safetyAttributes": {

"categories": [

"Derogatory",

"Toxic",

"Violent",

"Sexual",

"Insult",

"Profanity",

"Death, Harm & Tragedy",

"Firearms & Weapons",

"Public Safety",

"Health",

"Religion & Belief",

"Illicit Drugs",

"War & Conflict",

"Politics",

"Finance",

"Legal"

],

"scores": [

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1

],

"safetyRatings": [

{"category": "Hate Speech", "severity": "NEGLIGIBLE", "severityScore": 0.0,"probabilityScore": 0.1},

{"category": "Dangerous Content", "severity": "LOW", "severityScore": 0.3, "probabilityScore": 0.1},

{"category": "Harassment", "severity": "MEDIUM", "severityScore": 0.6, "probabilityScore": 0.1},

{"category": "Sexually Explicit", "severity": "HIGH", "severityScore": 0.9, "probabilityScore": 0.1}

],

"blocked": false

},

"content": "<>"

}

]

}

Nota: Las categorías con una puntuación que se redondea a 0.0 se omiten en la respuesta. Esta respuesta de muestra es solo con fines ilustrativos.

Respuesta de ejemplo cuando está bloqueada

{

"predictions": [

{

"safetyAttributes": {

"blocked": true,

"errors": [

150,

152,

250

]

},

"content": ""

}

]

}

Descripciones de los atributos de seguridad

| Atributo de seguridad | Descripción |

|---|---|

| Contenido peyorativo | Comentarios negativos o dañinos que se orientan a la identidad o los atributos protegidos. |

| Tóxico | Contenido grosero, irrespetuoso u obsceno. |

| Contenido sexual | Incluye referencias a actos sexual o a otro contenido obsceno. |

| Violento | Describe situaciones que representen violencia contra una persona o un grupo, o descripciones generales de imágenes sangrientas. |

| Insultos | Comentarios insultantes, provocadores o negativos hacia una persona o un grupo de personas. |

| Lenguaje obsceno | Lenguaje obsceno o vulgar, como insultos. |

| Muerte, daños y tragedias | Muertes de personas, tragedias, accidentes, catástrofes y autolesiones. |

| Armas de fuego y de otros tipos | Contenido que menciona cuchillos, pistolas, armas personales y accesorios, como municiones, escasas, etcétera. |

| Seguridad pública | Servicios y organizaciones que proporcionan asistencia y garantizan la seguridad pública. |

| Salud | Salud humana, incluidos: problemas de salud, enfermedades y trastornos. terapias médicas, medicamentos, vacunación y prácticas médicas, recursos para sanar, incluidos los grupos de asistencia. |

| Religión y creencias | Sistemas de creencias que se enfrentan a la posibilidad de leyes y seres sobre naturales; religión, fe, creencia, práctica espiritual, islas y lugares de culto. Incluye la astrología y el ocultismo. |

| Drogas ilegales | Drogas ilegales y recreativas; parafernalia y cultivo de droga, headshops, etcétera. Incluye el uso medicinal de drogas que suelen consumirse con fines recreativos (p. ej., la marihuana). |

| Guerras y conflictos | Problemas de conflicto, conflictos militares y militares que involucran una gran cantidad de personas. Incluye discusión de servicios militares, incluso si no están directamente relacionados con una guerra o un conflicto. |

| Finanzas | Servicios financieros y para consumidores, como bancos, préstamos, crédito, inversiones, seguros, etcétera. |

| Política | Noticias y medios de comunicación políticas; debates sobre políticas sociales, gubernamentales y públicas. |

| Legal | Contenido relacionado con la ley, que incluye: corporaciones legales, información legal, materiales legales principales, servicios legales, publicaciones y tecnologías legales, testigos expertos, asesores de abogados y otros proveedores de servicios legales. |

Atributos de seguridad con calificaciones de seguridad

| Atributo de seguridad | Definición | Niveles |

|---|---|---|

| Incitación al odio o a la violencia | Comentarios negativos o dañinos que se orientan a la identidad o los atributos protegidos. | Alta, media, baja y despreciable |

| Acoso | Comentarios maliciosos, intimidantes, de bullying o abusivos dirigidos a otra persona. | Alta, media, baja y despreciable |

| Sexualmente explícito | Incluye referencias a actos sexual o a otro contenido obsceno. | Alta, media, baja y despreciable |

| Contenido peligroso | Promueve o habilita el acceso a bienes, servicios y actividades perjudiciales. | Alta, media, baja y despreciable |

Umbrales de seguridad

Se implementaron umbrales de seguridad para los siguientes atributos de seguridad:

- Incitación al odio o a la violencia

- Acoso

- Sexualmente explícito

- Contenido peligroso

Google bloquea las respuestas del modelo que superan las puntuaciones de gravedad designadas para estos atributos de seguridad. Para solicitar la capacidad de modificar un umbral de seguridad, comunícate con el equipo de tu Google Cloud cuenta.

Prueba tus umbrales de confianza y gravedad

Puedes probar los filtros de seguridad de Google y definir los umbrales de confianza adecuados para tu empresa. El uso de estos umbrales permite adoptar medidas exhaustivas para detectar contenidos que infrinjan las políticas de uso o las condiciones del servicio de Google y tomar las medidas adecuadas.

Las puntuaciones de confianza son solo predicciones y no debes depender de las puntuaciones para confiabilidad o precisión. Google no es responsable de interpretar ni usar estas puntuaciones para las decisiones empresariales.

Importante: Probabilidad y gravedad

A excepción de los cuatro atributos de seguridad con las calificaciones de seguridad, las puntuaciones de confianza de los filtros de seguridad de la API de PaLM se basan en la probabilidad de que el contenido sea inseguro y no en la gravedad. Es importante saber esto porque algunos contenidos pueden tener una baja probabilidad de ser inseguros, aunque la gravedad del daño pueda seguir siendo alta. Por ejemplo, comparemos las siguientes oraciones:

- El robot me golpeó.

- El robot me acuchilló.

La oración 1 podría tener una mayor probabilidad de ser insegura, pero podrías considerar que la oración 2 es de mayor gravedad en términos de violencia.

Ahora que entendemos esto, es importante que los clientes prueben y consideren con cuidado cuál es el nivel adecuado de bloqueo necesario para apoyar sus casos de uso clave, para así minimizar al mismo tiempo el daño a los usuarios finales.

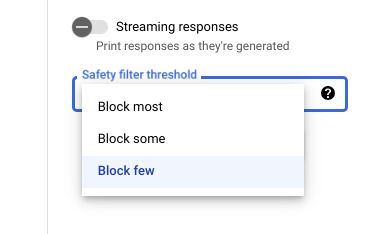

Configuración de seguridad en Vertex AI Studio

Con el umbral de filtro de seguridad ajustable, puedes ajustar las probabilidades de que veas respuestas que podrían ser perjudiciales. Las respuestas del modelo se bloquean según la probabilidad de que incluya acoso, incitación al odio o a la violencia, contenido peligroso o contenido sexual explícito. La configuración del filtro de seguridad se encuentra en la parte derecha del campo de instrucción en Vertex AI Studio. Puedes elegir entre tres opciones: block most, block some y block few.

Filtro de citas

Nuestras funciones de código generativo están destinadas a producir contenido original y no a replicar en detalle el contenido que ya esté disponible. Diseñamos nuestros sistemas para limitar las posibilidades de que esto suceda y mejorar continuamente el funcionamiento de estos sistemas. Si estas funciones toman citas textuales de una página web, citan dicha página.

En ocasiones, es posible que se encuentre el mismo contenido en varias páginas web. Si eso ocurre, intentaremos dirigirlo a una fuente popular. En el caso de citas a repositorios de código, la cita también puede hacer referencia a una licencia de código abierto aplicable. Es su responsabilidad satisfacer los requisitos de las licencias.

Para obtener información acerca de los metadatos del filtro de citas, consulta la referencia de la API de citas.

Errores de seguridad

Los códigos de error de seguridad son códigos de tres dígitos que representan el motivo por el que se bloqueó una instrucción o respuesta. El primer dígito es un prefijo que indica si el código se aplica a la instrucción o la respuesta, y los dígitos restantes identifican el motivo por el que se bloqueó la instrucción o la respuesta.

Por ejemplo, un código de error de 251 indica que la respuesta se bloqueó debido a un problema con contenido que incita al odio o a la violencia en la respuesta del modelo.

Se pueden mostrar varios códigos de error en una sola respuesta.

Si encuentras errores que bloquean el contenido en tu respuesta del modelo (prefijo = 2, por ejemplo, 250), ajusta la configuración temperature en tu solicitud. Esto ayuda a generar un conjunto diferente de respuestas con menos probabilidades de bloquearse.

Prefijo del código de error

El prefijo del código de error es el primer dígito del código de error.

| 1 | El código de error se aplica a la instrucción enviada al modelo. |

| 2 | El código de error se aplica a la respuesta del modelo. |

Motivo del código de error

El motivo del código de error corresponde al segundo y el tercer dígito del código de error.

Los motivos de los códigos de error que comienzan con 3 o 4 indican que las instrucciones o respuestas se bloquearon porque se alcanzó el umbral de confianza para un incumplimiento del atributo de seguridad.

Los motivos de los códigos de error que comienzan con 5 indican las instrucciones o las respuestas en las que se encontró contenido no seguro.

| 10 | Se bloqueó la respuesta debido a un problema de calidad o una configuración de parámetros que afectaba a los metadatos de las citas. Esto se aplica solo a las respuestas del modelo. Es decir, El verificador de citas identifica problemas de calidad o derivados de una configuración de parámetros. Intenta aumentar los parámetros Para obtener más información, consulta Filtro de cita. |

| 20 | El idioma proporcionado o mostrado es no compatible. Para obtener una lista de los idiomas admitidos, consulta Idiomas admitidos. |

| 30 | Se bloqueó la instrucción o la respuesta porque se descubrió que puede ser dañina. Se incluye un término de la lista de términos bloqueados. Reformula tu instrucción. |

| 31 | El contenido puede incluir información de identificación personal sensible (IIPS). Reformula tu instrucción. |

| 40 | Se bloqueó la instrucción o la respuesta porque se descubrió que puede ser dañina. El contenido infringe la configuración de SafeSearch. Reformula tu instrucción. |

| 50 | Se bloqueó la solicitud o respuesta porque puede incluir contenido sexual explícito. Reformula tu instrucción. |

| 51 | Se bloqueó la solicitud o la respuesta porque puede incluir contenido que incite al odio o a la violencia. Reformula tu instrucción. |

| 52 | Se bloqueó la instrucción o la respuesta porque puede incluir contenido de acoso. Reformula tu instrucción. |

| 53 | Se bloqueó la instrucción o la respuesta porque puede incluir contenido peligroso. Reformula tu instrucción. |

| 54 | Se bloqueó la instrucción o la respuesta porque puede incluir contenido tóxico. Reformula tu instrucción. |

| 00 | Motivo desconocido. Reformula tu instrucción. |

¿Qué sigue?

- Obtén más información sobre la IA responsable.

- Obtén información sobre la administración de datos.