Nesta página, descrevemos as etapas de solução de problemas que podem ser úteis se você tiver problemas ao usar o Vertex AI Workbench.

As etapas de solução de problemas de alguns componentes da Vertex AI são listadas separadamente. Confira a seguir:

Para filtrar o conteúdo desta página, clique em um tópico:

Modelos de AutoML

Nesta seção, descrevemos as etapas de solução de problemas que podem ser úteis se você tiver problemas com o AutoML.

Faltam rótulos no conjunto de teste, validação ou treinamento

Problema

Ao usar a divisão de dados padrão ao treinar um modelo de classificação do AutoML, a Vertex AI pode atribuir poucas instâncias de uma classe a um conjunto específico (teste, validação ou treinamento), o que causa um erro durante o treinamento. Esse problema ocorre com mais frequência quando você tem classes desequilibradas ou uma pequena quantidade de dados de treinamento.

Solução

Para resolver esse problema, adicione mais dados de treinamento, divida manualmente os dados para atribuir classes suficientes a cada conjunto ou remova os rótulos menos frequentes do conjunto de dados. Para mais informações, consulte Sobre divisões de dados para modelos do AutoML.

Vertex AI Studio

Ao trabalhar com o Vertex AI Studio, você pode receber os seguintes erros:

A tentativa de ajustar um modelo retorna Internal error encountered.

Problema

Você vai encontrar um erro Internal error encountered ao tentar ajustar um modelo.

Solução

Execute o comando cURL a seguir para criar um conjunto de dados vazio da Vertex AI. Verifique se você configurou o ID do projeto no comando.

PROJECT_ID=PROJECT_ID

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://europe-west4-aiplatform.googleapis.com/ui/projects/$PROJECT_ID/locations/europe-west4/datasets \

-d '{

"display_name": "test-name1",

"metadata_schema_uri": "gs://google-cloud-aiplatform/schema/dataset/metadata/image_1.0.0.yaml",

"saved_queries": [{"display_name": "saved_query_name", "problem_type": "IMAGE_CLASSIFICATION_MULTI_LABEL"}]

}'

Após a conclusão do comando, aguarde cinco minutos e tente ajustar o modelo novamente.

Código do erro: 429

Problema

Você vai encontrar o seguinte erro:

429: The online prediction request quota is exceeded for PUBLIC_BASE_MODEL_NAME.

Solução

Tente novamente mais tarde com espera. Se ainda houver erros, entre em contato com a Vertex AI.

Código do erro: 410

Problema

Você vai encontrar o seguinte erro:

410: The request is missing the required authentication credential. Expected OAuth 2.0 access token, login cookie, or other valid authentication credential.

Solução

Consulte a Visão geral da autenticação para saber mais.

Código do erro: 403

Problema

Você vai encontrar o seguinte erro:

403: Permission denied.

Solução

Verifique se a conta que acessa a API tem as permissões corretas.

Vertex AI Pipelines

Nesta seção, descrevemos etapas de solução de problemas que podem ser úteis se você tiver problemas com o Vertex AI Pipelines.

Você não tem permissão para atuar como conta de serviço

Problema

Ao executar o fluxo de trabalho do Vertex AI Pipelines, talvez você encontre a seguinte mensagem de erro:

You do not have permission to act as service account: SERVICE_ACCOUNT. (or it may not exist).

Solução

Esse erro significa que a conta de serviço que executa o fluxo de trabalho não tem acesso aos recursos necessários.

Para resolver esse problema, tente uma das seguintes opções:

- Adicione o papel

Vertex AI Service Agentà conta de serviço: - Conceda ao usuário a permissão

iam.serviceAccounts.actAsna conta de serviço.

Error Internal error happened

Problema

Se o pipeline falhar com uma mensagem Internal error happened, verifique a Análise de registros e pesquise o nome do pipeline. Você receberá este erro:

java.lang.IllegalStateException: Failed to validate vpc network projects/PROJECT_ID/global/networks/VPC_NETWORK.APPLICATION_ERROR;google.cloud.servicenetworking.v1/ServicePeeringManagerV1.GetConsumerConfig;Reserved range: 'RANGE_NAME' not found for consumer project: 'PROJECT_ID' network: 'VPC_NETWORK'. com.google.api.tenant.error.TenantManagerException: Reserved range: 'RANGE_NAME' not found for consumer project

Isso significa que o peering de VPC para Vertex AI inclui um intervalo de IP que foi excluído.

Solução

Para resolver esse problema, atualize o peering de VPC usando o comando update e inclua intervalos de IP válidos.

O escopo do OAuth ou o público-alvo do token de ID é inválido

Problema

Ao executar o fluxo de trabalho do Vertex AI Pipelines, você encontra a mensagem de erro a seguir:

google.auth.exceptions.RefreshError: ('invalid_scope: Invalid OAuth scope

or ID token audience provided.', {'error': 'invalid_scope',

'error_description': 'Invalid OAuth scope or ID token audience provided.'})

Solução

Isso significa que você não forneceu credenciais em um dos componentes do pipeline

ou não usou ai_platform.init() para definir credenciais.

Para resolver esse problema, defina as credenciais do componente de pipeline

relevante ou defina as credenciais do ambiente e use ai_platform.init()

no início do código.

os.environ['GOOGLE_APPLICATION_CREDENTIALS'] = PATH_TO_JSON_KEY

Os componentes do Vertex AI Pipelines exigem mais espaço em disco do que 100 GB

Problema

O espaço em disco padrão alocado para componentes do Vertex AI Pipelines é de 100 GB, e não é possível aumentar o espaço em disco. Consulte o Issue Tracker público para saber mais sobre esse problema.

Solução

Para que um componente use mais de 100 GB de espaço em disco, converta-o em um job personalizado usando o método components. Com esse operador, é possível atribuir o tipo de máquina e o tamanho do disco que o componente usa.

Para conferir um exemplo de como usar esse operador, consulte Vertex AI Pipelines: treinamento personalizado com componentes pré-criados do pipeline do Google Cloud, na seção Converter o componente em um Seção "Job personalizado da Vertex AI".

Problemas de rede da Vertex AI

Esta seção descreve etapas de solução de problemas que podem ser úteis se você tiver problemas com redes na Vertex AI.

O pipeline ou o job não pode acessar endpoints na rede VPC com peering

Problema

O pipeline da Vertex AI expira quando tenta se conectar a recursos na rede VPC.

Solução

Para resolver o problema, faça o seguinte:

- Verifique se você concluiu todas as etapas em Configurar o peering de rede VPC.

Revise a configuração da sua rede VPC com peering. Verifique se a rede importa rotas do intervalo de rede de serviço correto enquanto o job está em execução.

Verifique se você tem uma regra de firewall que permite conexões desse intervalo com o destino na sua rede.

Se a conexão de peering não importar nenhuma rota enquanto o job estiver em execução, isso significa que a configuração de rede de serviço não está sendo usada. Isso ocorre provavelmente porque você concluiu a configuração de peering com uma rede diferente da rede padrão. Se esse for o caso, especifique sua rede ao iniciar um job. Use o nome de rede totalmente qualificado no seguinte formato:

projects/$PROJECT_ID/global/networks/$NETWORK_NAME.Para mais informações, consulte Visão geral de rotas.

O pipeline ou o job não pode acessar para alcançar endpoints em outras redes além da sua rede

Problema

O pipeline ou o job não consegue acessar endpoints em redes fora da rede.

Solução

Por padrão, sua configuração de peering exporta apenas rotas para as sub-redes locais na VPC.

Além disso, o peering transitivo não é aceito e apenas redes com peering direto podem se comunicar.

- Para permitir que a Vertex AI se conecte pela

sua rede e alcance endpoints em outras redes, exporte as rotas

de rede para a conexão de peering. Edite a configuração da rede VPC com peering e ative

Export custom routes.

Como o peering transitivo não é compatível, a Vertex AI não aprende rotas para outras redes e serviços com peering, mesmo com Export Custom Routes ativado. Para informações sobre soluções alternativas, consulte

Como ampliar a acessibilidade da rede do Vertex AI Pipelines.

No route to host sem conflitos de rota evidentes no console do Google Cloud

Problema

As únicas rotas que podem ser vistas no console do Google Cloud são aquelas conhecidas pela sua própria VPC, bem como os intervalos reservados quando você conclui a configuração de Peering de rede VPC.

Em raras ocasiões, um job da Vertex AI pode gerar uma reclamação no route to host

ao tentar acessar um endereço IP que sua VPC está exportando para a rede

da Vertex AI.

Isso pode ter acontecido porque os jobs da Vertex AI são executados em um namespace de rede em um cluster do GKE gerenciado com um intervalo de IP em conflito com o IP de destino. Consulte Princípios básicos de rede do GKE para mais detalhes.

Nessas condições, a carga de trabalho tenta se conectar ao IP no próprio namespace de rede e gera um erro se não conseguir alcançá-lo.

Solução

Crie a carga de trabalho para retornar os endereços IP de namespace local dela e confirme se não há conflito com as rotas que você está exportando pela conexão de peering.

Se houver um conflito, transmita uma lista de reservedIpRanges[]

nos parâmetros do job que não se sobreponham a nenhum intervalo na rede VPC.

O job usa esses intervalos para os endereços IP internos da carga de trabalho.

RANGES_EXHAUSTED, RANGES_NOT_RESERVED

Problema

Os erros na forma RANGES_EXHAUSTED e RANGES_NOT_RESERVED e RANGES_DELETED_LATER indicam um problema com a configuração de peering da rede VPC subjacente. Esses são erros de rede,

não do serviço da Vertex AI.

Solução

Para mais informações, consulte Erros de validação da infraestrutura de serviços.

Se o erro continuar, entre em contato com a equipe de suporte.

Router status is temporarily unavailable

Problema

Ao iniciar o Vertex AI Pipelines, você recebe uma mensagem de erro semelhante a esta:

Router status is temporarily unavailable. Please try again later

Solução

A mensagem de erro indica que essa é uma condição temporária. Tente iniciar o Vertex AI Pipelines novamente.

Se o erro continuar, entre em contato com a equipe de suporte.

Previsão do Vertex AI

Nesta seção, descrevemos etapas de solução de problemas que podem ser úteis se você tiver problemas com a previsão da Vertex AI.

Erro de novas tentativas excedido

Problema

Ao executar jobs de previsão em lote, você recebe um erro como o seguinte indicando que a máquina que executa o modelo personalizado pode não ser capaz de concluir as previsões dentro do limite de tempo.

('Post request fails. Cannot get predictions. Error: Exceeded retries: Non-OK

result 504 (upstream request timeout) from server, retry=3, elapsed=600.04s.', 16)

Isso pode acontecer quando o serviço de previsão da Vertex AI se registra no serviço do Google Front End, que encaminha as conexões do cliente para a API Prediction da Vertex AI.

O serviço do Google Front End expira a conexão e retorna um código de resposta HTTP 500 ao cliente se não receber uma resposta da API em 10 minutos.

Solução

Para resolver esse problema, tente uma das seguintes opções:

- Aumente os nós de computação ou mude o tipo de máquina.

- Crie o contêiner de previsão para enviar códigos de resposta HTTP 102 periódicos. Isso reinicia o timer de 10 minutos no serviço do Google Front End.

O projeto já está vinculado à VPC

Problema

Ao implantar um endpoint, talvez você veja uma mensagem de erro como a seguinte, que indica que os endpoints da Vertex AI já usaram uma rede de nuvem privada virtual e os recursos não foram limpados adequadamente.

Currently only one VPC network per user project is supported. Your project is

already linked to "projects/YOUR_SHARED_VPC_HOST_PROJECT/global/networks/YOUR_SHARED_VPC_NETWORK".

To change the VPC network, please undeploy all Vertex AI deployment resources,

delete all endpoint resources, and then retry creating resources in 30 mins.

Solução

Para resolver esse problema, tente executar este comando no Cloud Shell.

gcloud services vpc-peerings delete \

--service=servicenetworking.googleapis.com \

--network=YOUR_SHARED_VPC_NETWORK \

--project=YOUR_SHARED_VPC_HOST_PROJECT

Isso desconecta manualmente sua rede VPC antiga da VPC do Service Networking.

Problemas com a conta de serviço personalizada da Vertex AI

Esta seção descreve etapas de solução de problemas que podem ser úteis se você tiver problemas com contas de serviço.

A implantação do modelo falha com a conta de serviço serviceAccountAdmin erro

Problema

A implantação do modelo falha com um erro como este:

Failed to deploy model MODEL_NAME to

endpoint ENDPOINT_NAME due to the error: Failed to add IAM policy binding.

Please grant SERVICE_ACC_NAME@gcp-sa-aiplatform.iam.gserviceaccount.com the

iam.serviceAccountAdmin role on service account

vertex-prediction-role@PROJECT_INFO.iam.gserviceaccount.com

Solução

Esse erro significa que sua conta de serviço personalizada pode não ter sido configurada corretamente. Para criar uma conta de serviço personalizada com as permissões de IAM corretas, consulte Usar uma conta de serviço personalizada.

Não foi possível buscar o token de identidade ao usar a conta de serviço personalizada

Problema

Ao usar uma conta de serviço personalizada, os jobs de treinamento executados em uma única réplica não conseguem alcançar o serviço de metadados do Compute Engine necessário para recuperar um token.

Você verá um erro semelhante a este:

Failed to refresh jwt, retry number 0: ("Failed to retrieve http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/identity?audience=...&format=full

from the Google Compute Engine Metadata service. Status: 404 Response:

\nb'Not Found\n'", <google.auth.transport.requests._Response object at

0x7fb19f058c50>)

Solução

Para buscar o token de identidade com uma conta de serviço personalizada, use iamcredentials.googleapis.com.

Modelos treinados e personalizados

Nesta seção, descrevemos as etapas de solução de problemas que podem ser úteis se você tiver problemas com modelos treinados de maneira personalizada.

Problemas de treinamento personalizados

Os problemas a seguir podem ocorrer durante o treinamento personalizado. Os problemas se aplicam a recursos CustomJob e HyperparameterTuningJob, incluindo aqueles criados por recursos TrainingPipeline.

Código do erro: 400

Problema

Você vai encontrar o seguinte erro:

400 Machine type MACHINE_TYPE is not supported.

Essa mensagem de erro pode aparecer se o tipo de máquina selecionado não for compatível com o treinamento da Vertex AI ou se um recurso específico não estiver disponível na região selecionada.

Solução

Use apenas os tipos de máquina disponíveis nas regiões adequadas.

A réplica saiu com um código de status diferente de zero

Problema

Durante o treinamento distribuído, um erro de qualquer worker provoca falha no treinamento.

Solução

Para verificar o rastreamento de pilha do worker, visualize os registros de treinamento personalizados no Console do Google Cloud.

Veja os outros tópicos para solucionar problemas comuns e crie um novo recurso CustomJob, HyperparameterTuningJob ou TrainingPipeline. Em muitos

casos, os códigos de erro são causados por problemas no código de treinamento, não pelo

serviço da Vertex AI. Para determinar se esse é o caso, execute o código de treinamento na máquina local ou no Compute Engine.

A réplica está sem memória

Problema

Pode ocorrer um erro se uma instância de máquina virtual (VM) de treinamento ficar sem memória durante o treinamento.

Solução

Veja o uso de memória das suas VMs de treinamento no Console do Cloud.

Mesmo quando você receber esse erro, talvez não veja 100% do uso da memória na VM, porque os serviços além do aplicativo de treinamento em execução na VM também consomem recursos. Para tipos de máquinas com menos memória, outros serviços podem consumir uma porcentagem relativamente grande de memória.

Por exemplo, em uma VM n1-standard-4, os serviços podem consumir até 40% da memória.

Otimize o consumo de memória do aplicativo de treinamento ou escolha um tipo de máquina maior com mais memória.

Recursos insuficientes em uma região

Problema

Você encontrou um problema de estoque esgotado em uma região.

Solução

A Vertex AI treina seus modelos usando recursos do Compute Engine. A Vertex AI não poderá programar sua carga de trabalho se o Compute Engine estiver na capacidade de uma determinada CPU ou GPU em uma região. Esse problema não está relacionado à sua cota do projeto.

Ao alcançar o limite do Compute Engine, a Vertex AI

repete o CustomJob ou o HyperparameterTuningJob automaticamente até três vezes. O job falhará caso todas as novas tentativas falhem.

Uma descargas geralmente ocorre quando você usa GPUs. Se você encontrar esse erro ao usar GPUs, tente mudar para um tipo de GPU diferente. Se for possível usar outra região, faça o treinamento em uma região diferente.

Erro de permissão ao acessar outro serviço do Google Cloud

Se você encontrar um erro de permissão ao acessar outro serviço do Google Cloud

pelo código de treinamento (por exemplo,

google.api_core.exceptions.PermissionDenied: 403), talvez haja um dos

seguintes problemas:

-

Problema

O agente de serviço ou a conta de serviço que executa o código (o agente de serviço de código personalizado do Vertex AI do projeto ou uma conta de serviço personalizada) não tem a permissão necessária.

Solução

Saiba como conceder permissões ao agente de serviço de código personalizado do Vertex AI ou configurar uma conta de serviço personalizada com as permissões necessárias.

-

Problema

O agente ou conta de serviço que executa o código tem a permissão necessária, mas o código está tentando acessar um recurso no projeto errado. É provável que esse seja o problema se a mensagem de erro referenciar um ID de projeto que termine com

-tp.Solução

Devido à maneira como o Vertex AI executa o código de treinamento, esse problema pode ocorrer inadvertidamente se você não especificar explicitamente um ID ou número de projeto no código.

Saiba como corrigir esse problema especificando um ID ou número de projeto.

Erro interno

Problema

O treinamento falhou devido a um erro no sistema.

Solução

O problema pode ser temporário; tente reenviar CustomJob, HyperparameterTuningJob ou TrainingPipeline. Se o erro persistir, entre em contato com a equipe de suporte.

Código de erro 500 ao usar uma imagem de contêiner do cliente

Problema

Você vê um erro 500 nos registros.

Solução

Esse tipo de erro provavelmente é um problema com a imagem do contêiner personalizado e não um erro da Vertex AI.

A conta de serviço não pode acessar o bucket do Cloud Storage ao implantar em um endpoint

Problema

Quando você tenta implantar um modelo em um endpoint e sua conta de serviço

não tem acesso

storage.objects.list

ao bucket do Cloud Storage relacionado,

você poderá encontrar o seguinte erro:

custom-online-prediction@TENANT_PROJECT_ID.iam.gserviceaccount.com

does not have storage.objects.list access to the Cloud Storage bucket.

Por padrão, o contêiner personalizado que implanta seu modelo usa uma conta de serviço que não tem acesso ao seu bucket do Cloud Storage.

Solução

Para resolver isso, tente uma das seguintes opções:

Copie o arquivo que você está tentando acessar do contêiner em artefatos do modelo ao fazer upload do modelo. A Vertex AI vai copiá-la para um local a que a conta de serviço padrão tenha acesso, semelhante a todos os outros artefatos de modelo.

Copie o arquivo no contêiner como parte do processo de criação dele.

Especifique uma conta de serviço personalizada.

Pesquisa de arquitetura neural

Problemas conhecidos

- Depois de cancelar o job NAS, o job principal (o pai) é interrompido, mas alguns testes filhos continuam mostrando um estado Running. Ignore o estado do teste filho que mostra Em execução nesse caso. Os testes foram interrompidos, mas a interface continua mostrando o estado Running. Enquanto o job principal tiver parado, você não vai receber cobranças extras.

- Depois de relatar os prêmios no treinador, aguarde (em suspensão) por 10 minutos antes dos jobs de teste serem encerrados.

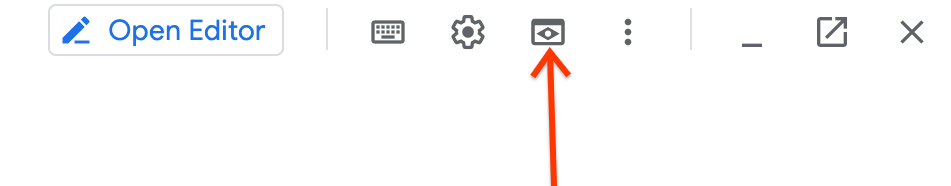

Ao usar o Cloud Shell para executar

TensorBoard, o link de saída gerado pode não funcionar. Nesse caso, anote o número da porta, use a ferramenta Visualização da Web e selecione o número da porta correto para exibir os gráficos.Como acessar a ferramenta

Web Preview:

Se você vir mensagens de erro como as apresentadas a seguir nos registros do Trainer:

gcsfuse errors: fuse: writeMessage: no such file or directory [16 0 0 0 218 255 255 255 242 25 111 1 0 0 0 0]Use um computador com mais RAM, porque uma condição OOM está causando esse erro.

Se o treinador personalizado não conseguir encontrar a FLAG

job-dirdo diretório de jobs, importejob_dircom um sublinhado em vez de um hífen. Uma observação no tutorial-1 explica isso.Erro de NAN durante o treinamento Pode haver erros de NaN no job de treinamento, como

NaN : Tensor had NaN values. A taxa de aprendizado pode ser grande demais para a arquitetura sugerida. Para ver mais informações, consulte Erros relacionados a falta de memória (OOM) e taxa de aprendizado.Erro de falta de memória durante o treinamento Pode haver erros de falta de memória (OOM, na sigla em inglês) no job de treinamento. O tamanho do lote pode ser muito grande para a memória do acelerador. Para ver mais informações, consulte Erros relacionados a falta de memória (OOM) e taxa de aprendizado.

Dados do job do controlador de seleção de modelos de tarefa de proxy No caso raro de o job do controlador de seleção de modelo de tarefa de proxy ser encerrado, retome o job seguindo estas etapas.

Dados do job do controlador de pesquisa de tarefa de proxy No caso raro de o job do controlador de pesquisa de tarefa de proxy ser encerrado, você pode retomar o job seguindo estas etapas. ,

A conta de serviço não tem permissão para acessar o Artifact Registry ou o bucket. Se você receber um erro como

Vertex AI Service Agent service-123456789@gcp-sa-aiplatform-cc.iam.gserviceaccount.com does not have permission to access Artifact Registry repository projects/my-project/locations/my-region/repositories/nasou um erro semelhante para acesso ao bucket, atribua a essa conta de serviço um papel de editor de armazenamento no projeto.

Vertex AI Feature Store

Esta seção descreve etapas de solução de problemas que podem ser úteis se você tiver dificuldades com o Vertex AI Feature Store.

Erro Resource not found ao enviar uma solicitação de ingestão de streaming ou de exibição on-line

Problema

Depois de configurar um featurestore, um tipo de entidade ou um recurso de recurso, há um

atraso até que esses recursos sejam propagados para o

serviço FeaturestoreOnlineServingService. Às vezes, essa propagação atrasada

pode causar um erro resource not found quando você envia uma ingestão de streaming

ou solicitação de exibição on-line imediatamente após criar um recurso.

Solução

Se você receber esse erro, aguarde alguns minutos e tente sua solicitação novamente.

Processamento em lote bem-sucedido para recursos recém-criados, mas a solicitação de exibição on-line retorna valores vazios

Problema

Somente para recursos recém-criados, há um atraso até que esses recursos sejam

propagados para o serviço FeaturestoreOnlineServingService. Os recursos e os valores

existem, mas levam algum tempo para serem propagados. Isso pode fazer com que sua solicitação de disponibilização on-line retorne valores vazios.

Solução

Se você encontrar essa inconsistência, aguarde alguns minutos e tente sua solicitação de exibição on-line novamente.

O uso da CPU é alto para um nó de exibição on-line

Problema

O uso da CPU para um nó de exibição on-line é alto.

Solução

Para atenuar esse problema, aumente o número de nós de veiculação on-line aumentando manualmente a contagem de nós ou ativando o escalonamento automático. Mesmo que o escalonamento automático esteja ativado, o Vertex AI Feature Store precisa de tempo para reequilibrar os dados quando os nós são adicionados ou removidos. Para informações sobre como visualizar métricas de distribuição do valor do atributo ao longo do tempo, consulte Ver métricas do valor do atributo.

O uso da CPU é alto para o melhor nó de exibição on-line

Problema

Se a utilização da CPU for alta para o nó mais quente, aumente o número de nós de exibição ou altere o padrão de acesso da entidade para pseudoaleatório.

Solução

Definir o padrão de acesso à entidade como pseudoaleatório diminui a alta utilização da CPU resultante do acesso frequente de entidades localizadas próximas umas das outras no featurestore. Se nenhuma solução for eficaz, implemente um cache do lado do cliente para evitar acessar as mesmas entidades repetidamente.

A latência da exibição on-line é alta quando o QPS é baixo

Problema

O período de inatividade ou baixa atividade com QPS baixa pode resultar na expiração de alguns caches do lado do servidor. Isso pode resultar em alta latência quando o tráfego para nós de exibição on-line for retomado com QPS regular ou maior.

Solução

Para atenuar esse problema, você precisa manter a conexão ativa enviando tráfego artificial de pelo menos 5 QPS para o featurestore.

O job de ingestão em lote falha após seis horas

Problema

O job de ingestão em lote pode falhar porque a sessão de leitura expira após seis horas.

Solução

Para evitar o tempo limite, aumente o número de workers para concluir o job de ingestão dentro do limite de seis horas.

Erro Resource exceeded ao exportar valores de atributos

Problema

A exportação de um grande volume de dados pode falhar com um erro de recurso excedido se o job de exportação exceder a cota interna.

Solução

Para evitar esse erro, configure os parâmetros de intervalo de tempo, start_time

e end_time, para processar quantidades menores de dados por vez. Consulte Exportação completa para mais informações.

Vertex AI Vizier

Ao usar o Vertex AI Vizier, é possível ter os problemas a seguir.

Erro interno

Problema

O erro interno ocorre quando há um erro do sistema.

Solução

Pode ser transitório. Tente reenviar a solicitação e, se o erro persistir, entre em contato com o suporte.