In Anthos Service Mesh 1.5 und höher ist die automatische gegenseitige TLS-Authentifizierung (automatisches mTLS) standardmäßig aktiviert. Bei automatischem mTLS erkennt ein Client-Sidecar-Proxy automatisch, ob der Server einen Sidecar hat. Der Client-Sidecar-Proxy sendet an Arbeitslasten mit Sidecars mTLS und an Arbeitslasten ohne Sidecars Klartext-Traffic. Dienste akzeptieren dagegen sowohl Klartext- als auch mTLS-Traffic. Wenn Sie Sidecar-Proxys in Ihre Pods einfügen, empfehlen wir Ihnen, Ihre Dienste auch so zu konfigurieren, dass nur mTLS-Traffic akzeptiert wird.

Mit Anthos Service Mesh können Sie mTLS außerhalb Ihres Anwendungscodes durch Anwenden einer einzelnen YAML-Datei erzwingen. Anthos Service Mesh bietet Ihnen die Flexibilität, eine Authentifizierungsrichtlinie auf das gesamte Service Mesh, auf einen Namespace oder auf eine einzelne Arbeitslast anzuwenden.

Kosten

In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Nach Abschluss dieser Anleitung können Sie weitere Kosten durch Löschen von erstellten Ressourcen vermeiden. Weitere Informationen finden Sie unter Bereinigen.

Hinweise

Die Abrechnung für das Cloud-Projekt muss aktiviert sein. So prüfen Sie, ob die Abrechnung für Ihr Projekt aktiviert ist.

Installieren Sie Anthos Service Mesh auf einem GKE-Cluster und stellen Sie ein Gateway für eingehenden Traffic bereit. Wenn Sie für diese Anleitung einen Cluster einrichten müssen, finden Sie in der Anthos Service Mesh-Kurzanleitung folgende Schritte:

- GKE-Cluster erstellen

- Stellt verwaltetes Anthos Service Mesh bereit.

- Ingress-Gateway bereitstellen.

- Bereitstellung der Beispielanwendung Online Boutique aus dem Repository

anthos-service-mesh-packages, die gegenüber dem ursprünglichen Satz von Manifesten inmicroservices-demo-Repository verändert wurde Gemäß den Best Practices wird jeder Dienst in einem separaten Namespace mit einem eigenen Dienstkonto bereitgestellt.

Auf Online Boutique zugreifen

Legen Sie den aktuellen Kontext für

kubectlauf dem Cluster fest, in dem Sie Online Boutique bereitgestellt haben:gcloud container clusters get-credentials CLUSTER_NAME \ --project=PROJECT_ID \ --zone=CLUSTER_LOCATIONListen Sie die Dienste im Namespace

frontendauf:kubectl get services -n frontendBeachten Sie, dass

frontend-externaleinLoadBalancerist und eine externe IP-Adresse hat. Die Beispielanwendung enthält einen Dienst, der ein Load-Balancer ist, sodass er in GKE ohne Anthos Service Mesh bereitgestellt werden kann.Rufen Sie die Anwendung in Ihrem Browser mit der externen IP-Adresse des Dienstes

frontend-externalauf:http://FRONTEND_EXTERNAL_IP/Anthos Service Mesh bietet Ihnen die Möglichkeit, ein Ingress-Gateway bereitzustellen. Sie können auf die Online-Boutique auch mit der externen IP-Adresse des Ingress-Gateways zugreifen. Rufen Sie die externe IP-Adresse der Anwendung ab: Ersetzen Sie die Platzhalter durch folgende Informationen:

- GATEWAY_SERVICE_NAME ist der Name des Ingress-Gateway-Dienstes. Wenn Sie das Beispielgateway ohne Änderung bereitgestellt oder das Standardgateway für eingehenden Traffic bereitgestellt haben, lautet der Name

istio-ingressgateway. - GATEWAY_NAMESPACE ist der Namespace, in dem Sie das Ingress-Gateway bereitgestellt haben. Wenn Sie das Standard-Gateway für eingehenden Traffic bereitgestellt haben, lautet der Namespace

istio-system.

kubectl get service GATEWAY_NAME -n GATEWAY_NAMESPACE- GATEWAY_SERVICE_NAME ist der Name des Ingress-Gateway-Dienstes. Wenn Sie das Beispielgateway ohne Änderung bereitgestellt oder das Standardgateway für eingehenden Traffic bereitgestellt haben, lautet der Name

Öffnen Sie einen weiteren Tab in Ihrem Browser und rufen Sie die Anwendung mithilfe der externen IP-Adresse des Ingress-Gateways auf:

http://INGRESS_GATEWAY_EXTERNAL_IP/Führen Sie den folgenden Befehl aus, um

curlfür denfrontend-Dienst mit reinem HTTP aus einem anderen Pod durchzuführen. Da sich die Dienste in verschiedenen Namespaces befinden, müssen Sie „curl“ für den DNS-Namen des Dienstesfrontenddurchführen.kubectl exec \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -c istio-proxy -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Ihre Anfrage ist mit dem Status

200erfolgreich, da standardmäßig sowohl TLS- als auch Klartext-Traffic akzeptiert wird.

Gegenseitiges TLS pro Namespace aktivieren

Für mTLS wenden Sie eine PeerAuthentication-Richtlinie mit kubectl an.

Speichern Sie die folgende Authentifizierungsrichtlinie als

mtls-namespace.yaml.cat <<EOF > mtls-namespace.yaml apiVersion: "security.istio.io/v1beta1" kind: "PeerAuthentication" metadata: name: "namespace-policy" spec: mtls: mode: STRICT EOFDie Zeile

mode: STRICTin der YAML-Datei konfiguriert die Dienste so, dass sie nur mTLS akzeptieren.modeist standardmäßig aufPERMISSIVEgesetzt. Damit werden Dienste so konfiguriert, dass sie sowohl Klartext als auch mTLS akzeptieren.Wenden Sie die Authentifizierungsrichtlinie an, um alle Online Boutique-Dienste so zu konfigurieren, dass sie nur mTLS akzeptieren:

for ns in ad cart checkout currency email frontend loadgenerator \ payment product-catalog recommendation shipping; do kubectl apply -n $ns -f mtls-namespace.yaml doneErwartete Ausgabe:

peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created

Öffnen Sie in Ihrem Browser den Tab, der über die externe IP-Adresse des Dienstes

frontend-externalauf die Online-Boutique zugreift:http://FRONTEND_EXTERNAL_IP/Aktualisieren Sie die Seite. Der Browser zeigt den folgenden Fehler an:

Durch das Aktualisieren der Seite wird Klartext an den

frontend-Dienst gesendet. Aufgrund derSTRICT-Authentifizierungsrichtlinie blockiert der Sidecar-Proxy die Anfrage an den Dienst.Wechseln Sie in Ihrem Browser zu dem Tab, der über die externe IP-Adresse des

istio-ingressgatewayauf die Online Boutique zugreift, und aktualisieren Sie die Seite, die erfolgreich angezeigt wird. Wenn Sie über das Ingress-Gateway auf die Online Boutique zugreifen, verwendet die Anfrage den folgenden Pfad:mTLS-Authentifizierungsablauf:

- Der Browser sendet eine Klartext-HTTP-Anfrage an den Server.

- Der Ingress-Gateway-Proxy-Container fängt die Anfrage ab.

- Der Ingress-Gateway-Proxy führt einen TLS-Handshake mit dem serverseitigen Proxy aus (in diesem Beispiel den Frontend-Dienst). Dieser Handshake umfasst einen Austausch von Zertifikaten. Diese Zertifikate werden von Anthos Service Mesh vorab in die Proxy-Container geladen.

- Der Ingress-Gateway-Proxy führt eine sichere Namensprüfung für das Serverzertifikat durch und bestätigt so, dass der Server über eine autorisierte Identität ausgeführt wird.

- Die Ingress-Gateway- und Serverproxys stellen eine gegenseitige TLS-Verbindung her und der Serverproxy leitet die Anfrage an den Server des Anwendungscontainers (den Frontend-Dienst) weiter.

Führen Sie den folgenden Befehl aus, um

curlfür denfrontend-Dienst mit reinem HTTP aus einem anderen Pod durchzuführen.kubectl exec \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -c istio-proxy -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Ihre Anfrage schlägt fehl, da alle Online-Boutique-Dienste auf mTLS

STRICTgesetzt sind und der Sidecar-Proxy die Anfrage an den Dienst blockiert.Erwartete Ausgabe:

000 command terminated with exit code 56

mTLS-Status aufrufen

Sie können den Status von Anthos-Sicherheitsfeatures, einschließlich Authentifizierungsrichtlinien, in der Google Cloud Console ansehen.

Rufen Sie in der Google Cloud Console die Seite GKE Enterprise-Sicherheit auf.

Wählen Sie das Google Cloud-Projekt aus der Drop-down-Liste in der Menüleiste aus.

Die Richtlinienzusammenfassung zeigt den Status der Anwendungssicherheit einschließlich mTLS an.

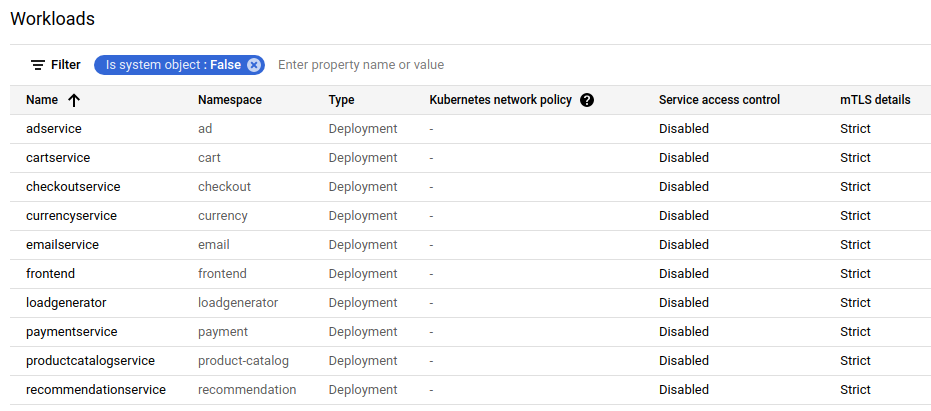

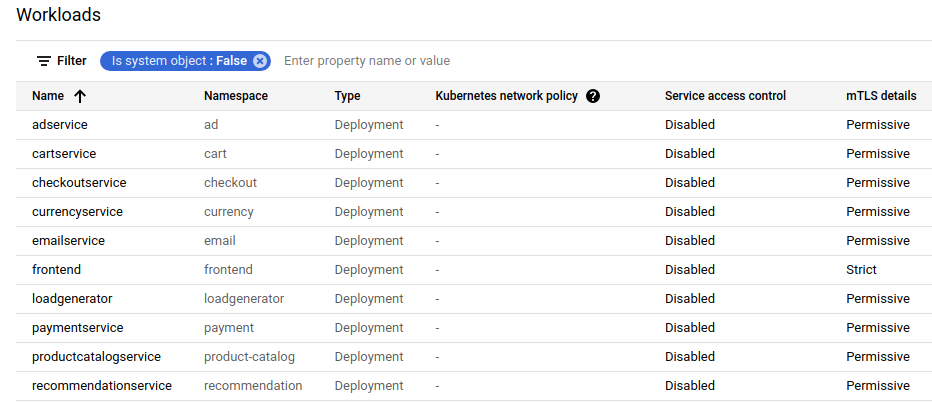

Klicken Sie auf Richtlinienprüfung, um den Status der Arbeitslastrichtlinien für jeden Cluster und Namespace aufzurufen. Einen Überblick finden Sie auf der Karte mTLS-Status. Die Liste Arbeitslasten enthält den mTLS-Status der einzelnen Arbeitslasten.

Authentifizierungsrichtlinien suchen und löschen

Eine Liste aller

PeerAuthentication-Richtlinien im Service Mesh:kubectl get peerauthentication --all-namespacesDie Ausgabe sieht in etwa so aus:

NAMESPACE NAME MODE AGE ad namespace-policy STRICT 17m cart namespace-policy STRICT 17m checkout namespace-policy STRICT 17m currency namespace-policy STRICT 17m email namespace-policy STRICT 17m frontend namespace-policy STRICT 17m loadgenerator namespace-policy STRICT 17m payment namespace-policy STRICT 17m product-catalog namespace-policy STRICT 17m recommendation namespace-policy STRICT 17m shipping namespace-policy STRICT 17mLöschen Sie die Authentifizierungsrichtlinie aus allen Namespaces für Online Boutique:

for ns in ad cart checkout currency email frontend loadgenerator payment \ product-catalog recommendation shipping; do kubectl delete peerauthentication -n $ns namespace-policy done;Erwartete Ausgabe:

peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deletedGreifen Sie über die externe IP-Adresse des Dienstes

frontend-externalauf die Online Boutique zu und aktualisieren Sie die Seite. Die Seite wird wie erwartet angezeigt.Führen Sie den folgenden Befehl aus, um

curlfür denfrontend-Dienst mit reinem HTTP aus einem anderen Pod durchzuführen.kubectl exec \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -c istio-proxy -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Ihre Anfrage ist mit dem Status

200erfolgreich, da standardmäßig sowohl TLS- als auch Klartext-Traffic akzeptiert wird.

Wenn Sie die Seite in der Google Cloud Console aktualisieren, auf der die Liste Arbeitslasten angezeigt wird, lautet der mTLS-Status jetzt Permissive.

Gegenseitiges TLS pro Arbeitslast aktivieren

Zum Festlegen einer PeerAuthentication-Richtlinie für eine bestimmte Arbeitslast müssen Sie den Abschnitt selector konfigurieren und die Labels angeben, die der gewünschten Arbeitslast entsprechen.

Anthos Service Mesh kann jedoch keine Richtlinien für Arbeitslast für ausgehenden mTLS-Traffic zu einem Dienst zusammenfassen. Sie müssen eine Zielregel konfigurieren, um dieses Verhalten zu verwalten.

Wenden Sie eine Authentifizierungsrichtlinie auf eine bestimmte Arbeitslast an. Beachten Sie, wie die folgende Richtlinie Labels und Selektoren verwendet, um die jeweilige

frontend-Bereitstellung anzusteuern.cat <<EOF | kubectl apply -n frontend -f - apiVersion: "security.istio.io/v1beta1" kind: "PeerAuthentication" metadata: name: "frontend" namespace: "frontend" spec: selector: matchLabels: app: frontend mtls: mode: STRICT EOFErwartete Ausgabe:

peerauthentication.security.istio.io/frontend created

Konfigurieren Sie eine übereinstimmende Zielregel:

cat <<EOF | kubectl apply -n frontend -f - apiVersion: "networking.istio.io/v1alpha3" kind: "DestinationRule" metadata: name: "frontend" spec: host: "frontend.demo.svc.cluster.local" trafficPolicy: tls: mode: ISTIO_MUTUAL EOFErwartete Ausgabe:

destinationrule.networking.istio.io/frontend created

Greifen Sie über die externe IP-Adresse des Dienstes

frontend-externalauf die Online Boutique zu und aktualisieren Sie die Seite. Die Seite wird nicht angezeigt, weil derfrontend serviceaufSTRICTmTLS gesetzt ist und der Sidecar-Proxy die Anfrage blockiert.Führen Sie den folgenden Befehl aus, um

curlfür denfrontend-Dienst mit reinem HTTP aus einem anderen Pod durchzuführen.kubectl exec \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -c istio-proxy -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Ihre Anfrage schlägt mit dem Statuscode

56fehl.Wenn Sie die Seite in der Google Cloud Console aktualisieren, auf der die Liste Arbeitslasten angezeigt wird, lautet der mTLS-Status für den Dienst

frontendjetztStrictund alle anderen Dienste sind aufPermissiveeingestellt.

Löschen Sie die Authentifizierungsrichtlinie:

kubectl delete peerauthentication -n frontend frontendErwartete Ausgabe:

peerauthentication.security.istio.io "frontend" deletedLöschen Sie die Zielregel:

kubectl delete destinationrule -n frontend frontendErwartete Ausgabe:

destinationrule.networking.istio.io "frontend" deleted

Mesh-weites mTLS erzwingen

Wenn Sie verhindern möchten, dass alle Dienste im Mesh-Netzwerk Klartext-Traffic akzeptieren, legen Sie eine Mesh-weite PeerAuthentication-Richtlinie mit dem mTLS-Modus auf STRICT fest.

Die Mesh-weite PeerAuthentication-Richtlinie sollte keinen Selektor haben und muss im Stamm-Namespace istio-system angewendet werden. Wenn Sie die Richtlinie bereitstellen, stellt die Steuerungsebene automatisch TLS-Zertifikate bereit, sodass Arbeitslasten sich gegenseitig authentifizieren können.

Mesh-weites mTLS erzwingen:

kubectl apply -f - <<EOF apiVersion: "security.istio.io/v1beta1" kind: "PeerAuthentication" metadata: name: "mesh-wide" namespace: "istio-system" spec: mtls: mode: STRICT EOFErwartete Ausgabe:

peerauthentication.security.istio.io/mesh-wide created

Greifen Sie über die externe IP-Adresse des Dienstes

frontend-externalauf die Online Boutique zu und aktualisieren Sie die Seite. Die Seite wird nicht angezeigt.Führen Sie den folgenden Befehl aus, um

curlfür denfrontend-Dienst mit reinem HTTP aus einem anderen Pod durchzuführen.kubectl exec \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -c istio-proxy -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Ihre Anfrage schlägt mit dem Statuscode

56fehl.Löschen Sie die

mesh-wide-Richtlinie:kubectl delete peerauthentication -n istio-system mesh-wideErwartete Ausgabe:

peerauthentication.security.istio.io "mesh-wide" deletedWenn Sie die Seite in der Google Cloud Console aktualisieren, sehen Sie, dass in den

mTLS-Details für alle Dienste jetztPermissiveangezeigt wird.

Bereinigen

Damit Ihrem Google Cloud-Konto die in dieser Anleitung verwendeten Ressourcen nicht in Rechnung gestellt werden, löschen Sie entweder das Projekt, das die Ressourcen enthält, oder Sie behalten das Projekt und löschen die einzelnen Ressourcen.

Wenn Sie zusätzliche Gebühren vermeiden möchten, löschen Sie den Cluster:

gcloud container clusters delete CLUSTER_NAME \ --project=PROJECT_ID \ --zone=CLUSTER_LOCATIONWenn Sie den Cluster behalten und das Online Boutique-Beispiel entfernen möchten:

- Löschen Sie die Anwendungs-Namespaces:

kubectl delete -f online-boutique/kubernetes-manifests/namespacesErwartete Ausgabe:

namespace "ad" deleted namespace "cart" deleted namespace "checkout" deleted namespace "currency" deleted namespace "email" deleted namespace "frontend" deleted namespace "loadgenerator" deleted namespace "payment" deleted namespace "product-catalog" deleted namespace "recommendation" deleted namespace "shipping" deleted- Löschen Sie die Diensteinträge:

kubectl delete -f online-boutique/istio-manifests/allow-egress-googleapis.yamlErwartete Ausgabe:

serviceentry.networking.istio.io "allow-egress-googleapis" deleted serviceentry.networking.istio.io "allow-egress-google-metadata" deleted

Nächste Schritte

- Eine allgemeine Anleitung zum Konfigurieren von

PeerAuthentication-Richtlinien finden Sie unter Transportsicherheit konfigurieren.