El entrenamiento y la extracción de modelos personalizados te permiten crear tu propio modelo diseñado específicamente para tus documentos sin usar la IA generativa. Es ideal si no quieres usar la IA generativa y quieres controlar todos los aspectos del modelo entrenado.

Configuración del conjunto de datos

Se necesita un conjunto de datos de documentos para entrenar, volver a entrenar o evaluar una versión de un procesador. Los procesadores de Document AI aprenden de ejemplos, al igual que los humanos. El conjunto de datos alimenta la estabilidad del procesador en términos de rendimiento.Conjunto de datos de entrenamiento

Para mejorar el modelo y su precisión, entrena un conjunto de datos con tus documentos. El modelo se compone de documentos con información verificada. Necesitas al menos tres documentos para entrenar un modelo nuevo.Conjunto de datos de prueba

El conjunto de datos de prueba es el que usa el modelo para generar una puntuación F1 (precisión). Se compone de documentos con datos verificados. Para ver con qué frecuencia acierta el modelo, se usa la verdad fundamental para comparar las predicciones del modelo (campos extraídos del modelo) con las respuestas correctas. El conjunto de datos de prueba debe tener al menos tres documentos.Antes de empezar

Si aún no lo has hecho, habilita la facturación y la API Document AI.

Crear y evaluar un modelo personalizado

Empieza creando y, después, evaluando un procesador personalizado.

Crea un procesador y define los campos que quieras extraer, lo cual es importante porque influye en la calidad de la extracción.

Definir la ubicación del conjunto de datos: selecciona la carpeta predeterminada Gestionado por Google. Esto puede hacerse automáticamente poco después de crear el procesador.

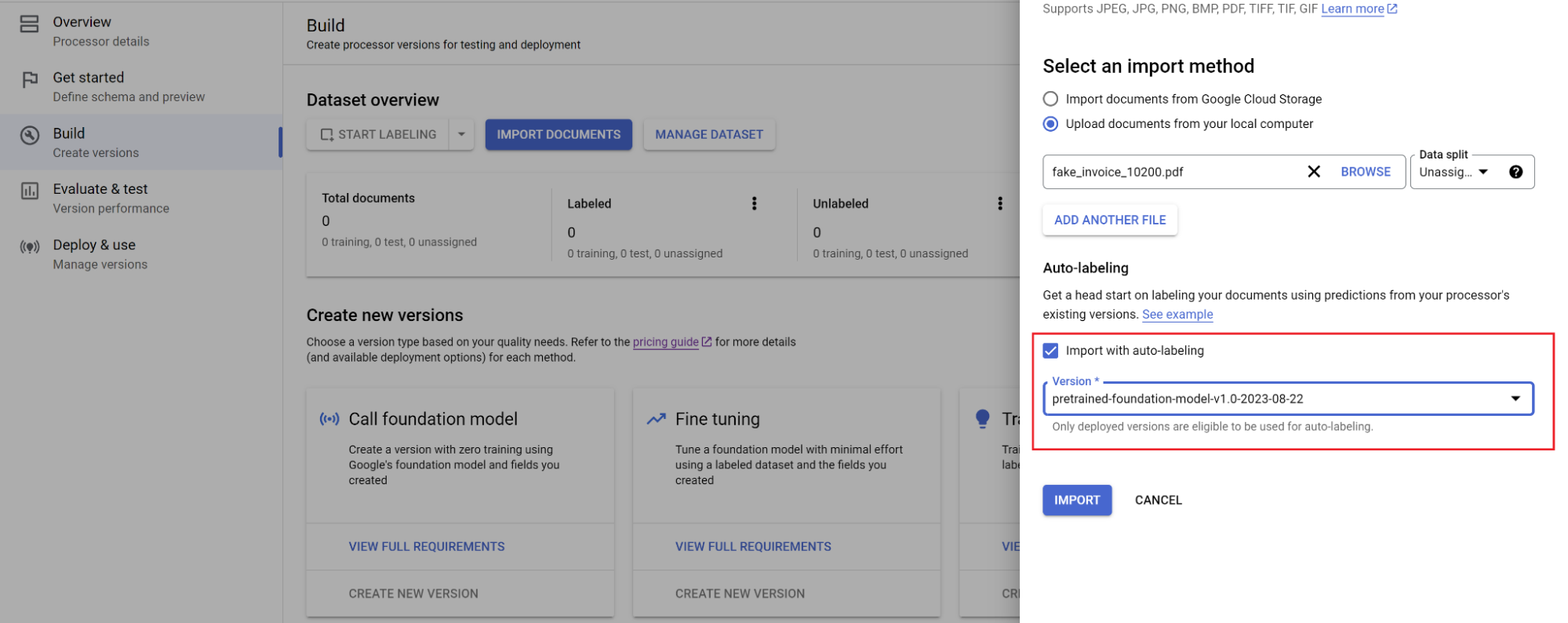

Ve a la pestaña Crear y selecciona Importar documentos con el etiquetado automático habilitado (consulta Etiquetado automático con el modelo base). Para entrenar un modelo personalizado, necesitas un mínimo de 10 documentos en el conjunto de entrenamiento y 10 en el conjunto de pruebas.

Entrenar modelo:

- Selecciona Entrenar nueva versión y asigna un nombre a la versión del procesador.

- Ve a Mostrar opciones avanzadas y selecciona la opción Basado en modelo.

Evaluación:

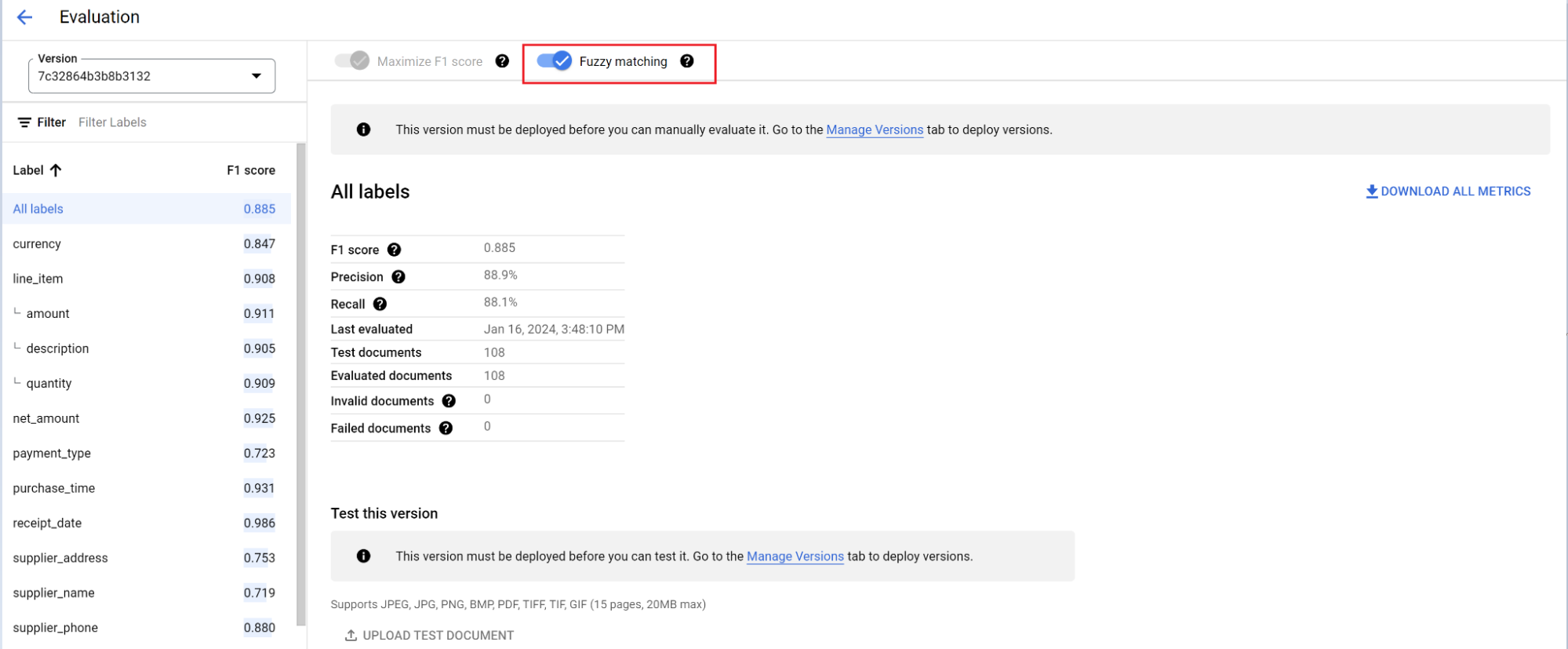

- Ve a Evaluar y probar, selecciona la versión que acabas de entrenar y, a continuación, Ver evaluación completa.

- Ahora puede ver métricas como f1, precisión y recuperación de todo el documento y de cada campo.

- Decide si el rendimiento cumple tus objetivos de producción. Si no es así, vuelve a evaluar los conjuntos de entrenamiento y de prueba. Normalmente, se añaden documentos al conjunto de prueba de entrenamiento que no se analizan correctamente.

Definir una nueva versión como predeterminada.

- Vaya a Gestionar versiones.

- Ve al menú y selecciona Definir como predeterminado.

Tu modelo ya está desplegado y los documentos enviados a este procesador ahora usan tu versión personalizada. Quieres evaluar el rendimiento del modelo para comprobar si necesita más entrenamiento.

Referencia de evaluación

El motor de evaluación puede realizar tanto la concordancia exacta como la concordancia aproximada. Para que haya una coincidencia exacta, el valor extraído debe coincidir exactamente con el valor de referencia o se contabiliza como un error.

Las extracciones de coincidencias aproximadas que tenían pequeñas diferencias, como diferencias en el uso de mayúsculas y minúsculas, siguen contando como coincidencias. Puedes cambiarlo en la pantalla Evaluación.

Etiquetado automático con el modelo fundacional

El modelo base puede extraer campos de forma precisa para varios tipos de documentos, pero también puedes proporcionar datos de entrenamiento adicionales para mejorar la precisión del modelo en estructuras de documentos específicas.

Document AI usa los nombres de las etiquetas que definas y las anotaciones anteriores para etiquetar documentos a gran escala con el etiquetado automático.

- Cuando hayas creado un procesador personalizado, ve a la pestaña Empezar.

- Seleccione Crear campo.

- Proporciona un nombre descriptivo y rellena el campo de descripción. La descripción de la propiedad te permite proporcionar contexto, estadísticas y conocimientos previos adicionales sobre cada entidad para mejorar la precisión y el rendimiento de la extracción.

Ve a la pestaña Compilación y selecciona Importar documentos.

Selecciona la ruta de los documentos y el conjunto al que se deben importar. Marca la casilla de etiquetado automático y selecciona el modelo base.

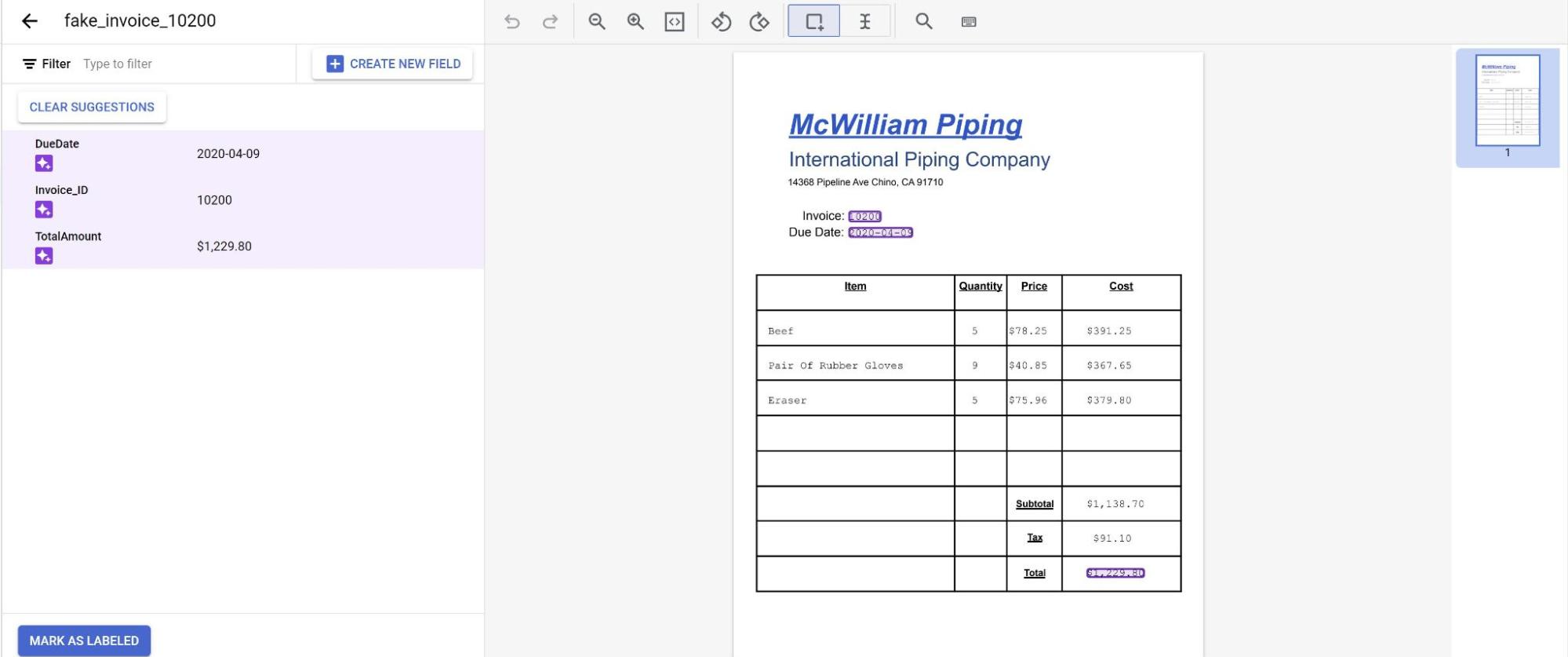

En la pestaña Crear, selecciona Gestionar conjunto de datos. Deberían aparecer los documentos que has importado. Selecciona uno de tus documentos.

Ahora verás las predicciones del modelo resaltadas en morado.

- Revisa cada etiqueta predicha por el modelo y asegúrate de que sea correcta. Si faltan campos, añádelos también.

- Una vez que se haya revisado el documento, selecciona Marcar como etiquetado. El documento ya está listo para que lo use el modelo. Asegúrate de que el documento esté en el conjunto Pruebas o Entrenamiento.