Scegliere modelli e infrastruttura per la tua applicazione di AI generativa

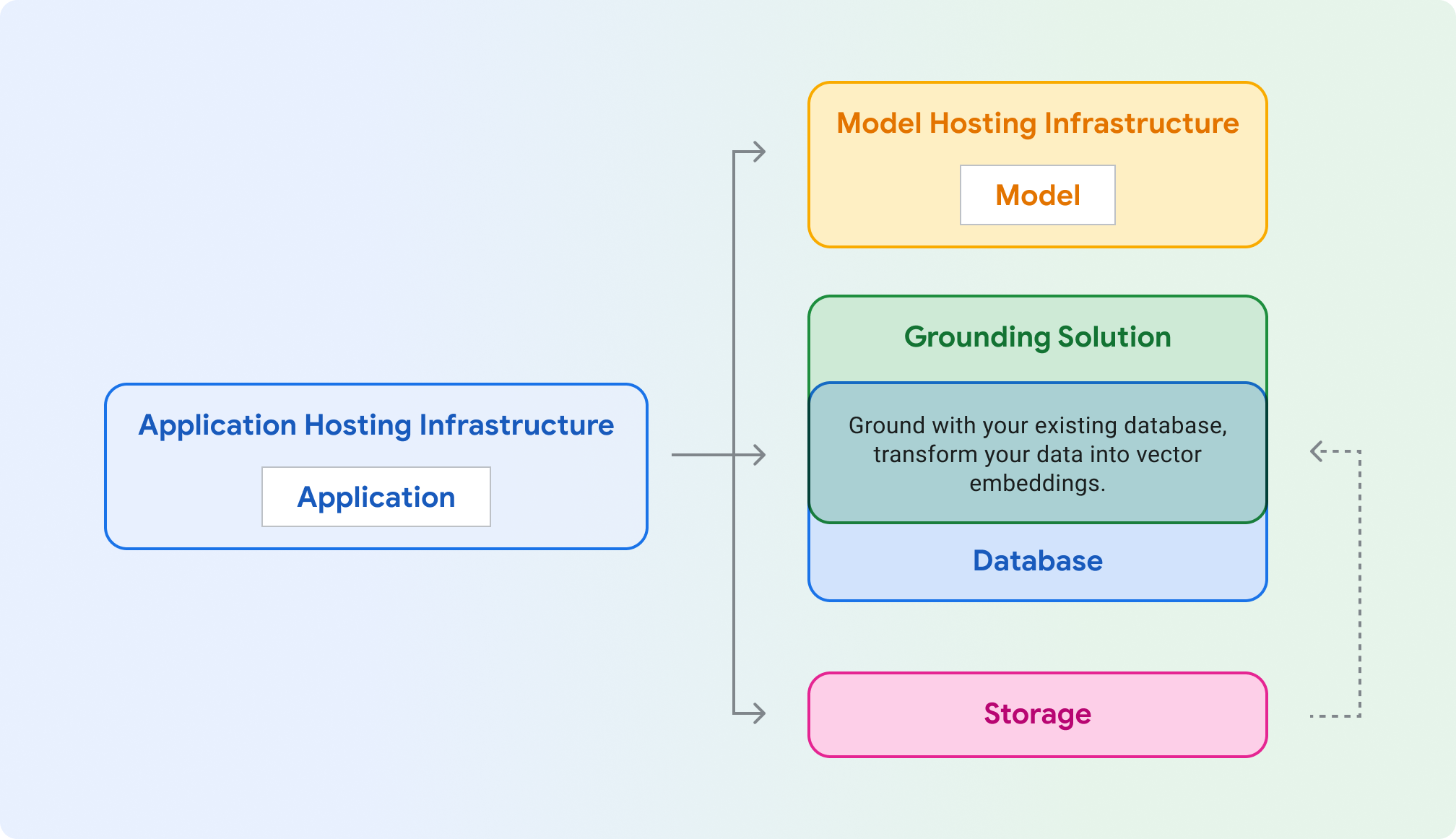

Hosting di applicazioni: risorse di calcolo per ospitare l'applicazione. La tua applicazione può utilizzare gli SDK e le librerie client di Google Cloud per comunicare con diversi prodotti Cloud.

Hosting del modello:hosting scalabile e sicuro per un modello generativo.

Modello: modello generativo per testo, chat, immagini, codice, incorporamenti e multimodale.

Soluzione di grounding: ancora l'output del modello a fonti di informazioni verificabili e aggiornate.

Database:memorizza i dati dell'applicazione. Puoi riutilizzare il tuo database esistente come soluzione di ancoraggio, integrando i prompt tramite query SQL e/o archiviando i dati come embedding vettoriali utilizzando un'estensione come pgvector.

Archiviazione:archivia file come immagini, video o frontend web statici. Puoi anche utilizzare Storage per i dati non elaborati relativi al sistema di ancoraggio (ad es. PDF) che in un secondo momento vengono convertiti in embedding e archiviati in un database vettoriale.

Le sezioni seguenti illustrano ciascuno di questi componenti e ti aiutano a scegliere i prodotti Google Cloud da provare.

Infrastruttura di hosting delle applicazioni

Scegli un prodotto per ospitare e pubblicare il workload dell'applicazione, che esegue chiamate al modello generativo.

Infrastruttura di hosting del modello

Google Cloud offre diversi modi per ospitare un modello generativo, dalla piattaforma di punta Vertex AI all'hosting personalizzabile e portatile su Google Kubernetes Engine.

Utilizzi Gemini e hai bisogno di funzionalità aziendali come scalabilità, sicurezza, privacy dei dati e osservabilità

Vuoi un'infrastruttura completamente gestita con API e strumenti di IA generativa di prima classe?

Il tuo modello richiede un kernel specializzato, un sistema operativo legacy o ha termini di licenza speciali?

Modello

Google Cloud fornisce un insieme di foundation model all'avanguardia tramite Vertex AI , tra cui Gemini. Puoi anche eseguire il deployment di un modello di terze parti in Model Garden di Vertex AI o auto-hosting su GKE , Cloud Run o Compute Engine.

Generazione di embedding per ricerca, classificazione o clustering?

Ok, vuoi generare del testo. Vuoi includere immagini o video nei prompt di testo? (multimodale)

Ok, solo prompt di testo. Vuoi sfruttare il modello di punta più avanzato di Google?

Esegui il deployment di un modello open source in: Vertex AI (Model Garden) GKE (HuggingFace)

Grounding e RAG

Per garantire risposte del modello informate e accurate, basa la tua applicazione di IA generativa su dati in tempo reale. Questa tecnica è chiamata retrieval-augmented generation (RAG).

Se vuoi generare contenuti basati su informazioni aggiornate di internet, i modelli Gemini possono valutare se le conoscenze del modello sono sufficienti o se è necessario il grounding con la Ricerca Google.

Puoi implementare il grounding utilizzando un indice dei tuoi dati con un motore di ricerca. Molti motori di ricerca ora memorizzano gli embedding in un database vettoriale, che è un formato ottimale per operazioni come la ricerca di similarità. Google Cloud offre più soluzioni di database vettoriali per diversi casi d'uso.

Nota: puoi eseguire il grounding utilizzando database non vettoriali eseguendo query su un database esistente come Cloud SQL o Firestore e puoi utilizzare il risultato della query nel prompt del modello.

Vuoi una soluzione ottimizzata completamente gestita che supporti la maggior parte delle origini dati e impedisca l'accesso diretto agli embedding sottostanti?

Vuoi creare un motore di ricerca per RAG utilizzando un orchestratore gestito con un'interfaccia simile a LlamaIndex?

Hai bisogno di una ricerca vettoriale a bassa latenza, di una pubblicazione su larga scala o di un database vettoriale specializzato e ottimizzato?

Hai accesso ai dati tramite programmazione (OLTP)? Utilizzi già un database SQL?

Vuoi utilizzare i modelli di IA di Google direttamente dal tuo database? Hai bisogno di bassa latenza?

Hai un set di dati di analisi di grandi dimensioni (OLAP)? Richiedi l'elaborazione in batch e l'accesso frequente alle tabelle SQL da parte di persone o script (data science)?

Conoscenza di base delle API

Estensioni Vertex AI (anteprima privata)

Componenti di LangChain

Messa a terra in Vertex AI

Inizia a creare

Configurare LangChain

LangChain è un framework open source per app di IA generativa che ti consente di creare contesto nei prompt e di intervenire in base alla risposta del modello.

Visualizzare esempi di codice e implementare applicazioni di esempio

Visualizza esempi di codice per casi d'uso comuni ed esegui il deployment di esempi di applicazioni di IA generativa sicure, efficienti, resilienti, ad alte prestazioni e convenienti.