Escolha modelos e infraestrutura para seu aplicativo de IA generativa

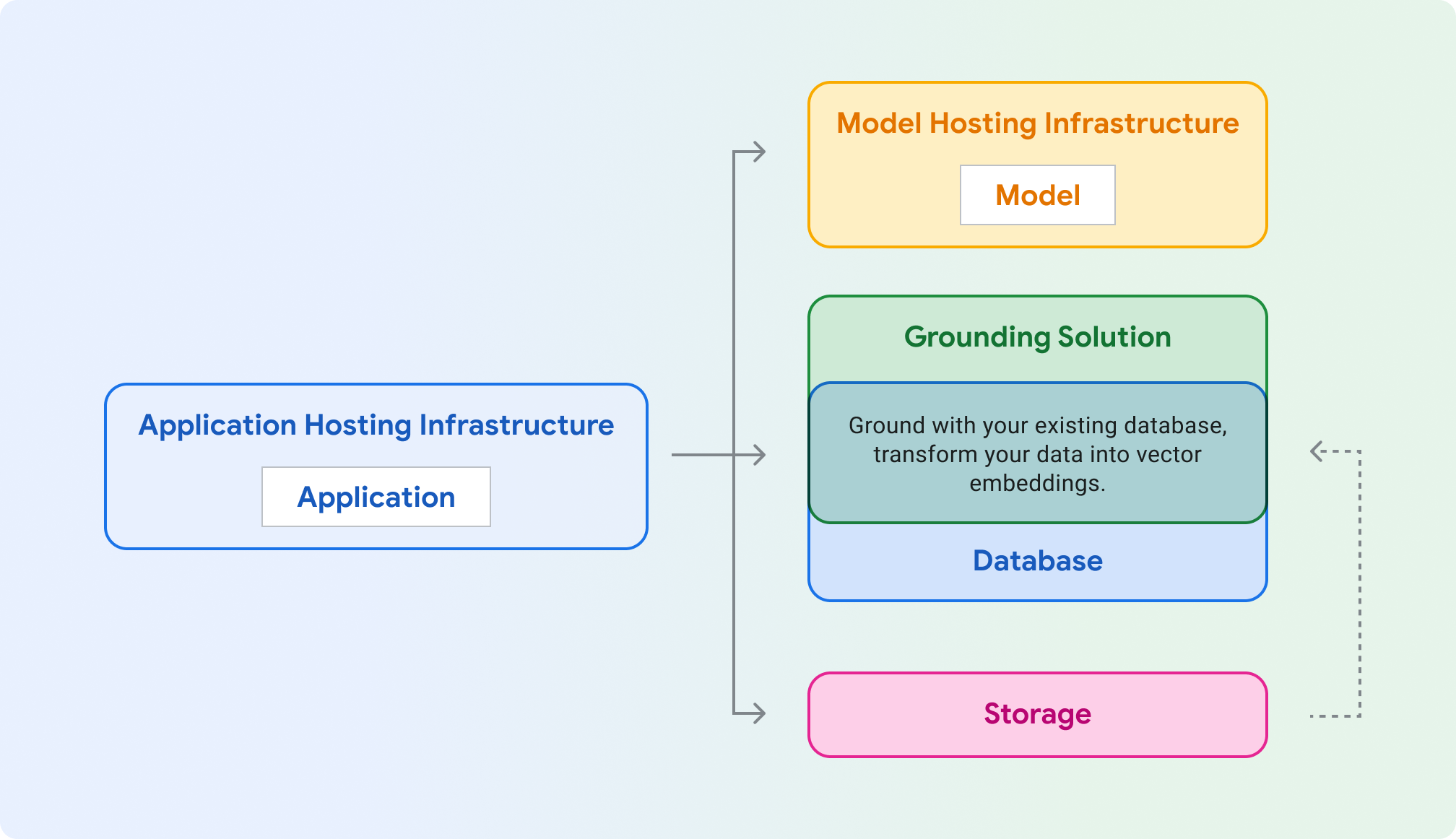

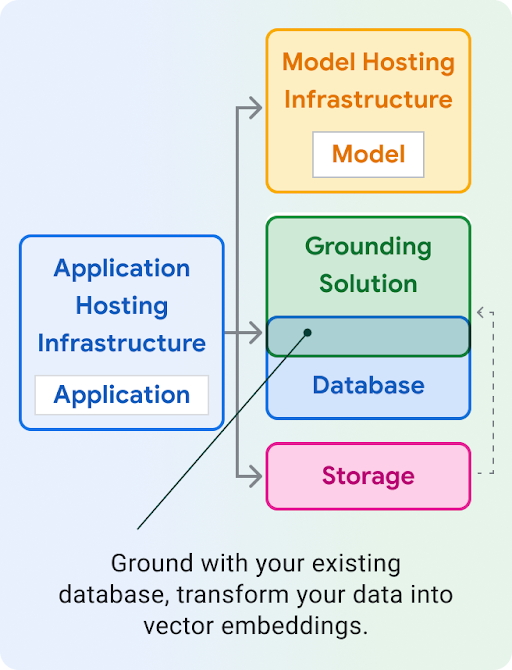

Hospedagem de aplicativos:computação para hospedar seu aplicativo. Seu aplicativo pode usar bibliotecas de cliente e SDKs do Google Cloud para se comunicar com diferentes produtos do Cloud.

Hospedagem de modelos:hospedagem escalonável e segura para um modelo generativo.

Modelo:modelo generativo para texto, chat, imagens, código, embeddings e multimodal.

Solução de embasamento: fixe a saída do modelo em fontes de informações verificáveis e atualizadas.

Banco de dados: armazena os dados do seu aplicativo. É possível reutilizar o banco de dados como solução de embasamento: aumente os comandos com a consulta SQL e/ou armazene os dados como embeddings vetoriais usando uma extensão como pgvector.

Armazenamento:armazene arquivos como imagens, vídeos ou front-ends estáticos da Web. Também é possível usar o Storage para os dados brutos de embasamento (por exemplo, PDFs) que serão convertidos posteriormente em embeddings e armazenados em um banco de dados de vetores.

As seções abaixo mostram cada um desses componentes para ajudar você a escolher quais produtos do Google Cloud testar.

Infraestrutura de hospedagem de aplicativos

Escolha um produto para hospedar e disponibilizar a carga de trabalho do seu aplicativo, que chama o modelo generativo.

Infraestrutura de hospedagem de modelos

O Google Cloud oferece várias maneiras de hospedar um modelo generativo, desde a plataforma principal da Vertex AI até a hospedagem personalizável e portátil no Google Kubernetes Engine.

Usar o Gemini e precisar de recursos empresariais, como escalonamento, segurança, privacidade de dados e observabilidade

Quer infraestrutura totalmente gerenciada com ferramentas e APIs de IA generativa de primeira linha?

Seu modelo exige um kernel especializado, um SO legado ou tem termos de licenciamento especiais?

Modelo

O Google Cloud oferece um conjunto de modelos de fundação de última geração pela Vertex AI , incluindo o Gemini. Também é possível implantar um modelo de terceiros no Model Garden da Vertex AI ou na auto-hospedagem no GKE , no Cloud Run ou no Compute Engine.

Você está gerando embeddings para pesquisa, classificação ou agrupamento?

Ok, você quer gerar texto. Você quer incluir imagens ou vídeos nos comandos de texto? (multimodal)

Ok, apenas comandos de texto. Quer aproveitar o modelo principal mais eficiente do Google?

Implante um modelo de código aberto em: Vertex AI (Model Garden) GKE (HuggingFace)

Altitude de referência

Para garantir respostas de modelo informadas e precisas, baseie seu aplicativo de IA generativa com dados em tempo real. Isso é chamado de geração aumentada de recuperação (RAG).

É possível implementar o embasamento com seus próprios dados em um banco de dados de vetores, que é um formato ideal para operações como a pesquisa por similaridade. O Google Cloud oferece várias soluções de banco de dados de vetores para diferentes casos de uso.

Observação:também é possível embasar com bancos de dados tradicionais (não vetoriais). Basta consultar um banco de dados, como o Cloud SQL ou o Firestore, e usar o resultado no comando do modelo.

Quer uma solução simples, sem acesso às incorporações subjacentes?

Você precisa de pesquisa de vetor de baixa latência, veiculação em grande escala ou quer usar um DB de vetor especializado?

Seus dados são acessados de forma programática (OLTP)? Já está usando um banco de dados SQL?

Quer usar os modelos de IA do Google diretamente no seu banco de dados? Requer baixa latência?

Tem um grande conjunto de dados analíticos (OLAP)? Requer processamento em lote e acesso frequente à tabela SQL por humanos ou scripts (ciência de dados)?

Embasamento com APIs

Extensões da Vertex AI (prévia particular)

Componentes do LangChain

Embasamento na Vertex AI

Comece a criar

Configurar o LangChain

O LangChain é um framework de código aberto para apps de IA generativa que permite criar contexto nos seus comandos e agir com base na resposta do modelo.

Conferir exemplos de código e implantar aplicativos de exemplo

Conheça exemplos de código selecionados para casos de uso conhecidos e implante exemplos de aplicativos de IA generativa que são seguros, eficientes, resilientes, de alto desempenho e econômicos.