Generative KI-Anwendung in Google Cloud erstellen

Google Cloud bietet eine Reihe von Produkten und Tools zum Erstellen generativer KI-Anwendungen mit Skalierung, Sicherheit und Beobachtbarkeit auf Unternehmensniveau.

Auf dieser Seite erfahren Sie mehr über die Phasen der Entwicklung einer generativen KI-Anwendung, die Auswahl der besten Produkte und Tools für Ihren Anwendungsfall und den Zugriff auf die Dokumentation, die Sie für den Einstieg benötigen.

Grundlagen der generativen KI-Entwicklung

Wann werden generative oder herkömmliche KI verwendet?

Generative AI-Anwendung entwickeln

Infrastruktur für Ihre generative KI-Anwendung auswählen

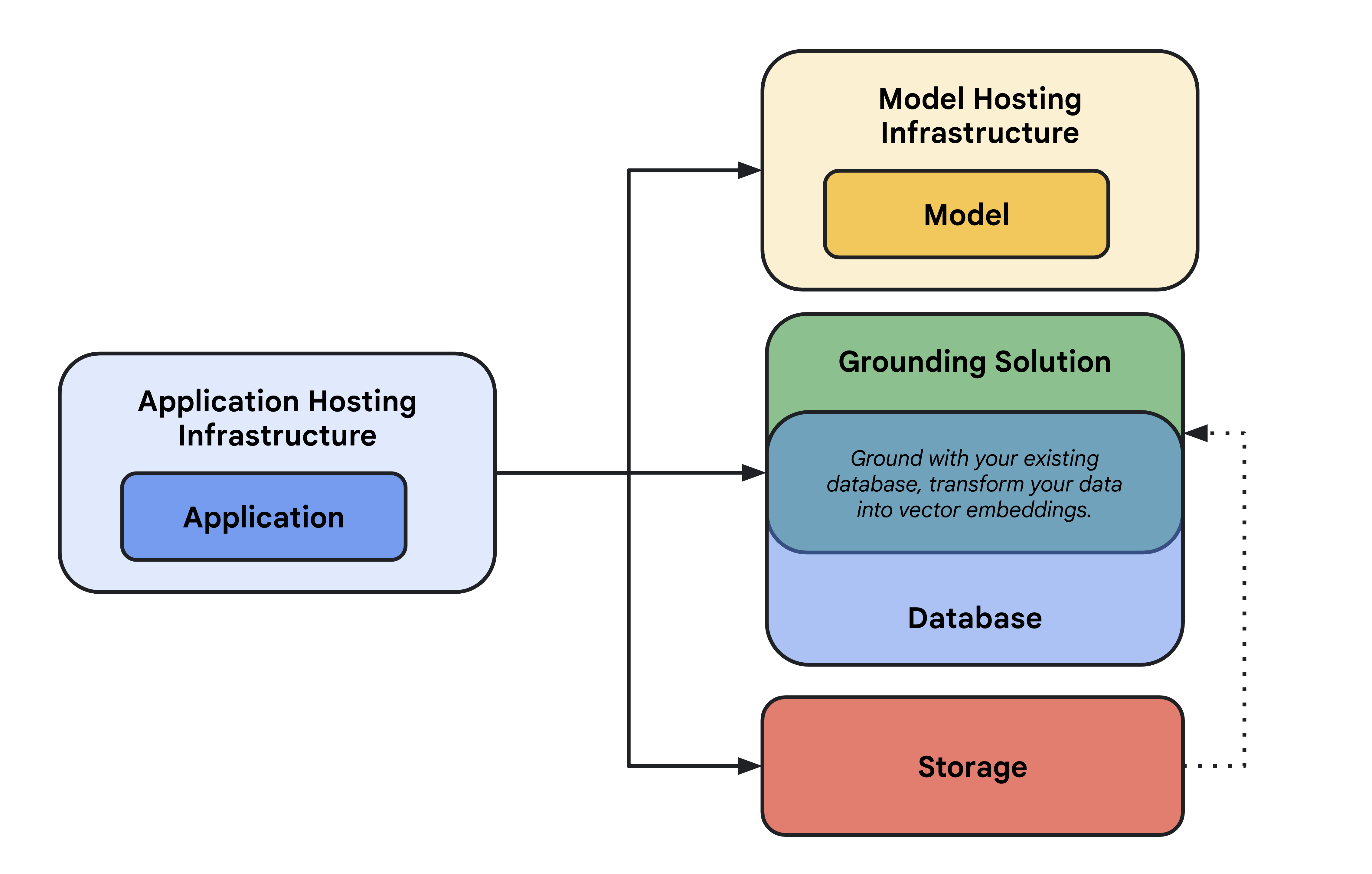

Hier erfahren Sie, welche Produkte, Frameworks und Tools sich am besten für das Erstellen Ihrer generativen KI-Anwendung eignen. Gängige Komponenten in einer in der Cloud gehosteten generativen KI-Anwendung sind:

- Anwendungshosting: Compute zum Hosten Ihrer Anwendung. Ihre Anwendung kann die Clientbibliotheken und SDKs von Google Cloud verwenden, um mit verschiedenen Cloud-Produkten zu kommunizieren.

- Modellhosting: Skalierbares und sicheres Hosting für ein generatives Modell.

- Modell: Generatives Modell für Text, Chat, Bilder, Code, Einbettungen und multimodal.

- Fundierungslösung: Verankern Sie die Modellausgabe auf überprüfbare, aktualisierte Informationsquellen.

- Datenbank: Speichern Sie die Daten Ihrer Anwendung. Sie können Ihre vorhandene Datenbank als Fundierungslösung wiederverwenden, indem Sie Prompts über SQL-Abfrage erweitern und/oder Ihre Daten mit einer Erweiterung wie pgvector als Vektoreinbettungen speichern.

- Speicher: Speichern Sie Dateien wie Bilder, Videos oder statische Web-Front-Ends. Sie können den Speicher auch für die grundlegenden Fundierungsdaten verwenden (z. B. PDFs), die später in Einbettungen konvertiert und in einer Vektordatenbank gespeichert werden.

In den folgenden Abschnitten werden diese Komponenten beschrieben, damit Sie die richtigen Google Cloud-Produkte auswählen können.

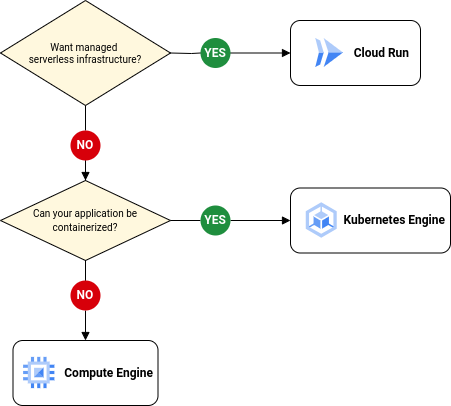

Infrastruktur für das Anwendungshosting

Jetzt starten mit:

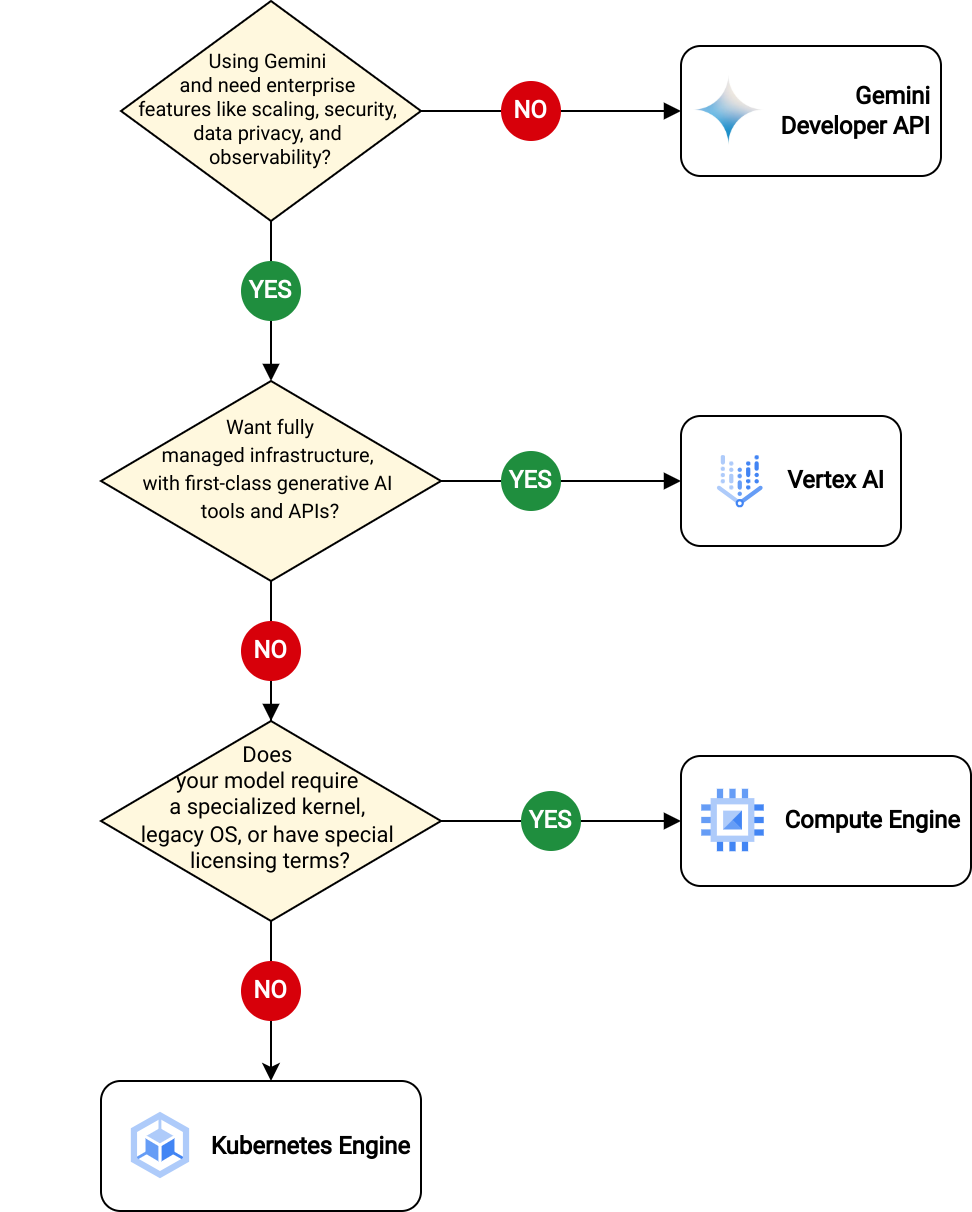

Modellhostinginfrastruktur

Jetzt starten mit:

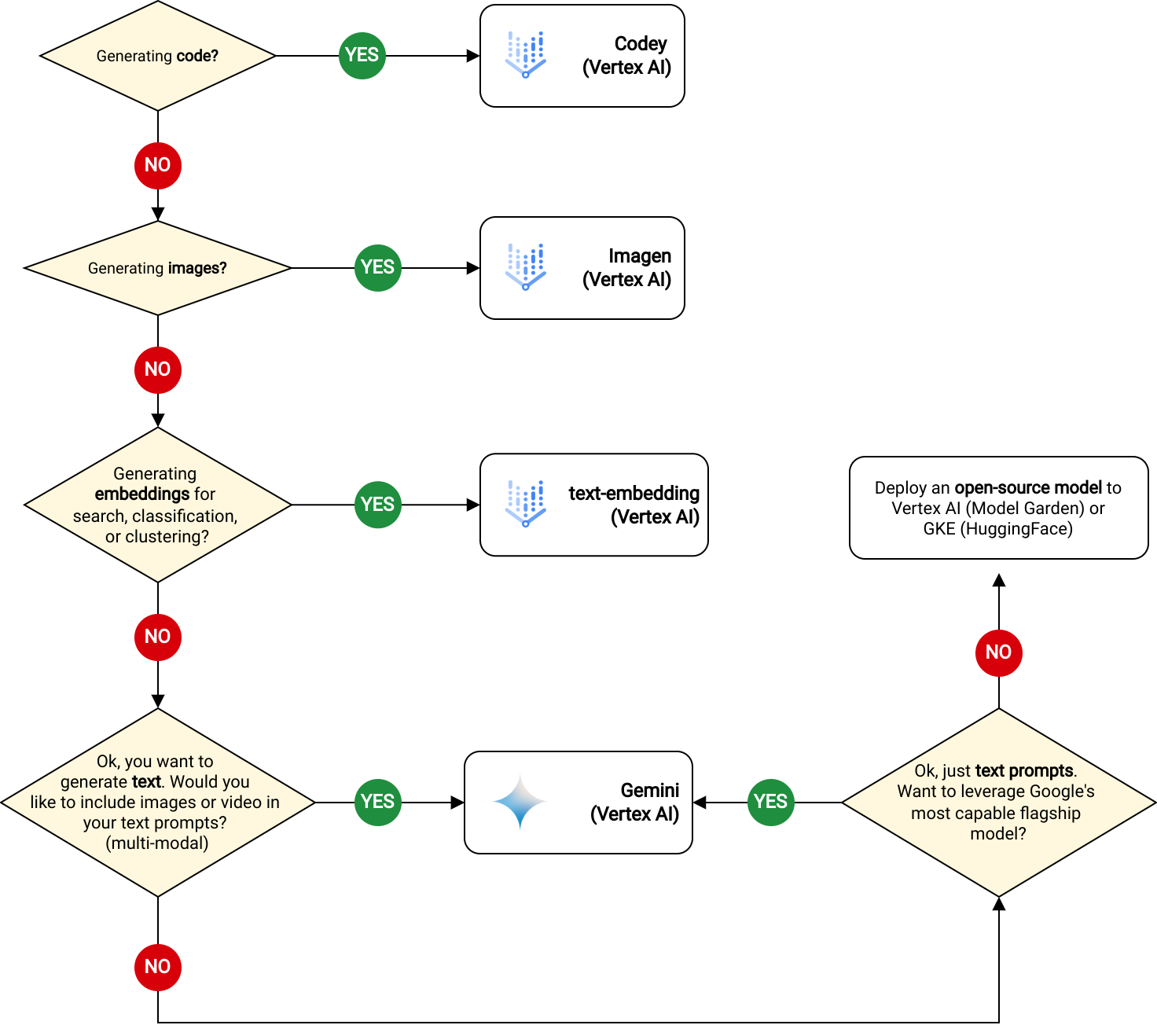

Modell

Jetzt starten mit:

- Gemini

- Codey

- Imagen

- Texteinbettung

- Vertex AI Model Garden (Open-Source-Modelle)

- HuggingFace Model Hub (Open-Source-Modelle)

Nullniveau

Damit Sie fundierte und präzise Modellantworten erhalten, können Sie Ihre generative KI-Anwendung mit Echtzeitdaten fundieren. Dies wird als Retrieval Augmented Generation (RAG) bezeichnet.

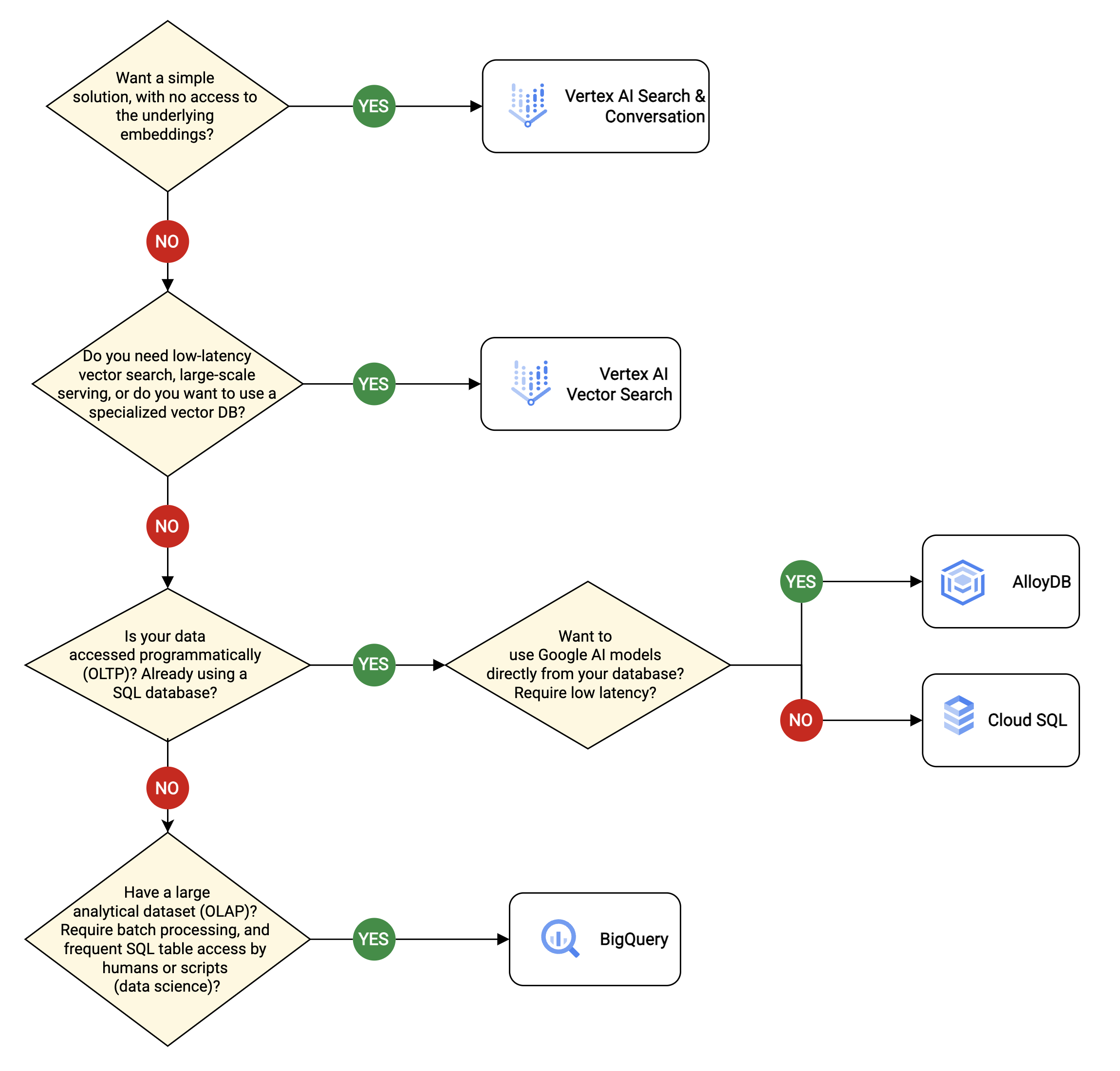

Sie können die Fundierung mit Ihren eigenen Daten in einer Vektordatenbank implementieren, die ein optimales Format für Vorgänge wie die Ähnlichkeitssuche ist. Google Cloud bietet mehrere Lösungen für Vektordatenbanken für verschiedene Anwendungsfälle.

Hinweis: Sie können auch herkömmliche Datenbanken (keine Vektordatenbanken) nutzen, indem Sie einfach eine vorhandene Datenbank wie Cloud SQL oder Firestore abfragen und das Ergebnis in Ihrer Modell-Eingabeaufforderung verwenden.

Jetzt starten mit:

- Vertex AI Agent Builder (früher Enterprise Search, Gen AI App Builder, Discovery Engine)

- Vektorsuche (früher Matching Engine)

- AlloyDB for PostgreSQL

- Cloud SQL

- BigQuery

Fundierung mit APIs

Vertex AI-Erweiterungen (private Vorschau)

Langchain-Komponenten

Fundierung in Vertex AI

Gleich mit dem Erstellen loslegen

Entwicklungsumgebung einrichten

Google Cloud CLI installieren

Cloud Code-Erweiterung in Ihrer IDE installieren

Authentifizierung einrichten

LangChain einrichten

Prompts entwerfen und Modelle bewerten

Einführung in das Prompt-Design

Vertex AI Studio

Prompt-Beispiele generativer KI

Ideenfindung mit generativen Modellen in Vertex AI

Modellbewertung in Vertex AI

Codebeispiele

Webchatbot: Fragen zum Google Store beantworten

Hier erfahren Sie, wie Sie mit dem Vertex AI Agent Builder und Firebase einen webbasierten Chatbot für die Beantwortung von Fragen erstellen.

Chat-App mit Eventarc und Vertex AI

Hier erfahren Sie, wie Sie eine einfache Python Flask-Anwendung erstellen, die ein vortrainiertes Grundlagenmodell in Vertex AI aufruft.

Marketingkampagne mit Gemini erstellen

Erstellen Sie mit Gemini in Vertex AI, Cloud Run und Streamlit eine Webanwendung, um Ideen für Marketingkampagnen zu generieren.

Question Answering-App mit „The Practitioner's Guide to MLOps“

Erfahren Sie, wie Sie Vertex AI Search und LangChain verwenden, um Modell-Prompts auf einer überprüfbaren Wissensquelle zu fundieren (Google Cloud-Whitepaper).

Weather API Request Helper: Funktionsaufruf mit Gemini

Erfahren Sie, wie Sie Funktionsaufrufe implementieren, d. h. die Verwendung eines LLM zum Ausfüllen eines Anfragetexts, den Sie dann an eine externe API senden können.

Architekturanleitung und Schnellstartlösungen

Infrastruktur für eine RAG-fähige generative KI-Anwendung mit Vertex AI

Verwenden Sie diese Referenzarchitektur, um die Infrastruktur für die Ausführung einer generativen KI-Anwendung mit Retrieval Augmented Generation (RAG) mithilfe von Vertex AI und AlloyDB for PostgreSQL zu entwerfen.

Infrastruktur für eine RAG-fähige generative KI-Anwendung mit GKE

Verwenden Sie dieses Referenzarchitektur-Design, um eine generative KI-Anwendung mit Retrieval Augmented Generation (RAG) unter Verwendung von GKE, Cloud SQL und Open-Source-Tools wie Ray, Hugging Face und LangChain auszuführen.

Speicher für KI- und ML-Arbeitslasten in Google Cloud entwerfen

In diesem Dokument finden Sie Designanleitungen zur Verwendung und Integration der verschiedenen Speicheroptionen von Google Cloud für wichtige KI- und ML-Arbeitslasten.

Schnellstartlösung: Dokumentzusammenfassung

Stellen Sie eine Beispielanwendung mit einem Klick bereit, um lange Dokumente mit Vertex AI zusammenzufassen.

Schnellstartlösung: Generative AI RAG mit Cloud SQL

Stellen Sie eine Beispielanwendung mit einem Klick bereit, die in Cloud SQL gespeicherte Vektoreinbettungen verwendet, um die Genauigkeit von Antworten aus einer Chatanwendung zu verbessern.

Schnellstartlösung: Wissensdatenbank zu generativer KI

Stellen Sie eine Beispielanwendung mit einem Klick bereit, die Frage-und-Antwort-Paare aus einer Reihe von Dokumenten extrahiert, zusammen mit einer Pipeline, die die Anwendung beim Hochladen eines Dokuments auslöst.