Objetivos

Use o Dataproc Hub para criar um ambiente de bloco de notas do JupyterLab de utilizador único executado num cluster do Dataproc.

Crie um notebook e execute uma tarefa do Spark no cluster do Dataproc.

Elimine o cluster e preserve o bloco de notas no Cloud Storage.

Antes de começar

- O administrador tem de lhe conceder

notebooks.instances.useautorização (consulte o artigo Defina funções de gestão de identidade e de acesso (IAM)).

Crie um cluster do Dataproc JupyterLab a partir do Dataproc Hub

Selecione o separador User-Managed Notebooks na página Dataproc→Workbench na Google Cloud consola.

Clique em Abrir JupyterLab na linha que apresenta a instância do Dataproc Hub criada pelo administrador.

- Se não tiver acesso à Google Cloud consola, introduza o URL da instância do Dataproc Hub que um administrador partilhou consigo no seu navegador de Internet.

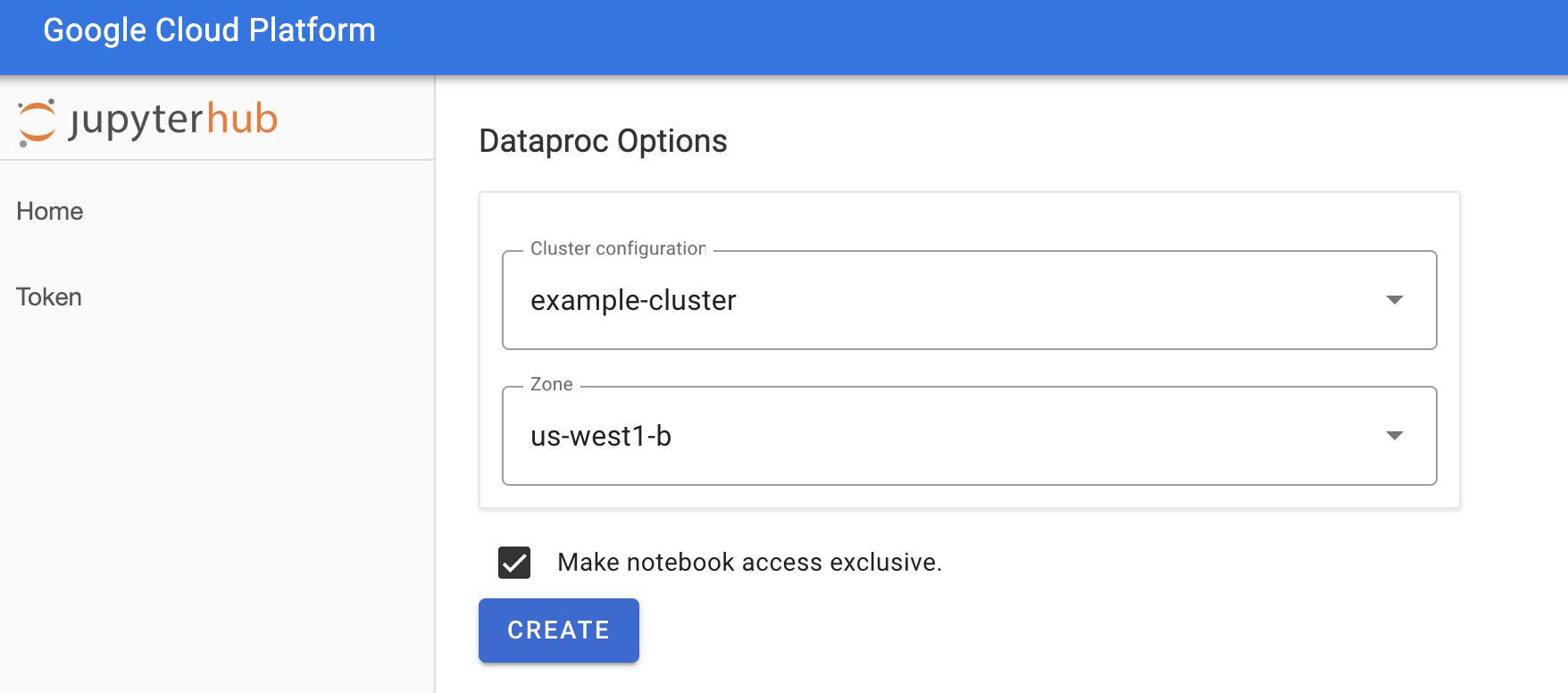

Na página Jupyterhub→Opções do Dataproc, selecione uma configuração de cluster e uma zona. Se estiver ativada, especifique as personalizações e, de seguida, clique em Criar.

Depois de criar o cluster do Dataproc, é feito o redirecionamento para a interface do JupyterLab em execução no cluster.

Crie um notebook e execute uma tarefa do Spark

No painel esquerdo da interface do JupyterLab, clique em

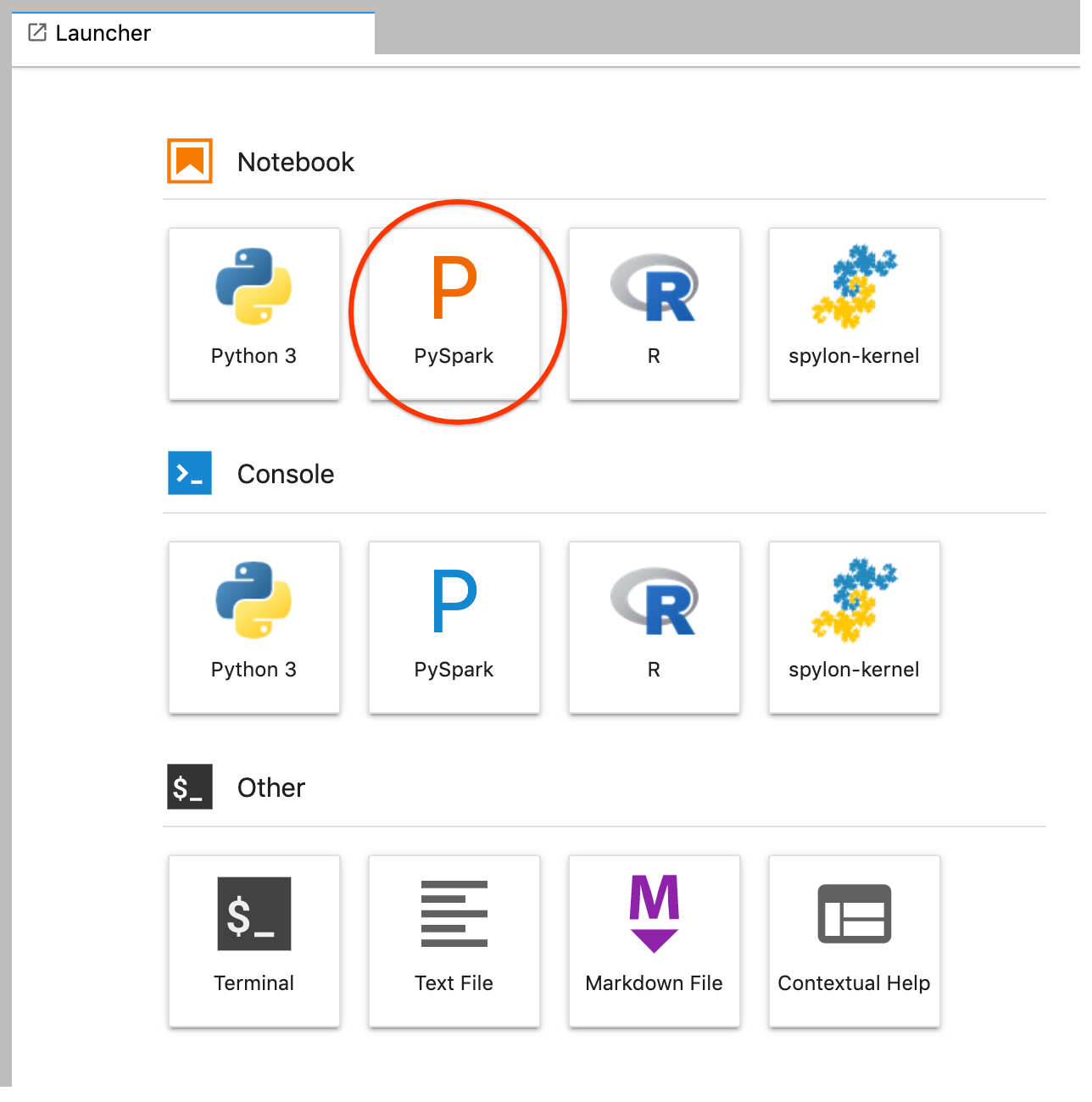

GCS(Cloud Storage).Crie um notebook PySpark a partir do Launcher do JupyterLab.

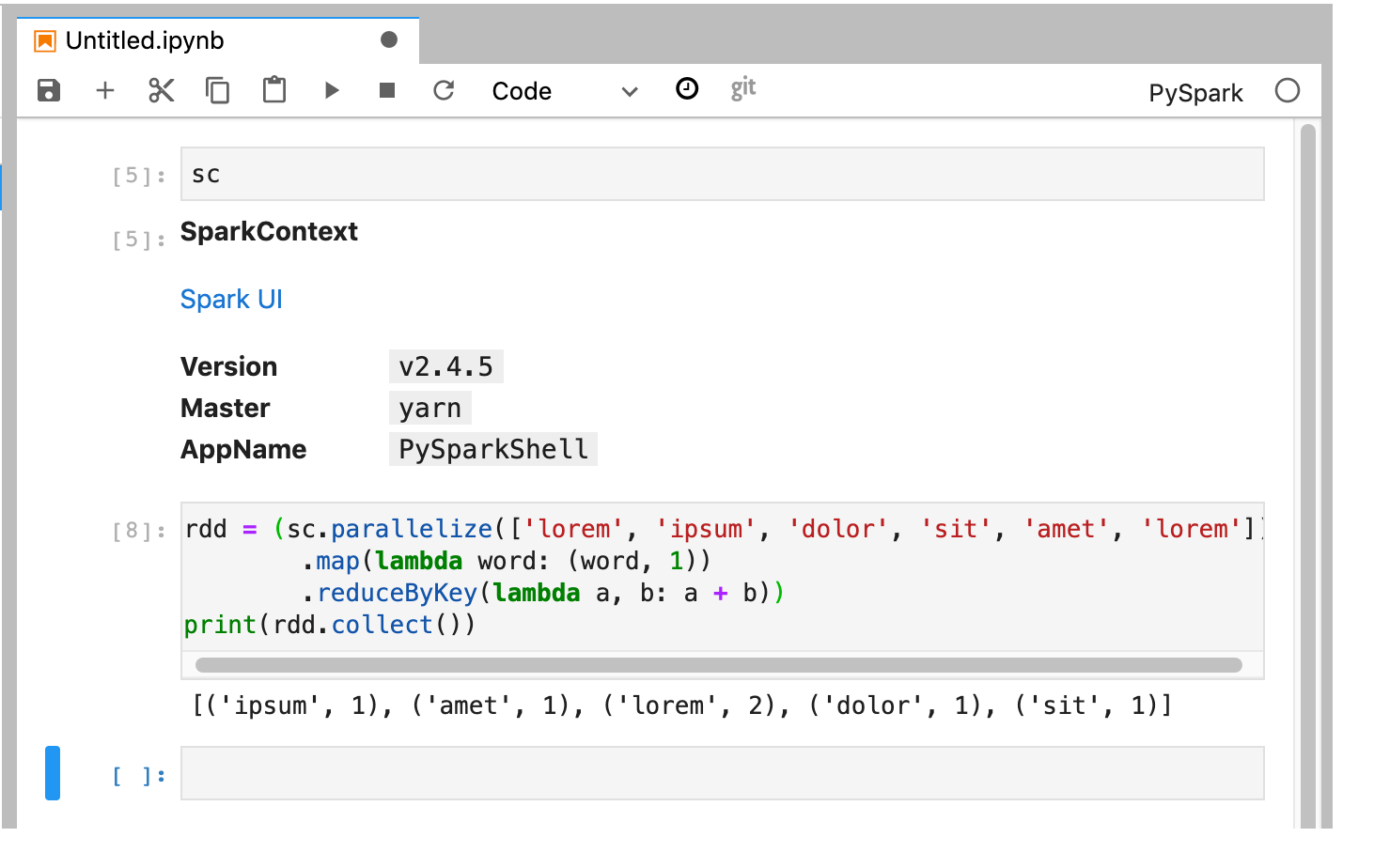

O kernel do PySpark inicializa um SparkContext (usando a variável

sc). Pode examinar o SparkContext e executar uma tarefa do Spark a partir do bloco de notas.rdd = (sc.parallelize(['lorem', 'ipsum', 'dolor', 'sit', 'amet', 'lorem']) .map(lambda word: (word, 1)) .reduceByKey(lambda a, b: a + b)) print(rdd.collect())

Atribua um nome e guarde o bloco de notas. O bloco de notas é guardado e permanece no armazenamento na nuvem após a eliminação do cluster do Dataproc.

Encerre o cluster do Dataproc

Na interface do JupyterLab, selecione File→Hub Control Panel para abrir a página Jupyterhub.

Clique em Parar o meu cluster para encerrar (eliminar) o servidor do JupyterLab, que elimina o cluster do Dataproc.

O que se segue?

- Explore o Spark e os blocos de notas do Jupyter no Dataproc no GitHub.