6단계: 배포 실행

이 페이지에서는 Cortex Framework의 핵심인 Cortex Framework Data Foundation을 배포하는 여섯 번째 단계를 설명합니다. 이 단계에서는 Cortex Framework Data Foundation의 배포를 실행합니다.

빌드 프로세스

5단계: 배포 구성에 설명된 대로 config.json 파일을 구성한 후 다음 안내에 따라 프로세스를 빌드합니다.

다음 명령어를 실행하여 클론된 저장소로 이동합니다.

cd cortex-data-foundation타겟 로그 버킷과 함께 빌드 명령어를 실행합니다.

gcloud builds submit \ --substitutions=_GCS_BUCKET=LOGS_BUCKET_NAME,_BUILD_ACCOUNT='projects/SOURCE_PROJECT/serviceAccounts/CLOUD_BUILD_SA@SOURCE_PROJECT.iam.gserviceaccount.com'다음을 바꿉니다.

LOGS_BUCKET_NAME을 로그 저장소의 버킷 이름으로 바꿉니다. Cloud Build 서비스 계정에는 여기에 쓸 수 있는 액세스 권한이 필요합니다.SOURCE_PROJECT를 소스 프로젝트로 바꿉니다.- 배포 4단계에서 만든 Cloud Build 서비스 계정 ID를 사용하여

CLOUD_BUILD_SA

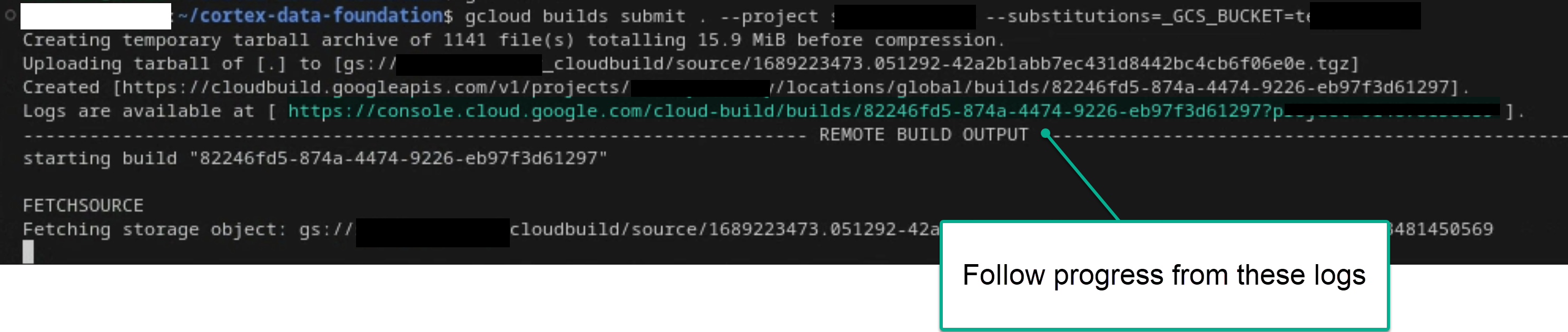

권한이 충분한 경우 터미널 또는 Cloud Build 콘솔에서 로그를 확인하여 기본 빌드 프로세스를 따릅니다. 자세한 내용은 다음 이미지를 참고하세요.

그림 1. 터미널에서 로그 진행 상황을 보는 예

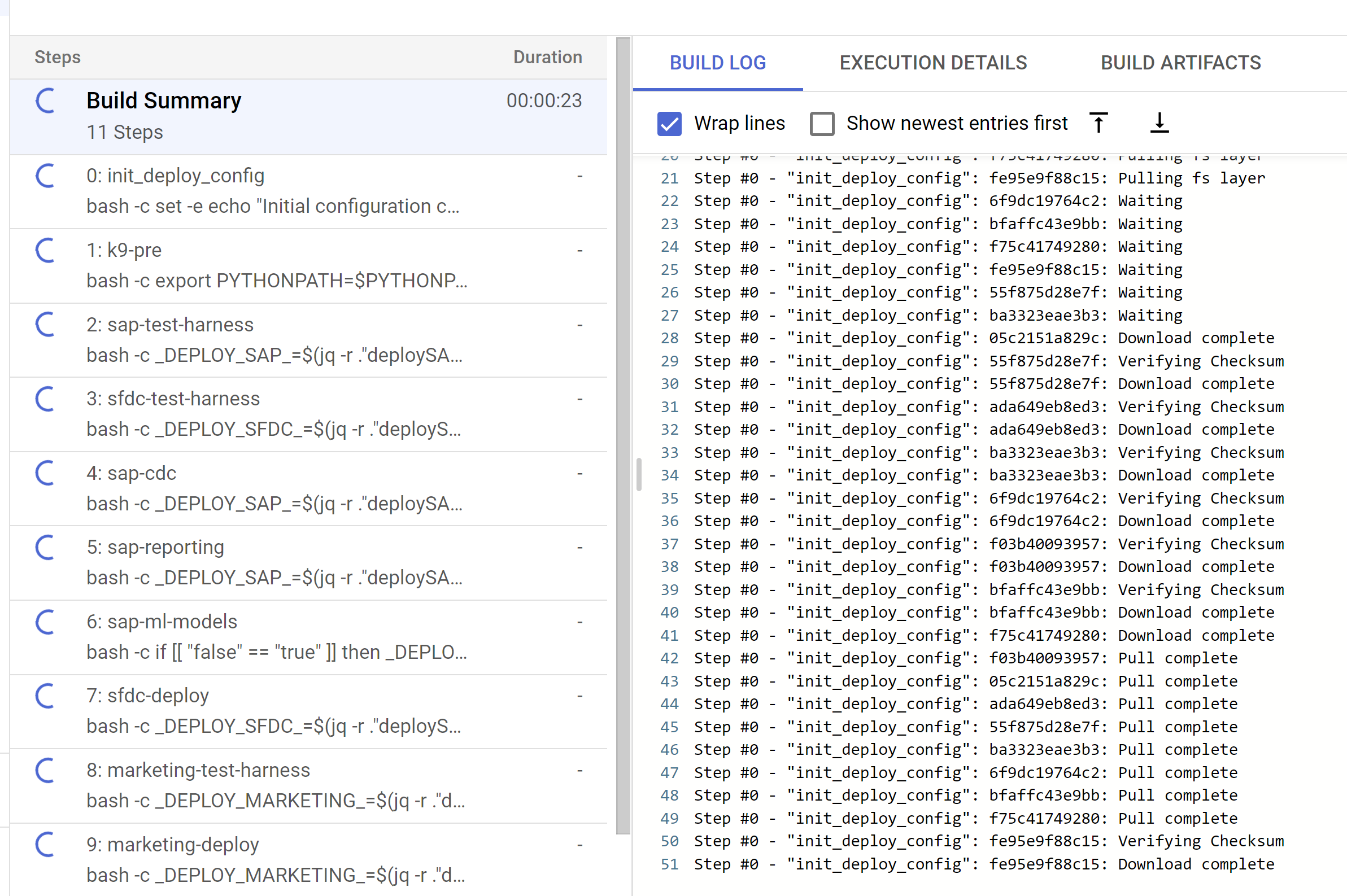

그림 2. 콘솔에서 로그 진행 상황을 확인하는 예시 Cloud Build 콘솔에서 트리거되거나 단계에서 생성된 로그 내에서 트리거된 하위 빌드 단계를 추적합니다. 자세한 내용은 다음 이미지를 참고하세요.

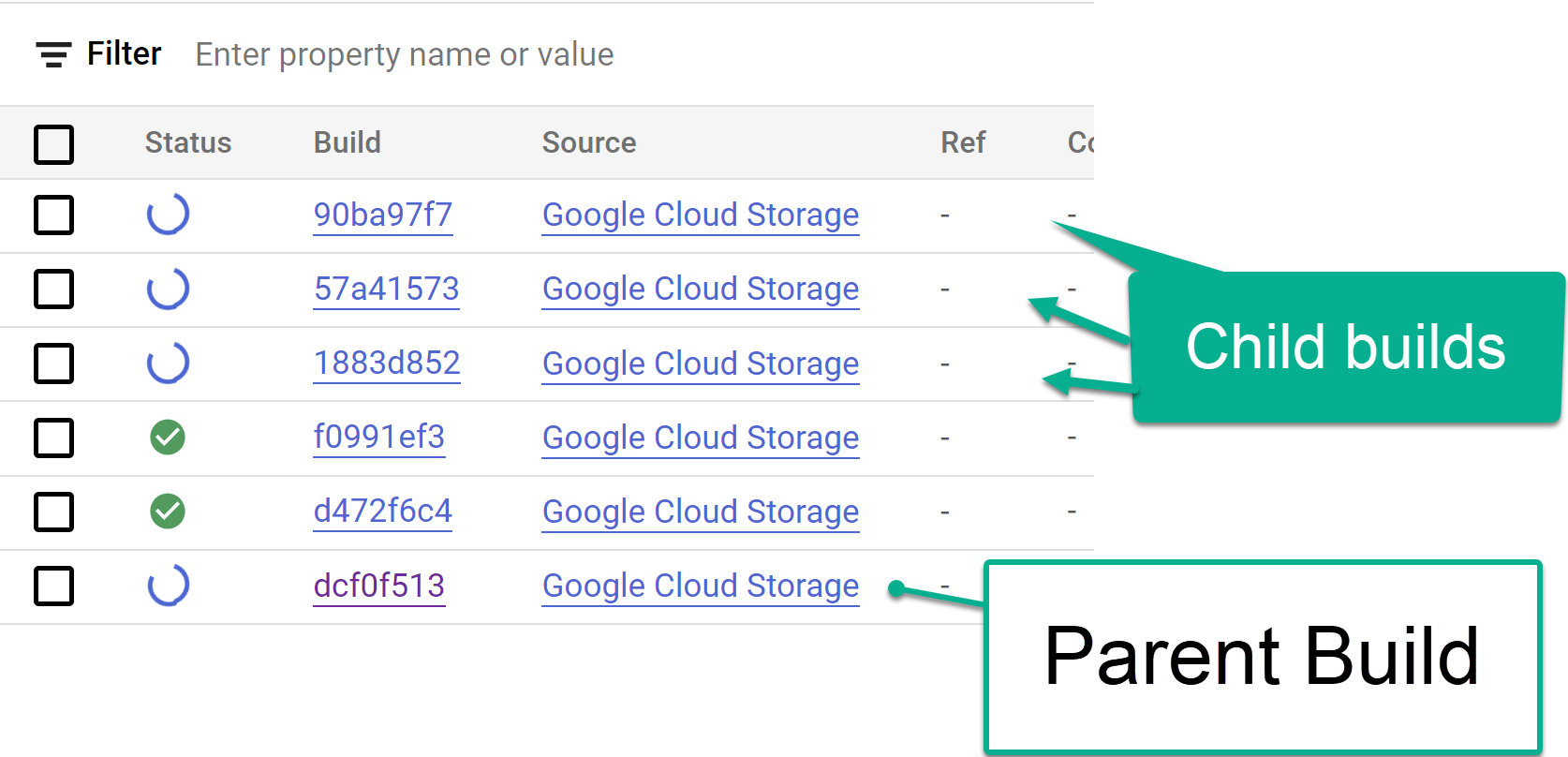

그림 3. 콘솔에서 자식 빌드 단계를 추적하는 예

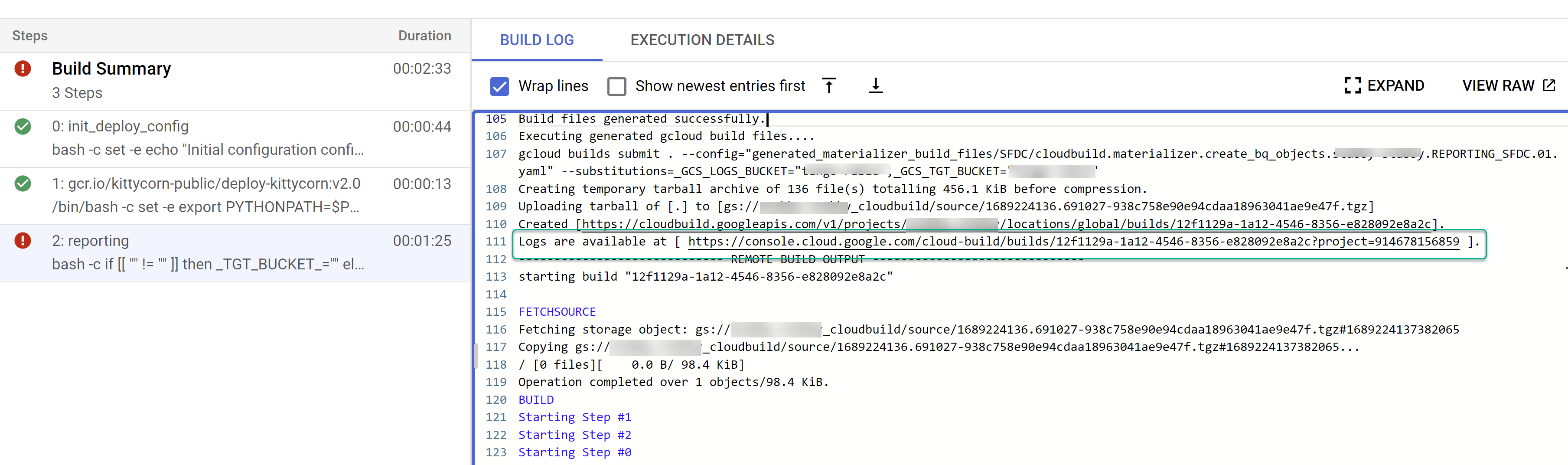

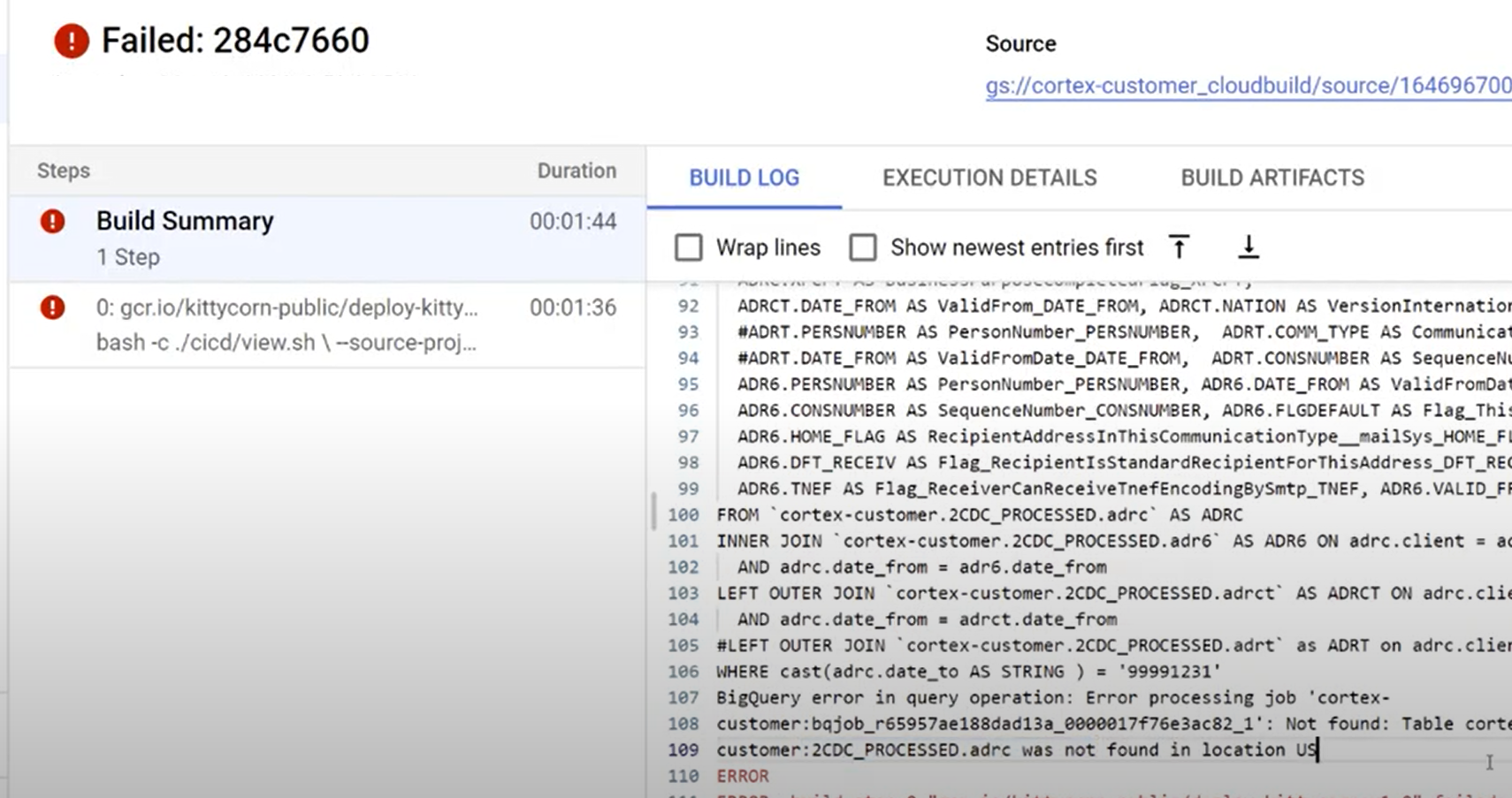

그림 4. 로그 내에서 하위 빌드 단계를 추적하는 예 개별 빌드의 문제를 식별합니다. 오류가 있으면 수정합니다. 생성된 SQL을 BigQuery에 붙여넣어 오류를 식별하고 수정하는 것이 좋습니다. 대부분의 오류는 선택되었지만 복제된 소스에 없는 필드와 관련이 있습니다. BigQuery UI를 사용하면 이러한 항목을 식별하고 주석 처리할 수 있습니다.

그림 5. Cloud Build 로그를 통해 문제를 식별하는 예

파일을 Cloud Composer (Airflow) DAG 버킷으로 이동

통합 또는 CDC 파일을 생성하도록 선택했고 Cloud Composer (Airflow) 인스턴스가 있는 경우 다음 명령어를 사용하여 최종 버킷으로 이동할 수 있습니다.

gcloud storage -m cp -r gs://OUTPUT_BUCKET/dags/ gs://COMPOSER_DAG_BUCKET/

gcloud storage -m cp -r gs://OUTPUT_BUCKET/data/ gs://COMPOSER_DAG_BUCKET/

다음을 바꿉니다.

OUTPUT_BUCKET을 출력 버킷으로 바꿉니다.- Cloud Composer (Airflow) DAG 버킷을 사용합니다.

COMPOSER_DAG_BUCKET

맞춤설정 및 업그레이드 준비

많은 엔터프라이즈 고객은 흐름의 추가 문서나 특정 유형의 레코드와 같은 시스템을 맞춤설정합니다. 이는 각 고객에게 고유하며 비즈니스 요구사항이 발생하면 기능 분석가가 구성합니다.

Cortex는 코드에서 ## CORTEX-CUSTOMER 태그를 사용하여 이러한 맞춤설정이 필요할 수 있는 위치를 나타냅니다. grep -R CORTEX-CUSTOMER 명령어를 사용하여 맞춤설정해야 하는 모든 ## CORTEX-CUSTOMER 주석을 확인합니다.

CORTEX-CUSTOMER 태그 외에도 코드의 명확한 태그를 사용하여 이러한 모든 변경사항을 포크 또는 클론된 저장소에 커밋하여 다음을 추가로 맞춤설정해야 할 수 있습니다.

- 비즈니스 규칙 추가

- 다른 데이터 세트를 추가하고 기존 뷰 또는 테이블과 조인

- 제공된 템플릿을 재사용하여 추가 API를 호출합니다.

- 배포 스크립트 수정

- 추가 데이터 메시 개념 적용

- 표준에 포함되지 않은 추가 필드를 포함하도록 일부 표 또는 출시된 API를 적응시킵니다.

조직에 적합한 CI/CD 파이프라인을 채택하여 이러한 개선사항을 테스트하고 전반적인 솔루션을 안정적이고 강력한 상태로 유지하세요. 파이프라인은 cloudbuild.yaml 스크립트를 재사용하여 빌드를 자동화함으로써 선택한 저장소에 따라 주기적으로 또는 Git 작업을 기반으로 엔드 투 엔드 배포를 트리거할 수 있습니다.

config.json 파일을 사용하여 개발, 스테이징, 프로덕션 환경에 서로 다른 프로젝트 및 데이터 세트를 정의합니다. 자체 샘플 데이터로 자동화된 테스트를 사용하여 모델이 항상 예상한 결과를 생성하도록 합니다.

리포지토리의 포크 또는 클론에서 변경사항을 명시적으로 태그하고 일부 배포 및 테스트 자동화를 사용하면 업그레이드를 실행하는 데 도움이 됩니다.

지원

이러한 모델 또는 배포자와 관련된 문제가 발생하거나 기능 요청이 있는 경우 Cortex Framework Data Foundation 저장소에서 문제를 만드세요. 필요한 정보를 수집하는 데 도움이 되도록 클론된 디렉터리에서 support.sh를 실행합니다. 이 스크립트는 문제 해결에 도움이 되는 일련의 단계를 안내합니다.

Cortex Framework 요청 또는 문제가 있는 경우 개요 페이지의 지원 섹션으로 이동하세요.

Looker 블록 및 대시보드

사용 가능한 Looker 블록과 대시보드를 활용합니다. 이는 기본적으로 Cortex Framework의 일반적인 분석 패턴과 데이터 소스를 위한 재사용 가능한 데이터 모델입니다. 자세한 내용은 Looker 블록 및 대시보드 개요를 참고하세요.