Etapa 1: estabelecer cargas de trabalho

Esta página orienta você na etapa inicial de configuração da base de dados, que é o núcleo do Cortex Framework. Criada com base no armazenamento do BigQuery, a base de dados organiza os dados recebidos de várias fontes. Esses dados organizados simplificam a análise e a aplicação no desenvolvimento de IA.

Configurar a integração de dados

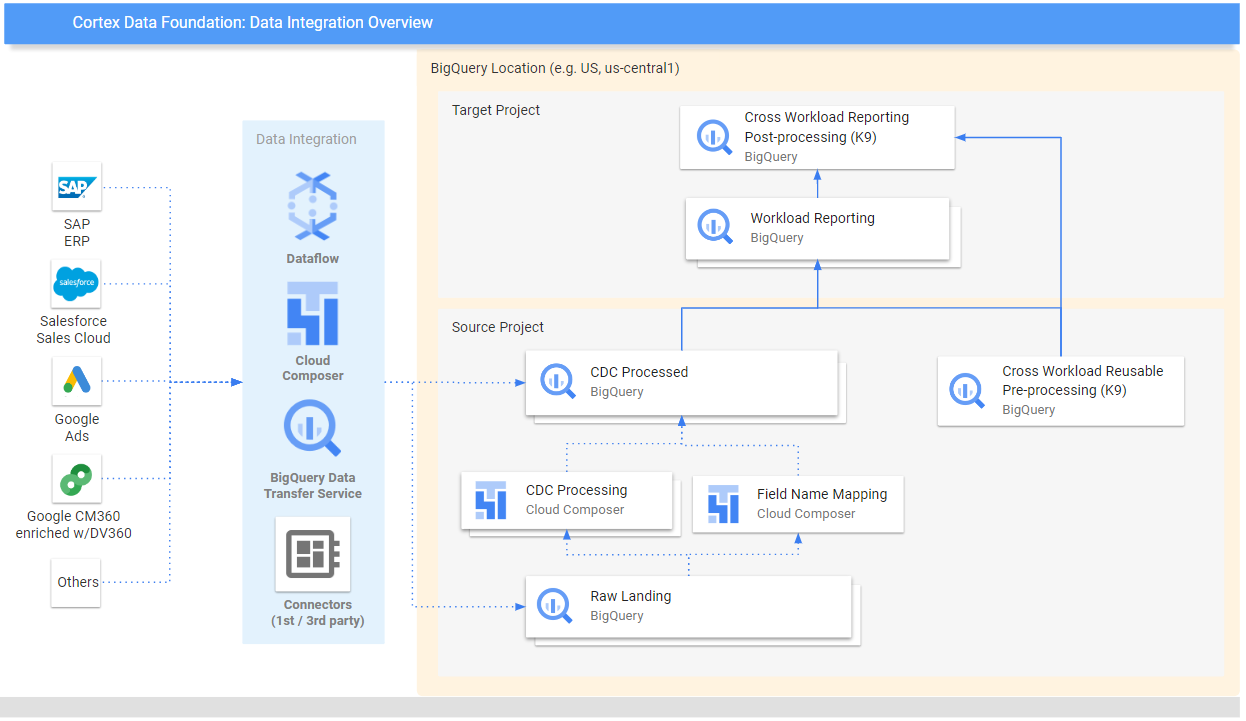

Comece definindo alguns parâmetros principais para servir como um modelo de organização e uso eficiente dos dados no Cortex Framework. Esses parâmetros podem variar dependendo da carga de trabalho específica, do fluxo de dados escolhido e do mecanismo de integração. O diagrama a seguir oferece uma visão geral da integração de dados na base de dados do Cortex Framework:

Defina os seguintes parâmetros antes da implantação para uma utilização de dados eficiente e eficaz no Cortex Framework.

Projetos

- Projeto de origem:projeto em que seus dados brutos estão localizados. Você precisa de pelo menos um projeto do Google Cloud para armazenar dados e executar o processo de implantação.

- Projeto de destino (opcional): projeto em que a Data Foundation do Cortex Framework armazena os modelos de dados processados. Pode ser o mesmo projeto de origem ou um diferente, dependendo das suas necessidades.

Se você quiser ter conjuntos separados de projetos e conjuntos de dados para cada carga de trabalho (por exemplo, um conjunto de projetos de origem e destino para SAP e um conjunto diferente de projetos de destino e origem para Salesforce), execute implantações separadas para cada carga de trabalho. Para mais informações, consulte Usar projetos diferentes para separar o acesso na seção de etapas opcionais.

Modelo de dados

- Implantar modelos:escolha se você precisa implantar modelos para todas as cargas de trabalho ou apenas um conjunto de modelos (por exemplo, SAP, Salesforce e Meta). Para mais informações, consulte Fontes de dados e cargas de trabalho disponíveis.

Conjuntos de dados do BigQuery

- Conjunto de dados de origem (bruto): conjunto de dados do BigQuery em que os dados de origem são replicados ou em que os dados de teste são criados. A recomendação é ter conjuntos de dados separados, um para cada fonte. Por exemplo, um conjunto de dados brutos para o SAP e outro para o Google Ads. Esse conjunto de dados pertence ao projeto de origem.

- Conjunto de dados de CDC:conjunto de dados do BigQuery em que os dados processados de CDC recebem os registros mais recentes disponíveis. Algumas cargas de trabalho permitem o mapeamento de nomes de campos. A recomendação é ter um conjunto de dados de CDC separado para cada fonte. Por exemplo, um conjunto de dados de CDC para SAP e outro para Salesforce. Esse conjunto de dados pertence ao projeto de origem.

- Conjunto de dados de relatórios de destino:conjunto de dados do BigQuery em que os modelos de dados predefinidos da Data Foundation são implantados. Recomendamos ter um conjunto de dados de relatórios separado para cada origem. Por exemplo, um conjunto de dados de relatórios para SAP e outro para Salesforce. Esse conjunto de dados é criado automaticamente durante a implantação, se não existir. Esse conjunto de dados pertence ao projeto de destino.

- Pré-processamento do conjunto de dados K9:conjunto de dados do BigQuery em que componentes DAG reutilizáveis e entre cargas de trabalho, como dimensões

time, podem ser implantados. As cargas de trabalho têm uma dependência desse conjunto de dados, a menos que sejam modificadas. Esse conjunto de dados é criado automaticamente durante a implantação, se ainda não existir. Esse conjunto de dados pertence ao projeto de origem. - Conjunto de dados K9 de pós-processamento:conjunto de dados do BigQuery em que é possível implantar relatórios entre cargas de trabalho e DAGs de fontes externas adicionais (por exemplo, ingestão do Google Trends). Esse conjunto de dados é criado automaticamente durante a implantação, se ainda não existir. Esse conjunto de dados pertence ao projeto de destino.

Opcional: gerar dados de amostra

O Cortex Framework pode gerar dados e tabelas de amostra para você se não tiver acesso aos seus próprios dados ou ferramentas de replicação para configurar dados, ou mesmo se quiser apenas ver como o Cortex Framework funciona. No entanto, você ainda precisa criar e identificar os conjuntos de dados de CDC e brutos com antecedência.

Crie conjuntos de dados do BigQuery para dados brutos e CDC por fonte de dados, seguindo estas instruções.

Console

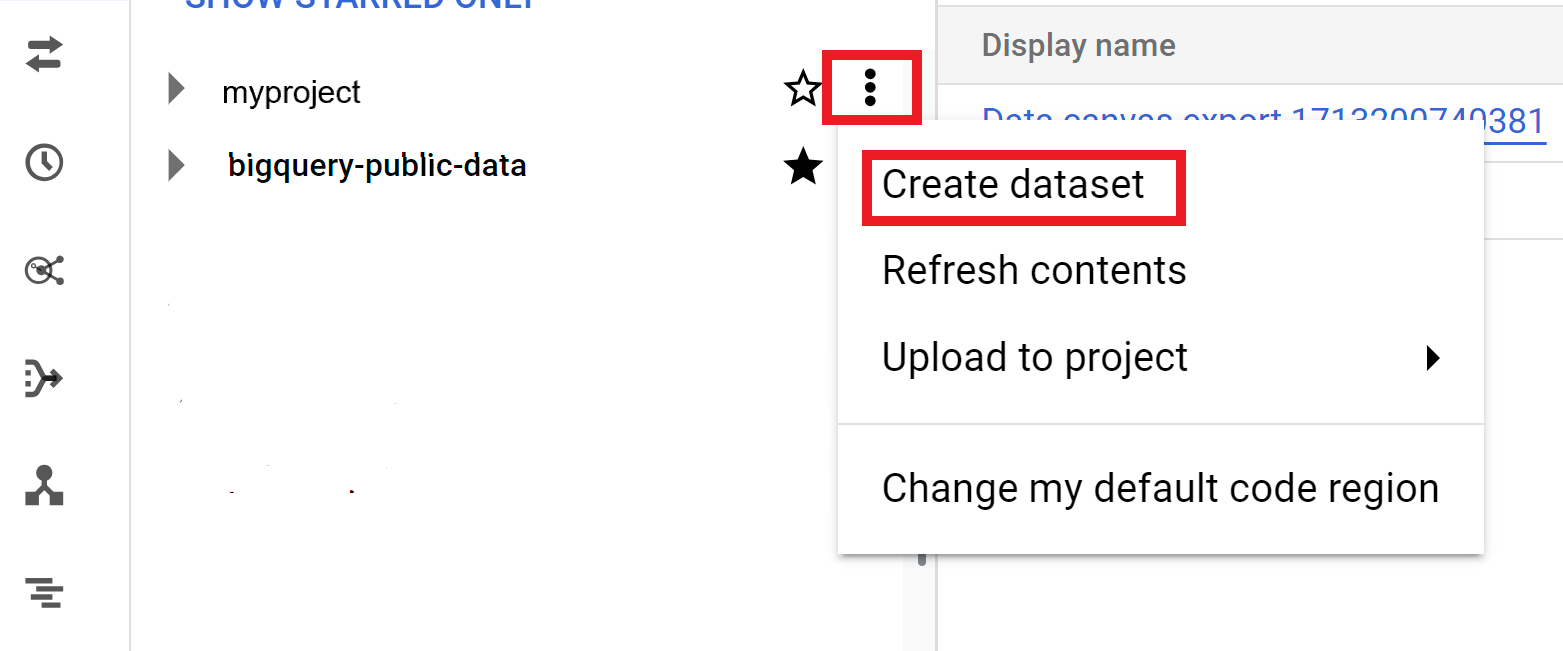

Abra a página do BigQuery no console do Google Cloud .

No painel Explorer, selecione o projeto em que você quer criar o conjunto de dados.

Expanda a opção Ações e clique em Criar conjunto de dados.

Na página Criar conjunto de dados, faça o seguinte:

- Em ID do conjunto de dados, insira um nome exclusivo.

Em Tipo de local, escolha um local geográfico para o conjunto de dados. Após a criação de um conjunto de dados, o local não pode ser alterado.

Opcional. Para mais detalhes de personalização do conjunto de dados, consulte Criar conjuntos de dados: console.

Clique em Criar conjunto de dados.

BigQuery

Copie o comando a seguir para criar um conjunto de dados para dados brutos:

bq --location= LOCATION mk -d SOURCE_PROJECT: DATASET_RAWSubstitua:

LOCATIONcom o local do conjunto de dados.SOURCE_PROJECTcom o ID do projeto de origem.DATASET_RAWcom o nome do conjunto de dados de dados brutos. Por exemplo,CORTEX_SFDC_RAW.

Copie o comando a seguir para criar um conjunto de dados para dados de CDC:

bq --location=LOCATION mk -d SOURCE_PROJECT: DATASET_CDCSubstitua:

LOCATIONcom o local do conjunto de dados.SOURCE_PROJECTcom o ID do projeto de origem.DATASET_CDCcom o nome do conjunto de dados para dados de CDC. Por exemplo,CORTEX_SFDC_CDC.

Confirme se os conjuntos de dados foram criados com o seguinte comando:

bq lsOpcional. Para mais informações sobre como criar conjuntos de dados, consulte Criar conjuntos de dados.

Próximas etapas

Depois de concluir essa etapa, siga para as etapas de implantação a seguir:

- Estabelecer cargas de trabalho (esta página).

- Clonar repositório.

- Determine o mecanismo de integração.

- Configurar componentes.

- Configurar a implantação.

- Executar a implantação.