Cloud Composer 1 |Cloud Composer 2 |Cloud Composer 3

本页面介绍了 Cloud Composer 环境的架构。

环境架构配置

Cloud Composer 3 环境具有单个配置,该配置不依赖于网络类型:

客户和租户项目

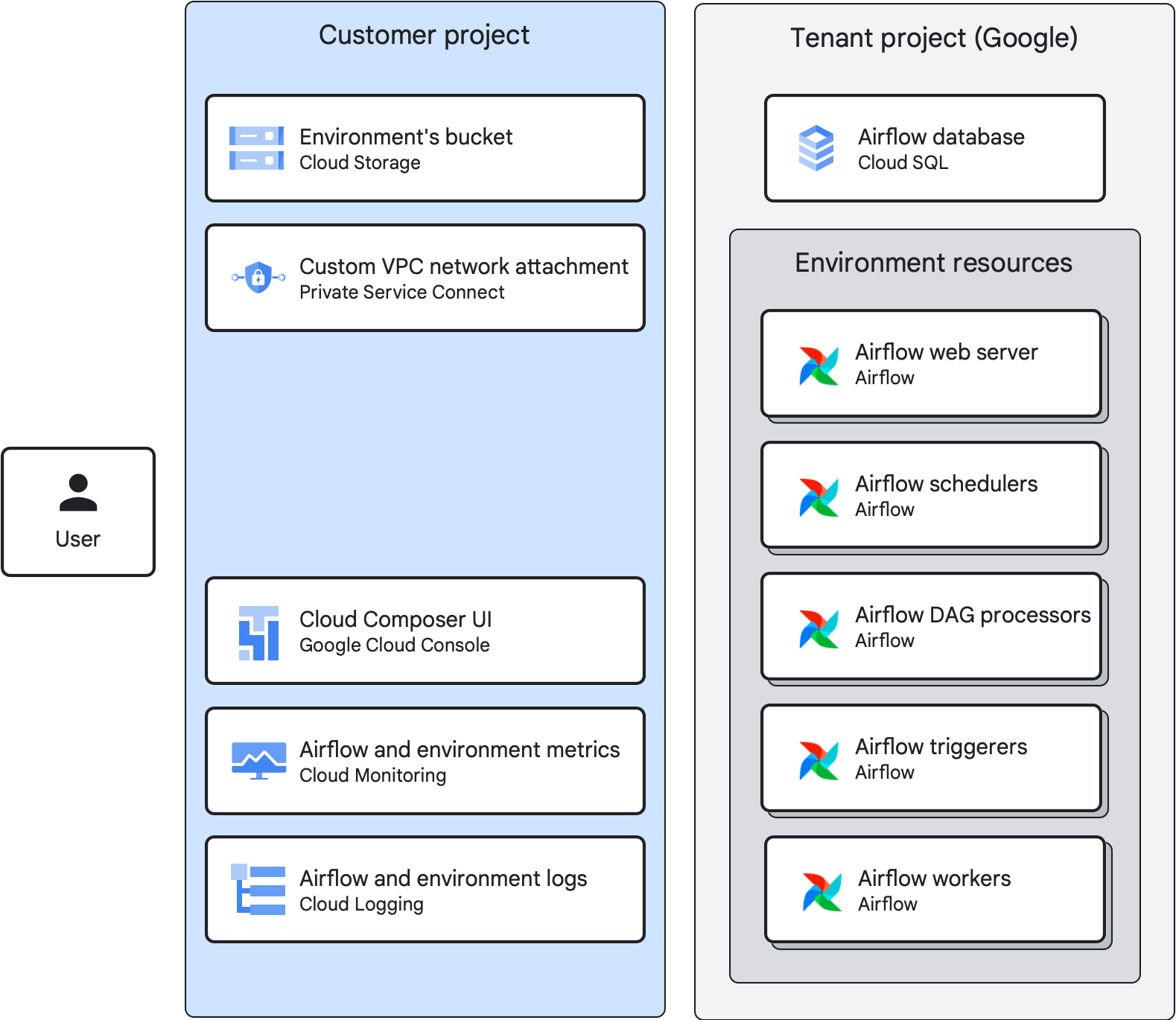

当您创建环境时,Cloud Composer 会将 在租户和客户项目之间定义环境中的资源:

- 客户项目是您在其中创建环境的 Google Cloud 项目。您可以在一个客户项目中创建多个环境。

租户项目是由 Google 管理的租户项目。 租户项目可为您的环境提供统一的访问权限控制和额外一层数据安全保护。每个 Cloud Composer 具有自己的租户项目。

环境组件

Cloud Composer 环境由环境组件组成。

环境组件是作为环境的一部分在 Google Cloud 上运行的代管式 Airflow 基础架构的一个元素。环境组件在环境的租户或客户项目中运行。

环境存储桶

环境存储桶是一个 Cloud Storage 存储桶,用于存储 DAG、插件、数据依赖项和 Airflow 日志。环境的 存储桶位于客户项目中。

当您将 DAG 文件上传到以下位置的 /dags 文件夹时:

Cloud Composer 会将 DAG 同步到您环境的 Airflow 组件中。

Airflow Web 服务器

Airflow 网络服务器会运行您环境的 Airflow 界面。

Cloud Composer 会根据为用户定义的用户身份和 IAM 政策绑定来提供对该界面的访问权限。

Airflow 数据库

Airflow 数据库是您的环境的租户项目中运行的 Cloud SQL 实例。它托管 Airflow 元数据数据库。

为了保护敏感连接和工作流信息,Cloud Composer 只允许对环境的服务账号进行数据库访问。

其他气流组件

在您的环境中运行的其他 Airflow 组件包括:

Airflow 调度器解析 DAG 定义文件,安排 DAG 运行 根据计划间隔安排任务,并将任务排队等待 Airflow 工作器。

Airflow 触发器会异步监控环境中的所有推迟任务。如果您在上述环境中设置了触发器数量 则您可以使用 DAG 中可延期运算符。

Airflow DAG 处理器会处理 DAG 文件并将其转换为 DAG 对象。在 Cloud Composer 3 中,DAG 处理程序会作为单独的环境组件运行。

Airflow 工作器执行由 Airflow 调度的任务 调度器 环境中工作器数量下限和上限发生变化 具体取决于队列中的任务数量。

Cloud Composer 3 环境架构

在 Cloud Composer 3 环境中:

- 租户项目托管一个包含 Airflow 数据库的 Cloud SQL 实例。

- 所有 Airflow 资源都在租户项目中运行。

- 客户项目托管环境的存储桶。

- 客户项目中的自定义 VPC 网络连接可用于 将环境连接到自定义 VPC 网络。您可以使用 也可以由 Cloud Composer 自动点播。您还可以将环境与 VPC 网络

- Google Cloud 控制台、Monitoring 和 通过登录客户项目,您可以管理 DAG 和 DAG 运行,以及访问环境指标和 日志。您还可以使用 Airflow 界面、Google Cloud CLI、Cloud Composer API 和 Terraform 来实现相同的目的。

与 Cloud Logging 和 Cloud Monitoring 集成

Cloud Composer 集成了您的 Google Cloud 项目的 Cloud Logging 和 Cloud Monitoring,因此您可以集中查看 Airflow 和 DAG 日志。

Cloud Monitoring 会从 Cloud Composer 中收集并提取指标、事件和元数据,并通过信息中心和图表生成数据分析。

得益于 Cloud Logging 的流式传输特性,您可以立即查看 Airflow 组件发出的日志,而无需等待 Airflow 日志显示在环境的 Cloud Storage 存储桶中。

如需限制 Google Cloud 项目中的日志数量,您可以停止所有日志提取。请勿停用 Logging。