Google の海底光ファイバーを解説

Google Cloud Japan Team

※この投稿は米国時間 2022 年 4 月 7 日に、Google Cloud blog に投稿されたものの抄訳です。

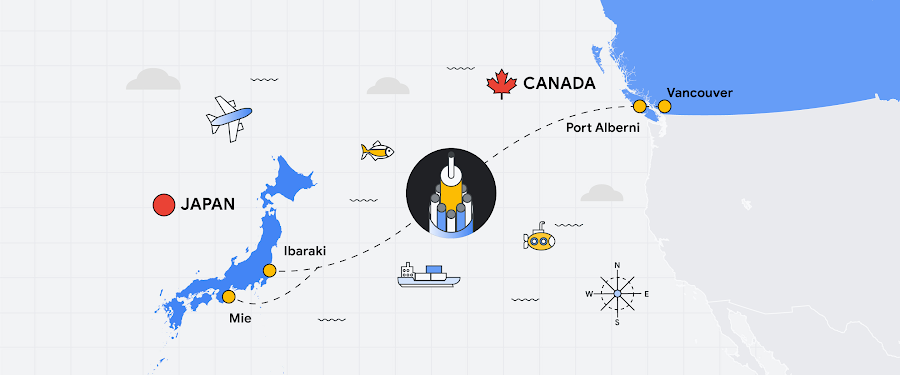

光ファイバー ネットワークは、現代のインターネットの基盤と言えます。事実、海底ケーブルは国際ネットワーク トラフィックの実に 99% を担っていますが、私たちはその存在にほとんど気が付きません。また、最初の海底ケーブルが 1858 年にヨーロッパと北米間を結ぶ電信用として敷設されたことも、あまり知られていないかもしれません。メッセージが届くのには 17 時間以上を要し、1 文字あたり 2 分 5 秒をかけてモールス信号で送られていました。

今日、ケーブル 1 本で 340 Tbps の通信が可能であり、これは一般家庭のインターネット接続の 2,500 万倍以上の速さに相当します。Google は長年、世界中のパートナーと協力して、地中および海底に敷設する光ファイバーにさらに容量を設計すべく努力を続けてきました。これには、物理学、海洋技術、工学の美しい化学反応が必要です。そこで私は、ネットワークの需要が膨らみ続けるこの世の中で、グローバル ネットワークを計画し、実装するために何が必要かを紹介する動画を作ろうと思いました。

この動画を作り始めた時点では、説明したいことは数点のみだと思っていました。その後、光ネットワーク エンジニアへのインタビューやネットワーク設計書を読み漁ったりして、25 時間以上にもおよぶ調査の結果、はじめてこの情報の海の表面をかきわけることができてきました。私の調査結果に一緒にダイブしましょう(ここ、笑うところです!)。

Google Cloud はどのようにして、ネットワーク トラフィックを予測し、容量を計画しているのでしょうか。

物理的なインフラストラクチャの許可、電源の特定、冷却装置とハードウェアの設置。1 つのプロジェクトのプロセス全体の計画と実装に、何年もかかることもあります。なので、容量の計画はずっと前から行っておく必要があるのです。容量の需要を予測するのは簡単ではありません。一般的なトレンドライン分析は役に立たないのです。こうしたリードタイムの長さや 20 年を超えるケーブルの寿命を考慮し、Google における予測とアセット取得の意思決定のための分析は、数か月というより数年のスパンにわたる需要予測を元にしています。

1 つ確かな要因は、クラウドが Google のネットワークの需要における大きな主導役であるということです。Gartner は、世界でクラウドにかける費用は 2025 年までに 9,170 億ドルにまで増加すると予測しています。Google Cloud は、ネットワークとサービスにおける可用性と高速化の増加への需要を後押ししており、Google Cloud のお客様が発生させうるトラフィックの急増に対応する必要があります。また、新しいリージョンを追加する際には、そこまでの経路を冗長化し、より高いネットワーク容量を計画しなければなりません。Google の Global Networking チームは、お客様が求めるそのときに容量をお届けするために、信頼性を念頭に置いてネットワークを設計し、複数の障害点を把握して、素早いフェイルオーバーを提供しています。

パートごとの予測

容量の需要を予測するには、5 年先、3 年先、3~6 か月先の需要を、感度分析を使って予測します。そして、レイテンシなどの Google Cloud の要件を満たしつつ、容量とコストのバランスを考慮したコストカーブ上での最適解を探します。これにより、ケーブルの投資規模を決定するのです。予測の一助とするため、ネットワークを 3 つのカテゴリに分けています。

メトロ間ネットワーク – 大陸内および大陸間における主要な大都市圏をつなぐ経路。

リージョン – 大都市圏のリージョンにおけるデータセンターをつなぐ経路。

エッジ – Google のネットワークとインターネット サービス プロバイダ(ISP)をつなぐ経路。

エンジニア チームがこだわったのは、ネットワークの復元力

多くのエンジニア チームは、ネットワークの予測と設計のために日々奮闘しています。彼らは、以下のようなことを決定しています。

それぞれの Google サービス(Google Cloud サービス、検索、YouTube など)で必要となる帯域幅。

パフォーマンスを最適化するためのネットワーク トポロジの形状(さまざまなノード、デバイス、および接続が、お互いの関係に対して物理的または論理的にどう編成されているか)。

高可用性実現に必要となるルートの数(各ロケーションの回路数)。単一障害点を防ぐため、完全に分断された多様なルートを探します。

容量計画のための光ファイバーのテスト

光ファイバー ネットワーク エンジニア チームは、Google Cloud ネットワークにおけるパフォーマンスを把握するために、光ファイバー ケーブルをテストしています。これにより、何が提供できるかを予測できるため、こうしたテスト結果は容量計画において重要な役割を果たしています。

目標は、最高の信号雑音比を達成することです。光はファイバーを通して長距離を移動しますが、その際にシグナルの歪みが発生します。ラボでケーブル全体を収容することは不可能ですが、何十本ものファイバー スプールをデイジー チェーン接続して、Google Cloud のネットワークを再現しています。光スペクトラム アナライザを使って、レーザーをパルスしながら 1.2 Tbps の 0 と 1 をケーブルに押し込み、シグナルの品質をチェックします。

けれど、ファイバーはレーザーとケーブルと物理の法則だけで成り立っているわけではありません。ハードウェアにおける変更や問題に対処するには、ソフトウェアの堅牢な自動化が必要です。リージョン間の接続に新しいファイバーを配置できるよう、自動化パイプラインを構築しています。ファイバーに障害が発生した場合でも、自動化によって数メートルの精度で問題を特定し、迅速に対応できます。

ネットワークの信頼性とスケールを拡大するために、どのような技術が開発されてきたのでしょうか。

空間分割多重方式

Grace Hopper ケーブルは、空間分割多重方式(SDM)を使用することで、通常は 6 または 8 であったファイバーペアを 16 に増やし、新記録を樹立しました。このケーブルが開通すると、340 Tbps の伝送が可能になります。これは、この 4K 動画を 450 万回同時にストリーミングできる計算です。SDM は、使用電力を最適化したリピーター設計を活用して、費用効率を高めながらケーブルの容量増加を達成しました。Topaz ケーブルでは、パートナーと協力して SDM 技術と 16 本のファイバーペアを使用し、 240 Tbps の設計容量を実現しました。19 世紀の電気化学の研究者である Michael Faraday が、太平洋に敷設されたたった 1 本のケーブルが、1 秒間に 2.4 兆ビットを送信していると知ったら、どれほど誇らしく思うことでしょう。

波長選択スイッチ

Topaz はまた、波長選択スイッチ(WSS)も搭載しています。WSS は、波長に基づいて、光ファイバー間のシグナルを動的にルーティングするのに使用されます。これにより容量の割り当てが格別に単純化され、ケーブル システムが必要に応じて柔軟に、さまざまなロケーションに容量を追加したり、割り当てを変更したりすることが可能になります。その仕組みを説明します。

分岐ユニットとは、ケーブルの一部をスプリットして別のロケーションに着地させるためのものです。分岐はファイバーペアまたは波長レベルのどちらかです。

WSS は波長に応じて、シグナルを主幹と分岐パスにスプリットします。これにより、各リンクに専用のファイバーペアを設置することなく、違う経路のシグナルを同じファイバーで共有できます。

そして、ケーブル システムは、光ファイバーペアでスペクトルを切り分け、1 つのファイバーペアを使用して異なるロケーションに容量を適用します。こうして、トラフィックをその場でリダイレクトすることができるのです。

復元性のある動的なパスを実現する WSS は、4 年以上も前に Google のホワイトボードで初めて紹介されました。現在、この革新技術は業界全体で採用されています。

ケーブルが影響を受けても Google Cloud のお客様がほとんど気が付かないのはどうしてでしょう。

光ファイバー ケーブルは保護されてはいますが、無敵ではありません。漁船や客船は錨を引きずりますが、海底ケーブルの障害の 3 分の 2 はその錨が原因となっています。

ペレーションに尽力を続け、その範囲、信頼性、可用性を向上させ続けているのです。例えば、物理的に損傷したケーブルの修復には数週間かかることがあります。そんな場合でもサービスが影響を受けないように、各クロス セクションには複数のケーブルを設置し、単一障害点がないようにネットワークに余剰の容量を設計しています。

私たちの理念は、大都市圏、リージョナル、グローバル レベルで十分な数の同時ネットワーク パスを作成し、スケーラブルなソフトウェア コントロール プレーンと組み合わせて、ネットワークの輻輳を最小限に抑えながらトラフィックの再分配をサポートすることです。サービスの中断が発生したときでも、他のネットワーク パスを利用してトラフィックをシームレスに再ルーティングし、世界中のお客様にご迷惑をかけないようにしています。例えば、米国とチリ間のネットワークが中断されたとしても、Google Cloud は他の多様なパスを利用して、トラフィックを再ルーティングします。

Google Cloud のお客様がこの進化を活用するには、どうしたらよいでしょうか。

ネットワーク計画、オペレーション、モニタリングは Google の要です。

プレミアム ティア ネットワークは、Google の高速ネットワークへの入り口と言えます。

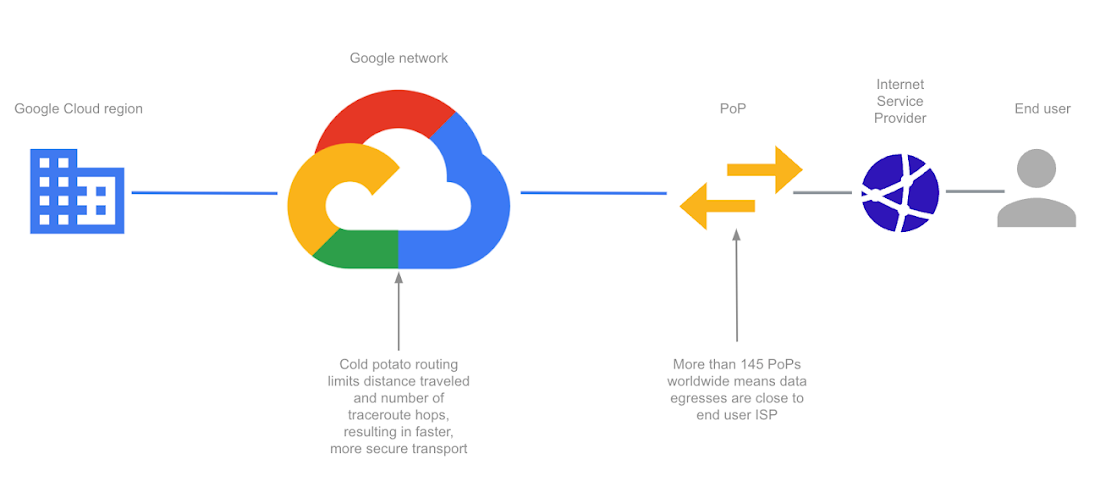

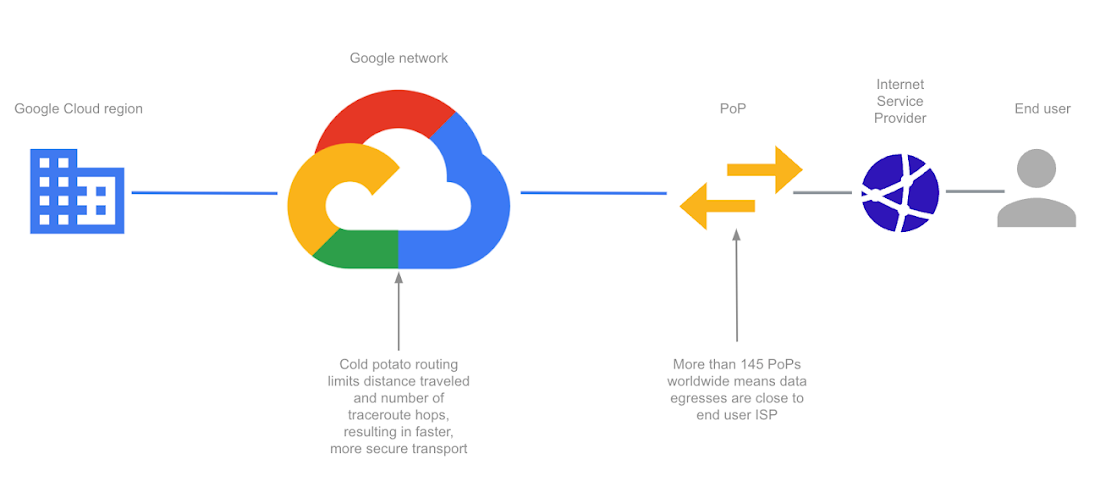

Google Cloud のネットワーク バックボーンを理解するためには、公衆インターネットの仕組みについて知っておくといいかもしれません。数十社の大手 ISP が、各都市のネットワーク アクセス ポイントで相互接続しています。プロバイダ間で交わされる一般的な契約には、ホットポテト ルーティングと呼ばれるものが含まれます。ISP は、ネットワークの作業量を最小限にするために、できるだけ早く下流の ISP にトラフィックを渡そうとします。これは、トラフィックが宛先に到着するまでに、ネットワークとルーター間のホップ数が増えることを意味します。この種類のルーティングは、Google Cloud のスタンダード ティア ネットワークで利用できます。

クリックして拡大

対照的に、Google Cloud のプレミアム ティア ネットワークは、コールドポテト ルーティングを使用しています。これはプライベート ネットワークのバックボーンでトラフィックを維持するため、ISP 間のホップ数は少なくて済みます。データがエンドユーザーに最も近くなった瞬間に、ISP にトラフィックをオフロードします。

クリックして拡大

例を挙げて考えてみましょう。あなたの会社は、従来のネットワークを使用しているとします。米国内の自社のプライベート データセンターからのトラフィックが宛先であるチリに到着するには、まずローカル ISP を通過します。ローカル ISP はおそらく、ファイバー サプライヤを使用して、次の ISP にトラフィックを渡すでしょう。多くのホットポテト ホップを通過する間に、高レイテンシが生じ、帯域幅の容量が制限されることがあります。

Google Cloud なら、プレミアム ティア ネットワークを使って、スタンダード ティアより 1.4 倍高いスループットを実現できます。また、エンドユーザーに最も近い場所にコンテンツをキャッシュする Cloud CDN を利用できます。

垂直インテグレーションの美

物理的ネットワーク上に鎮座するソフトウェア スタックも忘れてはいけません。トラフィック ルーティングのためのネットワーク トポロジとソフトウェア定義コントローラは、フォールト トレラントを考慮して構築されています。データセンターのネットワーク ファブリックは、Google が設計した Jupiter という閉じた階層のスイッチング ファブリックで構成されています。データセンター全体で数十万台のマシンを接続し、1 Pbps の全二分帯域幅を提供しています。

Jupiter がこれほどの高帯域幅を実現できるのは、ノンブロッキングであるからです。これにより、他のトラフィックに干渉することなく、任意の空き出力ポートにリクエストをルーティングして処理できるのです。つまり、非常に低いレイテンシでスケーリングやバーストが可能であり、フォールト トレラントであるということです。ファブリックのどこかが破損しても、対応できるように構築されています。

Google Cloud は、Jupiter の上に構築された仮想化ソフトウェア定義ネットワーキングである Andromeda によって支えられており、Google の大規模なグローバル スイッチング ファブリックのお客様独自のスライスを提供します。また、Andromeda は、グローバルな仮想プライベート クラウド ネットワークをデプロイし、機能と性能を分離し、高度なセキュリティを提供することを目的としています。このグローバルなコントロール プレーン、高速オンホストの仮想スイッチ、パケット プロセッサを利用すると、数千台のステートフル マシンを数分でオンラインにしたり、数千台のマシンにファイアウォール ルールをチョークポイントなしで即座にデプロイしたりすることができます。例えば、Google Cloud のグローバル Virtual Private Cloud(VPC)は、公共のインターネットを介した通信を行わずに、複数のリージョンにまたがる 1 つの VPC を持つことができます。さまざまなマイクロサービスが分離され、ネットワークを通じて互いに会話することができるため、独立したスケーリングが可能となりました。実質的に無制限のストレージとステートレスで復元性のあるコンピューティング、そしてライブ マイグレーションなどの機能が利用できます。

BigQuery を使用してペタバイト級のデータを数秒で処理する場合でも、Spanner を使用してリージョン間で整合性のあるデータベースを実行する場合でも、ゾーン間で GKE クラスタを自動スケーリングする場合でも、Google のグローバル ネットワーク バックボーンは業務に必要なだけの容量を提供します。

Google の光ファイバー ケーブル ネットワークがどのように計画され、構築されているのかについて、海底ほど深く知ることができたのは大きな収穫でした。私が話を伺ったエンジニア、プロジェクト マネージャー、公共政策の専門家はみな、インターネットのグローバルな接続性を世界中に広げたいという情熱を熱く語ってくれました(そして、Google Cloud はこの壮大な旅の船頭なのです)。

Google Cloud プレミアム ティア ネットワークの波に乗るためのさらに多くの方法をぜひご覧ください。

Google のクラウド技術を推進し、限定イベントに参加する機会に興味がおありですか?ぜひ Google Cloud Innovators にご参加ください。

この記事に関するご意見・ご感想に関しましては、Twitter で @stephr_wong までご連絡ください。

- デベロッパー アドボケイト、Stephanie Wong